用极限网关实现 ES 容灾,简单!

身为 IT 人士,大伙身边的各种系统肯定不少吧。系统虽多,但最最最重要的那套、那几套,大伙肯定是捧在手心,关怀备至。如此重要的系统,万一发生故障了且短期无法恢复,该如何保障业务持续运行?

有过这方面思考或经验的同学,肯定脱口而出--切灾备啊。

是的,接下来我来介绍下我们的 ES 灾备方案。当然如果你有更好的,请使用各种可用的渠道联系我们。

总体设计

通过极限网关 将应用对主集群的写操作,复制到灾备集群。应用发送的读请求则直接转发到主集群,并将响应结果转发给应用。应用对网关无感知,访问方式与访问 ES 集群一样。

方案优势

- 轻量级

极限网关使用 Golang 编写,安装包很小,只有 10MB 左右,没有任何外部环境依赖,部署安装都非常简单,只需要下载对应平台的二进制可执行文件,启动网关程序的二进制程序文件执行即可。

- 跨版本支持

极限网关针对不同的 Elasticsearch 版本做了兼容和针对性处理,能够让业务代码无缝的进行适配,后端 Elasticsearch 集群版本升级能够做到无缝过渡,降低版本升级和数据迁移的复杂度。

- 高可用

极限网关内置多种高可用解决方案,前端请求入口支持基于虚拟 IP 的双机热备,后端集群支持集群拓扑的自动感知,节点上下线能自动发现,自动处理后端故障,自动进行请求的重试和迁移。

- 灵活性

主备集群都是可读可写,切换迅速,只需切换网关到另一套配置即可。回切灵活,恢复使用原配置即可。

架构图

.*

网关程序部署

下载

根据操作系统和平台选择下面相应的安装包:

解压到指定目录:

mkdir gateway

tar -zxf xxx.gz -C gateway

修改网关配置

在此下载网关配置,默认网关会加载配置文件 gateway.yml ,如果要指定其他配置文件使用 -config 选项指定。

网关配置文件内容较多,下面展示必要部分。

#primary

PRIMARY_ENDPOINT: http://192.168.56.3:7171

PRIMARY_USERNAME: elastic

PRIMARY_PASSWORD: password

PRIMARY_MAX_QPS_PER_NODE: 10000

PRIMARY_MAX_BYTES_PER_NODE: 104857600 #100MB/s

PRIMARY_MAX_CONNECTION_PER_NODE: 200

PRIMARY_DISCOVERY_ENABLED: false

PRIMARY_DISCOVERY_REFRESH_ENABLED: false

#backup

BACKUP_ENDPOINT: http://192.168.56.3:9200

BACKUP_USERNAME: admin

BACKUP_PASSWORD: admin

BACKUP_MAX_QPS_PER_NODE: 10000

BACKUP_MAX_BYTES_PER_NODE: 104857600 #100MB/s

BACKUP_MAX_CONNECTION_PER_NODE: 200

BACKUP_DISCOVERY_ENABLED: false

BACKUP_DISCOVERY_REFRESH_ENABLED: false

PRIMARY_ENDPOINT:配置主集群地址和端口

PRIMARY_USERNAME、PRIMARY_PASSWORD: 访问主集群的用户信息

BACKUP_ENDPOINT:配置备集群地址和端口

BACKUP_USERNAME、BACKUP_PASSWORD: 访问备集群的用户信息

运行网关

前台运行

直接运行网关程序即可启动极限网关了,如下:

./gateway-linux-amd64

后台运行

./gateway-linux-amd64 -service install

Success

./gateway-linux-amd64 -service start

Success

卸载服务

./gateway-linux-amd64 -service stop

Success

./gateway-linux-amd64 -service uninstall

Success

灾备功能测试

在灾备场景下,为保证数据一致性,对集群的访问操作都通过网关进行。注意只有 bulk API 的操作才会被复制到备集群。

在此次测试中,网关灾备配置功能为:

- 主备集群正常时

读写请求正常执行;

写请求被记录到队列,备集群实时消费队列数据。

- 当主集群故障时

写入请求报错,主备集群都不写入数据;

查询请求转到备集群执行,并返回结果给客户端。

- 当备集群故障时

读写请求都正常执行;

写操作记录到磁盘队列,待备集群恢复后,自动消费队列数据直到两个集群一致。

主备集群正常时写入、查询测试

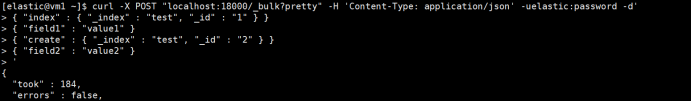

写入数据

# 通过网关写入数据

curl -X POST "localhost:18000/_bulk?pretty" -H 'Content-Type: application/json' -uelastic:password -d'

{ "index" : { "_index" : "test", "_id" : "1" } }

{ "field1" : "value1" }

{ "create" : { "_index" : "test", "_id" : "2" } }

{ "field2" : "value2" }

'

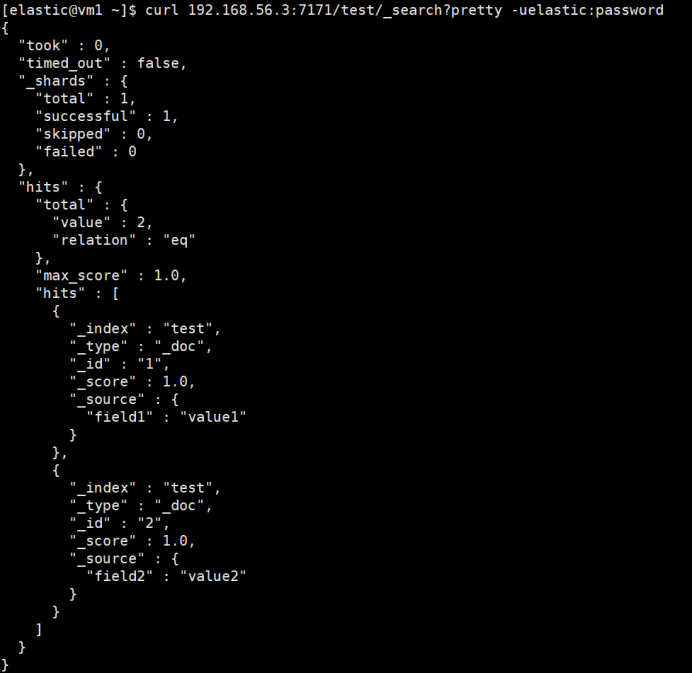

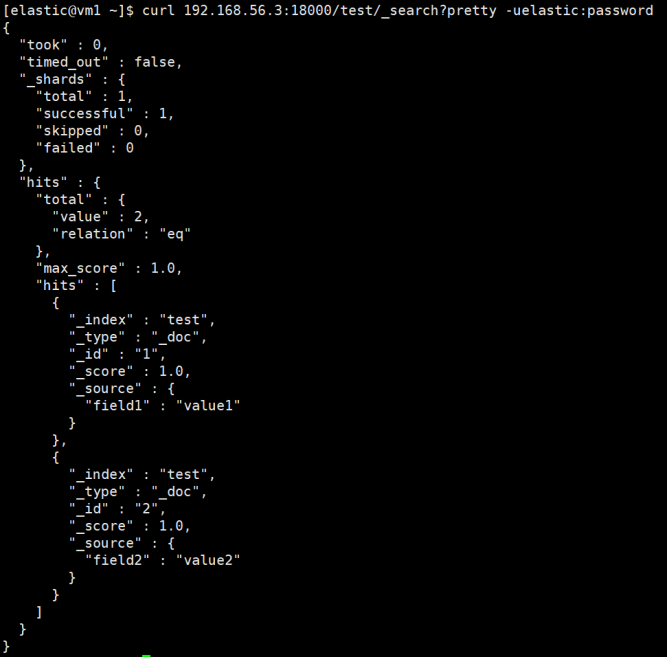

查询数据

# 查询主集群

curl 192.168.56.3:7171/test/_search?pretty -uelastic:password

# 查询备集群

curl 192.168.56.3:9200/test/_search?pretty -uadmin:admin

# 查询网关,网关转发给主集群执行

curl 192.168.56.3:18000/test/_search?pretty -uelastic:password

主备集群都已写入数据,且数据一致。通过网关查询,也正常返回。

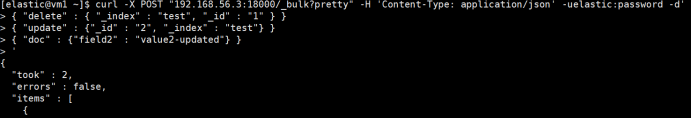

删除和更新文档

# 通过网关删除和更新文档

curl -X POST "192.168.56.3:18000/_bulk?pretty" -H 'Content-Type: application/json' -uelastic:password -d'

{ "delete" : { "_index" : "test", "_id" : "1" } }

{ "update" : {"_id" : "2", "_index" : "test"} }

{ "doc" : {"field2" : "value2-updated"} }

'

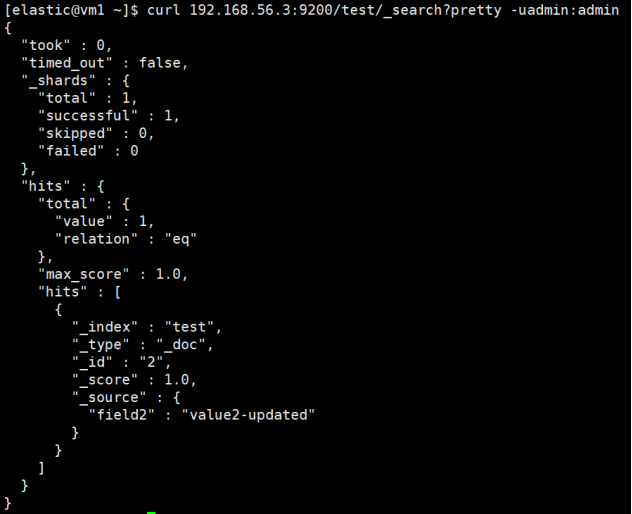

查询数据

# 查询主集群

curl 192.168.56.3:7171/test/_search?pretty -uelastic:password

# 查询备集群

curl 192.168.56.3:9200/test/_search?pretty -uadmin:admin

两个集群都已执行删除和更新操作,数据一致。

主集群故障时写入、查询测试

为模拟主集群故障,直接关闭主集群。

写入数据

# 通过网关写入数据

curl -X POST "192.168.56.3:18000/_bulk?pretty" -H 'Content-Type: application/json' -uelastic:password -d'

{ "index" : { "_index" : "test", "_id" : "3" } }

{ "field3" : "value3" }

{ "create" : { "_index" : "test", "_id" : "4" } }

{ "field4" : "value4" }

'

写入数据报错

查询数据

# 通过网关查询,因为主集群不可用,网关将查询转发到备集群执行

curl 192.168.56.3:18000/test/_search?pretty -uelastic:password

正常查询到数据,说明请求被转发到了备集群执行。

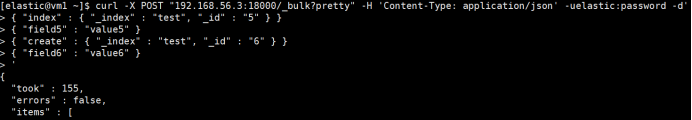

备集群故障时写入、查询测试

为模拟备集群故障,直接关闭备集群。

写入数据

# 通过网关写入数据

curl -X POST "192.168.56.3:18000/_bulk?pretty" -H 'Content-Type: application/json' -uelastic:password -d'

{ "index" : { "_index" : "test", "_id" : "5" } }

{ "field5" : "value5" }

{ "create" : { "_index" : "test", "_id" : "6" } }

{ "field6" : "value6" }

'

数据正常写入。

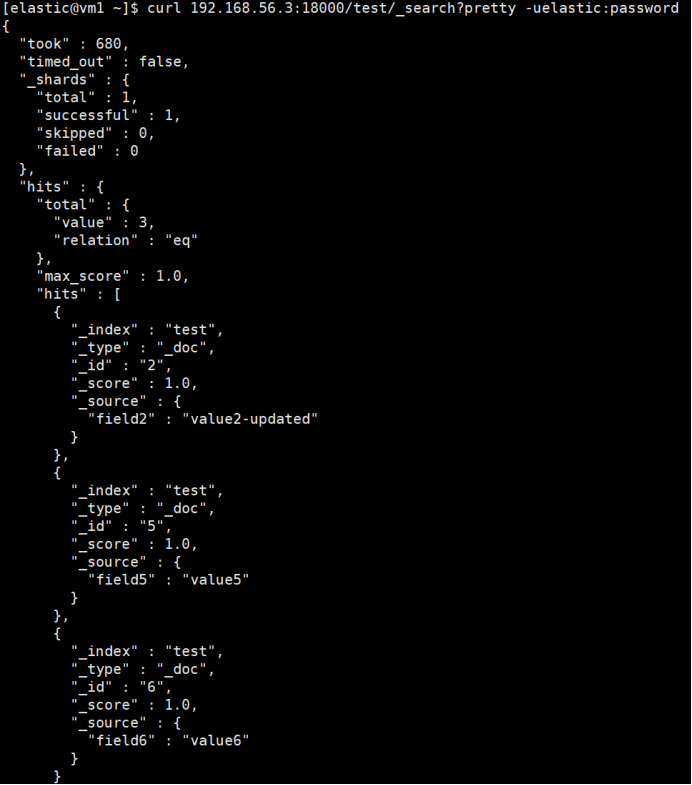

查询数据

# 通过网关查询

curl 192.168.56.3:18000/test/_search?pretty -uelastic:password

查询成功返回。主集群成功写入了两条新数据。同时此数据会被记录到备集群的队列中,待备集群恢复后,会消费此队列追数据。

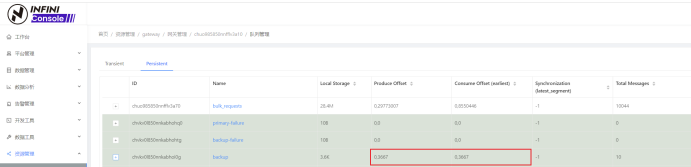

恢复备集群

启动备集群。

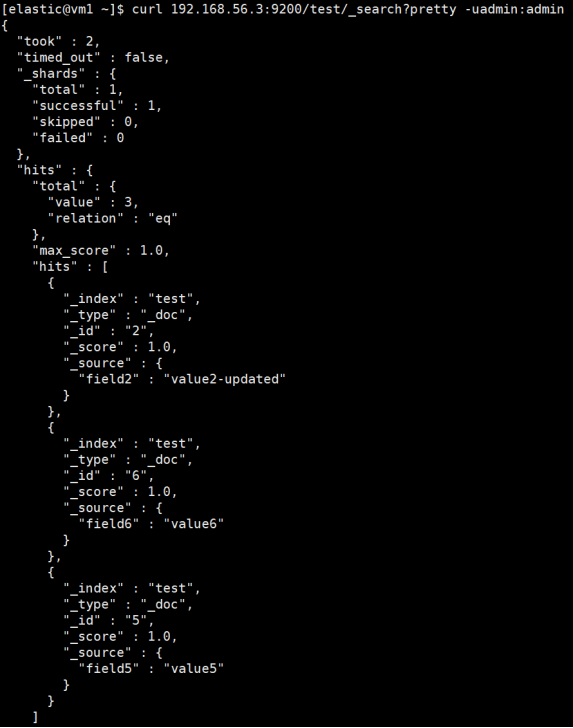

查询数据

等待片刻或通过 INFINI Console 确定网关队列消费完毕后,查询备集群的数据。

(生产和消费 offset 相同,说明消费完毕。)

# 查询备集群的数据

curl 192.168.56.3:9200/test/_search?pretty -uadmin:admin

备集群启动后自动消费队列数据,消费完后备集群数据达到与主集群数据一致。

灾备切换

测试了这么多,终于到切换的时刻了。切换前我们判断下主系统是否短期无法修复。

如果我们判断主用系统无法短时间恢复,要执行切换。非常简单,我们直接将配置文件中定义的主备集群互换,然后重启网关程序就行了。但我们推荐在相同主机上另部署一套网关程序--网关 B,先前那套用网关 A 指代。网关 B 中的配置文件把原备集群定义为主集群,原主集群定义为备集群。若要执行切换,我们先停止网关 A,然后启动网关 B,此时应用连接到网关(端口不变),就把原备系统当作主系统使用,把原主系统当作备系统,也就完成了主备系统的切换。

灾备回切

当原主集群修复后,正常启动,就会从消费队列追写修复期间产生数据直到主备数据一致,同样我们可通过 INFINI Console 查看消费的进度。如果大家还是担心数据的一致性,INFINI Console 还能帮大家做校验数据任务,做到数据完全一致后(文档数量及文档内容一致),才进行回切。

回切也非常简单,停止网关 B,启动网关 A 即可。

网关高可用

网关自带浮动 IP 模块,可进行双机热备。客户端通过 VIP 连接网关,网关出现故障时,VIP 漂移到备网关。

视频教程戳这里。

这样的优点是简单,不足是只有一个网关在线提供服务。如果想多个网关在线提供服务,则需搭配分布式消息系统一起工作,架构如下。

前端通过负载均衡将流量分散到多个在线网关,网关将消息存入分布式消息系统。此时,网关可看作无状态应用,可根据需要扩缩规模。

以上就是我介绍的 ES 灾备方案,是不是相当灵活了。有问题还是那句话 Call me 。

原文网址:http://www.infinilabs.com/blog/2023/backup-system-with-gateway/

用极限网关实现 ES 容灾,简单!的更多相关文章

- ceph 008 ceph多区域网关(ceph对象容灾) cephfs文件系统

clienta作为集群的管理人员.一部分.他是需要秘钥与配置文件的 但真正服务端只需要通过curl就好 ceph 多区域网关 对象存储容灾解决方案 zone与zone会做数据同步. 把会做同步的rgw ...

- 微软分布式云计算框架Orleans(2):容灾与集群(1)

在上一篇:微软分布式云计算框架Orleans(1):Hello World,我们大概了解了Orleans如何运用,当然上一篇的例子可以说是简单且无效的,因为用了Orleans不可能只写一个Hello ...

- 传统业务上云:跨AZ容灾架构解析

本文由 网易云发布. 数字化转型浪潮之下,采用云计算服务提升业务敏捷性.降低运维成本,成为了传统企业的优选方案.网易云资深解决方案架构师张亮通过某物流企业客户的实际案例,分享了传统业务系统在云上的架 ...

- elasticsearch集群扩容和容灾

elasticsearch专栏:https://www.cnblogs.com/hello-shf/category/1550315.html 一.集群健康 Elasticsearch 的集群监控信息 ...

- Redis容灾部署(哨兵Sentinel)

Redis容灾部署(哨兵Sentinel) 哨兵的作用 1. 监控:监控主从是否正常2. 通知:出现问题时,可以通知相关人员3. 故障迁移:自动主从切换4. 统一的配置管理:连接者询问sentinel ...

- diamond专题(四)—— 容灾机制

大家好,本次为大家带来diamond的容灾机制. diamond之所以表现的稳定可靠,除了架构简单之外,另一个重要原因是diamond具有一套完备的容灾机制,容灾机制涉及到client和server两 ...

- hadoop容灾能力测试

实验简单来讲就是 1. put 一个600M文件,分散3个replica x 9个block 共18个blocks到4个datanode 2. 我关掉了两个datanode,使得大部分的block只在 ...

- 主从集群搭建及容灾部署redis

redis主从集群搭建及容灾部署(哨兵sentinel) Redis也用了一段时间了,记录一下相关集群搭建及配置详解,方便后续使用查阅. 提纲 l Redis安装 l 整体架构 l Redis主 ...

- QQ 相册后台存储架构重构与跨 IDC 容灾实践

欢迎大家前往云加社区,获取更多腾讯海量技术实践干货哦~ 作者简介:xianmau,2015 年加入腾讯 TEG 架构平台部,一直负责 QQ 相册平台的维护和建设,主导相册上传架构重构和容灾优化等工作. ...

- kbmMW均衡负载与容灾(1)(转载红鱼儿)

kbmMW为均衡负载与容灾提供了很好的机制,支持多种实现方式,现在看看最简单的一种,客户端控制的容灾和简单的负载均衡. 现在,我们将kbmMWServer部署到不同的服务器,或者在同一服务器部署多份实 ...

随机推荐

- 深度学习--PyTorch定义Tensor以及索引和切片

深度学习--PyTorch定义Tensor 一.创建Tensor 1.1未初始化的方法 这些方法只是开辟了空间,所附的初始值(非常大,非常小,0),后面还需要我们进行数据的存入. torch.em ...

- 简单理解重载运算符&位运算

重载运算符 作用 重载运算符的作用大致可以理解为自定义一个运算法则,比如当我们在使用结构体的时候,我们有时候会用到优先队列,但是优先队列并不能对于结构体使用,所以这个时候我们就需要用到重载运算符来自定 ...

- 2023-05-04:用go语言重写ffmpeg的scaling_video.c示例,用于实现视频缩放(Scaling)功能。

2023-05-04:用go语言重写ffmpeg的scaling_video.c示例,用于实现视频缩放(Scaling)功能. 答案2023-05-04: 这段代码实现了使用 libswscale 库 ...

- HMS Core 6.10.0版本发布公告

分析服务 ◆ 事件分析下新增商品订阅分析报告,帮助开发者了解应用内用户付费订阅概况,评估订阅付费价值: ◆ 营销分析.用户质量.转化分析以及过滤器中,新增广告系列/广告任务通过ID进行搜索的功能,通过 ...

- Wolai 使用教程:嵌入小组件库,打造精美、强大的知识库主页

Wolai /我来云笔记在 2022.7.11 日的更新中,支持嵌入包括 NotionPet.芦笋.Replit 等在内的第三方应用.感谢 Wolai 云笔记官方对于 NotionPet 的支持. 趁 ...

- 2021-12-22:回文子串。 给你一个字符串 s ,请你统计并返回这个字符串中 回文子串 的数目。 回文字符串 是正着读和倒过来读一样的字符串。 子字符串 是字符串中的由连续字符组成的一个序列。

2021-12-22:回文子串. 给你一个字符串 s ,请你统计并返回这个字符串中 回文子串 的数目. 回文字符串 是正着读和倒过来读一样的字符串. 子字符串 是字符串中的由连续字符组成的一个序列. ...

- 非极大值抑制(NMS)算法详解

NMS(non maximum suppression)即非极大值抑制,广泛应用于传统的特征提取和深度学习的目标检测算法中. NMS原理是通过筛选出局部极大值得到最优解. 在2维边缘提取中体现在提取边 ...

- 一分钟学一个 Linux 命令 - cd

前言 大家好,我是 god23bin.欢迎来到这个系列,每天只需一分钟,记住一个 Linux 命令不成问题.今天让我们从 cd 命令开始,掌握在 Linux 系统中切换目录的技巧. 什么是 cd 命令 ...

- Python time strftime() 方法的使用

1.描述 strftime() 用于格式化时间,返回以可读字符串表示的时间,格式自定义. 2.说明 python中日期和时间的格式化符号有很多,下面列举常用的符号: %y 两位数的年份表示(00-9 ...

- 9.3 Django框架

Django 是一个非常流行的 Python Web 开发框架,它是完整且强大的,适用于构建大型 Web 应用.在这一章节中,我们将详细介绍 Django 的基本概念.组件和用法.为了便于理解,我们将 ...