爬虫_腾讯招聘(xpath)

和昨天一样的工作量,时间只用了一半,但还是效率有点低了,因为要把两个网页结合起来,所以在列表操作上用了好多时间

import requests

from lxml import etree headers = {'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.75 Safari/537.36'} def get_html(url):

response = requests.get(url, headers=headers)

response.encoding = response.apparent_encoding

html = response.text

return html def parse_html(html):

informations = []

urls = []

html_element = etree.HTML(html)

kinds = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])/td[2]/text()')

'''

kinds:

['技术类', '设计类', '技术类', '技术类', '技术类', '技术类', '技术类', '技术类', '技术类', '产品/项目类']

'''

nums = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])//td[3]/text()')

'''

nums:

['2', '1', '2', '1', '2', '2', '1', '2', '1', '1']

'''

addresses = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])//td[4]/text()')

'''

addresses:

['深圳', '深圳', '深圳', '深圳', '深圳', '深圳', '深圳', '深圳', '深圳', '深圳']

'''

times = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])//td[5]/text()')

'''

times:

['2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04', '2018-08-04']

'''

names = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])//a/text()') detail_url = html_element.xpath('(//tr[@class="even"]|//tr[@class="odd"])//a/@href')

for str_url in detail_url: url = 'https://hr.tencent.com/' + str(str_url)

urls.append(url) '''

urls :

['https://hr.tencent.com/position_detail.php?id=42917&keywords=python&tid=0&lid=0',

'https://hr.tencent.com/position_detail.php?id=42908&keywords=python&tid=0&lid=0',

......

'https://hr.tencent.com/position_detail.php?id=42832&keywords=python&tid=0&lid=0',

'https://hr.tencent.com/position_detail.php?id=42628&keywords=python&tid=0&lid=0']

'''

for index, name in enumerate(names):

information = {}

information['name'] = name

information['url'] = urls[index]

information['kind'] = kinds[index]

information['nums_of_need'] = nums[index]

information['address'] = addresses[index]

informations.append(information)

# print(informations)

# print(urls)

return urls, informations def parse_detail_page(url):

#one detail page

html = get_html(url)

return html def get_all_page(page_nums):

for i in range(0, page_nums):

url = 'https://hr.tencent.com/position.php?lid=&tid=&keywords=python&start={0}#a'.format(i*10)

html = get_html(url)

urls, informations = parse_html(html)

# print(informations)

works = []

for i, url in enumerate(urls): html_detail = parse_detail_page(url)

html_element = etree.HTML(html_detail)

work_intro = html_element.xpath('//td[@class="l2"]//text()')

for index, text in enumerate(work_intro):

if text.startswith('工作职责:'):

text = text.replace('工作职责:', '')

works_detail = {}

intros = []

for x in range(index+1, len(work_intro)):

intro = work_intro[x].strip()

if work_intro[x].startswith('工作要求:'):

break

intros.append(intro)

while '' in intros:

intros.remove('')

works_detail['1_____工作职责:'] = intros

works.append(works_detail)

# print(intros)

'''

['负责NLP与深度学习相关技术的研究与实现;',

'负责建设基础的语义分析工具和平台;',

'负责搜索系统、知识图谱系统、问答与对话系统的设计与搭建;',

'结合实际业务需求与数据,研发高效、稳健、完备的NLP解决方案。']

''' if text.startswith('工作要求:'):

text = text.replace('工作要求:', '')

works_detail = {}

requests = []

for x in range(index+1, len(work_intro)):

intro = work_intro[x].strip()

if work_intro[x].startswith('申请岗位'):

break

requests.append(intro)

while '' in requests:

requests.remove('')

works_detail['2_____工作要求:'] = requests

works.append(works_detail)

# print(requests)

'''

['三年以上自然语言处理经验包括语义表示、搜索、知识图谱、对话系统等;',

'扎实的编程基础,至少精通一种编程语言,如C++,Java,python等;',

'熟悉深度学习以及常见机器学习算法的原理与算法,能熟练运用聚类、分类、回归、排序等模型解决有挑战性的问题;',

'对自然语言处理相关的分词、词性标注、实体识别、句法分析、语义分析等有深入的实践经验;',

'有强烈求知欲,对人工智能领域相关技术有热情;', '具有良好的数学基础,良好的英语阅读能力;',

'有项目管理经验,与他人合作良好,能够独立有效推动复杂项目。']

'''

return works, informations def main():

works, informations = get_all_page(1)

for index, information in enumerate(informations):

list = []

list.append(works[index*2])

list.append(works[index*2+1])

information['duty'] = list

print(information) if __name__ == '__main__':

main()

目前sublime还输入不了中文,所以把输出注释上,方便看清格式

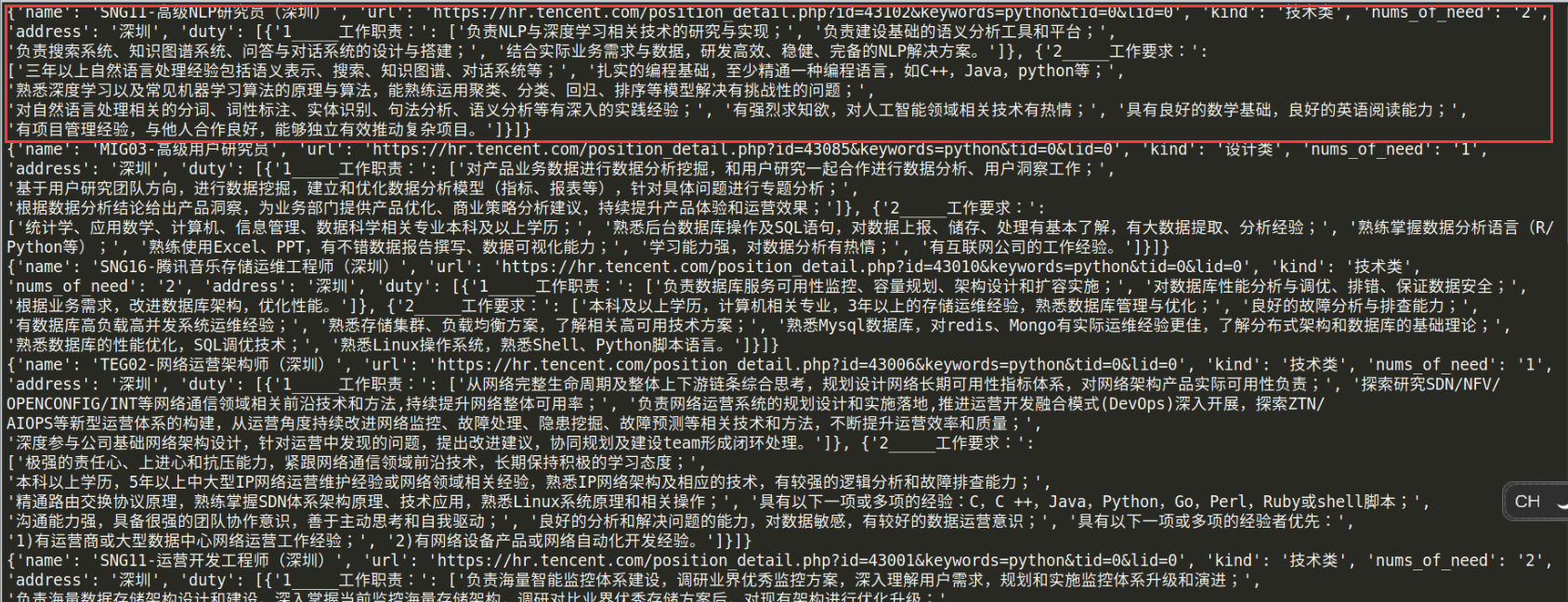

运行结果:

红色圈出来的是一个字典,包含第一个网页的信息(职位名称,url,位置)和详情页面的职责(工作职责,工作要求),嵌套的可能有点复杂,但目前还没有想到更简明的方法

爬虫_腾讯招聘(xpath)的更多相关文章

- python爬虫入门(三)XPATH和BeautifulSoup4

XML和XPATH 用正则处理HTML文档很麻烦,我们可以先将 HTML文件 转换成 XML文档,然后用 XPath 查找 HTML 节点或元素. XML 指可扩展标记语言(EXtensible Ma ...

- Scrapy实现腾讯招聘网信息爬取【Python】

一.腾讯招聘网 二.代码实现 1.spider爬虫 # -*- coding: utf-8 -*- import scrapy from Tencent.items import TencentIte ...

- pymongodb的使用和一个腾讯招聘爬取的案例

一.在python3中操作mongodb 1.连接条件 安装好pymongo库 启动mongodb的服务端(如果是前台启动后就不关闭窗口,窗口关闭后服务端也会跟着关闭) 3.使用 import pym ...

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- 学习笔记之Python全栈开发/人工智能公开课_腾讯课堂

Python全栈开发/人工智能公开课_腾讯课堂 https://ke.qq.com/course/190378 https://github.com/haoran119/ke.qq.com.pytho ...

- Scrapy 项目:腾讯招聘

目的: 通过爬取腾讯招聘网站(https://careers.tencent.com/search.html)练习Scrapy框架的使用 步骤: 1.通过抓包确认要抓取的内容是否在当前url地址中,测 ...

- 历峰集团3.43亿美元收购Net-a-Porter剩余股权_财经_腾讯网

历峰集团3.43亿美元收购Net-a-Porter剩余股权_财经_腾讯网 历峰集团3.43亿美元收购Net-a-Porter剩余股权

- 大Q品牌故事_大Q官网_腾讯旗下买卖宝公司倾力打造

大Q品牌故事_大Q官网_腾讯旗下买卖宝公司倾力打造 走在大路上的改变者,有态度的互联网手机品牌

- 凡客副总裁崔晓琦离职 曾负责旗下V+商城项目_科技_腾讯网

凡客副总裁崔晓琦离职 曾负责旗下V+商城项目_科技_腾讯网 凡客副总裁崔晓琦离职 曾负责旗下V+商城项目 腾讯科技[微博]乐天2013年09月18日12:44 分享 微博 空间 微信 新浪微博 邮箱 ...

随机推荐

- c++入门之出话指针和地址。

指针和地址是c和c++中重要的概念,在此,对指针做以下几方面的总结: new和delete: ]; point[] = ; point[] = ; point[] = ; cout << ...

- [2019BUAA软工助教]第一次阅读 - 小结

[2019BUAA软工助教]第一次阅读 - 小结 一.评分规则 总分 16 分,附加 2 分,共 18 分 markdown格式统一且正确 - 2分 不统一:扣 1 分 不正确:扣 1 分(例如使用代 ...

- Day7 Ubantu学习(一)

Linux是多用户操作系统 Ubantu学习参考网址:https://www.cnblogs.com/resn/p/5800922.html 1.虚拟机网络类型的理解 bridged(桥接模式) : ...

- P124黎曼可积性刻画 的两个备注

1.这里为什么是开集? 2.请问为什么说了是开集马上就说是有界可测函数? 开集为可测集

- Python_内置函数之round的幺蛾子

pycharm运行结果 1 ret = round(0.5) print(ret) >>> 0 ret1 = round(1.5) print(ret1) >>> ...

- JS刷新当前页面的几种方法总结

reload 方法,该方法强迫浏览器刷新当前页面. 语法:location.reload([bForceGet]) 参数: bForceGet, 可选参数, 默认为 false,从客户端缓存里取当前页 ...

- C#设计模式之4:装饰者模式

装饰者模式 背景是有一家星巴兹咖啡店,由于客源充足,所以决定重新设计他们的收费系统,以前的收费系统中只定义了一个表示饮料的Beverage的基类,它里面定义了一个Cost的方法用来计算饮料的花费,但是 ...

- Azure系列2.1.12 —— CloudBlobDirectory

(小弟自学Azure,文中有不正确之处,请路过各位大神指正.) 网上azure的资料较少,尤其是API,全是英文的,中文资料更是少之又少.这次由于公司项目需要使用Azure,所以对Azure的一些学习 ...

- [官网]How to configure the Microsoft Distributed Transaction Coordinator (MSDTC) on Linux

How to configure the Microsoft Distributed Transaction Coordinator (MSDTC) on Linux APPLIES TO: SQL ...

- CLOUD物料列表查询的一份跟踪

SELECT * FROM (SELECT t0.FNUMBER fnumber, t0_L.FNAME fname, t0_L.FSPECIFICATION fspecification, t0.F ...