吴恩达DeepLearning 第一课第四周随笔

第四周

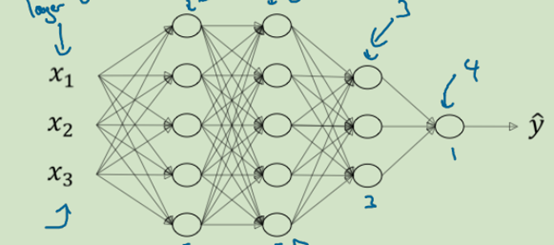

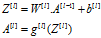

4.1深度神经网络符号约定

L=4______(神经网络层数)

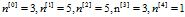

4.2 校正矩阵的维数

校正要点: ,

, ,

,

dZ,dA,dW,db都与它们被导数(Z,A,W,b)的维数相同

4.3 为什么使用深层表示

按神经网络的概念(仿人脑):有浅层的简单识别出一些特征,然后再通过深层的组合,最终,整个网络实现一个复杂的问题

按电路来说:一个巨大的计算问题,分几路出去(特征,隐藏层),最后在慢慢整合,节约计算成本

吴推荐思路:从logistic回归开始建立,然后,由1层隐藏层,2层,慢慢尝试,找出一个适合的结构,将隐藏层作为超参数调整。不要一上来就要什么10+隐藏层怼

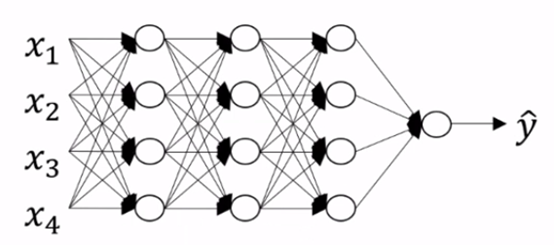

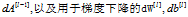

4.4 反向传播

反向传播:输入  ,

,

输出

注意:

计算 是,那个*,代表対应为元素相乘,不累加

是,那个*,代表対应为元素相乘,不累加

是根据成本函数来决定出来的

是根据成本函数来决定出来的

这样看,实际上反向传播的算法公式也很简单,很固定。需要计算的也就是

- 每一层激活函数的

的导数,如果选用relu函数,更简单了,导数=1。当然,要记住在Z=0时是没有导数的,需要自定义一下。Z为负数的时候,你可以选择maximum(0.01Z,Z)这样倒是就是0.01了, 通常是规避出现负数。激活函数设的简单,或许那些研究深度学习算法的大佬,微积分要补下课

的导数,如果选用relu函数,更简单了,导数=1。当然,要记住在Z=0时是没有导数的,需要自定义一下。Z为负数的时候,你可以选择maximum(0.01Z,Z)这样倒是就是0.01了, 通常是规避出现负数。激活函数设的简单,或许那些研究深度学习算法的大佬,微积分要补下课

- 另一个需要计算的就是

了,看成本函数取什么

了,看成本函数取什么

4.5 参数VS 超参数

超参数可以控制参数的输出结果。超参数的最优值是不断尝试,找出来的。但最优值会随着时间发生变化。造成这些原因有可能是你训练的数据增加了,CPU/GPU算例增加了,你训练的数据发送了变化。最优值只是这个时间段的最优值,并不是永恒的最优值。

吴恩达DeepLearning 第一课第四周随笔的更多相关文章

- 吴恩达deepLearning.ai循环神经网络RNN学习笔记_看图就懂了!!!(理论篇)

前言 目录: RNN提出的背景 - 一个问题 - 为什么不用标准神经网络 - RNN模型怎么解决这个问题 - RNN模型适用的数据特征 - RNN几种类型 RNN模型结构 - RNN block - ...

- 吴恩达deepLearning.ai循环神经网络RNN学习笔记_没有复杂数学公式,看图就懂了!!!(理论篇)

本篇文章被Google中国社区组织人转发,评价: 条理清晰,写的很详细! 被阿里算法工程师点在看! 所以很值得一看! 前言 目录: RNN提出的背景 - 一个问题 - 为什么不用标准神经网络 - RN ...

- 用纯Python实现循环神经网络RNN向前传播过程(吴恩达DeepLearning.ai作业)

Google TensorFlow程序员点赞的文章! 前言 目录: - 向量表示以及它的维度 - rnn cell - rnn 向前传播 重点关注: - 如何把数据向量化的,它们的维度是怎么来的 ...

- 吴恩达DeepLearning.ai的Sequence model作业Dinosaurus Island

目录 1 问题设置 1.1 数据集和预处理 1.2 概览整个模型 2. 创建模型模块 2.1 在优化循环中梯度裁剪 2.2 采样 3. 构建语言模型 3.1 梯度下降 3.2 训练模型 4. 结论 ...

- Deap Learning (吴恩达) 第一章深度学习概论 学习笔记

Deap Learning(Ng) 学习笔记 author: 相忠良(Zhong-Liang Xiang) start from: Sep. 8st, 2017 1 深度学习概论 打字太麻烦了,索性在 ...

- 一文看懂神经网络初始化!吴恩达Deeplearning.ai最新干货

[导读]神经网络的初始化是训练流程的重要基础环节,会对模型的性能.收敛性.收敛速度等产生重要的影响.本文是deeplearning.ai的一篇技术博客,文章指出,对初始化值的大小选取不当, 可能造成 ...

- 吴恩达deeplearning之CNN—卷积神经网络

https://blog.csdn.net/ice_actor/article/details/78648780 个人理解: 卷积计算的过程其实是将原始的全连接换成了卷积全连接,每个kernel为对应 ...

- 2017年度好视频,吴恩达、李飞飞、Hinton、OpenAI、NIPS、CVPR、CS231n全都在

我们经常被问:机器翻译迭代了好几轮,专业翻译的饭碗都端不稳了,字幕组到底还能做什么? 对于这个问题,我们自己感受最深,却又来不及解释,就已经边感受边做地冲出去了很远,摸爬滚打了一整年. 其实,现在看来 ...

- 吴恩达讲了干货满满的一节全新AI课,全程手写板书充满诚意非常干货

吴恩达讲了干货满满的一节全新AI课,全程手写板书充满诚意非常干货 摘要: 目前,AI技术做出的经济贡献几乎都来自监督学习,也就是学习从A到B,从输入到输出的映射.现在,监督学习.迁移学习.非监督学习. ...

随机推荐

- git 提交各种情况下的处理方式

自己总结: 01.若在提交过程中有冲突,解决冲突后,git add . git rebase —continue git push for 02.git rebase vs git merge g ...

- [持续更新] Linux基础的重要命令

命令总结:100个左右 mkdir 方法一 [root@localhost ~]# mkdir /test && ls -ld /test 方法二 [root@localhost ~] ...

- (C#) Handling and Raising Events

Handling and Raising Events .NET Framework 4.5 Other Versions 6 out of 20 rated this helpful - ...

- SpringCloud的学习记录(2)

这一章节主要讲如何搭建eureka-client项目. 在我们生成的Demo项目上右键点击New->Module->spring Initializr, 然后next, 填写Group和A ...

- 线程队列queue

队列queue 队列用于线程之间安全的信息交换 队列和列表的区别:队列里的信息get()后就没了,而列表获取数据则是copy,原列表里的值还在 使用前先实例化队列 q = queue.Queue(ma ...

- Do not set "root" as "NOPASSWD" in sudoers file

cat /etc/sudoers root ALL=(ALL)ALL: ALL do not change it to root ALL=(ALL)NOPASSWD: ALL Since ...

- linux挂载和卸载NAS操作

1.建立准备挂载NFS的目录,例如:cd /home/test,mkdir my_NFS_Catalog 2.挂接NFS至 /home/test/my_NFS_Catalog目录下(nas有两种格式: ...

- ZOJ - 2112 Dynamic Rankings(BIT套主席树)

纠结了好久的一道题,以前是用线段树套平衡树二分做的,感觉时间复杂度和分块差不多了... 终于用BIT套函数式线段树了过了,120ms就是快,此题主要是卡内存. 假设离散后有ns个不同的值,递归层数是l ...

- ios 逆向工程文档汇总

iOS逆向工程工具集 http://www.jianshu.com/p/7f9511d48e05 移动App入侵与逆向破解技术-iOS篇 http://blog.csdn.net/heiby/arti ...

- 旧文备份:rtlinux安装手册

前段时间接触了几天RTLinux,折腾了好几天才总算把它安装上,得益于Prof. Chang-Gun Lee的安装建议,觉得该文档可能会对准备尝试安装RTLinux的朋友们有帮助,本人英语很烂,也比较 ...