python网络爬虫(12)去哪网酒店信息爬取

目的意义

爬取某地的酒店价格信息,示例使用selenium在Firefox中的使用。

来源

少部分来源于书。python爬虫开发与项目实战

构造

本次使用简易的方案,模拟浏览器访问,然后输入字段,查找,然后抓取网页中的信息。存储csv中。然后再转换为Excel,并对其中的数据进行二次处理。

代码

整个过程相当于获取网页,下载,然后粗糙的存储过程,最终完成。

不能理解的是,这样是使用了Phantomjs么。

from selenium import webdriver

from selenium.webdriver.support.wait import WebDriverWait

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

import re

import csv

import time class goWhere():

def __init__(self):

self.toCity=u'焦作'

self.driver=webdriver.Firefox()

self.driver.get("https://hotel.qunar.com/")

self.get_element()

for i in range(30):

self.get_response()

self.parser_store()

self.get_next_page() def get_element(self):

self.elem_toCity=self.driver.find_element_by_name(u"toCity")

self.elem_fromDate=self.driver.find_element_by_name(u"fromDate")

self.elem_toDate=self.driver.find_element_by_name(u"toDate")

self.elem_search=self.driver.find_element_by_class_name('search-btn')

self.elem_toCity.clear()

self.elem_toCity.send_keys(self.toCity)

self.elem_search.click() def get_response(self):

for i in range(5):

try:

WebDriverWait(self.driver,30).until(EC.presence_of_element_located((

By.CLASS_NAME,"item_price")))

break

except Exception as e:

self.driver.refresh()

print(e)

if(i==10):

self.driver.close()

exit()

js="window.scrollTo(0,document.body.scrollHeight);"

self.driver.execute_script(js)

time.sleep(5)

self.all=self.driver.find_elements_by_class_name("b_result_bd")

if(len(self.all)<16 or self.all[0].text==''):

self.driver.refresh()

self.get_response() def parser_store(self):

pattern=re.compile('(.*\s?)')

for each in self.all:

each_text=re.findall(pattern, each.text)

print(each_text)

with open('text.csv','a',encoding='gb18030',newline='') as f:

f_csv=csv.writer(f,)

if len(each_text)==8:

each_text.pop(5)

if len(each_text)==6:

each_text.insert(2,'None')

f_csv.writerow(each_text)

print('finished') def get_next_page(self):

self.nextBtn=self.driver.find_element_by_class_name('next')

self.nextBtn.click() if __name__=='__main__':

goWhere()

print('task finish')

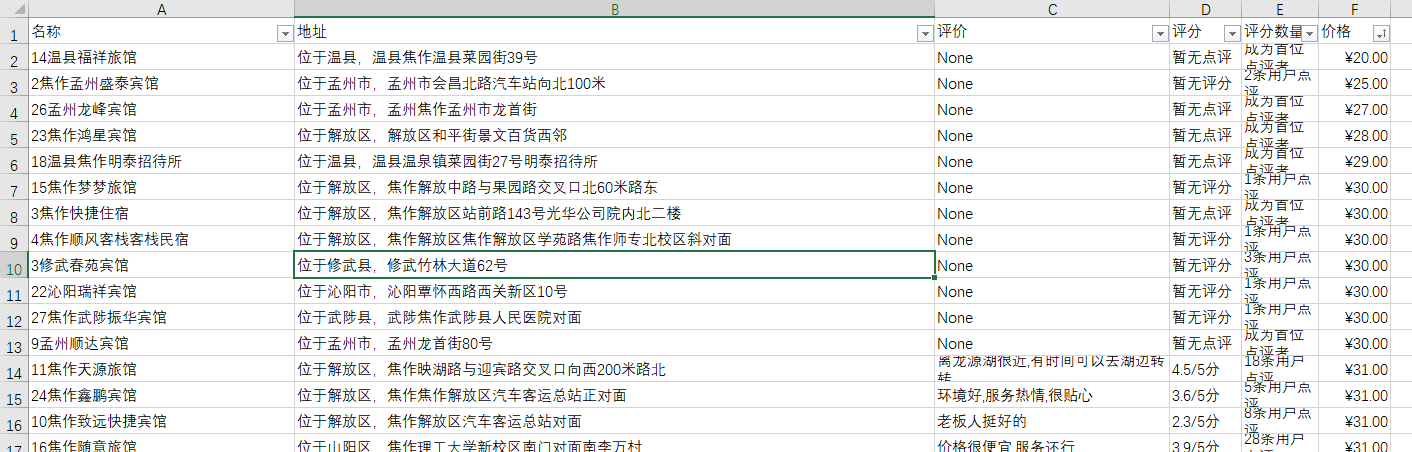

效果举例

二次处理的过程包括处理价格中的??,处理查看地图,处理礼品卡等字段,然后去掉起字,设定价格单元格为人民币格式。

后续

在实际操作过程中,有时网页不容易加载完成,有时加载正常。本次爬取的界面为26个左右共计780余数据。并没有完成数据爬取过程。

python网络爬虫(12)去哪网酒店信息爬取的更多相关文章

- Python开发爬虫之BeautifulSoup解析网页篇:爬取安居客网站上北京二手房数据

目标:爬取安居客网站上前10页北京二手房的数据,包括二手房源的名称.价格.几室几厅.大小.建造年份.联系人.地址.标签等. 网址为:https://beijing.anjuke.com/sale/ B ...

- Python 爬虫练手项目—酒店信息爬取

from bs4 import BeautifulSoup import requests import time import re url = 'http://search.qyer.com/ho ...

- [Python3网络爬虫开发实战] 7-动态渲染页面爬取

在前一章中,我们了解了Ajax的分析和抓取方式,这其实也是JavaScript动态渲染的页面的一种情形,通过直接分析Ajax,我们仍然可以借助requests或urllib来实现数据爬取. 不过Jav ...

- Python网络爬虫笔记(一):网页抓取方式和LXML示例

(一) 三种网页抓取方法 1. 正则表达式: 模块使用C语言编写,速度快,但是很脆弱,可能网页更新后就不能用了. 2. Beautiful Soup 模块使用Python编写,速度慢. ...

- 《精通Python网络爬虫》|百度网盘免费下载|Python爬虫实战

<精通Python网络爬虫>|百度网盘免费下载|Python爬虫实战 提取码:7wr5 内容简介 为什么写这本书 网络爬虫其实很早就出现了,最开始网络爬虫主要应用在各种搜索引擎中.在搜索引 ...

- Python网络爬虫入门篇

1. 预备知识 学习者需要预先掌握Python的数字类型.字符串类型.分支.循环.函数.列表类型.字典类型.文件和第三方库使用等概念和编程方法. 2. Python爬虫基本流程 a. 发送请求 使用 ...

- 学习推荐《精通Python网络爬虫:核心技术、框架与项目实战》中文PDF+源代码

随着大数据时代的到来,我们经常需要在海量数据的互联网环境中搜集一些特定的数据并对其进行分析,我们可以使用网络爬虫对这些特定的数据进行爬取,并对一些无关的数据进行过滤,将目标数据筛选出来.对特定的数据进 ...

- 【学习笔记】PYTHON网络爬虫与信息提取(北理工 嵩天)

学习目的:掌握定向网络数据爬取和网页解析的基本能力the Website is the API- 1 python ide 文本ide:IDLE,Sublime Text集成ide:Pychar ...

- Python网络爬虫:空姐网、糗百、xxx结果图与源码

如前面所述,我们上手写了空姐网爬虫,糗百爬虫,先放一下传送门: Python网络爬虫requests.bs4爬取空姐网图片Python爬虫框架Scrapy之爬取糗事百科大量段子数据Python爬虫框架 ...

随机推荐

- sql注入的基本小知识

load_fie('') into outfile '' into dumpfile('') 堆叠注入 ;insert into liunx密码读取 /etc/passwd /etc/shadow W ...

- LightGBM GPU python版本安装

失败的安装尝试 1.官方Guide https://lightgbm.readthedocs.io/en/latest/GPU-Windows.html 生成在windows下可执行的exe程序,但是 ...

- Docker安装Redis及Warning解决方法

虚拟机环境:VirtualBox 操作系统:CentOS 7 宿主机: Microsoft Windows 10 家庭中文版 Docker简介 Docker是一个轻量级容器技术.Docker直接运行在 ...

- Leetcode题目21.合并两个有序链表(简单)

题目描述: 将两个有序链表合并为一个新的有序链表并返回.新链表是通过拼接给定的两个链表的所有节点组成的. 示例: 输入:1->2->4, 1->3->4输出:1->1-& ...

- MQTT 连接服务端失败,报错客户机未连接(32104)

和同事协同开发项目,在启动项目时偶尔报错连接不到MQTT 服务器. 原因是两个人开发同一个项目,连接MQTT时配置的 client-id 相同,在使用一个client-id连接到MQTT服务器后,再使 ...

- LeetCode 179. 最大数(Largest Number)

题目描述 给定一组非负整数,重新排列它们的顺序使之组成一个最大的整数. 示例 1: 输入: [10,2] 输出: 210 示例 2: 输入: [3,30,34,5,9] 输出: 9534330 说明: ...

- Ubuntu14.04升级cmake版本的方法

在Ubuntu14.04用以下命令默认安装的cmake版本为2.8.x,有时我们需要更高版本的cmake,所以需要升级. $ sudo apt-get install cmake 可通过以下命令查询c ...

- 七十五:flask.Restful之Restful.API介绍

restful api是用于在前端与后台进行通信的一套规范,使用这个规范可以让前后端开发变得更加轻松 协议:http或者https 数据传输格式:使用json url链接:url链接中不能有动词(/g ...

- [转] ansible批量执行命令展示

[From] https://blog.csdn.net/zhydream77/article/details/81223805 ansible命令基础 • ansible <host-patt ...

- Computed Styles

The style object offers no information about the styles that have cascaded from style sheets and aff ...