使用selenium webdriver+beautifulsoup+跳转frame,实现模拟点击网页下一页按钮,抓取网页数据

记录一次快速实现的python爬虫,想要抓取中财网数据引擎的新三板板块下面所有股票的公司档案,网址为http://data.cfi.cn/data_ndkA0A1934A1935A1986A1995.html。

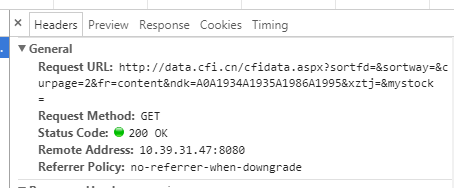

比较简单的网站不同的页码的链接也不同,可以通过观察链接的变化找出规律,然后生成全部页码对应的链接再分别抓取,但是这个网站在换页的时候链接是没有变化的,因此打算去观察一下点击第二页时的请求

发现使用的是get的请求方法,并且请求里有curpage这个参数,貌似控制着不同页数,于是改动了请求链接中的这个参数值为其他数值发现并没有变化,于是决定换一种方法,就是我们标题中提到的使用selenium+beautifulsoup实现模拟点击网页中的下一页按钮来实现翻页,并分别抓取网页里的内容。

首先我们先做一下准备工作,安装一下需要的包,打开命令行,直接pip install selenium和pip install beautifulsoup4

然后就是下载安装chromedriver的驱动,网址如下https://sites.google.com/a/chromium.org/chromedriver/downloads,记得配置下环境变量或者直接安装在工作目录下。(还可以使用IE、phantomJS等)

这里我们先抓取每一个股票对应的主页链接,代码如下(使用python2):

1 # -*- coding: utf-8 -*-

2 from selenium import webdriver

3 from bs4 import BeautifulSoup

4 import sys

5 reload(sys)

6 sys.setdefaultencoding('utf-8')

7

8 def crawl(url):

9 driver = webdriver.Chrome()

10 driver.get(url)

11 page = 0

12 lst=[]

13 with open('./url.txt','a') as f:

14 while page < 234:

15 soup = BeautifulSoup(driver.page_source, "html.parser")

16 print(soup)

17 urls_tag = soup.find_all('a',target='_blank')

18 print(urls_tag)

19 for i in urls_tag:

20 if i['href'] not in lst:

21 f.write(i['href']+'\n')

22 lst.append(i['href'])

23 driver.find_element_by_xpath("//a[contains(text(),'下一页')]").click()

24 time.sleep(2)

25 return 'Finished'

26 def main():

27 url = 'http://data.cfi.cn/cfidata.aspx?sortfd=&sortway=&curpage=2&fr=content&ndk=A0A1934A1935A1986A1995&xztj=&mystock='

28 crawl(url)

29 if __name__ == '__main__':

30 main()

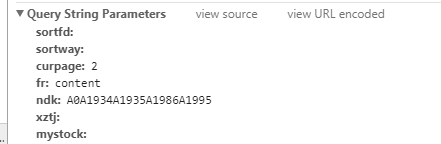

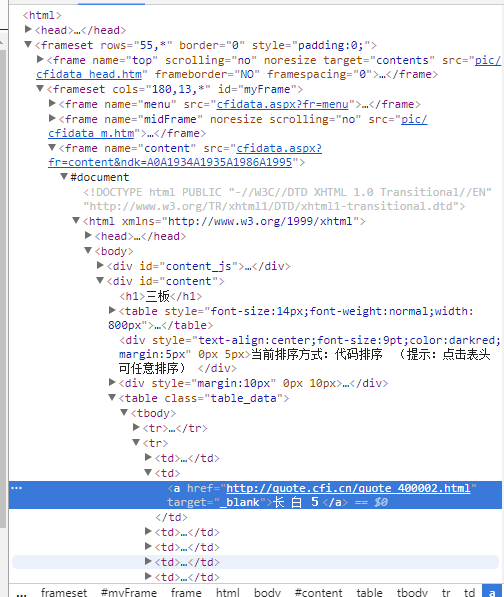

运行代码发现总是报错:

这里报错的意思是找不到想要找的按钮。

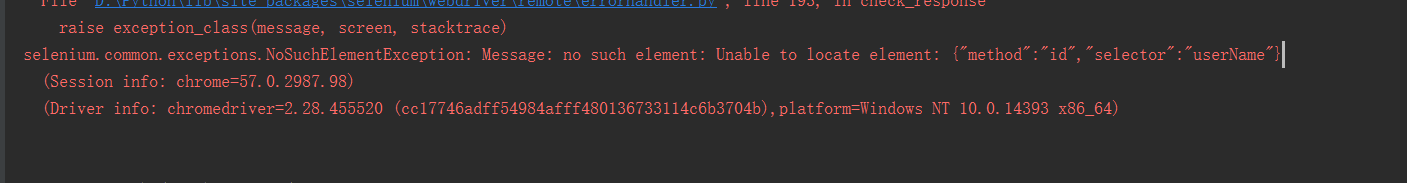

于是我们去查看一下网页源代码:

发现网页分为不同的frame,所以我们猜想应该需要跳转frame,我们需要抓取的链接处于的frame的name为“content”,所以我们添加一行代码:driver.switch_to.frame('content')

def crawl(url):

driver = webdriver.Chrome()

driver.get(url)

driver.switch_to.frame('content')

page = 0

lst=[]

with open('./url.txt','a') as f:

while page < 234:

soup = BeautifulSoup(driver.page_source, "html.parser")

print(soup)

urls_tag = soup.find_all('a',target='_blank')

print(urls_tag)

for i in urls_tag:

if i['href'] not in lst:

f.write(i['href']+'\n')

lst.append(i['href'])

driver.find_element_by_xpath("//a[contains(text(),'下一页')]").click()

time.sleep(2)

return 'Finished'

至此,运行成:

参考博文链接: http://unclechen.github.io/2016/12/11/python%E5%88%A9%E7%94%A8beautifulsoup+selenium%E8%87%AA%E5%8A%A8%E7%BF%BB%E9%A1%B5%E6%8A%93%E5%8F%96%E7%BD%91%E9%A1%B5%E5%86%85%E5%AE%B9/

http://www.cnblogs.com/liyuhang/p/6661835.html

使用selenium webdriver+beautifulsoup+跳转frame,实现模拟点击网页下一页按钮,抓取网页数据的更多相关文章

- 使用Selenium+firefox抓取网页指定firefox_profile后的问题

from: https://blog.csdn.net/chufazhe/article/details/51145834 摘要:在使用selenium和firefox抓取网页指定firefox_pr ...

- [Python爬虫] 之八:Selenium +phantomjs抓取微博数据

基本思路:在登录状态下,打开首页,利用高级搜索框输入需要查询的条件,点击搜索链接进行搜索.如果数据有多页,每页数据是20条件,读取页数 然后循环页数,对每页数据进行抓取数据. 在实践过程中发现一个问题 ...

- [Python爬虫] 之四:Selenium 抓取微博数据

抓取代码: # coding=utf-8import osimport refrom selenium import webdriverimport selenium.webdriver.suppor ...

- selenium配合phantomjs实现爬虫功能,并把抓取的数据写入excel

# -*- coding: UTF-8 -*- ''' Created on 2016年5月13日 @author: csxie ''' import datetime from Base impor ...

- 利用selenium抓取网页的ajax请求

部门需要一个自动化脚本,完成web端界面功能的冒烟,并且需要抓取加载页面时的ajax请求,从接口层面判断请求是否成功.查阅了很多资料都没有人有过相关问题的处理经验,在处理过程中也踩了很多坑,所以如果你 ...

- php使用curl抓取网页自动跳转问题处理

问题分析: 请求抓取http://go.com数据: function curlGet($url) { $ch = curl_init(); curl_setopt($ch, CURLOPT_URL, ...

- python+selenium+webdriver+BeautifulSoup实现自动登录

from selenium import webdriverimport timefrom bs4 import BeautifulSoupfrom urllib import requestimpo ...

- 一、使用 BeautifulSoup抓取网页信息信息

一.解析网页信息 from bs4 import BeautifulSoup with open('C:/Users/michael/Desktop/Plan-for-combating-master ...

- Selenium webdriver 截图 太长截不全的问题

Selenium webdriver 截图 太长截不全的问题 1.环境 selenium webdriver.net 2.46.0.0 + firefox 37.0.1 + win 8.1 2.问题 ...

随机推荐

- 如何使用fiddler抓取https请求(PC和移动端)

最近做一个抓取移动端app接口,并执行评论,收藏的接口功能测试.怎么搞/(ㄒoㄒ)/~~ 按照老思路试一试,第一步还是要用fiddler来帮忙获取接口信息! 一.基本的抓取http请求设置: 1.cm ...

- java进程/线程;堆和栈;多线程

一.进程和线程 进程:在内存中运行的应用程序,一个exe是一个进程. 如:ps -exf 可以查看各个应用的进程,其中ppid为父进程: ps aux | egrep '(cron|syslog)' ...

- IBAction&IBOutlet

IB:Interface Builder 1>IBAction 需要操作,例如按钮的点击 2> IBOutlet 需要获得.修改该属性 然后就可以与Storyboard建立起联系

- vue实例讲解之vuex的使用

vuex是一个状态管理插件,本文通过一个简单的实例来讲解一下,vuex的使用. 先看一张官方的图: 这个图新手一看估计是蒙的,简单解释一下,这个图表示的就是vue通过Action Mutations ...

- Angular JS的正确打开姿势——简单实用(上)

前 言 絮叨絮叨 在分享了JS和JQuery之后,今天再给大家分享一个好玩并且特别好用JS框架--AngularJS. 一. AngularJS简介 AngularJS 诞生于2009年,由 ...

- 组合 Lucas定理

组合 Time Limit: 1000MS Memory Limit: 32768KB 64bit IO Format: %I64d & %I64u [Submit] [Go Ba ...

- Dubbo分布式服务子系统的划分

一.划分子系统的策略 按照系统的业务模块的独立性划分 二.划分时服务子系统的数量的控制 过多:可能划分过细,破坏业务子系统的独立性,部署维护工作量大,独立进程占用内存多 过少:没能很好的解耦,开发维护 ...

- Ansible(二) - 配置及命令简介

Ⅰ. Ansible Inventory Hosts文件配置 # mkdir /etc/ansible # touch /etc/ansible/hosts # cat /etc/hosts 127. ...

- php版本的选择

简单来说non-thread-safe 非 线程安全 与IIS 搭配环境,thread-safe 线程安全 与apache 搭配的 环境这个大家一定要注意,否则用错了版本,apache是无法启动的,另 ...

- windows无法启动MySQL服务 错误1067

启动wampmysqld 出现 1067 错误 解决方法:删除在MySQL安装目录下的Data目录中的ib_logfile0和ib_logfile1这两个文件. 重新启动MySQL服务