Spark踩坑记——初试

[TOC]

Spark简介

整体认识

Apache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架。最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache的开源项目之一。

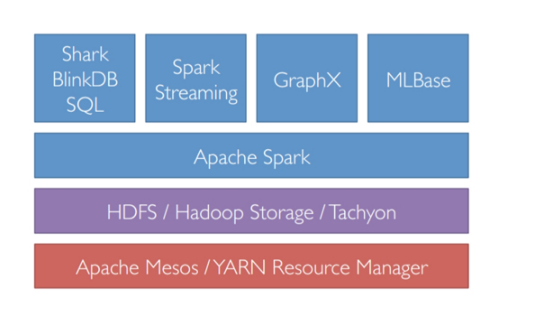

Spark在整个大数据系统中处于中间偏上层的地位,如下图,对hadoop起到了补充作用:

基本概念

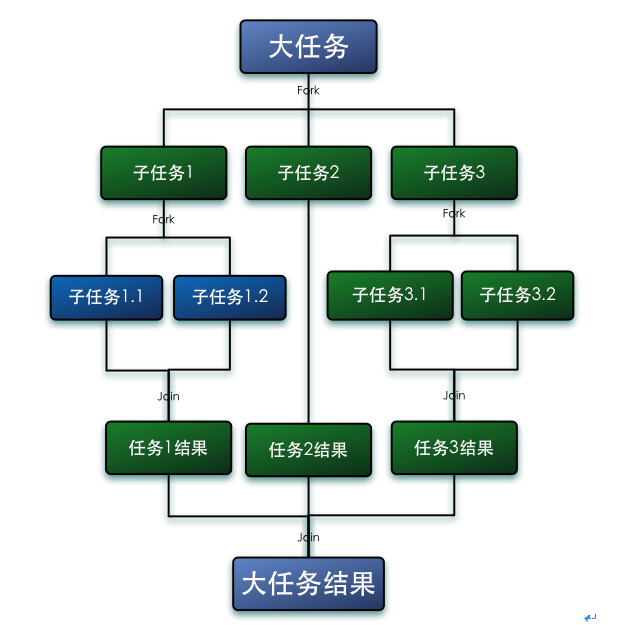

Fork/Join框架是Java7提供了的一个用于并行执行任务的框架, 是一个把大任务分割成若干个小任务,最终汇总每个小任务结果后得到大任务结果的框架。

- 第一步分割任务。首先我们需要有一个fork类来把大任务分割成子任务,有可能子任务还是很大,所以还需要不停的分割,直到分割出的子任务足够小。

第二步执行任务并合并结果。分割的子任务分别放在双端队列里,然后几个启动线程分别从双端队列里获取任务执行。子任务执行完的结果都统一放在一个队列里,启动一个线程从队列里拿数据,然后合并这些数据。

具体可参考Fork/Join核心概念

- RDD(Resilient Distributed Dataset) 弹性分布数据集介绍

弹性分布式数据集(基于Matei的研究论文)或RDD是Spark框架中的核心概念。可以将RDD视作数据库中的一张表。其中可以保存任何类型的数据。Spark将数据存储在不同分区上的RDD之中。

RDD可以帮助重新安排计算并优化数据处理过程。

此外,它还具有容错性,因为RDD知道如何重新创建和重新计算数据集。

RDD是不可变的。你可以用变换(Transformation)修改RDD,但是这个变换所返回的是一个全新的RDD,而原有的RDD仍然保持不变。

RDD支持两种类型的操作:- 变换(Transformation)

- 行动(Action)

变换:变换的返回值是一个新的RDD集合,而不是单个值。调用一个变换方法,不会有任何求值计算,它只获取一个RDD作为参数,然后返回一个新的RDD。变换函数包括:map,filter,flatMap,groupByKey,reduceByKey,aggregateByKey,pipe和coalesce。

行动:行动操作计算并返回一个新的值。当在一个RDD对象上调用行动函数时,会在这一时刻计算全部的数据处理查询并返回结果值。

行动操作包括:reduce,collect,count,first,take,countByKey以及foreach。

- 共享变量(Shared varialbes)

- 广播变量(Broadcast variables)

- 累加器(Accumulators)

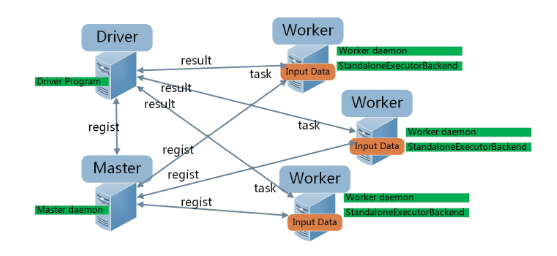

- Master/Worker/Driver/Executor

- Master:1. 接受Worker的注册请求,统筹记录所有Worker的CPU、Memory等资源,并跟踪Worker结点的活动状态;2. 接受Driver中App的注册请求(这个请求由Driver端的Client发出),为App在Worker上分配CPU、Memory资源,生成后台Executor进程;之后跟踪Executor和App的活动状态。

- Worker:负责接收Master的指示,为App创建Executor进程。Worker在Master和Executor之间起着桥梁作用,实际不会参与计算工作。

- Driver:负责用户侧逻辑处理。

- Executor:负责计算,接受并执行由App划分的Task任务,并将结果缓存在本地内存或磁盘。

Spark部署

关于Spark的部署网上相关资料很多,这里进行归纳整理

部署环境

- Ubuntu 14.04LTS

- Hadoop:2.7.0

- Java JDK 1.8

- Spark 1.6.1

- Scala 2.11.8

Hadoop安装

由于Spark会利用HDFS和YARN,所以需要提前配置Hadoop,配置教程可以参考:

Setting up a Apache Hadoop 2.7 single node on Ubuntu 14.04

Hadoop安装教程_单机/伪分布式配置_Hadoop2.6.0/Ubuntu14.04

Spark安装

在安装好Hadoop的基础上,搭建Spark,配置教程参考:

Spark快速入门指南 – Spark安装与基础使用

scala安装

Scala作为编写Spark的源生语言,更新速度和支持情况肯定是最好的,而另一方面Scala本身语言中对于面向对象和函数式编程两种思想的糅合,使得该语言具有很多炫酷的语法糖,所以在使用Spark的过程中我采用了Scala语言进行开发。

- Scala最终编译成字节码需要运行在JVM中,所以需要依托于jdk,需要部署jdk

- Eclipse作为一款开发Java的IDE神器,在Scala中当然也可以使用,有两种方式:

- Eclipse->Help->Install New Software安装Scala Plugins

- 下载官网已经提供的集成好的Scala IDE

- 基于以上两步已经可以进行Scala开发,需要用到Scala自带的SBT编译的同学可以装下Scala官网下载地址,本人一直使用Maven进行包管理就延续Maven的使用

简单示例:WordCount(Spark Scala)

- 开发IDE:Eclipse Scala

- 包管理:Maven

- 开发语言:Scala

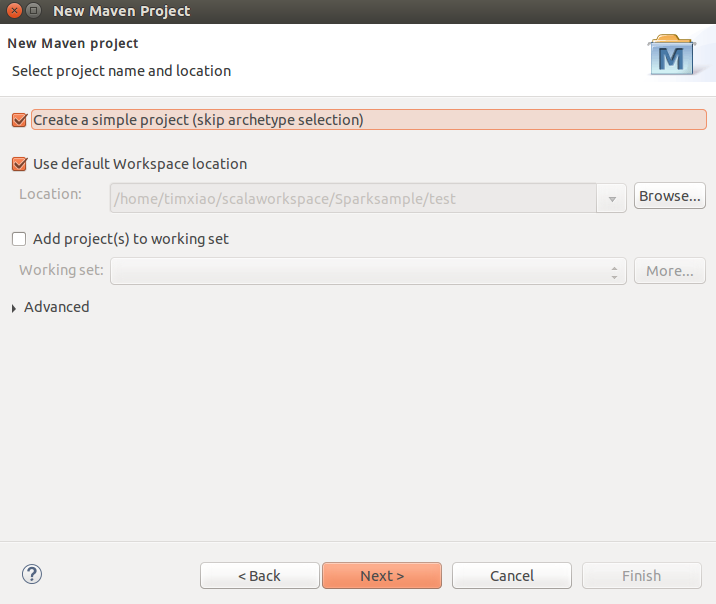

创建Maven项目

跳过archetype项目模板的选择- 下载模板pom.xml

- 对maven项目添加Scala属性:

Right click on project -> configure - > Add Scala Nature. - 调整下Scala编译器的版本,与Spark版本对应:

Right click on project- > Go to properties -> Scala compiler -> update Scala installation version to 2.10.5 - 从Build Path中移除Scala Library(由于在Maven中添加了Spark Core的依赖项,而Spark是依赖于Scala的,Scala的jar包已经存在于Maven Dependency中):

Right click on the project -> Build path -> Configure build path and remove Scala Library Container. - 添加package包com.spark.sample

- 创建Object WordCount和SimpleCount,用来作为Spark的两个简单示例

Spark Sample

源码

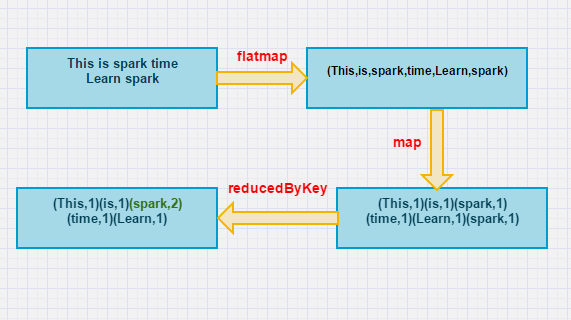

原理如下图:

参考文献:

- http://km.oa.com/group/2430/articles/show/181711?kmref=search&from_page=1&no=1&is_from_iso=1

- http://spark.apache.org/docs/latest/programming-guide.html#resilient-distributed-datasets-rdds

- http://www.infoq.com/cn/articles/apache-spark-introduction?utm_source=infoq_en&utm_medium=link_on_en_item&utm_campaign=item_in_other_langs

- http://www.infoq.com/cn/articles/apache-spark-sql

- http://www.infoq.com/cn/articles/apache-spark-streaming

- http://www.devinline.com/2016/01/apache-spark-setup-in-eclipse-scala-ide.html

- https://databricks.gitbooks.io/databricks-spark-reference-applications/content/

- http://wuchong.me/blog/2015/04/06/spark-on-hbase-new-api/

- http://colobu.com/2015/01/05/kafka-spark-streaming-integration-summary/

- http://www.devinline.com/2016/01/apache-spark-setup-in-eclipse-scala-ide.html

Spark踩坑记——初试的更多相关文章

- Spark踩坑记——数据库(Hbase+Mysql)

[TOC] 前言 在使用Spark Streaming的过程中对于计算产生结果的进行持久化时,我们往往需要操作数据库,去统计或者改变一些值.最近一个实时消费者处理任务,在使用spark streami ...

- Spark踩坑记——共享变量

[TOC] 前言 Spark踩坑记--初试 Spark踩坑记--数据库(Hbase+Mysql) Spark踩坑记--Spark Streaming+kafka应用及调优 在前面总结的几篇spark踩 ...

- Spark踩坑记——从RDD看集群调度

[TOC] 前言 在Spark的使用中,性能的调优配置过程中,查阅了很多资料,之前自己总结过两篇小博文Spark踩坑记--初试和Spark踩坑记--数据库(Hbase+Mysql),第一篇概况的归纳了 ...

- [转]Spark 踩坑记:数据库(Hbase+Mysql)

https://cloud.tencent.com/developer/article/1004820 Spark 踩坑记:数据库(Hbase+Mysql) 前言 在使用Spark Streaming ...

- Spark踩坑记——数据库(Hbase+Mysql)转

转自:http://www.cnblogs.com/xlturing/p/spark.html 前言 在使用Spark Streaming的过程中对于计算产生结果的进行持久化时,我们往往需要操作数据库 ...

- Spark踩坑记——Spark Streaming+Kafka

[TOC] 前言 在WeTest舆情项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark strea ...

- Spark踩坑记:Spark Streaming+kafka应用及调优

前言 在WeTest舆情项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark streaming从k ...

- Spark踩坑记:共享变量

收录待用,修改转载已取得腾讯云授权 前言 前面总结的几篇spark踩坑博文中,我总结了自己在使用spark过程当中踩过的一些坑和经验.我们知道Spark是多机器集群部署的,分为Driver/Maste ...

- 【踩坑记】从HybridApp到ReactNative

前言 随着移动互联网的兴起,Webapp开始大行其道.大概在15年下半年的时候我接触到了HybridApp.因为当时还没毕业嘛,所以并不清楚自己未来的方向,所以就投入了HybridApp的怀抱. Hy ...

随机推荐

- 关于这段时间学习 EntityFramework的 一点感悟

Ado.Net,用了N多年,Entity Framework也关注了很多年. 每当项目转型的时候,就花费大巴的时间,学习一番,潮流的东西. 这个Orm很多,这个EF很火,这么多年了,我还是不敢用,虽然 ...

- java中servlet的各种路径

1. web.xml中<url-pattern>路径,(叫它Servlet路径!) > 要么以“*”开关,要么为“/”开头 2. 转发和包含路径 > *****以“/”开头:相 ...

- JavaScript之职责链模式

一.概述 职责链模式(Chain of responsibility),就是使多个对象都有机会处理请求,从而避免请求的发送者和接受者之间的耦合关系.将这个对象连成一条链,并沿着这条链传递该请求,直到有 ...

- 【绝对干货】仿微信QQ设置图形头像裁剪,让你的App从此炫起来~

最近在做毕业设计,想有一个功能和QQ一样可以裁剪头像并设置圆形头像,额,这是设计狮的一种潮流. 而纵观现在主流的APP,只要有用户系统这个功能,这个需求一般都是在(bu)劫(de)难(bu)逃(xue ...

- OSGi规范的C#实现开源

这是大约在3-4年前完成的一个C#实现的OSGi框架,实现的过程参照了OSGi规范与与一些实现思路(感谢当时的那些资料与项目),此框架虽然仅在几个小型项目有过实际的应用,但OSGi的规范实现还是相对比 ...

- Android之数据存储的五种方法

1.Android数据存储的五种方法 (1)SharedPreferences数据存储 详情介绍:http://www.cnblogs.com/zhangmiao14/p/6201900.html 优 ...

- 深入学习HBase架构原理

HBase定义 HBase 是一个高可靠.高性能.面向列.可伸缩的分布式存储系统,利用Hbase技术可在廉价PC Server上搭建 大规模结构化存储集群. HBase 是Google Bigtabl ...

- Spring集成MyBatis

本文原创,原文地址为http://www.cnblogs.com/fengzheng/p/5045105.html 如果觉得Hibernate不够灵活,可以尝试用Mybatis.相比于Hibernat ...

- 快速Android开发系列通信篇之EventBus

先吐槽一下博客园的MarkDown编辑器,推出的时候还很高兴博客园支持MarkDown了,试用了下发现支持不完善就没用了,这次这篇是在其他编辑器下写的,复制过来后发现..太烂了.怎么着作为一个技术博客 ...

- WebStorm 常用功能的使用技巧分享

WebStorm 是 JetBrain 公司开发的一款 JavaScript IDE,使用非常方便,可以使编写代码过程更加流畅. 本文在这里分享一些常用功能的使用技巧,希望能帮助大家更好的使用这款强大 ...