爬虫之爬取斗鱼官网LOL部分主播的状态

一个爬虫小程序 爬取主播的排名及观看人数

import re

import requests

import request

class Spider():

url = 'https://www.douyu.com/g_lol'

root_pattern = '<p>([\s\S]*?)</p>'

name_pattern = '<span class="dy-name ellipsis fl">([\s\S]*?)</span>'

number_pattern = '<span class="dy-num fr" >([\s\S]*?)</span>' def __fetch_content(self):

r = requests.get(Spider.url)

htmls = r.text

return htmls def __analysis(self, htmls):

root_htmls = re.findall(Spider.root_pattern, htmls)

anchors = []

for html in root_htmls:

name = re.findall(Spider.name_pattern, html)

number = re.findall(Spider.number_pattern, html)

anchor = {'name': name, 'number': number}

anchors.append(anchor)

return anchors def __refine(self, anchors):

l = lambda anchor: {

'name': anchor['name'][0],

'number': anchor['number'][0]

}

return map(l, anchors) def __sort(self, anchors):

anchors = sorted(anchors, key=self.__sort_seed, reverse=True)

return anchors def __sort_seed(self, anchor):

r = re.findall('\d*', anchor['number'])

number = float(r[0])

if '万' in anchor['number']:

number *= 10000

return number def __show(self, anchors):

for rank in range(0, len(anchors)):

print(

'人数排名' + str(rank + 1)

+ ' : ' + anchors[rank]['name']

+ '~~~~~~' + anchors[rank]['number']

) def go(self):

htmls = self.__fetch_content()

anchors = self.__analysis(htmls)

anchors = list(self.__refine(anchors))

anchors = self.__sort(anchors)

self.__show(anchors) spider = Spider()

spider.go()

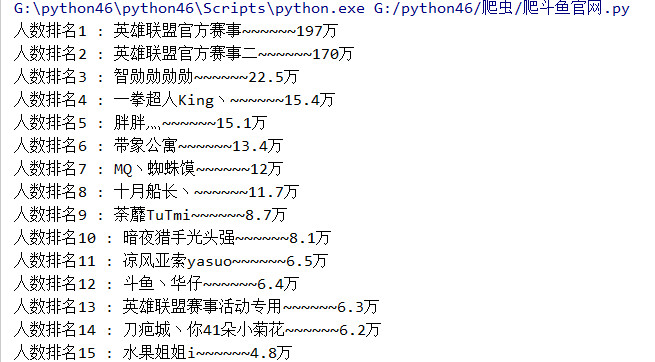

运行结果:

喜欢的朋友们可以去看主播的排名啦

爬虫之爬取斗鱼官网LOL部分主播的状态的更多相关文章

- 初识python 之 爬虫:爬取中国天气网数据

用到模块: 获取网页并解析:import requests,html5lib from bs4 import BeautifulSoup 使用pyecharts的Bar可视化工具"绘制图表& ...

- 爬虫实例——爬取煎蛋网OOXX频道(反反爬虫——伪装成浏览器)

煎蛋网在反爬虫方面做了不少工作,无法通过正常的方式爬取,比如用下面这段代码爬取无法得到我们想要的源代码. import requests url = 'http://jandan.net/ooxx' ...

- python爬虫:爬取易迅网价格信息,并写入Mysql数据库

本程序涉及以下方面知识: 1.python链接mysql数据库:http://www.cnblogs.com/miranda-tang/p/5523431.html 2.爬取中文网站以及各种乱码处 ...

- 用python爬虫简单爬取 笔趣网:类“起点网”的小说

首先:文章用到的解析库介绍 BeautifulSoup: Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能. 它是一个工具箱,通过解析文档为用户提供 ...

- scrapy实验1 爬取中国人寿官网新闻,保存为xml

一.scrapy 实验 爬中国人寿新闻,保存为xml 如需转发,请注明出处:小婷儿的python https://www.cnblogs.com/xxtalhr/p/10517297.html 链 ...

- 实战爬取Plati官网游戏实时最低价格-Python

需要修改url中的id_r="这个",这个id需要从Battlefield V (plati.ru)中获取,其实也是这个链接中的#s24235. 配合了e-mail推送,其实这个e ...

- python爬取虎牙直播颜值区美女主播照片

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理. PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取 python免费学习资 ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- 网络爬虫之定向爬虫:爬取当当网2015年图书销售排行榜信息(Crawler)

做了个爬虫,爬取当当网--2015年图书销售排行榜 TOP500 爬取的基本思想是:通过浏览网页,列出你所想要获取的信息,然后通过浏览网页的源码和检查(这里用的是chrome)来获相关信息的节点,最后 ...

随机推荐

- 修改mysql编码方式

第一种: 通过mysql命令行修改: 1)首先查看数据库字符编码,命令为: show variables like’collation_%’; show variables like’char ...

- 【SQL Server 2012】按倒序存储“分组统计”结果的临时表到新建表

程序预先说明: 本文访问的数据库是基于存有RDF三元组的开源数据库Localyago修改的库,其中只有一个表,表中有五个属性:主语subject.谓语predict.宾语object.主语的编号sub ...

- Django问卷调查项目思路流程

Django问卷调查项目思路流程: 1 后端思路 : 需求分析 ---- 找出各实体对应关系 ---- 设计model架构 ---- 统一资源封装 --- 提供资源API入口 ---- 设计项目实体功 ...

- Browser进程和浏览器内核(Renderer进程)的通信过程

看到这里,首先,应该对浏览器内的进程和线程都有一定理解了,那么接下来,再谈谈浏览器的Browser进程(控制进程)是如何和内核通信的, 这点也理解后,就可以将这部分的知识串联起来,从头到尾有一个完整的 ...

- oracle备份恢复

1.oracle文件备份恢复 /etc/oraInst.loc /etc/oratab /home/oracle 家目录 /oracle 安装目录 /usr/local/bin/dbhome /usr ...

- May 15th 2017 Week 20th Monday

Life is a flower of which love is the honey. 人生是花朵,爱情是花蜜. Not every life can be a flower, not every ...

- Win10提示“您未连接到nvidia gpu的显示器”的解决方法

显卡有Nvidia 和 ATI两个芯片,我们经常称他们为N卡和A卡,N卡更加注重于性能,而A卡则为颜色艳丽,画面更好.不过,最近一些windows10系统用户在使用N卡过程中,遇到了提示“您当前未使用 ...

- 使用shell调用python中的函数

最近遇到一个需求,需要通过shell调用python中的一个函数,发现其实也挺简单的: python脚本如下: test.py: import ConfigParser config = Config ...

- python:进程操作

一.多进程应用 import socket from multiprocessing import Process def talk(conn): conn.send(b'connected') re ...

- Windows 备用数据流(ADS)的妙用___转载

NTFS交换数据流(Alternate Data Streams,简称ADS)是NTFS磁盘格式的一个特性,在NTFS文件系统下,每个文件都可以存在多个数据流.通俗的理解,就是其它文件可以“寄宿”在某 ...