爬虫抓取页面数据原理(php爬虫框架有很多 )

爬虫抓取页面数据原理(php爬虫框架有很多 )

一、总结

1、php爬虫框架有很多,包括很多傻瓜式的软件

2、照以前写过java爬虫的例子来看,真的非常简单,就是一个获取网页数据的类或者方法(这里的话$handle = fopen($url, "r");),然后就可以获取网页上的html源代码,然后取啥数据就用正则表达式来取好了$content = stream_get_contents($handle, -1);

二、爬虫抓取页面数据原理

a、网页的页面源码我们可以轻松获得

b、比如cnsd博客,文章的正文内容全部放在<article></article>当中,所以非常好获取,此时我们获取的是html的页面,不同网站标签不同,具体看情况就好

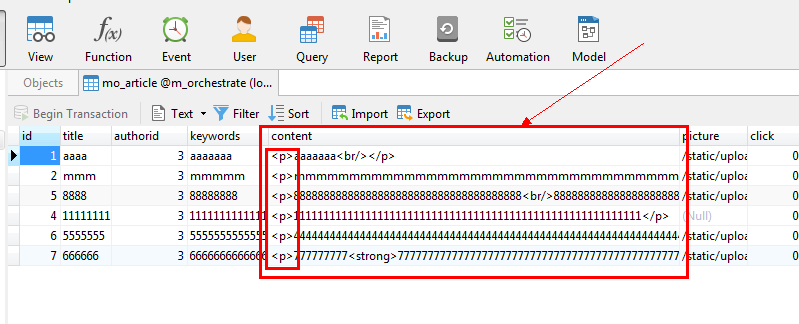

c、html的数据自带格式,所以直接放到数据库即可,因为数据库里面存的也就是html数据,要显示的话直接把这部分数据放到页面上面来即可

三、PHP爬虫最全总结1

爬虫是我一直以来跃跃欲试的技术,现在的爬虫框架很多,比较流行的是基于python,nodejs,java,C#,PHP的的框架,其中又以基于python的爬虫流行最为广泛,还有的已经是一套傻瓜式的软件操作,如八爪鱼,火车头等软件。

今天我们首先尝试的是使用PHP实现一个爬虫程序,首先在不使用爬虫框架的基础上实践也是为了理解爬虫的原理,然后再利用PHP的lib,框架和扩展进行实践。

所有代码挂在我的github上。

1.PHP简单的爬虫–原型

爬虫的原理:

- 给定原始的url;

- 分析链接,根据设置的正则表达式获取链接中的内容;

- 有的会更新原始的url再进行分析链接,获取特定内容,周而复始。

- 将获取的内容保存在数据库中(mysql)或者本地文件中

下面是网上一个例子,我们列下来然后分析

从main函数开始

<?php

/**

* 爬虫程序 -- 原型

*

* 从给定的url获取html内容

*

* @param string $url

* @return string

*/

function _getUrlContent($url) {

$handle = fopen($url, "r");

if ($handle) {

$content = stream_get_contents($handle, -1);

//读取资源流到一个字符串,第二个参数需要读取的最大的字节数。默认是-1(读取全部的缓冲数据)

// $content = file_get_contents($url, 1024 * 1024);

return $content;

} else {

return false;

}

}

/**

* 从html内容中筛选链接

*

* @param string $web_content

* @return array

*/

function _filterUrl($web_content) {

$reg_tag_a = '/<[a|A].*?href=[\'\"]{0,1}([^>\'\"\ ]*).*?>/';

$result = preg_match_all($reg_tag_a, $web_content, $match_result);

if ($result) {

return $match_result[1];

}

}

/**

* 修正相对路径

*

* @param string $base_url

* @param array $url_list

* @return array

*/

function _reviseUrl($base_url, $url_list) {

$url_info = parse_url($base_url);//解析url

$base_url = $url_info["scheme"] . '://';

if ($url_info["user"] && $url_info["pass"]) {

$base_url .= $url_info["user"] . ":" . $url_info["pass"] . "@";

}

$base_url .= $url_info["host"];

if ($url_info["port"]) {

$base_url .= ":" . $url_info["port"];

}

$base_url .= $url_info["path"];

print_r($base_url);

if (is_array($url_list)) {

foreach ($url_list as $url_item) {

if (preg_match('/^http/', $url_item)) {

// 已经是完整的url

$result[] = $url_item;

} else {

// 不完整的url

$real_url = $base_url . '/' . $url_item;

$result[] = $real_url;

}

}

return $result;

} else {

return;

}

}

/**

* 爬虫

*

* @param string $url

* @return array

*/

function crawler($url) {

$content = _getUrlContent($url);

if ($content) {

$url_list = _reviseUrl($url, _filterUrl($content));

if ($url_list) {

return $url_list;

} else {

return ;

}

} else {

return ;

}

}

/**

* 测试用主程序

*/

function main() {

$file_path = "url-01.txt";

$current_url = "http://www.baidu.com/"; //初始url

if(file_exists($file_path)){

unlink($file_path);

}

$fp_puts = fopen($file_path, "ab"); //记录url列表

$fp_gets = fopen($file_path, "r"); //保存url列表

do {

$result_url_arr = crawler($current_url);

if ($result_url_arr) {

foreach ($result_url_arr as $url) {

fputs($fp_puts, $url . "\r\n");

}

}

} while ($current_url = fgets($fp_gets, 1024)); //不断获得url

}

main();

?>2.使用crul lib

Curl是比较成熟的一个lib,异常处理、http header、POST之类都做得很好,重要的是PHP下操作MySQL进行入库操作比较省心。关于curl的说明具体可以查看PHP官方文档说明http://php.net/manual/zh/book.curl.php

不过在多线程Curl(Curl_multi)方面比较麻烦。

开启crul

针对winow系统:

- php.in中修改(注释;去掉即可)

extension=php_curl.dll

- php文件夹下的libeay32.dll, ssleay32.dll, libssh2.dll 还有 php/ext下的php_curl4个文件移入windows/system32

使用crul爬虫的步骤:

- 使用cURL函数的基本思想是先使用curl_init()初始化一个cURL会话;

- 接着你可以通过curl_setopt()设置你需要的全部选项;

- 然后使用curl_exec()来执行会话;

- 当执行完会话后使用curl_close()关闭会话。

例子

<?php

$ch = curl_init("http://www.example.com/");

$fp = fopen("example_homepage.txt", "w");

curl_setopt($ch, CURLOPT_FILE, $fp);

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_exec($ch);

curl_close($ch);

fclose($fp);

?>一个完整点的例子:

<?php

/**

* 将demo1-01换成curl爬虫

* 爬虫程序 -- 原型

* 从给定的url获取html内容

* @param string $url

* @return string

*/

function _getUrlContent($url) {

$ch=curl_init(); //初始化一个cURL会话

/*curl_setopt 设置一个cURL传输选项*/

//设置需要获取的 URL 地址

curl_setopt($ch,CURLOPT_URL,$url);

//TRUE 将curl_exec()获取的信息以字符串返回,而不是直接输出

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

//启用时会将头文件的信息作为数据流输出

curl_setopt($ch,CURLOPT_HEADER,1);

// 设置浏览器的特定header

curl_setopt($ch, CURLOPT_HTTPHEADER, array(

"Host: www.baidu.com",

"Connection: keep-alive",

"Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8",

"Upgrade-Insecure-Requests: 1",

"DNT:1",

"Accept-Language: zh-CN,zh;q=0.8,en-GB;q=0.6,en;q=0.4,en-US;q=0.2",

/*'Cookie:_za=4540d427-eee1-435a-a533-66ecd8676d7d; */

));

$result=curl_exec($ch);//执行一个cURL会话

$code=curl_getinfo($ch,CURLINFO_HTTP_CODE);// 最后一个收到的HTTP代码

if($code!='404' && $result){

return $result;

}

curl_close($ch);//关闭cURL

}

/**

* 从html内容中筛选链接

* @param string $web_content

* @return array

*/

function _filterUrl($web_content) {

$reg_tag_a = '/<[a|A].*?href=[\'\"]{0,1}([^>\'\"\ ]*).*?>/';

$result = preg_match_all($reg_tag_a, $web_content, $match_result);

if ($result) {

return $match_result[1];

}

}

/**

* 修正相对路径

* @param string $base_url

* @param array $url_list

* @return array

*/

function _reviseUrl($base_url, $url_list) {

$url_info = parse_url($base_url);//解析url

$base_url = $url_info["scheme"] . '://';

if ($url_info["user"] && $url_info["pass"]) {

$base_url .= $url_info["user"] . ":" . $url_info["pass"] . "@";

}

$base_url .= $url_info["host"];

if ($url_info["port"]) {

$base_url .= ":" . $url_info["port"];

}

$base_url .= $url_info["path"];

print_r($base_url);

if (is_array($url_list)) {

foreach ($url_list as $url_item) {

if (preg_match('/^http/', $url_item)) {

// 已经是完整的url

$result[] = $url_item;

} else {

// 不完整的url

$real_url = $base_url . '/' . $url_item;

$result[] = $real_url;

}

}

return $result;

} else {

return;

}

}

/**

* 爬虫

* @param string $url

* @return array

*/

function crawler($url) {

$content = _getUrlContent($url);

if ($content) {

$url_list = _reviseUrl($url, _filterUrl($content));

if ($url_list) {

return $url_list;

} else {

return ;

}

} else {

return ;

}

}

/**

* 测试用主程序

*/

function main() {

$file_path = "./url-03.txt";

if(file_exists($file_path)){

unlink($file_path);

}

$current_url = "http://www.baidu.com"; //初始url

//记录url列表 ab- 追加打开一个二进制文件,并在文件末尾写数据

$fp_puts = fopen($file_path, "ab");

//保存url列表 r-只读方式打开,将文件指针指向文件头

$fp_gets = fopen($file_path, "r");

do {

$result_url_arr = crawler($current_url);

echo "<p>$current_url</p>";

if ($result_url_arr) {

foreach ($result_url_arr as $url) {

fputs($fp_puts, $url . "\r\n");

}

}

} while ($current_url = fgets($fp_gets, 1024)); //不断获得url

}

main();

?>要对https支持,需要在_getUrlContent函数中加入下面的设置:

curl_setopt($ch, CURLOPT_HTTPAUTH, CURLAUTH_BASIC ) ;

curl_setopt($ch, CURLOPT_USERPWD, "username:password");

curl_setopt($ch, CURLOPT_SSLVERSION,3);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, FALSE);

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, 2);结果疑惑:

我们通过1和2部分得到的结果差异很大,第1部分能得到四千多条url数据,而第2部分却一直是45条数据。

还有我们获得url数据可能会有重复的,这部分处理在我的github上,对应demo2-01.php,或者demo2-02.php

3.file_get_contents/stream_get_contents与curl对比

3.1 file_get_contents/stream_get_contents对比

- stream_get_contents — 读取资源流到一个字符串

与 [file_get_contents()]一样,但是 stream_get_contents() 是对一个已经打开的资源流进行操作,并将其内容写入一个字符串返回

$handle = fopen($url, "r");

$content = stream_get_contents($handle, -1);//读取资源流到一个字符串,第二个参数需要读取的最大的字节数。默认是-1(读取全部的缓冲数据)- file_get_contents — 将整个文件读入一个字符串

$content = file_get_contents($url, 1024 * 1024);【注】 如果要打开有特殊字符的 URL (比如说有空格),就需要使用进行 URL 编码。

3.2 file_get_contents/stream_get_contents与curl对比

php中file_get_contents与curl性能比较分析一文中有详细的对比分析,主要的对比现在列下来:

- fopen /file_get_contents 每次请求都会重新做DNS查询,并不对 DNS信息进行缓存。但是CURL会自动对DNS信息进行缓存。对同一域名下的网页或者图片的请求只需要一次DNS查询。这大大减少了DNS查询的次数。所以CURL的性能比fopen /file_get_contents 好很多。

fopen /file_get_contents 在请求HTTP时,使用的是http_fopen_wrapper,不会keeplive。而curl却可以。这样在多次请求多个链接时,curl效率会好一些。

fopen / file_get_contents 函数会受到php.ini文件中allow_url_open选项配置的影响。如果该配置关闭了,则该函数也就失效了。而curl不受该配置的影响。

curl 可以模拟多种请求,例如:POST数据,表单提交等,用户可以按照自己的需求来定制请求。而fopen / file_get_contents只能使用get方式获取数据。

4.使用框架

使用框架这一块打算以后单独研究,并拿出来单写一篇博客

所有代码挂在我的github上。

参考阅读:

- 我用爬虫一天时间“偷了”知乎一百万用户,只为证明PHP是世界上最好的语言

- 知乎 – PHP, Python, Node.js 哪个比较适合写爬虫?

- 最近关于对网络爬虫技术总结

- PHP实现简单爬虫 (http://www.oschina.net/code/snippet_258733_12343)]

- 一个PHP实现的轻量级简单爬虫

- php中file_get_contents与curl性能比较分析

- PHP curl之爬虫初步

- 开源中国-PHP爬虫框架列表

- 网页抓取:PHP实现网页爬虫方式小结,抓取爬虫

- PHP爬虫框架–PHPCrawl

- php安装pcntl扩展实现多进程

爬虫抓取页面数据原理(php爬虫框架有很多 )的更多相关文章

- 怎么用Python写爬虫抓取网页数据

机器学习首先面临的一个问题就是准备数据,数据的来源大概有这么几种:公司积累数据,购买,交换,政府机构及企业公开的数据,通过爬虫从网上抓取.本篇介绍怎么写一个爬虫从网上抓取公开的数据. 很多语言都可以写 ...

- js 抓取页面数据

数据抓取 主要思路和原理 在根节点document中监听所有需要抓取的事件 在元素事件传递中,捕获阶段获取事件信息,进行埋点 通过getBoundingClientRect() 方法可获取元素的大小和 ...

- 利用python抓取页面数据

1.首先是安装python(注意python3.X和python2.X是不兼容的,我们最好用python3.X) 安装方法:安装python 2.安装成功后,再进行我们需要的插件安装.(这里我们需要用 ...

- 仿教程 小爬虫抓取imooc数据

慕课网的nodejs教程:http://www.imooc.com/learn/348 这人讲的很赞,特别是在事件驱动这点上,耳目一新. 视频略老,所以demo有些过时了,摸索着写了一个自己的小程序. ...

- java Jsoup 抓取页面数据

List<ImageBean> imgList = new ArrayList<ImageBean>(); ImageBean image = null; String ima ...

- iOS—网络实用技术OC篇&网络爬虫-使用java语言抓取网络数据

网络爬虫-使用java语言抓取网络数据 前提:熟悉java语法(能看懂就行) 准备阶段:从网页中获取html代码 实战阶段:将对应的html代码使用java语言解析出来,最后保存到plist文件 上一 ...

- Node.js爬虫抓取数据 -- HTML 实体编码处理办法

cheerio DOM化并解析的时候 1.假如使用了 .text()方法,则一般不会有html实体编码的问题出现 2.如果使用了 .html()方法,则很多情况下(多数是非英文的时候)都会出现,这时, ...

- iOS开发——网络实用技术OC篇&网络爬虫-使用java语言抓取网络数据

网络爬虫-使用java语言抓取网络数据 前提:熟悉java语法(能看懂就行) 准备阶段:从网页中获取html代码 实战阶段:将对应的html代码使用java语言解析出来,最后保存到plist文件 上一 ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

随机推荐

- Onsctl 配置ONS服务(10G)

Onsctl Onsctl这个命令是用来管理ONS(Oracle Notification Service)是OracleClustser实现FAN Event Push模型的基础. 在RAC环境下. ...

- 【Java编码准则】の #01限制内存中敏感数据的生命周期

当竞争对手的应用程序与我们的应用程序执行在同一个系统上时,我们的应用程序在内存中的敏感数据是非常easy被竞争对手获取的.假设我们的应用程序符合以下几种情况之中的一个,那么竞争对手能够获取到我们应用的 ...

- ZOJ Problem Set - 3819Average Score

ZOJ Problem Set - 3819Average Score 题目链接 题目大意:给你两个班的的学生的分数(A,B班).A班有一个学生的分数没有给出. 如今要求你给出这个学生分数的上下限.使 ...

- 自定义控件学习——仿qq侧滑栏

效果 主要步骤: 1. 在xml布局里摆放内容. include 2. 在自定义ViewGroup里, 进行measure测量, layout布局 3. 响应用户的触摸事件 4. i ...

- 11.使用 package.json

转自:http://www.runoob.com/nodejs/nodejs-express-framework.html package.json 位于模块的目录下,用于定义包的属性.接下来让我们来 ...

- django 简单会议室预约(3)

URL配置: 今天配置一下URL,打开urls.py配置如下: from django.conf.urls import patterns, include, url from djapp impor ...

- RFID的工作流程

工作流程 1.阅读器通过发射天线发送一定频率的射频信号, 2.当射频卡进入发射天线工作区域时产生感应电流,射频卡获得能量被激活: 3.射频卡将自身编码等信息通过卡内置发送天线发送出去 4.系统接收天线 ...

- 杭电1102 Constructing Roads

Constructing Roads Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Other ...

- 前端切图|点击按钮div变色

<!DOCTYPE html> <html> <head> <title>点击按钮div变色.html</title> <meta c ...

- iOS开发RunLoop学习:一:RunLoop简单介绍

一:RunLoop的简单介绍 #import "ViewController.h" @interface ViewController () @end @implementatio ...