hadoop-2.6.0源码编译

运行hadoop环境时,常常会出现这种提示

WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

意思是无法加载本地native库。

这里就需要我们自己本地进行编译hadoop源码,用生成的文件来替换原有的native库。

下面就是我整理的hadoop编译流程

首先介绍一下我的环境

centos6.5

jdk-7u79-linux-x64.tar.gz

apache-maven-3.3.9-bin.tar.gz

protobuf-2.5.0.tar.gz

hadoop-2.6.0-cdh5.12.0-src.tar.gz

接下来就进行步骤介绍

第一步,安装jdk

解压

tar -zxvf jdk-7u79-linux-x64.tar.gz

环境变量

vi /etc/profile

#JAVA_HOME

export JAVA_HOME=/home/hadoop/jdk1..0_79

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar

测试是否安装成功

source /etc/profile

java -version

第二步,安装maven

>>提君博客原创 http://www.cnblogs.com/tijun/ <<

解压

tar -zxvf apache-maven-3.3.9-bin.tar.gz

更改名称

mv apache-maven-3.3. maven339

环境变量

vi /etc/profile

#MAVEN_HOME

export MAVEN_HOME=/home/hadoop/maven339

export PATH=$MAVEN_HOME/bin:$PATH

测试是否安装成功

source /etc/profile

mvn -version

第三步,根据多次踩坑,准备编译时需要的安装

yum install gcc

yum intall gcc-c++

yum install make

或者是直接运行

yum install g++ autoconf automake libtool cmake zlib1g-dev pkg-config libssl-dev

第四步安装protoc

解压编译,逐步执行

tar -zxvf protobuf-2.5..tar.gz

cd protobuf-2.5.

./configure --prefix=/home/hadoop/protobuf250

make

make install

环境变量

vi /etc/profile

#PROTOC_HOME

export PROTOC_HOME=/home/hadoop/protobuf250

export PATH=$PROTOC_HOME/bin:$PATH

测试

source /etc/profile

protoc --version

第四步,编译hadoop

tar -zxvf hadoop-2.6.-cdh5.12.0-src.tar.gz

mv hadoop-2.6.-cdh5.12.0 hadoop260-src

cd hadoop-2.6.-src

mvn clean package -Dmaven.javadoc.skip=true -Pdist,native -DskipTests -Dtar

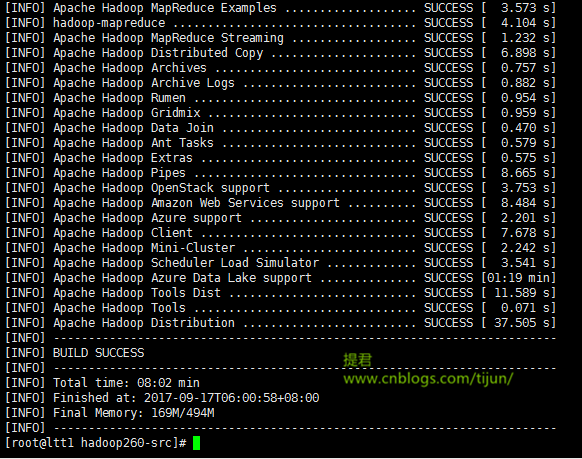

经过一段时间的等待,出现 build success ,说明编译成功。

>>提君博客原创 http://www.cnblogs.com/tijun/ <<

编译源码生成的部分都在hadoop260-src/hadoop-dist/target/目录下

将编译后的native文件夹下的东西替换到原来的native目录

cp -r hadoop260-src/hadoop-dist/target/hadoop-2.6.-cdh5.12.0/lib/native/ /home/hadoop/hadoop260/lib/

同样,其他机器的文件同样替换

scp -r hadoop260-src/hadoop-dist/target/hadoop-2.6.-cdh5.12.0/lib/native/ hadoop@ltt2.bg.cn:/home/hadoop/hadoop260/lib/

..

..

..

注意:不同的linux环境,编译过程中会有不同,有可能会出一些编译过程的错误,我将再接下来的一篇文章中整理出来,供大家参考。

>>提君博客原创 http://www.cnblogs.com/tijun/ <<

hadoop-2.6.0源码编译的更多相关文章

- hadoop-1.2.0源码编译

以下为在CentOS-6.4下hadoop-1.2.0源码编译步骤. 1. 安装并且配置ant 下载ant,将ant目录下的bin文件夹加入到PATH变量中. 2. 安装git,安装autoconf, ...

- hadoop-2.6.0源码编译问题汇总

在上一篇文章中,介绍了hadoop-2.6.0源码编译的一般流程,因个人计算机环境的不同, 编译过程中难免会出现一些错误,下面是我编译过程中遇到的错误. 列举出来并附上我解决此错误的方法,希望对大家有 ...

- Spark1.0.0 源码编译和部署包生成

问题导读:1.如何对Spark1.0.0源码编译?2.如何生成Spark1.0的部署包?3.如何获取包资源? Spark1.0.0的源码编译和部署包生成,其本质只有两种:Maven和SBT,只不过针对 ...

- ambari 2.5.0源码编译安装

参考:https://www.ibm.com/developerworks/cn/opensource/os-cn-bigdata-ambari/index.html Ambari 是什么 Ambar ...

- 使用Maven将Hadoop2.2.0源码编译成Eclipse项目

编译环境: OS:RHEL 6.3 x64 Maven:3.2.1 Eclipse:Juno SR2 Linux x64 libprotoc:2.5.0 JDK:1.7.0_51 x64 步骤: 1. ...

- hadoop-2.0.0-mr1-cdh4.2.0源码编译总结

准备编译hadoop-2.0.0-mr1-cdh4.2.0的同学们要谨慎了.首先看一下这篇文章: Hadoop作业提交多种方案 http://www.blogjava.net/dragonHadoop ...

- 基于cdh5.10.x hadoop版本的apache源码编译安装spark

参考文档:http://spark.apache.org/docs/1.6.0/building-spark.html spark安装需要选择源码编译方式进行安装部署,cdh5.10.0提供默认的二进 ...

- Spark2.0.0源码编译

Hive默认使用MapReduce作为执行引擎,即Hive on mr,Hive还可以使用Tez和Spark作为其执行引擎,分别为Hive on Tez和Hive on Spark.由于MapRedu ...

- Ubantu16.04进行Android 8.0源码编译

参考这篇博客 经过测试,8.0源码下载及编译之后,占用100多G的硬盘空间,尽量给ubantu系统多留一些硬盘空间,如果后续需要在编译好的源码上进行开发,需要预留更多的控件,为了防止后续出现文件权限问 ...

- jmeter4.0 源码编译 二次开发

准备: 1.jmeter4.0源码 - apache-jmeter-4.0_src.zip 2.IDE Eclipse - Oxygen.3 Release (4.7.3) 3.JDK - 1.8.0 ...

随机推荐

- Jsp敏感词过滤

Jsp敏感词过滤 大部分论坛.网站等,为了方便管理,都进行了关于敏感词的设定. 在多数网站,敏感词一般是指带有敏感政治倾向(或反执政党倾向).暴力倾向.不健康色彩的词或不文明语,也有一些网站根据自身实 ...

- 升级Cocoapods引起的Mantle库找不到的问题及解决方法

年前升级了Cocoapods库,从0.39升级到了1.2.0-beta版,然后用模拟器和真机测试都是没有问题的,均可以成功编译.今天测试人员要测试包,准备archive打包时,却提示:ld: libr ...

- javascript 实现字符串反转的两种方法

第一种方法:利用数组方法 //先split将字串变成单字数组,然后reverse()反转,然后将数组拼接回字串 var str = "abcdef"; str.split(&quo ...

- jQuery选择器使用习惯

http://www.cnblogs.com/fredlau/archive/2009/03/19/1416327.html

- Redis集群之优化系统参数

1.最大打开文件数量 (1)编辑资源限制文件,针对redis用户做资源访问控制,在文件尾加入最后两行, sudo vim /etc/security/limits.conf (2) sudo vim ...

- linux允许root远程登录

在根目录下自己建了一个目录 /software 通过ssh传输文件时遇到问题, 虽然ssh中su 切换用户到root ,但不能传输文件,所以要允许root登录才行 修改ssh配置文件 修改完重启 ss ...

- 删除QQ登录界面的QQ账号信息

删除QQ登录界面的QQ账号信息 .. ------------------- ------------------------ -------------------

- Win10个性化设置

Win10个性化设置.. ---------------------- Capture001-我的桌面 ---------------------- Win10设置任务栏的颜色 ----------- ...

- 每次启动懂maven项目都必须关闭javaw.exe进程

最近几天一致在搞配置问题,今天总于解决了.下面说问题: 我发现我每次配置完maven build的goals运行,总是会出现TOMCAT绑定接口问题,我做的方法就是不断地关掉JAVAw.exe进程.但 ...

- MySQL(五)DDL(数据定义语言)

SHOW CREATE TABLE 表名\G前言 前面在数据库的讲解中,其实很多东西都非常的细节,在以前的学习过程中我都是没有注意到的.可能在以后的工作中会碰到所以都是做了记录的. 接下来,我将分享的 ...