强化学习中atari游戏环境下帧的预处理操作

在网上找到一个Rainbow算法的代码(https://gitee.com/devilmaycry812839668/Rainbow),在里面找到了atari游戏环境下帧的预处理操作。

具体代码地址:

https://gitee.com/devilmaycry812839668/Rainbow/blob/master/env.py

# -*- coding: utf-8 -*-

from collections import deque

import random

import atari_py

import cv2

import torch class Env():

def __init__(self, args):

self.device = args.device

self.ale = atari_py.ALEInterface()

self.ale.setInt('random_seed', args.seed)

self.ale.setInt('max_num_frames_per_episode', args.max_episode_length)

self.ale.setFloat('repeat_action_probability', 0) # Disable sticky actions

self.ale.setInt('frame_skip', 0)

self.ale.setBool('color_averaging', False)

self.ale.loadROM(atari_py.get_game_path(args.game)) # ROM loading must be done after setting options

actions = self.ale.getMinimalActionSet()

self.actions = dict([i, e] for i, e in zip(range(len(actions)), actions))

self.lives = 0 # Life counter (used in DeepMind training)

self.life_termination = False # Used to check if resetting only from loss of life

self.window = args.history_length # Number of frames to concatenate

self.state_buffer = deque([], maxlen=args.history_length)

self.training = True # Consistent with model training mode def _get_state(self):

state = cv2.resize(self.ale.getScreenGrayscale(), (84, 84), interpolation=cv2.INTER_LINEAR)

return torch.tensor(state, dtype=torch.float32, device=self.device).div_(255) def _reset_buffer(self):

for _ in range(self.window):

self.state_buffer.append(torch.zeros(84, 84, device=self.device)) def reset(self):

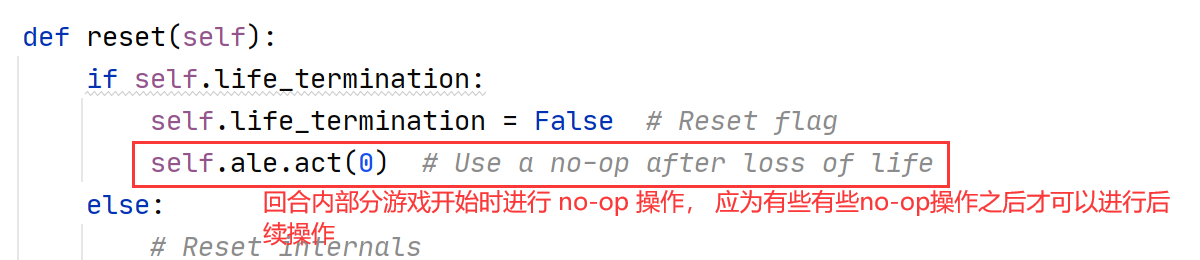

if self.life_termination:

self.life_termination = False # Reset flag

self.ale.act(0) # Use a no-op after loss of life

else:

# Reset internals

self._reset_buffer()

self.ale.reset_game()

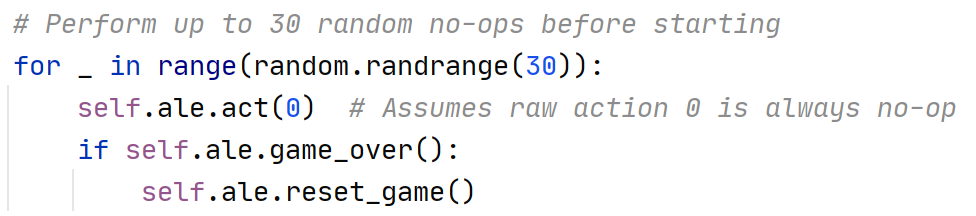

# Perform up to 30 random no-ops before starting

for _ in range(random.randrange(30)):

self.ale.act(0) # Assumes raw action 0 is always no-op

if self.ale.game_over():

self.ale.reset_game()

# Process and return "initial" state

observation = self._get_state()

self.state_buffer.append(observation)

self.lives = self.ale.lives()

return torch.stack(list(self.state_buffer), 0) def step(self, action):

# Repeat action 4 times, max pool over last 2 frames

frame_buffer = torch.zeros(2, 84, 84, device=self.device)

reward, done = 0, False

for t in range(4):

reward += self.ale.act(self.actions.get(action))

if t == 2:

frame_buffer[0] = self._get_state()

elif t == 3:

frame_buffer[1] = self._get_state()

done = self.ale.game_over()

if done:

break

observation = frame_buffer.max(0)[0]

self.state_buffer.append(observation)

# Detect loss of life as terminal in training mode

if self.training:

lives = self.ale.lives()

if lives < self.lives and lives > 0: # Lives > 0 for Q*bert

self.life_termination = not done # Only set flag when not truly done

done = True

self.lives = lives

# Return state, reward, done

return torch.stack(list(self.state_buffer), 0), reward, done # Uses loss of life as terminal signal

def train(self):

self.training = True # Uses standard terminal signal

def eval(self):

self.training = False def action_space(self):

return len(self.actions) def render(self):

cv2.imshow('screen', self.ale.getScreenRGB()[:, :, ::-1])

cv2.waitKey(1) def close(self):

cv2.destroyAllWindows()

该代码主要使用 atari_py 库实现游戏环境运行及图像的采集。

上面的代码为pytorch深度学习计算框架提供支持,同时可以经过适当的更改同样可以为TensorFlow等其他深度计算框架提供支持。

### 创建atari游戏环境的连接对象

### 为连接对象ale设置属性, 设置随机种子:random_seed ,每一个回合最多的帧个数(最多step数):max_num_frames_per_episode

### 执行动作传递给游戏环境时是否对上一个动作进行重复(迟滞动作):repeat_action_probability , frame_skip:是否跳帧(中间帧使用重复动作)

打印游戏路径:

atari_py.get_game_path(args.game)

为ale游戏连接对象加载游戏仿真环境的二进制文件:

获得ale的灰度值图像:

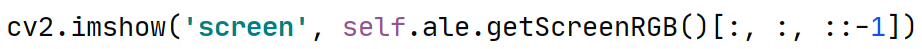

将ale的RGB图像更改为BGR图像以使cv2进行显示:

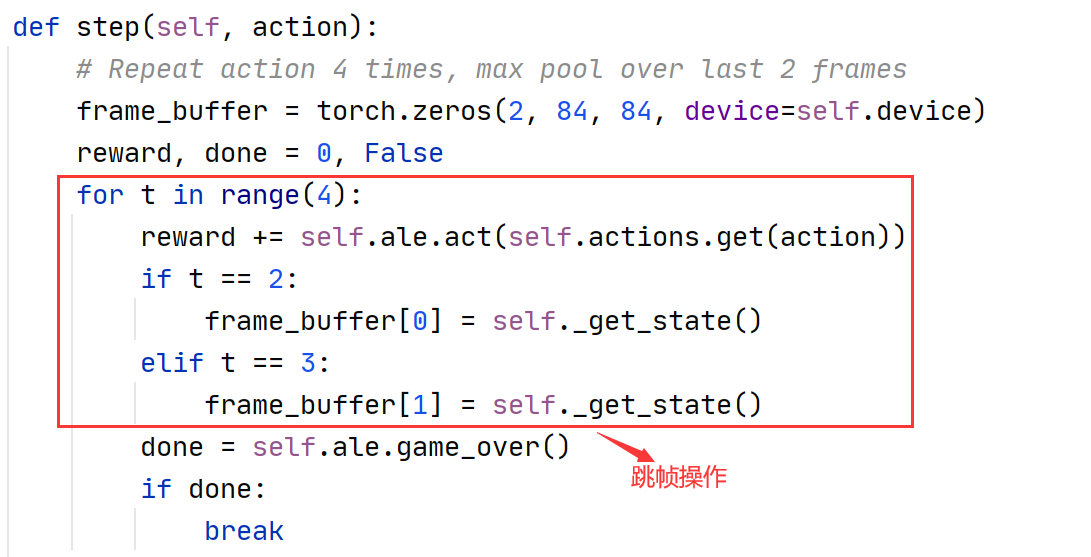

手动编写跳帧操作:

相邻两帧图像取最大值,避免图像闪烁问题:

对特殊游戏(一回合游戏有多条游戏生命数)设置 training 和 eval 两种模式, training模式下将每个生命数内的游戏帧提取为一个回合。

整体回合没有结束,但是部分回合结束(游戏生命数减少),使结束画面和开始画面连接:

游戏回合开始时进行一定步数的随机操作:

游戏回合内新生命数下游戏开始时进行随机操作,否则游戏游戏无法进行下一步操作:

扩展:

gym atari游戏的环境设置问题:Breakout-v0, Breakout-v4, BreakoutNoFrameskip-v4和BreakoutDeterministic-v4的区别

(https://www.cnblogs.com/devilmaycry812839668/p/14665402.html)

强化学习中atari游戏环境下帧的预处理操作的更多相关文章

- 强化学习实战 | 自定义Gym环境之井字棋

在文章 强化学习实战 | 自定义Gym环境 中 ,我们了解了一个简单的环境应该如何定义,并使用 print 简单地呈现了环境.在本文中,我们将学习自定义一个稍微复杂一点的环境--井字棋.回想一下井字棋 ...

- 强化学习实战 | 自定义Gym环境之扫雷

开始之前 先考虑几个问题: Q1:如何展开无雷区? Q2:如何计算格子的提示数? Q3:如何表示扫雷游戏的状态? A1:可以使用递归函数,或是堆栈. A2:一般的做法是,需要打开某格子时,再去统计周围 ...

- 强化学习中的无模型 基于值函数的 Q-Learning 和 Sarsa 学习

强化学习基础: 注: 在强化学习中 奖励函数和状态转移函数都是未知的,之所以有已知模型的强化学习解法是指使用采样估计的方式估计出奖励函数和状态转移函数,然后将强化学习问题转换为可以使用动态规划求解的 ...

- 深度强化学习中稀疏奖励问题Sparse Reward

Sparse Reward 推荐资料 <深度强化学习中稀疏奖励问题研究综述>1 李宏毅深度强化学习Sparse Reward4 强化学习算法在被引入深度神经网络后,对大量样本的需求更加 ...

- 强化学习中REIINFORCE算法和AC算法在算法理论和实际代码设计中的区别

背景就不介绍了,REINFORCE算法和AC算法是强化学习中基于策略这类的基础算法,这两个算法的算法描述(伪代码)参见Sutton的reinforcement introduction(2nd). A ...

- UNICODE环境下读写txt文件操作

内容转载自http://blog.sina.com.cn/s/blog_5d2bad130100t0x9.html UNICODE环境下读写txt文件操作 (2011-07-26 17:40:05) ...

- 强化学习中的经验回放(The Experience Replay in Reinforcement Learning)

一.Play it again: reactivation of waking experience and memory(Trends in Neurosciences 2010) SWR发放模式不 ...

- 强化学习实战 | 自定义Gym环境

新手的第一个强化学习示例一般都从Open Gym开始.在这些示例中,我们不断地向环境施加动作,并得到观测和奖励,这也是Gym Env的基本用法: state, reward, done, info = ...

- Go学习笔记(一):Ubuntu 环境下Go的安装

本文是根据<Go Web 编程>,逐步学习 Ubuntu 环境下go的安装的笔记. <Go Web 编程>的URL地址如下: https://github.com/astaxi ...

- 强化学习应用于游戏Tic-Tac-Toe

Tic-Tac-Toe游戏为3*3格子里轮流下棋,一方先有3子成直线的为赢家. 参考代码如下,我只删除了几个没用的地方: ####################################### ...

随机推荐

- vm ware 虚拟WIN XP 时卡

主机是I7 9700,SN750 NVME 1T SSD, 32G 内存,VM WARE 14,理论上虚拟WIN XP 不会卡,但实际情况就是很卡. 虚拟WIN7 ,WIN 10,UBUNTU LIN ...

- Vue学习:12.生命周期实例

两个小例子,巩固一下生命周期钩子函数. 实例1:初始化渲染 实现功能: 在 Vue 实例数据为空的情况下,用户在一进入页面就向服务器发送请求获取数据,并在数据返回后进行动态渲染. 思路: 创建一个 V ...

- Android开发基础——真机测试错误,ADB启动不了,程序安装不了,the connection to adb is down,INSTALL_CANCELED_BY_USER...

在Android开发中,无论是真机测试还是AVD测试,都会报出这些错误.在这里,我会详细说明一下怎么会出现这些错误的,然后要怎么样才能解决这些错误. 错误一: The connection to ad ...

- 使用 Promise.withResolvers() 来简化你将函数 Promise 化的实现~~

引言 在JavaScript编程中,Promise 是一种处理异步操作的常用机制.Promise 对象代表了一个尚未完成但预期将来会完成的操作的结果.在本文中,我们将探讨如何通过使用 ES2024 的 ...

- .Net Core5.0中Autofac依赖注入整合多层,项目中可直接用

一.配置Autofac替换内置DI 1.安装Nuget包:Autofac,Autofac.Extensions.DependencyInjection 2.Program.cs中CreateHostB ...

- 【译】向您介绍改版的 Visual Studio 资源管理器

随着最近 Visual Studio 的资源管理器的改进,开发人员将得到一种全新的享受!我们非常激动地宣布重新设计的 Visual Studio 资源管理器,相信我们,它将改变游戏规则. 在 Visu ...

- spark使用jdbc批次提交方式写入phoniex的工具类

一.需求:spark写入phoniex 二.实现方式 1.官网方式 dataFrame.write .format("org.apache.phoenix.spark") .mod ...

- 2024-06-26:用go语言,给定一个长度为n的数组nums和一个正整数k, 找到数组中所有相差绝对值恰好为k的子数组, 并返回这些子数组中元素之和的最大值。 如果找不到这样的子数组,返回0。 输

2024-06-26:用go语言,给定一个长度为n的数组nums和一个正整数k, 找到数组中所有相差绝对值恰好为k的子数组, 并返回这些子数组中元素之和的最大值. 如果找不到这样的子数组,返回0. 输 ...

- 数据结构—包(Bag)

数据结构中的包,其实是对现实中的包的一种抽象. 想像一下现实中的包,比如书包,它能做什么?有哪些功能?首先它用来装东西,里面的东西可以随便放,没有规律,没有顺序,当然,可以放多个相同的东西.其次,东西 ...

- 尝试官方的第一个SpringNative 0.11程序(WSL2)

Spring Native是Spring推出微服务体系Spring Cloud之后的又一大举动,从名字可以猜出,Spring Native是一门面向云原生的技术.如果你还对这个概念不太理解,可以多看一 ...