Hadoop(16)-MapReduce框架原理-自定义FileInputFormat

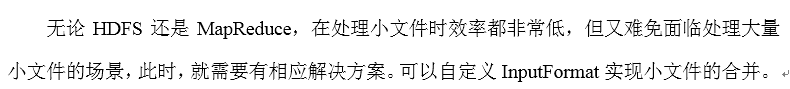

1. 需求

将多个小文件合并成一个SequenceFile文件(SequenceFile文件是Hadoop用来存储二进制形式的key-value对的文件格式),SequenceFile里面存储着多个文件,存储的形式为文件路径+名称为key,文件内容为value

三个小文件

one.txt

yongpeng weidong weinan

sanfeng luozong xiaoming

two.txt

shuaige changmo zhenqiang

dongli lingu xuanxuan

three.txt

longlong fanfan

mazong kailun yuhang yixin

longlong fanfan

mazong kailun yuhang yixin

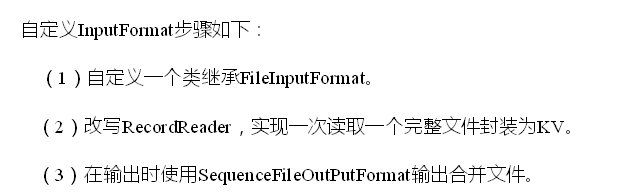

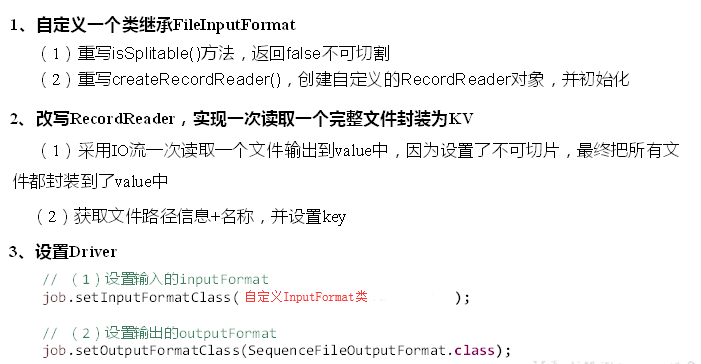

2. 需求分析

3.案例代码

1) 自定义RecordReader

package com.nty.inputformat; import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.InputSplit;

import org.apache.hadoop.mapreduce.RecordReader;

import org.apache.hadoop.mapreduce.TaskAttemptContext;

import org.apache.hadoop.mapreduce.lib.input.FileSplit; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomRecordReader extends RecordReader<Text, BytesWritable> { /**

* 由于采用了FileInputFormat的输入方式,所以输入源3个文件,会分成三个切片,所以一个RecordReader只处理一个文件,一次读完

*/ //标记文件是否被读过,true表示没被读过

private boolean flag = true; private Text key = new Text();

private BytesWritable value = new BytesWritable(); //输入流

FSDataInputStream fis; private FileSplit fs; /**

* 初始化方法,只调用一次

* @param split

* @param context

* @throws IOException

* @throws InterruptedException

*/

public void initialize(InputSplit split, TaskAttemptContext context) throws IOException, InterruptedException {

//FileSplit是InputSplit的子类

fs = (FileSplit) split; //获取文件路径

Path path = fs.getPath(); //获取文件系统

FileSystem fileSystem = FileSystem.get(context.getConfiguration());

//FileSystem fileSystem = path.getFileSystem(context.getConfiguration()); //开流

fis = fileSystem.open(path);

} /**

* 读取下一组KV

* @return 读到了返回true,反之返回false

* @throws IOException

* @throws InterruptedException

*/

public boolean nextKeyValue() throws IOException, InterruptedException {

if(flag){

//读取文件进入key和value

String path = fs.getPath().toString();

key.set(path); //文件是一次性读完,bytes的长度不能为普遍的1024,当然这么写会涉及到大文件的问题,不做讨论.

byte[] bytes = new byte[(int) fs.getLength()];

fis.read(bytes);

value.set(bytes,0,bytes.length); //重新标记

flag = false; return true;

}

return false;

} /**

* 获取当前读到的key

* @return

* @throws IOException

* @throws InterruptedException

*/

public Text getCurrentKey() throws IOException, InterruptedException {

return this.key;

} /**

* 获取当前读到的value

* @return

* @throws IOException

* @throws InterruptedException

*/

public BytesWritable getCurrentValue() throws IOException, InterruptedException {

return this.value;

} /**

* 获取当前读取的进度

* @return

* @throws IOException

* @throws InterruptedException

*/

public float getProgress() throws IOException, InterruptedException {

//文件一次读完,只有0和1的进度,根据flag来判断

return flag ? 0f : 1f;

} /**

* 关闭资源

* @throws IOException

*/

public void close() throws IOException {

IOUtils.closeStream(fis);

}

}

2) 自定义Inputformat

package com.nty.inputformat; import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.InputSplit;

import org.apache.hadoop.mapreduce.JobContext;

import org.apache.hadoop.mapreduce.RecordReader;

import org.apache.hadoop.mapreduce.TaskAttemptContext;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:09

*/

//需求中,key为文件路径+名称,所以key类型为Text,value为文件内容,用BytesWritable

public class CustomInputFormat extends FileInputFormat<Text, BytesWritable> { //最后输出的value为一个文件,所让文件不能被切分,返回false

@Override

protected boolean isSplitable(JobContext context, Path filename) {

return false;

} //返回自定义的 RecordReader

public RecordReader<Text, BytesWritable> createRecordReader(InputSplit split, TaskAttemptContext context) throws IOException, InterruptedException {

return new CustomRecordReader();

}

}

3) 编写Mapper类

package com.nty.inputformat; import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomMapper extends Mapper<Text, BytesWritable, Text, BytesWritable> {

@Override

protected void map(Text key, BytesWritable value, Context context) throws IOException, InterruptedException {

context.write(key,value);

}

}

4) 编写Reducer类

package com.nty.inputformat; import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomReducer extends Reducer<Text, BytesWritable, Text, BytesWritable> {

@Override

protected void reduce(Text key, Iterable<BytesWritable> values, Context context) throws IOException, InterruptedException {

for (BytesWritable value : values) {

context.write(key, value);

}

}

}

5) 编写Driver类

package com.nty.inputformat; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.BytesWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.mapreduce.lib.output.SequenceFileOutputFormat; /**

* author nty

* date time 2018-12-11 9:10

*/

public class CustomDriver { public static void main(String[] args) throws Exception{

//获取job

Configuration configuration = new Configuration();

Job job = Job.getInstance(configuration); //设置类

job.setJarByClass(CustomDriver.class);

//设置input和output

job.setInputFormatClass(CustomInputFormat.class);

job.setOutputFormatClass(SequenceFileOutputFormat.class); //设置Mapper和Reducer

job.setMapperClass(CustomMapper.class);

job.setReducerClass(CustomReducer.class); //设置Mapper和Reducer的输入输出

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(BytesWritable.class); job.setOutputKeyClass(Text.class);

job.setOutputValueClass(BytesWritable.class); //设置文件路径

FileInputFormat.setInputPaths(job, new Path("d:\\Hadoop_test"));

FileOutputFormat.setOutputPath(job, new Path("d:\\Hadoop_test_out"));

//提交

boolean b = job.waitForCompletion(true); System.exit(b ? 0 : 1); }

}

Hadoop(16)-MapReduce框架原理-自定义FileInputFormat的更多相关文章

- Hadoop(18)-MapReduce框架原理-WritableComparable排序和GroupingComparator分组

1.排序概述 2.排序分类 3.WritableComparable案例 这个文件,是大数据-Hadoop生态(12)-Hadoop序列化和源码追踪的输出文件,可以看到,文件根据key,也就是手机号进 ...

- Hadoop(12)-MapReduce框架原理-Hadoop序列化和源码追踪

1.什么是序列化 2.为什么要序列化 3.为什么不用Java的序列化 4.自定义bean对象实现序列化接口(Writable) 在企业开发中往往常用的基本序列化类型不能满足所有需求,比如在Hadoop ...

- Hadoop(20)-MapReduce框架原理-OutputFormat

1.outputFormat接口实现类 2.自定义outputFormat 步骤: 1). 定义一个类继承FileOutputFormat 2). 定义一个类继承RecordWrite,重写write ...

- Hadoop(15)-MapReduce框架原理-FileInputFormat的实现类

1. TextInputFormat 2.KeyValueTextInputFormat 3. NLineInputFormat

- Hadoop(17)-MapReduce框架原理-MapReduce流程,Shuffle机制,Partition分区

MapReduce工作流程 1.准备待处理文件 2.job提交前生成一个处理规划 3.将切片信息job.split,配置信息job.xml和我们自己写的jar包交给yarn 4.yarn根据切片规划计 ...

- Hadoop(13)-MapReduce框架原理--Job提交源码和切片源码解析

1.MapReduce的数据流 1) Input -> Mapper阶段 这一阶段的主要分工就是将文件切片和把文件转成K,V对 输入源是一个文件,经过InputFormat之后,到了Mapper ...

- Hadoop(19)-MapReduce框架原理-Combiner合并

1. Combiner概述 2. 自定义Combiner实现步骤 1). 定义一个Combiner继承Reducer,重写reduce方法 public class WordcountCombiner ...

- Hadoop(14)-MapReduce框架原理-切片机制

1.FileInputFormat切片机制 切片机制 比如一个文件夹下有5个小文件,切片时会切5个片,而不是一个片 案例分析 2.FileInputFormat切片大小的参数配置 源码中计算切片大小的 ...

- 【Hadoop】MapReduce自定义分区Partition输出各运营商的手机号码

MapReduce和自定义Partition MobileDriver主类 package Partition; import org.apache.hadoop.io.NullWritable; i ...

随机推荐

- 【Python】Java程序员学习Python(八)— 基本类型的基本运算

这一篇待写,毕竟基本运算都是通用的.

- git学习——简介、使用(一)

本文是作者参考其他教程学习git的记录,原文:http://www.liaoxuefeng.com/wiki/0013739516305929606dd18361248578c67b8067c8c01 ...

- Aheadof Time Compilation(AOT) vs (JIT)Just In Time compilation approach

像java这样的高级语言,往往先做好部分编译,在运行时,再使用JIT将前面编译的中间件输出编译为机器语言,放到机器上运行.这可能会影响到运行的性能. 再比如,像angular的web 应用,angul ...

- RHEL7系统管理之资源管理

1. CGroup(控制群组).slice(切片).scop.service 控制群组(control group)是linux kernel的一项功能, 该功能允许linux对RHEL7中syste ...

- Linux Transparent Huge Pages 对 Oracle 的影响

1 Transparent Huge Pages 说明 官网上有2篇文章对THP 做了说明: https://access.redhat.com/solutions/46111 https://acc ...

- 转: c#.net利用RNGCryptoServiceProvider产生任意范围强随机数的办法

//这样产生0 ~ 100的强随机数(含100) ; int rnd = int.MinValue; decimal _base = (decimal)long.MaxValue; ]; System ...

- 山寨"每日故宫"应用的图层遮罩效果

山寨"每日故宫"应用的图层遮罩效果 最终效果: 应用中的效果: 素材图片: 源码: // // ViewController.m // 每日故宫 // // Created by ...

- 为什么mysql要做主从复制?

为什么MySQL要做主从复制(读写分离)? 通俗来讲,如果对数据库的读和写都在同一个数据库服务器中操作,业务系统性能会降低. 为了提升业务系统性能,优化用户体验,可以通过做主从复制(读写分离)来减轻主 ...

- Spring 源码阅读之BeanFactory

1. BeanFactory 的结构体系如下: 2. XmlBeanFactory ,装载Spring配置信息 package org.springframework.beans.factory.xm ...

- singleton和prototype的区别

singleton作用域:当把一个Bean定义设置为singleton作用域是,Spring IoC容器中只会存在一个共享的Bean实例,并且所有对Bean的 请求,只要id与该Bean定义相匹配,则 ...