python爬虫之天气预报网站--查看最近(15天)的天气信息(正则表达式)

python爬虫之天气预报网站--查看最近(15天)的天气信息(正则表达式)

思路:

1.首先找到一个自己想要查看天气预报的网站,选择自己想查看的地方,查看天气(例:http://www.tianqi.com/xixian1/15/)

2.打开"网页源代码",分析自己想要获取数据的特点

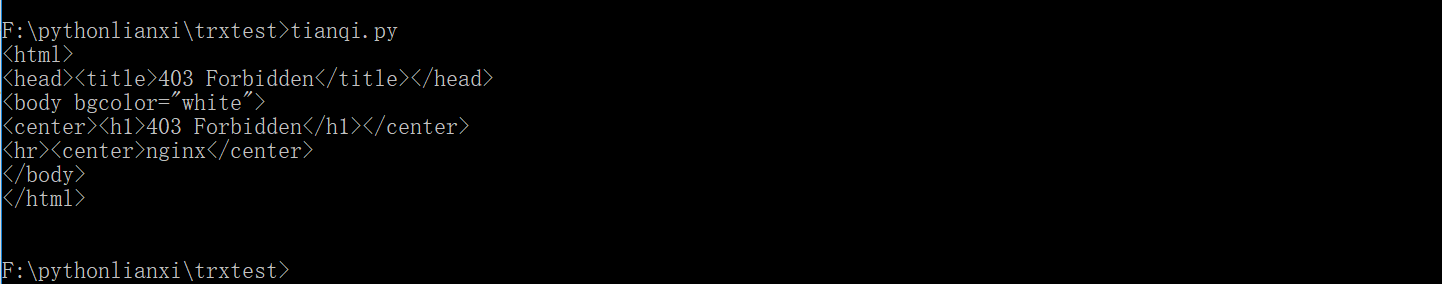

3.运用正则表达式来对数据进行处理,获得自己想要的数据 #网站可能反爬虫,需要绕过,这里用浏览器的代理(python默认的用户代理是自己,需要改成浏览器的用户代理,这样就能绕过一些网站简单的反爬虫)

4.获得数据后,对数据进行简单的美化

5.把数据写入文件(用pickle模块)

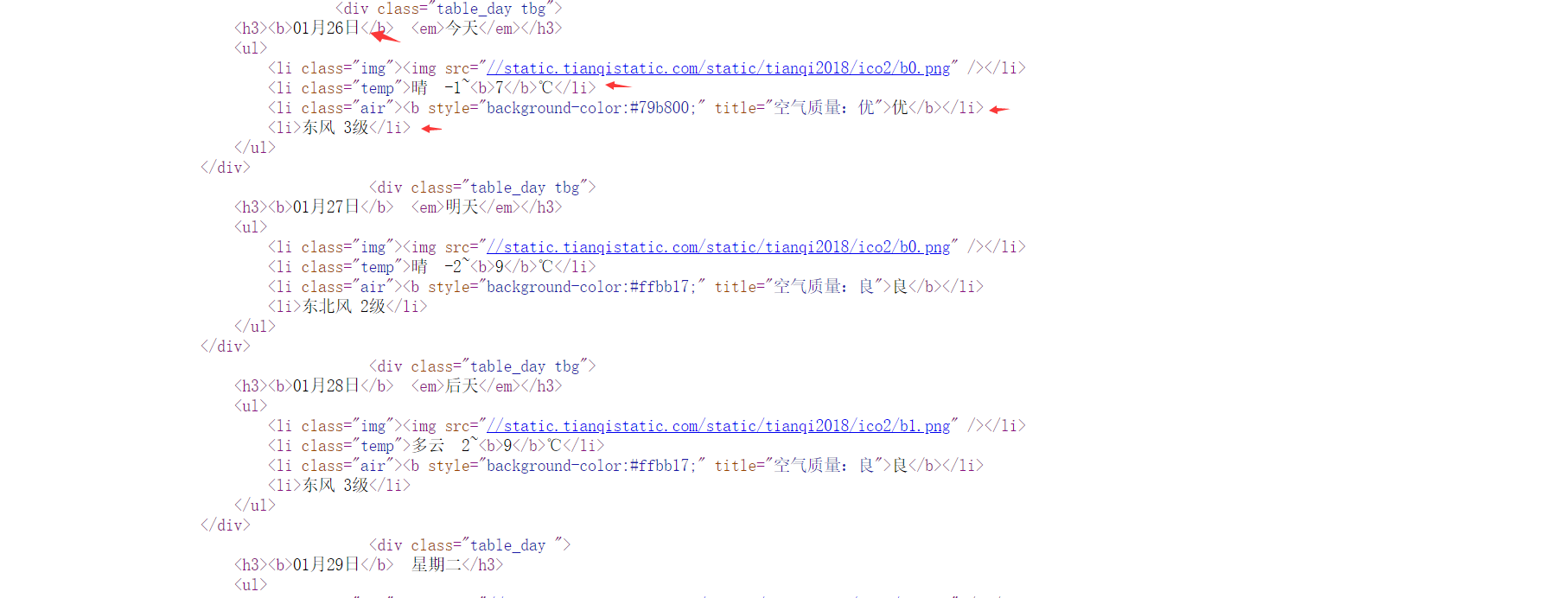

2.打开"网页源代码",分析自己想要获取数据的特点(不同网站的数据不同,需要具体问题具体分析)

3.1被网站禁止爬虫效果图如下:

3.2运用正则表达式来对数据进行处理,获得自己想要的数据

代码如下:

查看天气预报

import re

import requests

from prettytable import PrettyTable

url="http://www.tianqi.com/xixian1/15/"

#绕过网站反爬虫

txt=requests.get(url,headers={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36","Host":"www.tianqi.com"}).text

#print(txt)

s1=re.compile(r'<b>(\d\d月\d\d日)</b>') #日期

print(s1.findall(txt))

s2=re.compile(r'<li class="temp">(.+) (-?\d+)(\W+)<b>(-?\d+)</b>℃</li>')

print(s2.findall(txt))

s3=re.compile('>(.{1,4})</b></li>')

print(s3.findall(txt))

s4=re.compile(r'<li>([\u4e00-\u9fa5].+)</li>')

print(s4.findall(txt))

tianqi=[]

for i in range(len(s1.findall(txt))):

tianqi.append([s1.findall(txt)[i],s2.findall(txt)[i][0],s2.findall(txt)[i][1]+s2.findall(txt)[i][2]+s2.findall(txt)[i][3],s3.findall(txt)[i],s4.findall(txt)[i]]) print(tianqi)

ptable=PrettyTable('日期 天气 气温(℃) 空气质量 风级'.split())

for i in tianqi:

ptable.add_row(i)

print(ptable)

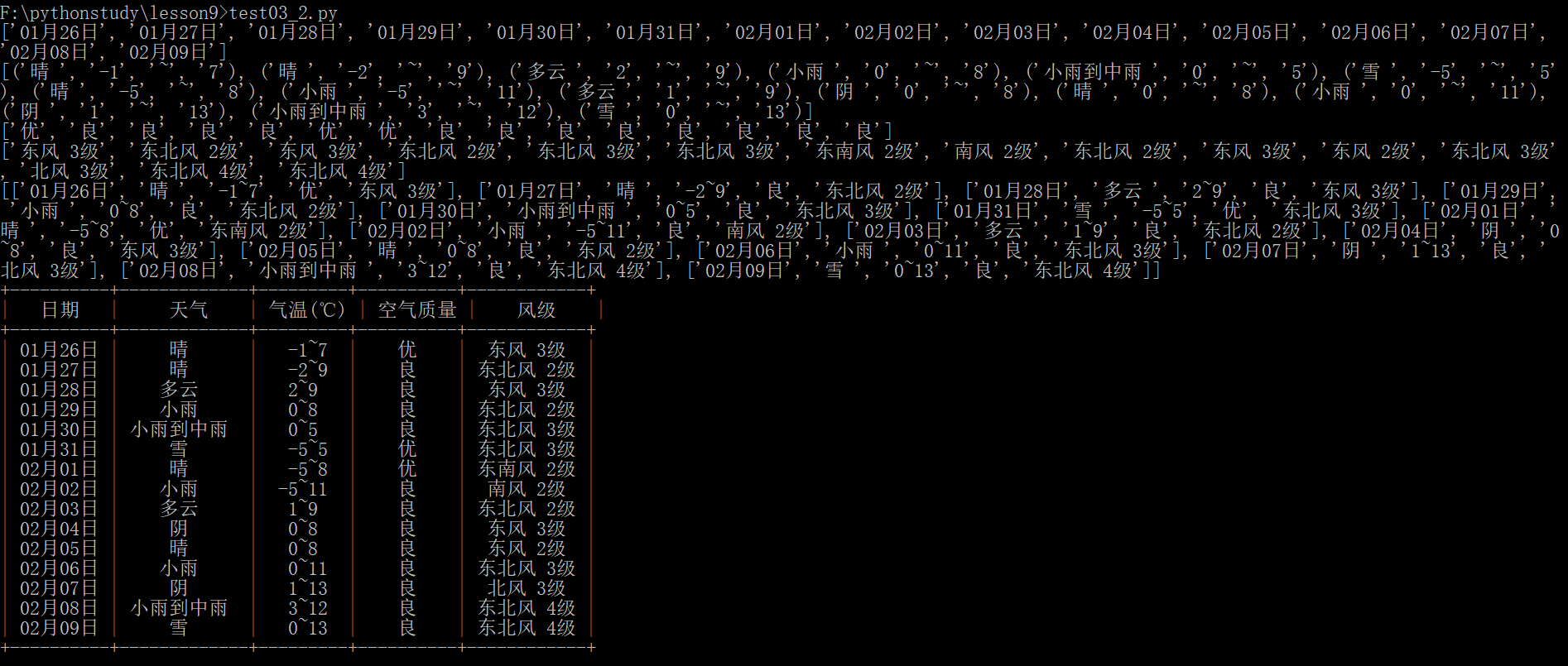

运行效果如下:

5.把数据写入文件(pickle)

代码如下:

import re

import requests

import pickle

from prettytable import PrettyTable

url="http://www.tianqi.com/xixian1/15/"

#绕过网站反爬虫

#把内容写入到文件中(序列化)

try:

with open("tianqi.txt","rb") as f:

txt=pickle.load(f)

print("结果已加载")

except:

txt=requests.get(url,headers={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36","Host":"www.tianqi.com"}).text

with open("tianqi.txt","wb") as f:

pickle.dump(txt,f)

print("文件已写入!")

#print(txt)

s1=re.compile(r'<b>(\d\d月\d\d日)</b>') #日期

print(s1.findall(txt))

s2=re.compile(r'<li class="temp">(.+) (-?\d+)(\W+)<b>(-?\d+)</b>℃</li>')

print(s2.findall(txt))

s3=re.compile('>(.{1,4})</b></li>')

print(s3.findall(txt))

s4=re.compile(r'<li>([\u4e00-\u9fa5].+)</li>')

print(s4.findall(txt))

tianqi=[]

for i in range(len(s1.findall(txt))):

tianqi.append([s1.findall(txt)[i],s2.findall(txt)[i][0],s2.findall(txt)[i][1]+s2.findall(txt)[i][2]+s2.findall(txt)[i][3],s3.findall(txt)[i],s4.findall(txt)[i]]) print(tianqi)

ptable=PrettyTable('日期 天气 气温(℃) 空气质量 风级'.split())

for i in tianqi:

ptable.add_row(i)

print(ptable)

python爬虫之天气预报网站--查看最近(15天)的天气信息(正则表达式)的更多相关文章

- python爬虫之12306网站--火车票信息查询

python爬虫之12306网站--火车票信息查询 思路: 1.火车票信息查询是基于车站信息查询,先完成车站信息查询,然后根据车站信息查询生成的url地址去查询当前已知出发站和目的站的所有车次车票信息 ...

- python爬虫之小说网站--下载小说(正则表达式)

python爬虫之小说网站--下载小说(正则表达式) 思路: 1.找到要下载的小说首页,打开网页源代码进行分析(例:https://www.kanunu8.com/files/old/2011/244 ...

- Python爬虫某招聘网站的岗位信息

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者:阿尔法游戏 PS:如有需要Python学习资料的小伙伴可以加点击下方链 ...

- python爬虫之12306网站--车站信息查询

python爬虫查询车站信息 目录: 1.找到要查询的url 2.对信息进行分析 3.对信息进行处理 python爬虫查询全拼相同的车站 目录: 1.找到要查询的url 2.对信息进行分析 3.对信息 ...

- 利用Python爬虫刷新某网站访问量

前言:前一段时间看到有博友写了爬虫去刷新博客访问量一篇文章,当时还觉得蛮有意思的,就保存了一下,但是当我昨天准备复现的时候居然发现文章404了.所以本篇文章仅供学习交流,严禁用于商业用途 很多人学习p ...

- Python爬虫: "追新番"网站资源链接爬取

“追新番”网站 追新番网站提供最新的日剧和日影下载地址,更新比较快. 个人比较喜欢看日剧,因此想着通过爬取该网站,做一个资源地图 可以查看网站到底有哪些日剧,并且随时可以下载. 资源地图 爬取的资源地 ...

- 编写python爬虫采集彩票网站数据,将数据写入mongodb数据库

1.准备工作: 1.1安装requests: cmd >> pip install requests 1.2 安装lxml: cmd >> pip install lxml ...

- python爬虫1——获取网站源代码(豆瓣图书top250信息)

# -*- coding: utf-8 -*- import requests import re import sys reload(sys) sys.setdefaultencoding('utf ...

- python爬虫爬小说网站涉及到(js加密,CSS加密)

我是对于xxxx小说网进行爬取只讲思路不展示代码请见谅 一.涉及到的反爬 js加密 css加密 请求头中的User-Agent以及 cookie 二.思路 1.对于js加密 对于有js加密信息,我们一 ...

随机推荐

- 使用3D Slicer对图像进行配准

在进行深度学习之前,我们需要图像进行一些预处理操作,其中配准是很重要的一环,以下将介绍使用软件3D Slicer来进行图像配准 3D Slicer是(1)一个软件平台,用以图像分析(包括配准和实时编辑 ...

- MyBatis源码解析(七)——DataSource数据源模块之托管数据源

原创作品,可以转载,但是请标注出处地址:http://www.cnblogs.com/V1haoge/p/6675700.html 1 回顾 之前介绍的非池型与池型数据源都是MyBatis自己定义的内 ...

- [JavaScript] XMLHttpRequest记录

XMLHttpRequest 使用 XMLHttpRequest 对象可以和服务器进行交互,可以获取到数据,而无需让整个页面进行刷新.这样 web 页面可以做到只更新局部页面,降低了对用户操作的影响. ...

- LeetCode-两个结构分别遍历,然后合并

今天做了leetcode67题,两个2进制数相加,回想了一下其实有很多这种类型的题,比如leetcode2两数相加. 在做这种题时我自己的思路就是先循环遍历一个短的,然后跳出循环,判断是哪个结束,再接 ...

- JDK源码分析(一)—— String

dir 参考文档 JDK源码分析(1)之 String 相关

- [转]Docker修改默认时区

本文转自:https://www.jianshu.com/p/004ddf941aac 前言 前段时间把公司部分项目迁移到了docker 容器里.查看ngixn反向代理的log时发现时间与正确时间相差 ...

- 【转载】 C#往文件中追加文本内容信息

在C#的文件相关操作中,往已有的文件中追加相关内容信息也是常有的操作,例如我们在写网站日志文件的时候,很多时候是1天的日志存放在一个txt文件中,此时就涉及到往原有文件中追加写入文本内容信息,追加文本 ...

- 细说flush、ob_flush的区别

ob_flush/flush在手册中的描述, 都是刷新输出缓冲区, 并且还需要配套使用, 所以会导致很多人迷惑… 其实, 他们俩的操作对象不同, 有些情况下, flush根本不做什么事情.. ob_* ...

- Linux 系统的安装 (最全收集)

在几年前,我曾经多次萌生抛弃Win系统,从而使用Linux系统-----(Ubuntu),但是我每次都会遇到同一个问题,TM怎么安装啊. 不是安装奇慢就是不知道安装的方法. 怎样安装Ubuntu操作系 ...

- Android Studio 学习(五)网络

HttpURLConnection OkHttp 添加依赖 编辑 app/build.gradle 在dependencies闭包中添加 implementation 'com.squareup.ok ...