Hadoop3集群搭建之——安装hadoop,配置环境

上篇已经安装好了虚拟机了,现在开始配置环境,安装hadoop

注:hadoop集群最少需要三台机,因为hdfs副本数最少为3,单机不算

我搭了三台机

1、创建hadoop用户,hadoopgroup组

groupadd -g hadoopgroup # 创建用户组 useradd -d /opt/hadoop -u -g hadoop #创建用户 passwd hadoop #给用户设置密码

2、安装ftp工具

yum -y install vsftpd

启动ftp:systemctl start vsftpd.service

停止ftp:systemctl stop vsftpd.service

重启ftp:systemctl restart vsftpd.service

[root@venn08 ~]# systemctl start vsftpd.service # 启动,无提示信息

[root@venn08 ~]# ps -ef|grep vsft #查看进程已存在,直接使用ftp工具连接

root : ? :: /usr/sbin/vsftpd /etc/vsftpd/vsftpd.conf

root : pts/ :: grep --color=auto vsft

[root@venn08 ~]# systemctl restart vsftpd.service

注:使用vsftpd 安装后就可以使用系统用户作为ftp用户登录,选项同系统权限,不需要额外配置。

2、安装jdk、hadoop

将下载的jdk、hadoop拷贝到服务器上,解压,修改目录名

[hadoop@venn05 ~]$ pwd

/opt/hadoop

[hadoop@venn05 ~]$ ll

drwxr-xr-x. hadoop hadoopgroup Apr : hadoop3

-rw-r--r--. hadoop hadoopgroup Apr : hadoop-3.0.1.tar.gz

drwxr-xr-x. hadoop hadoopgroup Apr jdk1.8

-rw-r--r--. hadoop hadoopgroup May jdk-8u91-linux-x64.tar.gz

修改目录名,是为了方便书写

3、配置Java、hadoop环境变量

在最后添加Java、hadoop环境变量,注意路径不要写错即可

[hadoop@venn05 ~]$ vim .bashrc

[hadoop@venn05 ~]$ more .bashrc

# .bashrc # Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi # Uncomment the following line if you don't like systemctl's auto-paging feature:

# export SYSTEMD_PAGER= # User specific aliases and functions

#jdk

export JAVA_HOME=/opt/hadoop/jdk1.8

export JRE_HOME=${JAVA_HOME}/jre

export CLASS_PATH=${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH #hadoop

export HADOOP_HOME=/opt/hadoop/hadoop3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

4、切换root用户,修改各机/etc/hosts

[root@venn05 hadoop]# vim /etc/hosts

[root@venn05 hadoop]# more /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

:: localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.1.5 venn05

192.168.1.6 venn06

192.168.1.7 venn07

其他几台机操作相同

5、创建ssh密钥

[hadoop@venn08 ~]$ mkdir .ssh # 创建.ssh 目录

[hadoop@venn08 ~]$ cd .ssh/

[hadoop@venn08 .ssh]$ ls

[hadoop@venn08 .ssh]$ pwd

/opt/hadoop/.ssh

[hadoop@venn08 .ssh]$ ssh-keygen -t rsa # 创建ssh秘钥,一路回车下去

Generating public/private rsa key pair.

Enter file in which to save the key (/opt/hadoop/.ssh/id_rsa):

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /opt/hadoop/.ssh/id_rsa.

Your public key has been saved in /opt/hadoop/.ssh/id_rsa.pub.

The key fingerprint is:

SHA256:rrlJxkA6o4eKwDKWjbx5CgyH+9EzbUiyfFHnJzgTL5w hadoop@venn08

The key's randomart image is:

+---[RSA ]----+

| |

| |

| . o . |

| . o o B |

|o * + E S . |

|=*+B * = o |

|OB=.* * . |

|B+o+ * + |

|o++ =. |

+----[SHA256]-----+

[hadoop@venn08 .ssh]$ ll # 查看

total

-rw-------. hadoop hadoopgroup Apr : id_rsa # 私钥,本机保存

-rw-r--r--. hadoop hadoopgroup Apr : id_rsa.pub #公钥,复制到其他机器

每台机都执行以上步骤,创建 ssh 密钥

6、合并每台机器的公钥,放到每台机器上

Venn05 :

复制公钥到文件 : cat id_rsa.pub >> authorized_keys

拷贝到 venn : scp authorized_keys hadoop@venn06:~/.ssh/authorized_keys Venn :

拷贝venn06的公钥到 authorized_keys : cat id_rsa.pub >> authorized_keys

拷贝到 venn07 : scp authorized_keys hadoop@venn07:~/.ssh/authorized_keys Venn07 :

复制公钥到文件 : cat id_rsa.pub >> authorized_keys

拷贝到 venn : scp authorized_keys hadoop@venn05:~/.ssh/authorized_keys

拷贝到 venn : scp authorized_keys hadoop@venn05:~/.ssh/authorized_keys

多机类推

至此,配置完成,现在各机hadoop用户可以免密登录。

7、修改 hadoop环境配置:hadoop-env.sh

进入路径: /opt/hadoop/hadoop3/etc/hadoop,打开 hadoop-env.sh 修改:

export JAVA_HOME=/opt/hadoop/jdk1.8 # 执行jdk

8、修改hadoop核心配置文件 : core-site.sh ,添加如下内容

<configuration>

<!--hdfs临时路径-->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/hadoop3/tmp</value>

</property>

<!--hdfs 的默认地址、端口 访问地址-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://venn05:8020</value>

</property>

</configuration>

9、修改yarn-site.sh ,添加如下内容

<configuration> <!-- Site specific YARN configuration properties -->

<!--集群master,-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>venn05</value>

</property> <!-- NodeManager上运行的附属服务-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--容器可能会覆盖的环境变量,而不是使用NodeManager的默认值-->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value> JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ</value>

</property>

<!-- 关闭内存检测,虚拟机需要,不配会报错-->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property> </configuration>

10、修改mapred-site.xml ,添加如下内容

<configuration>

<!--local表示本地运行,classic表示经典mapreduce框架,yarn表示新的框架-->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!--如果map和reduce任务访问本地库(压缩等),则必须保留原始值

当此值为空时,设置执行环境的命令将取决于操作系统:

Linux:LD_LIBRARY_PATH=$HADOOP_COMMON_HOME/lib/native.

windows:PATH =%PATH%;%HADOOP_COMMON_HOME%\\bin.

-->

<property>

<name>mapreduce.admin.user.env</name>

<value>HADOOP_MAPRED_HOME=/opt/hadoop/hadoop3</value>

</property>

<!--

可以设置AM【AppMaster】端的环境变量

如果上面缺少配置,可能会造成mapreduce失败

-->

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=/opt/hadoop/hadoop3</value>

</property> </configuration>

11、修改hdfs-site.xml ,添加如下内容

<configuration>

<!--hdfs web的地址 -->

<property>

<name>dfs.namenode.http-address</name>

<value>venn05:</value>

</property>

<!-- 副本数-->

<property>

<name>dfs.replication</name>

<value></value>

</property>

<!-- 是否启用hdfs权限检查 false 关闭 -->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<!-- 块大小,默认字节, 可使用 k m g t p e-->

<property>

<name>dfs.blocksize</name>

<!--128m-->

<value></value>

</property> </configuration>

12、修workers 文件

[hadoop@venn05 hadoop]$ more workers

venn05 # 第一个为master

venn06

venn07

至此,hadoop master配置完成

13、scp .bashrc 、jdk 、hadoop到各个节点

进入hadoop home目录 cd ~

scp -r .bashrc jdk1.8 hadoop3 hadoop@192.168.1.8:/opt/hadoop/

至此hadoop集群搭建完成。

14、启动hadoop:

格式化命名空间:

hdfs namenode –formate

启动集群:

start-all.sh

输出:

[hadoop@venn05 ~]$ start-all.sh

WARNING: Attempting to start all Apache Hadoop daemons as hadoop in seconds.

WARNING: This is not a recommended production deployment configuration.

WARNING: Use CTRL-C to abort.

Starting namenodes on [venn05]

Starting datanodes

Starting secondary namenodes [venn05]

Starting resourcemanager

Starting nodemanagers

jps 查看进程:

[hadoop@venn05 ~]$ jps

Jps

NodeManager

NameNode

ResourceManager

SecondaryNameNode

[hadoop@venn05 ~]$

查看其它节点状态:

[hadoop@venn06 hadoop]$ jps

NodeManager

Jps

DataNode

hadoop启动成功

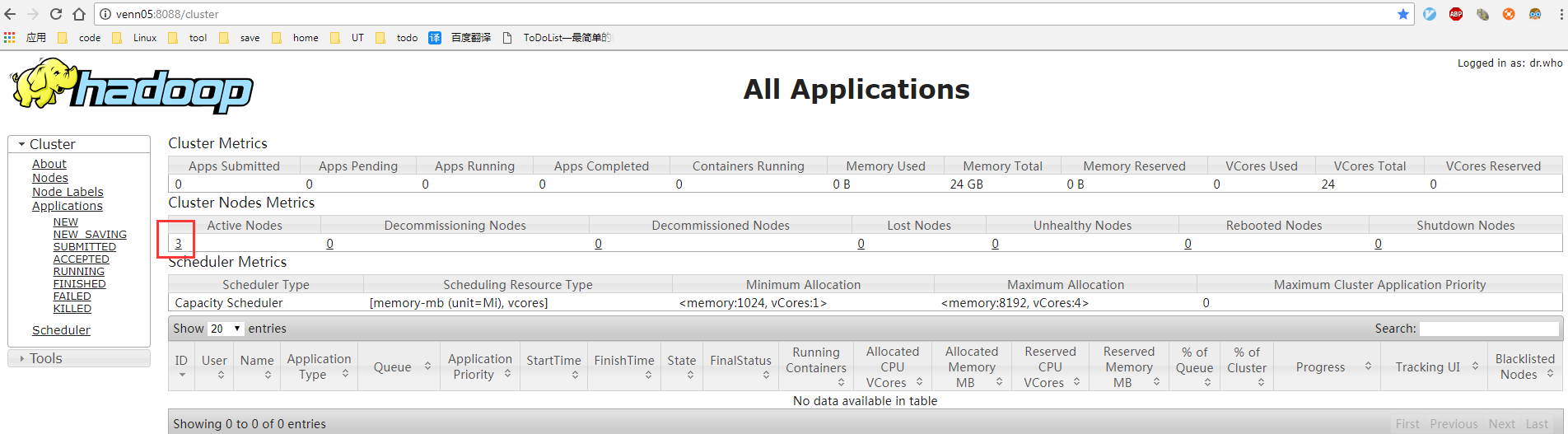

查看yarn web 控制台:

http://venn05:8088/cluster

查看 hdfs web 控制台:

http://venn05:50070/dfshealth.html#tab-overview

搞完收工,明天继续写ntp 和搭建过程中遇到的坑

Hadoop3集群搭建之——安装hadoop,配置环境的更多相关文章

- 基于Hadoop集群搭建Hive安装与配置(yum插件安装MySQL)---linux系统《小白篇》

用到的安装包有: apache-hive-1.2.1-bin.tar.gz mysql-connector-java-5.1.49.tar.gz 百度网盘链接: 链接:https://pan.baid ...

- Hadoop3集群搭建之——hbase安装及简单操作

折腾了这么久,hbase终于装好了 ------------------------- 上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hado ...

- Hadoop3集群搭建之——hive安装

Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hbase安装及简单操作 现在到 ...

- Hadoop3集群搭建之——配置ntp服务

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 下篇: Hadoop3集群搭建之——hive安装 Hadoop3集群搭建之——hbase安装及简 ...

- Hadoop3集群搭建之——虚拟机安装

现在做的项目是个大数据报表系统,刚开始的时候,负责做Java方面的接口(项目前端为独立的Java web 系统,后端也是Java web的系统,前后端系统通过接口传输数据),后来领导觉得大家需要多元化 ...

- Hadoop3集群搭建之——hive添加自定义函数UDTF (一行输入,多行输出)

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop3集群搭建之——hive添加自定义函数UDTF

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop3集群搭建之——hive添加自定义函数UDF

上篇: Hadoop3集群搭建之——虚拟机安装 Hadoop3集群搭建之——安装hadoop,配置环境 Hadoop3集群搭建之——配置ntp服务 Hadoop3集群搭建之——hive安装 Hadoo ...

- Hadoop集群搭建-05安装配置YARN

Hadoop集群搭建-04安装配置HDFS Hadoop集群搭建-03编译安装hadoop Hadoop集群搭建-02安装配置Zookeeper Hadoop集群搭建-01前期准备 先保证集群5台虚 ...

随机推荐

- FZU-1752.(A^B mod C)(快速幂与快速乘优化)

我把自己演哭了... 心酸.jpg 写了很多个版本的,包括数学公式暴力,快速幂TLE等等,最后想到了优化快速幂里的乘法,因为会爆longlong,但是和别人优化的效率简直是千差万别...? 本题大意: ...

- http://www.bugku.com:Bugku——备份是个好习惯(http://120.24.86.145:8002/web16/)

看了bugku的这道题,陌生又熟悉. 题目首先说[备份是个好习惯],访问网站只有一串字符,,,,,emmmmm,这句话表明人家经常做备份,所以咯,肯定在网站哪里备份有网页信息.嘻嘻 1 ...

- Django1.0和2.0中的rest_framework的序列化组件之超链接字段的处理

大家看到这个标题是不是有点懵逼,其实我就是想要一个这样的效果 比如我get一条书籍的数据,在一对多的字段中我们显示一个url,看起来是不是很绚! 下面我们就来实现这么一个东西 首先我们一对多字段中的一 ...

- django的csrf

csrf:跨站请求网站 如果是ajax提交,可以按照下面的方式处理 <script src="/static/jq/jquery-3.3.1.js"></scri ...

- MVC 的那点小事

两年未见 一切从头再来.我猜到了故事的开头,找工作一如我想象的那般艰难,但是结果却比我预期的要好很多. 第一次开始用MVC 框架,比我想象的要简单的多,就像同事跟我说的,这只是个框架. 言归正传,前两 ...

- day 31 表单标签,CSS

一. HTML表单标签 HTML表单用于搜集不同类型的用户输入,然后把数据提交给服务器处理. 常用的表单标签: 标签 作用 form 所有表单标签的根标签 input 输入标签,包括单行输入框.密码框 ...

- C++ 中 int 与string相互转换

int --> string 1.使用itoa()函数 将任意类型的数字变量转换为字串子变量. #include<stdio.h> #include<iostream> ...

- 如何将python中的List转化成dictionary

问题1:如何将一个list转化成一个dictionary? 问题描述:比如在python中我有一个如下的list,其中奇数位置对应字典的key,偶数位置为相应的value list : ['品牌', ...

- 两个App之间的跳转 并传值

两个App之间的传值最主要的是方法是 Intent intent = getPackageManager().getLaunchIntentForPackage("com.example.a ...

- echarts柱状图图例不显示的问题

如果想要图例有效果,legend中数据要和series中name的值保持一致,切记切记,这是我曾经遇到的坑,不保持一致是没有效果的