Sklearn库例子3:分类——岭回归分类(Ridge Regression )例子

为了解决数据的特征比样本点还多的情况,统计学家引入了岭回归。

岭回归通过施加一个惩罚系数的大小解决了一些普通最小二乘的问题。回归系数最大限度地减少了一个惩罚的误差平方和。

这里 是一个复杂的参数,用来控制收缩量,其值越大,就有更大的收缩量,从而成为更强大的线性系数。

是一个复杂的参数,用来控制收缩量,其值越大,就有更大的收缩量,从而成为更强大的线性系数。

Ridge和Line_Model一样,用fit(x,y)来训练模型,回归系数保存在coef_成员中

例子:

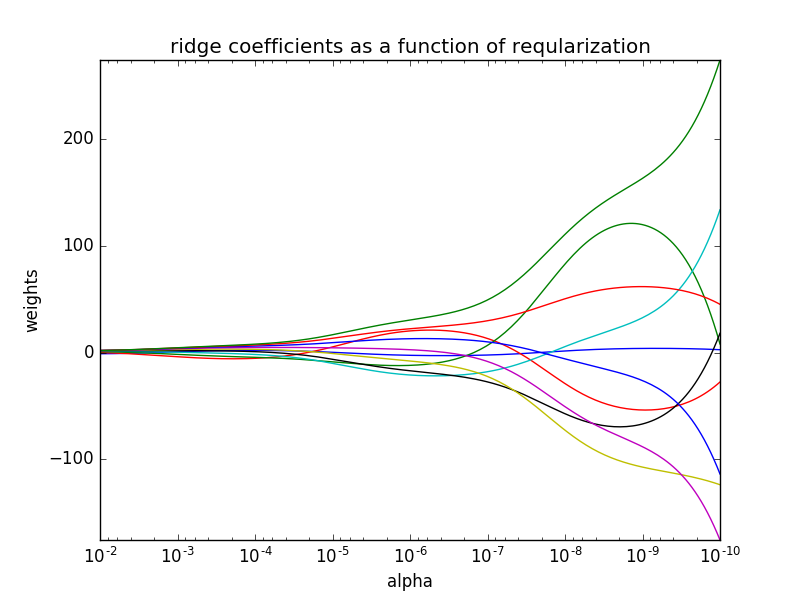

在这个例子使用岭回归作为估计器。结果中的每个颜色表示的系数向量的一个不同的功能,这是显示作为正则化参数的函数。在路径的最后,作为α趋于零和解决方案往往对普通最小二乘,系数表现出大的振荡。

代码如下:

#-*- encoding:utf-8 -*-

"""

岭回归example1

@Dylan

"""

import numpy as np

import matplotlib.pyplot as plt

from sklearn import linear_model #x是10*10 的Hilbert 矩阵

x=1./(np.arange(1,11)+np.arange(0,10)[:,np.newaxis])

# print(x)

y=np.ones(10) #####compute path

n_alphas=200

alphas=np.logspace(-10,-2,n_alphas)

# print(alphas)

clf=linear_model.Ridge(fit_intercept=False)

coefs=[]

for a in alphas:

clf.set_params(alpha=a)

clf.fit(x,y)

coefs.append(clf.coef_) ###展示结果

ax=plt.gca()

ax.set_color_cycle(['b','r','g','c','k','y','m']) ax.plot(alphas,coefs)

ax.set_xscale('log')

ax.set_xlim(ax.get_xlim()[::-1])

plt.xlabel('alpha')

plt.ylabel('weights')

plt.title('ridge coefficients as a function of reqularization')

plt.axis('tight')

plt.show()

其中 x为hilbert矩阵,生成方式值得借鉴。np.logspace()函数文档链接如下:here

结果如下:

Sklearn库例子3:分类——岭回归分类(Ridge Regression )例子的更多相关文章

- 机器学习:模型泛化(岭回归:Ridge Regression)

一.基础理解 模型正则化(Regularization) # 有多种操作方差,岭回归只是其中一种方式: 功能:通过限制超参数大小,解决过拟合或者模型含有的巨大的方差误差的问题: 影响拟合曲线的两个因子 ...

- 线性回归——lasso回归和岭回归(ridge regression)

目录 线性回归--最小二乘 Lasso回归和岭回归 为什么 lasso 更容易使部分权重变为 0 而 ridge 不行? References 线性回归很简单,用线性函数拟合数据,用 mean squ ...

- scikit-learn中的岭回归(Ridge Regression)与Lasso回归

一.岭回归模型 岭回归其实就是在普通最小二乘法回归(ordinary least squares regression)的基础上,加入了正则化参数λ. 二.如何调用 class sklearn.lin ...

- python机器学习sklearn 岭回归(Ridge、RidgeCV)

1.介绍 Ridge 回归通过对系数的大小施加惩罚来解决 普通最小二乘法 的一些问题. 岭系数最小化的是带罚项的残差平方和, 其中,α≥0α≥0 是控制系数收缩量的复杂性参数: αα 的值越大,收缩量 ...

- 岭回归和lasso回归(转)

回归和分类是机器学习算法所要解决的两个主要问题.分类大家都知道,模型的输出值是离散值,对应着相应的类别,通常的简单分类问题模型输出值是二值的,也就是二分类问题.但是回归就稍微复杂一些,回归模型的输出值 ...

- 在线场景感知:图像稀疏表示—ScSPM和LLC总结(以及lasso族、岭回归)

前言: 场景感知其实不分三维场景和二维场景,可以使用通用的方法,不同之处在于数据的形式,以及导致前期特征提取及后期在线场景分割过程.场景感知即是场景语义分析问题,即分析场景中物体的特征组合与相应场景的 ...

- 多元线性回归模型的特征压缩:岭回归和Lasso回归

多元线性回归模型中,如果所有特征一起上,容易造成过拟合使测试数据误差方差过大:因此减少不必要的特征,简化模型是减小方差的一个重要步骤.除了直接对特征筛选,来也可以进行特征压缩,减少某些不重要的特征系数 ...

- sklearn学习笔记之岭回归

岭回归 岭回归是一种专用于共线性数据分析的有偏估计回归方法,实质上是一种改良的最小二乘估计法,通过放弃最小二乘法的无偏性,以损失部分信息.降低精度为代价获得回归系数更为符合实际.更可靠的回归方法,对病 ...

- AI - TensorFlow - 分类与回归(Classification vs Regression)

分类与回归 分类(Classification)与回归(Regression)的区别在于输出变量的类型.通俗理解,定量输出称为回归,或者说是连续变量预测:定性输出称为分类,或者说是离散变量预测. 回归 ...

随机推荐

- PAT 08-2 求矩阵的局部最大值

这题挺简单的,但,每日一篇.说两点:第一,我的粗心导致我这题花了大把的时间去找错误,看到4个测试用例对了三个,我以为是那块的边界条件没考虑到,又或者是存在隐蔽的逻辑或语法错误,通过与别人程序的反复对比 ...

- Cisco路由器的6种模式

Cisco路由器的6种模式 -------------------------------------------------------------------------------------- ...

- 永不消逝的电波(三):低功耗蓝牙(BLE)入门之如何调戏别人的小米手环

0×00 前言 蓝牙(Bluetooth),一种无线技术标准,用来让固定与移动设备,在短距离间交换数据,以形成个人局域网(PAN).其使用短波特高频(UHF)无线电波,经由2.4至2.485 GHz的 ...

- UID 修改 & UID 锁死修复

首先是UID修改的问题,只要卡是UID卡,就都可以修改UID,首先读卡器连接电脑,卡片放到读卡器上. 然后我们要用一个工具,UID207.打开UID207.exe,点Initialize,初始化. 然 ...

- HDU 1054

http://acm.hdu.edu.cn/showproblem.php?pid=1054 二分图最少顶点覆盖,模板题,双向边最后结果/2 #include <iostream> #in ...

- 转:SQL SERVER数据库中实现快速的数据提取和数据分页

探讨如何在有着1000万条数据的MS SQL SERVER数据库中实现快速的数据提取和数据分页.以下代码说明了我们实例中数据库的“红头文件”一表的部分数据结构: CREATE TABLE [dbo]. ...

- Oracle PL/SQL高级应用 视图 同义词 序列

视图: 视图叫虚表,即是在哪个表上建立的视图,将那个表的数据用一条查询sql语句查出的数据展现在该视图中,对这个视图操作就是只能对该视图中的数据进行操作,该操作也会保存在建立的表中.可以理解为表上表, ...

- 《JS高程》实现继承的6种方式(完整版)

许多OO语言都支持 两种继承方式: (1)接口继承:只继承方法签名: (2)实现继承:继承实际的方法. ECMAScript 由于函数没有签名,无法实现接口继承,因此只支持实现继承,而且主要是依靠原型 ...

- ueditor上传图片到七牛云存储(form api,java)

转:http://my.oschina.net/duoduo3369/blog/174655 ueditor上传图片到七牛云存储 ueditor结合七牛传图片 七牛的试炼 开发前的准备与注意事项说明 ...

- 给linux添加一个回收站

http://blog.chinaunix.net/uid-26805356-id-3492419.html 都知道linux没有回收站,如果一不小心 rm -rf之后,很难恢复,所以就编写了一个回收 ...