python爬虫之分析Ajax请求抓取抓取今日头条街拍美图(七)

python爬虫之分析Ajax请求抓取抓取今日头条街拍美图

一、分析网站

1.进入浏览器,搜索今日头条,在搜索栏搜索街拍,然后选择图集这一栏。

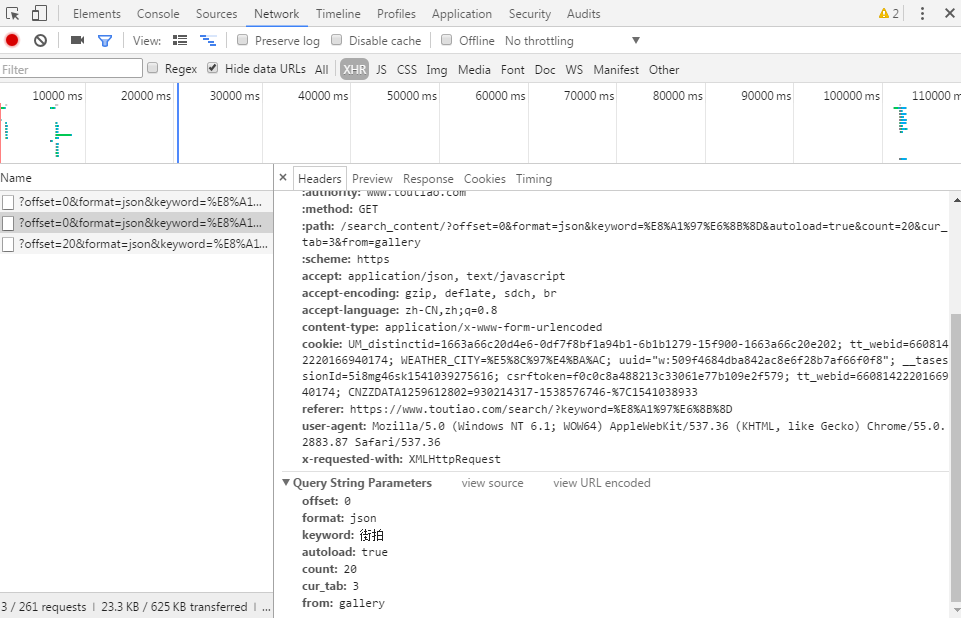

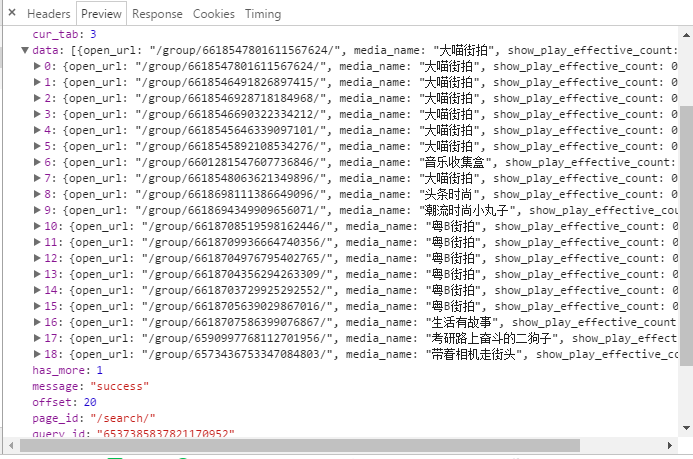

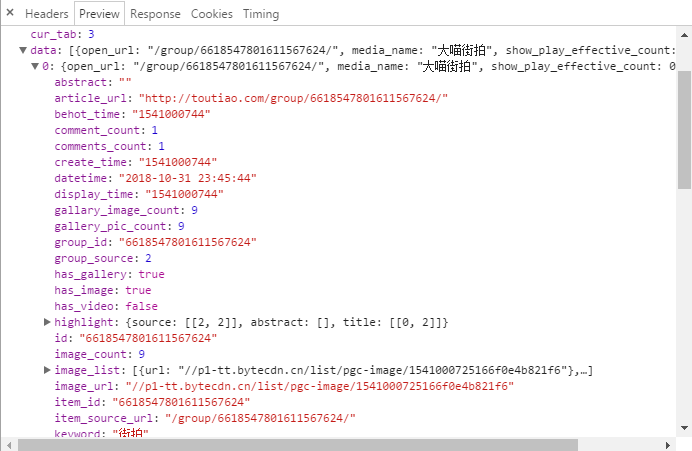

2.按F12打开开发者工具,刷新网页,这时网页回弹到综合这一栏,点击图集,在开发者工具中查看 XHR这个选项卡。

3.具体分析url,请求参数

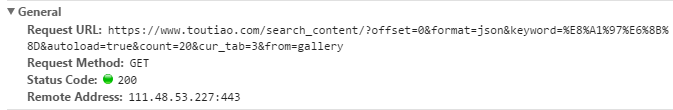

当我们在请求图集这个页面时,url如下:

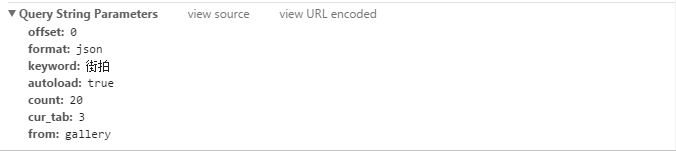

请求参数如下:

我们可以看到这个url的构成:

前面:https://www.toutiao.com/search_content/?

后面:offset=0&format=json&keyword=%E8%A1%97%E6%8B%8D&autoload=true&count=20&cur_tab=3&from=gallery

二、源代码

程序主体

import requests

from urllib.parse import urlencode

from requests.exceptions import RequestException

import json

import re

import os

import pymongo

from hashlib import md5

from bs4 import BeautifulSoup

from multiprocessing import Pool

from config import * #导入mongodb

client = pymongo.MongoClient(MOMGO_URL,connect=False)

#创建数据库对象

db = client[MOMGO_DB] #获取索引页内容

def get_page_index(offset,keyword):

#构造请求参数

data ={

'offset':offset,

'format':'json',

'keyword':keyword,

'autoload':'true',

'count':'20',

'cur_tab':'3',

'from':'gallery',

}

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64; Trident/7.0; rv:11.0) like Gecko'}

#请求url, urlencode()将字典数据转为url请求

url = 'https://www.toutiao.com/search_content/?' + urlencode(data) try:

response = requests.get(url,headers=headers)

if response.status_code ==200:

return response.text

return None

except RequestException:

print('请求页出错')

return None #解析索引网页,获得详细页面url

def parse_page_index(html):

#解析json数据,转为json对象

data = json.loads(html)

#判断data是否存在,存在则返回所有的键名

if data and 'data' in data.keys():

for item in data.get('data'):

#提取article_url,把article_url循环取出来

yield item.get('article_url') #获取详细页面内容

def get_page_detail(url):

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36 QIHU 360SE'}

try:

response = requests.get(url,headers=headers)

if response.status_code == 200:

return response.text

return None

except RequestException:

print('请求详细页出错')

return None #解析详细页面内容

def parse_page_Detail(html,url):

#生成BeautifulSoup对象,使用lxml解析

soup = BeautifulSoup(html,'lxml')

#匹配标题

title_pattern = re.compile('BASE_DATA.galleryInfo = {.*?title: (.*?),',re.S)

#匹配图片

images_pattern = re.compile('BASE_DATA.galleryInfo = {.*?gallery: JSON.parse\("(.*?)"\)',re.S)

result =re.search(images_pattern,html)

title = re.search(title_pattern,html)

if result:

data =json.loads(result.group(1).replace('\\',''))

#如果sub_images存在,返回所有键名

if data and 'sub_images' in data.keys():

#获取sub_images的所有内容

sub_images = data.get('sub_images')

#获取一组图,构造列表

images = [item.get('url') for item in sub_images]

#下载图片,保存图片

for image in images: down_images(image)

return {

'title':title.group(1),

'url':url,

'images':images

} def save_to_mongo(result):

if db[MOMG_TABLE].insert(result):

print('存储到mongodb成功')

return True

return False #下载图片

def down_images(url):

print('正在下载图片:'+ url)

headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36 QIHU 360SE'}

try:

response = requests.get(url,headers=headers)

if response.status_code == 200:

sava_images(response.content)

return None

except RequestException:

print('请求图片出错')

return None #保存图片

def sava_images(content):

file_path = "{0}/{1}.{2}".format(os.getcwd(),md5(content).hexdigest(),'jpg')

if not os.path.exists(file_path):

with open(str(file_path),'wb') as f:

f.write(content)

f.close() def main(offset):

#获取索引页内容

#传入第一个变量为offset值,第二个为关键字,网页通过滑动,offset值会发生改变

html = get_page_index(offset,KEYWORD)

#解析索引页内容,获取详细页面URL

for url in parse_page_index(html):

#将详细页面内容赋值给html

html = get_page_detail(url)

#如果详细页面内容不为空,则解析详细内容

if html:

result = parse_page_Detail(html,url)

print(result)

if result:

save_to_mongo(result) if __name__=='__main__': groups = [x * 20 for x in range(GROUP_START,GROUP_END + 1)]

#创建进程池

pool=Pool()

#开启多进程

pool,map(main(offset=0), groups)

配置文件

#链接地址

MOMGO_URL='localhost'

#数据库名字

MOMGO_DB='toutiao'

#表名

MOMG_TABLE='toutiao' GROUP_START=1

GROUP_END=20

KEYWORD="街拍"

python爬虫之分析Ajax请求抓取抓取今日头条街拍美图(七)的更多相关文章

- 15-分析Ajax请求并抓取今日头条街拍美图

流程框架: 抓取索引页内容:利用requests请求目标站点,得到索引网页HTML代码,返回结果. 抓取详情页内容:解析返回结果,得到详情页的链接,并进一步抓取详情页的信息. 下载图片与保存数据库:将 ...

- Python Spider 抓取今日头条街拍美图

""" 抓取今日头条街拍美图 """ import os import time import requests from hashlib ...

- 分析Ajax请求并抓取今日头条街拍美图

项目说明 本项目以今日头条为例,通过分析Ajax请求来抓取网页数据. 有些网页请求得到的HTML代码里面并没有我们在浏览器中看到的内容.这是因为这些信息是通过Ajax加载并且通过JavaScript渲 ...

- 【Python3网络爬虫开发实战】 分析Ajax爬取今日头条街拍美图

前言本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理.作者:haoxuan10 本节中,我们以今日头条为例来尝试通过分析Ajax请求 ...

- 【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图【华为云技术分享】

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

- 转:【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

- 爬虫(八):分析Ajax请求抓取今日头条街拍美图

(1):分析网页 分析ajax的请求网址,和需要的参数.通过不断向下拉动滚动条,发现请求的参数中offset一直在变化,所以每次请求通过offset来控制新的ajax请求. (2)上代码 a.通过aj ...

- 2.分析Ajax请求并抓取今日头条街拍美图

import requests from urllib.parse import urlencode # 引入异常类 from requests.exceptions import RequestEx ...

- 分析 ajax 请求并抓取今日头条街拍美图

首先分析街拍图集的网页请求头部: 在 preview 选项卡我们可以找到 json 文件,分析 data 选项,找到我们要找到的图集地址 article_url: 选中其中一张图片,分析 json 请 ...

随机推荐

- 变量,id()

>>> a = 1 >>> print id(a) 2870961640 >>> b = a >>> print id(b) 2 ...

- redis的底层数据机构

集群架构 参考 https://blog.csdn.net/wcf373722432/article/details/78678504 https://www.cnblogs.com/George19 ...

- 论文笔记系列-Efficient Neural Architecture Search via Parameter Sharing

Summary 本文提出超越神经架构搜索(NAS)的高效神经架构搜索(ENAS),这是一种经济的自动化模型设计方法,通过强制所有子模型共享权重从而提升了NAS的效率,克服了NAS算力成本巨大且耗时的缺 ...

- PHP - CentOS下开发运行环境搭建(Apache+PHP+MySQL+FTP)

本文介绍如何在 Linux下搭建一个 PHP 环境.其中 Linux 系统使用是 CentOS 7.3,部署在阿里云服务器上. 1,连接登录服务器 拿到服务器的 ip.初始密码以后.我们先通过远程 ...

- 【python图像处理】图像的缩放、旋转与翻转

[python图像处理]图像的缩放.旋转与翻转 图像的几何变换,如缩放.旋转和翻转等,在图像处理中扮演着重要的角色,python中的Image类分别提供了这些操作的接口函数,下面进行逐一介绍. 1.图 ...

- MR数据生成工具指向目录

mrDataTidy_SaveTwoDays.jar 原始路径 :D:\太原MR数据\一天数据整理 目标路径 : D:\MR现场数据整理\保存两天_整理后数据 例如 当前时间:2017-5-17 10 ...

- linux内核中链表代码分析---list.h头文件分析(二)【转】

转自:http://blog.chinaunix.net/uid-30254565-id-5637598.html linux内核中链表代码分析---list.h头文件分析(二) 16年2月28日16 ...

- 【转】OpenCV对图片中的RotatedRect进行填充

函数名:full_rotated_rect 函数参数: image输入图像,rect希望在图像中填充的RotatedRect,color填充的颜色 主要的思路是:先找到RotatedRect的四个顶点 ...

- python闭包的理解说明

什么是闭包: 闭包(closure)是函数式编程的重要的语法结构.函数式编程是一种编程范式 (而面向过程编程和面向对象编程也都是编程范式).在面向过程编程中,我们见到过函数(function):在面向 ...

- Android:注册登录

注册登录的实现 先在layout里新建一个xml文件: //login.xml <?xml version="1.0" encoding="utf-8"? ...