多元线性回归(Multivariate Linear Regression)简单应用

警告:本文为小白入门学习笔记

数据集:

由房屋的面积和bedroom个数影响房价的高低。

加载数据

x = load('ex3x.dat');

y = load('ex3y.dat');

m = length(y);

x = [ones(m, 1), x]; (之所以加上一列1,因为x1 = 1);

看一下输入值,注意房间面积是卧室数量的1000倍左右。这种差异意味着预处理输入将显着提高梯度下降的效率。

在您的程序中,按标准偏差缩放两种类型的输入,并将其均值设置为零。

%数据处理,特征值缩放

sigma = std(x);%标准差

mu = mean(x); %平均数

x(:,2) = (x(:,2) - mu(2))./ sigma(2);

x(:,3) = (x(:,3) - mu(3))./ sigma(3);

假设函数任然是:

梯度下降算法:

用居矩阵的方式计算:

theta = theta - x'*(x*theta-y)/m*a;

这里theta是一个3*1的矩阵,x是50*2矩阵,y是50*1矩阵,a表示alpha,m表示矩阵列长;

最终MATLAB程序是:

function [jVal] = multiLinerCost(a)

x = load('ex3x.dat');

y = load('ex3y.dat');

m = length(y);

x = [ones(m, 1), x];

%数据处理,特征值缩放

sigma = std(x);%标准差

mu = mean(x); %平均数

x(:,2) = (x(:,2) - mu(2))./ sigma(2);

x(:,3) = (x(:,3) - mu(3))./ sigma(3);

theta = zeros(size(x(1,:)))'; %3*1

J = zeros(50,1);

for iter = 1:50

theta = theta - x'*(x*theta-y)/m*a;

jVal = sum((x*theta-y).^2)/(2*m);

J(iter) = jVal;

end

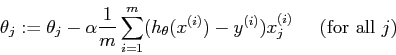

%绘图

plot(0:49,J(1:50),'-');

xlabel('Number of iterations')

ylabel('Cost J')

end

控制台:

multiLinerCost(0.07) %选取学习速率(learning rates )为0.07;

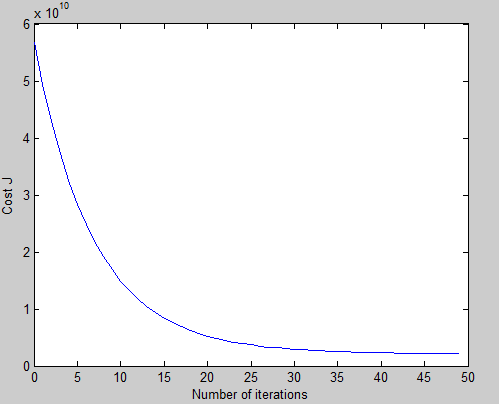

我们可以试试不同的learning rates 取值,对比曲线。

可以看到alpha =0.01时,曲线下降缓慢,迭代50次时还没有下降到最低值,alpha = 0.3时曲线在5附近急剧下降,在之后迭代就没有太大变化,所以选取0.07这个值相对合理。

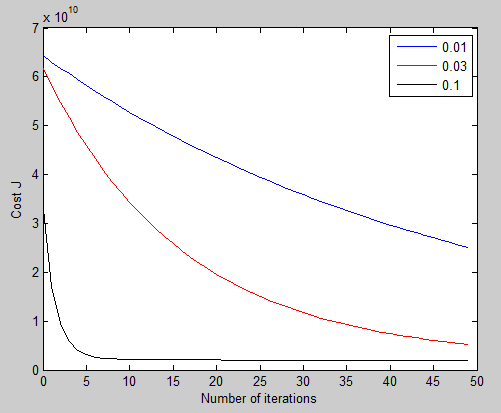

如果alpha 再大会怎么样呢?

设alpha=1.5,可以看到这个值太大以至于一开始就为零,到最后趋近于无穷大。

所以一般取值 :

|

使用梯度下降算法求得theta:

1.0e+05 *

3.4041

1.1063

-0.0665

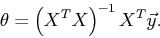

使用矩阵计算求出:(如果用矩阵直接计算,不用特征值缩放)

1.0e+04 *

8.9598

0.0139

-0.8738

(梯度下降法)所以最后的曲线方程是 h(x1,x2) = 340413 + 110631*x1 - 6650*x2

假如一个房间面积为1650,bedroom个数是3个,那么预测价格是$293,081;

这是对于二元线性回归问题,如果一般化X = [x1;x2;x3;........xn] ; theta = [theta0;theta1;......thetan]也可以解决。

这只是对多元线性回归的简单应用,还有很多东西要学习。

入门菜鸟,错误地方欢迎指教!

多元线性回归(Multivariate Linear Regression)简单应用的更多相关文章

- 机器学习之多变量线性回归(Linear Regression with multiple variables)

1. Multiple features(多维特征) 在机器学习之单变量线性回归(Linear Regression with One Variable)我们提到过的线性回归中,我们只有一个单一特征量 ...

- 机器学习经典算法具体解释及Python实现--线性回归(Linear Regression)算法

(一)认识回归 回归是统计学中最有力的工具之中的一个. 机器学习监督学习算法分为分类算法和回归算法两种,事实上就是依据类别标签分布类型为离散型.连续性而定义的. 顾名思义.分类算法用于离散型分布预測, ...

- 从损失函数优化角度:讨论“线性回归(linear regression)”与”线性分类(linear classification)“的联系与区别

1. 主要观点 线性模型是线性回归和线性分类的基础 线性回归和线性分类模型的差异主要在于损失函数形式上,我们可以将其看做是线性模型在多维空间中“不同方向”和“不同位置”的两种表现形式 损失函数是一种优 ...

- 从零单排入门机器学习:线性回归(linear regression)实践篇

线性回归(linear regression)实践篇 之前一段时间在coursera看了Andrew ng的机器学习的课程,感觉还不错,算是入门了. 这次打算以该课程的作业为主线,对机器学习基本知识做 ...

- Python 线性回归(Linear Regression) 基本理解

背景 学习 Linear Regression in Python – Real Python,对线性回归理论上的理解做个回顾,文章是前天读完,今天凭着记忆和理解写一遍,再回温更正. 线性回归(Lin ...

- 【深度学习】线性回归(Linear Regression)——原理、均方损失、小批量随机梯度下降

1. 线性回归 回归(regression)问题指一类为一个或多个自变量与因变量之间关系建模的方法,通常用来表示输入和输出之间的关系. 机器学习领域中多数问题都与预测相关,当我们想预测一个数值时,就会 ...

- Multivariate Linear Regression

Multiple Features Linear regression with multiple variables is also known as "multivariate line ...

- 第五十篇 入门机器学习——线性回归(Linear Regression)

No.1. 线性回归算法的特点 No.2. 分类问题与回归问题的区别 上图中,左侧为分类问题,右侧为回归问题.左侧图中,横轴和纵轴表示的都是样本的特征,用不同的颜色来作为输出标记,表示不同的种类:左侧 ...

- 多重线性回归 (multiple linear regression) | 变量选择 | 最佳模型 | 基本假设的诊断方法

P133,这是第二次作业,考察多重线性回归.这个youtube频道真是精品,用R做统计.这里是R代码的总结. 连续变量和类别型变量总要分开讨论: 多重线性回归可以写成矩阵形式的一元一次回归:相当于把多 ...

随机推荐

- export default用法

// test.js export default { name: 'zs', age: 20 } 或是 // test.js var info = { name: 'zs', age: 20 } e ...

- Tomcat配置Https环境

windows环境下:http://blog.csdn.net/supersky07/article/details/7407523 linux环境下:http://blog.csdn.net/cuk ...

- codeforces589I

Lottery CodeForces - 589I Today Berland holds a lottery with a prize — a huge sum of money! There ar ...

- JarvisOJ Basic Base64?

GUYDIMZVGQ2DMN3CGRQTONJXGM3TINLGG42DGMZXGM3TINLGGY4DGNBXGYZTGNLGGY3DGNBWMU3WI=== 题目非常具有迷惑性,我一开始以为就是一 ...

- M3U8文件

M3U本质上说不是音频文件,它是音频文件的列表文件,是纯文本文件.你下载下来打开它,播放软件并不是播放它,而是根据它的记录找到网络地址进行在线播放. M3U文件的大小很小,也就是因为它里面没有任何音频 ...

- Mac下安装MySQL(Mac 10.12)

系统:Mac OS 10.12 MySQL:5.7.15 前言: 安装mysql有两种方式:1为官方下载dmg安装包.2为使用brew进行安装. 安装步骤: 一.官方下载dmg安装包进行安装 1.登陆 ...

- Android 修改 Menu字体颜色

转载:http://blog.csdn.net/jayyuz/article/details/55260996 @Override public boolean onCreateOptionsMenu ...

- python通过配置文件连接数据库

今天主要是通过读取配置文件(ini文件)获取数据库表的ip,端口,用户,密码,表名等,使用pysql来操作数据库,具体的ini配置文件的操作参见我另一篇博客:https://www.cnblogs.c ...

- Ionic3新页面去除Tabs的菜单问题总结

问题 要求在[我的]页面,点击[退出登录]按钮,返回到登录页面. 使用 this.navCtrl.setRoot(LoginPage); 或者 this.navCtrl.push(LoginPage) ...

- project 2013 工时完成百分比不会自动更新填充

[工时完成百分比].[实际完成百分比] 需要手填 [完成百分比] 会自动填,如下图