scrapy框架学习(六)日志设置和数据存储

日志设置

CRITICAL : 严重错误

ERROR : 一般错误

WARNING : 警告

INFO : 一般的信息

DEBUG : 调试信息

默认的显示级别是DEBUG

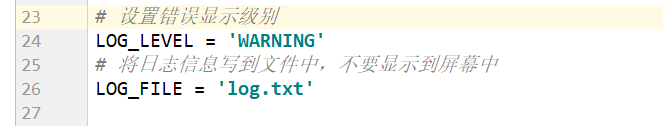

# 设置错误显示级别

LOG_LEVEL = 'DEBUG'

# 将日志信息写到文件中,不要显示到屏幕中

LOG_FILE = 'log.txt'

数据存储

在pipelines.py文件中创建3个函数

def open_spider(self,spider) 爬虫启动时会调用此方法

def close_spider(self,spider) 爬虫结束时会调用此方法

def download(self,item) 自己构建的下载文件的方法

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/latest/topics/item-pipeline.html # useful for handling different item types with a single interface

from itemadapter import ItemAdapter import json

import os

import urllib.request class MyfirstScrapydemoPipeline: #爬虫启动时会调用此方法

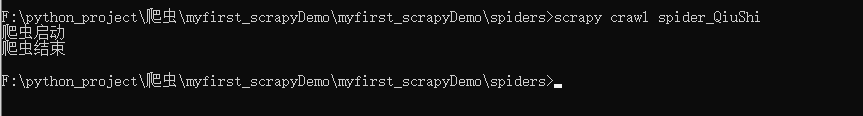

def open_spider(self,spider):

print('爬虫启动')

self.fp= open('qiushibaike.txt','w',encoding='utf8') def process_item(self, item, spider):

#下载头像图片

self.download(item)

#将数据转化为字典

obj= dict(item)

#将字典数据装换为json格式

string= json.dumps(obj,ensure_ascii=False)

#将数据写入文件

self.fp.write(string+'\n')

#不注释return item时只会下载第一页的头像

#return item def download(self,item):

#定义头像图片存放路径

dirpath= r'F:\python_project\爬虫\myfirst_scrapyDemo\myfirst_scrapyDemo\spiders\头像'

#获取每一张图片的名称

name= item['name']+'.jpg'

#拼接每一张头像图片的存储路径

filepath=os.path.join(dirpath,name)

#下载头像图片

urllib.request.urlretrieve(item['face_src'],filepath) # 爬虫结束时会调用此方法

def close_spider(self,spider):

print('爬虫结束')

self.fp.close()

scrapy框架学习(六)日志设置和数据存储的更多相关文章

- 自己的Scrapy框架学习之路

开始自己的Scrapy 框架学习之路. 一.Scrapy安装介绍 参考网上资料,先进行安装 使用pip来安装Scrapy 在开始菜单打开cmd命令行窗口执行如下命令即可 pip install Scr ...

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- scrapy框架学习之路

一.基础学习 - scrapy框架 介绍:大而全的爬虫组件. 安装: - Win: 下载:http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted pip3 ...

- Scrapy框架学习笔记

1.Scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网 ...

- scrapy框架学习

一.初窥Scrapy Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中. 其最初是为了 页面抓取 (更确切来说, 网 ...

- Scrapy框架学习参考资料

00.Python网络爬虫第三弹<爬取get请求的页面数据> 01.jupyter环境安装 02.Python网络爬虫第二弹<http和https协议> 03.Python网络 ...

- Python3 Scrapy 框架学习

1.安装scrapy 框架 windows 打开cmd输入 pip install Scrapy 2.新建一个项目: 比如这里我新建的项目名为first scrapy startproject fir ...

- Scrapy框架学习 - 使用内置的ImagesPipeline下载图片

需求分析需求:爬取斗鱼主播图片,并下载到本地 思路: 使用Fiddler抓包工具,抓取斗鱼手机APP中的接口使用Scrapy框架的ImagesPipeline实现图片下载ImagesPipeline实 ...

- Scrapy框架学习(一)Scrapy框架介绍

Scrapy框架的架构图如上. Scrapy中的数据流由引擎控制,数据流的过程如下: 1.Engine打开一个网站,找到处理该网站的Spider,并向该Spider请求第一个要爬取得URL. 2.En ...

- Scrapy 框架 安装 五大核心组件 settings 配置 管道存储

scrapy 框架的使用 博客: https://www.cnblogs.com/bobo-zhang/p/10561617.html 安装: pip install wheel 下载 Twisted ...

随机推荐

- ACR2022的辩论:DMARDs在pre-RA中的作用

ACR2022的辩论:DMARDs在pre-RA中的作用 2022年11月13日 亚临床RA在风湿病学实践中越来越常见:然而,目前尚不清楚如何管理这些患者,以及启动DMARD是否可以预防RA的发展 ...

- 如何调用别人的接口(包含get请求post请求)

对于如何调用第三方接口还是有些模糊,所以记录一下,上代码 package com.zhang.miaodou; import java.io.BufferedReader; import java.i ...

- CSS3,线性渐变(适用标题背景)

.test{ margin:200px auto; height:30px; border:1px #D4D4D4 solid; box-shadow:0 -1px 10px rgba(0,0,0,0 ...

- 41.Sentinel

Feign 整合 Sentinel 依赖 <!--Feign--> <dependency> <groupId>org.springframework.cloud& ...

- 常见的git操作

git branch 查看本地所有分支 git status 查看当前状态 git commit 提交 git branch -a查看所有的分支 git branch -r 查看远程所有分支 git ...

- gunicorn的功能及使用方法

一.gunicorn的简介Gunicorn是基于unix系统,被广泛应用的高性能的Python WSGI HTTP Server.用来解析HTTP请求的网关服务.它通常是在进行反向代理(如nginx) ...

- C++程序设计实验五 模板类与多态

三.实验内容 2. 实验任务2 Person.hpp: #ifndef PERSON_TASK_HPP #define PERSON_TASK_HPP #include<iostream> ...

- '大龄‘后端程序员,快速捡起ECMAScript6

1.Promise 2.迭代器 3.async 4.module 5. this的理解

- N63050 第二周运维作业

1.显示/etc目录下,以非字母开头,后面跟了一个字母以及其它任意长度任意字符的文件或目录 1 [root@centos8 etc]#touch 5a.txt 9a.txt 2 [root@cento ...

- 微信电脑版 v3.9.2.12 绿色便携版

修改历史: 2023.03.01:自改官方 3.9.2.12 最新正式版本2023.01.31:自改官方 3.9.0.28 最新正式版本2023.01.11:自改官方 3.9.0.21 最新正式版本- ...