Ⅱ Finite Markov Decision Processes

Dictum:

Is the true wisdom fortitude ambition. -- Napoleon

马尔可夫决策过程(Markov Decision Processes, MDPs)是一种对序列决策问题的解决工具,在这种问题中,决策者以序列方式与环境交互。

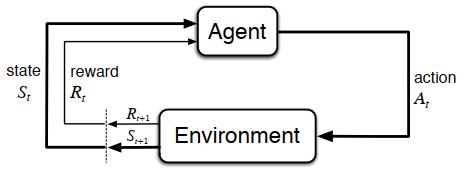

“智能体-环境”交互的过程

首先,将MDPs引入强化学习。我们可以将智能体和环境的交互过程看成关于离散情况下时间步长\(t(t=0,1,2,3,\ldots)\)的序列:\(S_0,A_0,R_1,S_1,A_1,R_2,S_2,A_2,R_3,\ldots\),可以定义动作空间\(\mathcal{S}\)为所有动作的集合,定义状态空间\(\mathcal{A}\)为所有状态的集合。

马尔可夫决策过程

马尔可夫性

当且仅当状态满足下列条件,则该状态具有马尔科夫性

\]

也就是说,未来状态只与当前状态有关,是独立于过去状态的。即当前状态捕获了所有历史状态的相关信息,是对未来状态的充分统计,因此只要当前状态已知,就历史状态就可以被丢弃。

动态特性

根据这个性质,我们可以写出状态转移概率\(\mathcal{P}_{ss^\prime}=\mathbb{P}[S_{t+1}=s^\prime\ |S_t=s]\)

由此可以得到状态转移矩阵\(\mathcal{P}\):

\begin{matrix}

to \\

\left[\begin{array}{rr}

\mathcal{P}_{11} & \cdots & \mathcal{P}_{1n} \\

\vdots & \ddots & \vdots \\

\mathcal{P}_{n1} & \cdots & \mathcal{P}_{nn} \\

\end{array}\right]

\end{matrix} \tag{2.2}

\]

(该矩阵中所有元素之和为1)

我们将函数\(p\)定义为MDP的动态特性,通常情况下\(p\)是一个包含四个参数的确定函数(\(p: \mathcal{S}\times\mathcal{A}\times\mathcal{S}\times\mathcal{R}\rightarrow[0,1]\)):

\]

或者,我们可以定义一个三个参数的状态转移概率\(p\)(\(p: \mathcal{S}\times\mathcal{S}\times\mathcal{A}\rightarrow[0,1]\)):

\]

由此,可以定义“状态-动作”二元组的期望奖励\(r(r:\mathcal{S}\times\mathcal{A}\rightarrow\mathbb{R})\):

\]

也可以定义“状态-动作-后继状态”三元组的期望奖励\(r(r:\mathcal{S}\times\mathcal{A}\times\mathcal{S}\rightarrow\mathbb{R})\):

\]

价值函数

回报

回报(Return)的定义式为

\]

\(\gamma\)被称为折扣率(discount rate)。当\(T= \infin\)且\(0 \le \gamma<1\)时,强化学习任务被称为连续任务(continuing tasks),当\(\gamma=1\)且\(T\ne\infin\)时,强化学习任务被称为幕式任务(episodic tasks)。

episodic tasks的智能体和环境的交互过程能够被拆分为一系列的子序列。在这类任务中,当时间步长\(t\)达到某个值\(T\)时,会产生终止状态(terminal state)。这种状态下,对于任意\(k>1,S_{T+k}=S_T=s\)恒成立,此时,\(T\)被称为终止时刻,它随着幕(episode)的变化而变化。从起始状态到达终止状态的每个子序列被称为幕。

策略

策略(Policy)\(\pi\)是状态到动作空间分布的映射

\]

它表示根据当前状态\(s\),执行动作\(a\)的概率。

状态价值函数

状态价值函数(State-value Function)\(v_\pi(s)\)定义为从状态\(s\)开始,执行策略\(\pi\)所获得的回报的期望值。

\]

动作价值函数

类似于公式\((2.9)\)的定义,将动作价值函数(Action-value Function)\(q_\pi(s,a)\)定义为在状态\(s\)时采取动作\(a\)后,所有可能的决策序列的期望回报。

\]

贝尔曼方程

贝尔曼方程(Bellman Euqation)是以等式的方式表示某一时刻价值与期后继时刻价值之间的递推关系。

下面给出状态价值函数\(v_\pi(s)\)的贝尔曼方程:

v_\pi(s)

& \doteq \mathbb{E}_\pi[G_t|S_t=s] \\

& =\mathbb{E}_\pi[R_{t+1}+ \gamma G_{t+1}|S_t=s] \\

& =\displaystyle \sum_a\pi(a|s) \sum_{s^\prime} \sum_rp(s^\prime,r|s,a)[r+\gamma \mathbb{E}_\pi[G_{t+1}|S_{t+1}=s^\prime]] \\

& =\displaystyle \sum_a\pi(a|s) \sum_{s^\prime.r} p(s^\prime,r|s,a) [r+\gamma v_\pi(s^\prime)]

\end{aligned} \tag{2.11}

\]

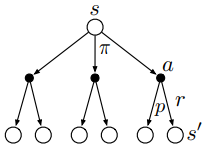

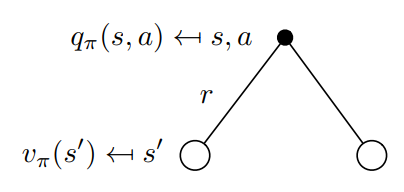

可以通过下面关于\(v_\pi(s)\)的回溯图(backup diagram)更好地理解上述方程,backup就是将价值信息从后继状态(或“状态-动作”二元组)转移到当前状态(或“状态-动作”二元组)。

在上图中,由上往下看,空心圆表示状态,实心圆表示“状态-动作”二元组。图中,从根节点状态\(s\)开始,智能体根据策略\(\pi\)采取动作集合中的任意动作,对于每个动作,环境会根据它的动态特性函数\(p\),给出奖励值\(r\)和后继状态\(s^\prime\)。

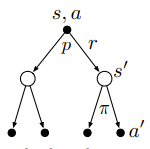

同样也可以通过\(q_\pi\)的回溯图得到它的贝尔曼方程(同时也给出推导过程):

q_\pi(s,a)

& \doteq \mathbb{E}_\pi[G_t|S_t=s,A_t=a] \\

& =\mathbb{E}_\pi[R_{t+1}|S_t=s,A_t=a]+ \gamma \mathbb{E}_\pi[G_{t+1}|S_t=s,A_t=a] \\

& =\displaystyle \sum_{s^\prime,r}p(s^\prime,r|s,a)r+ \gamma \sum_{s^\prime,r}p(s^\prime,r|s,a) \sum_{a^\prime}\pi(a^\prime|s^\prime) \mathbb{E}_\pi[G_{t+1}|S_{t+1}=s^\prime,A_{t+1}=a^\prime] \\

& =\displaystyle \sum_{s^\prime,r}p(s^\prime,r|s,a)[r+ \gamma \sum_{a^\prime}\pi(a^\prime|s^\prime)q_\pi(s^\prime,a^\prime)]

\end{aligned} \tag{2.12}

\]

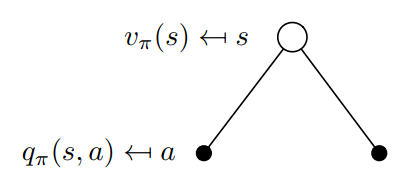

价值函数的相互转换

从定义的角度,我们更容易理解\(v_\pi(s)\)和\(q_\pi(s,a)\)的关系。我们可以将\(q_\pi(s,a)\)理解为执行策略后选取动作空间中一个动作所得到的价值函数,而将\(v_\pi(s)\)理解为执行策略后选择动作空间中所有动作所得到的价值函数。\(v_\pi\)其实就是\(q_\pi\)基于策略\(\pi\)的期望值,所以它们的关系转换如下:

\]

它的回溯图如下图所示:

也可以按照下面的回溯图写出状态价值函数到动作价值函数的转换:

\]

最优策略和最优价值函数

最优策略

智能体的目标就是找出一种策略,能够最大化它的长期奖励,这个策略就是最优策略(optimal policy),记作\(\pi_*\)。公式表示如下:

\]

也可以将上式的状态价值函数替换为动作价值函数,它们在寻找最优策略上是等价的。

最优价值函数

最优状态价值函数可以定义为

\]

\(v_*(s)\)的贝尔曼最优方程为

\]

最优动作价值函数可以定义为

\]

\(q_*(s,a)\)的贝尔曼最优方程为

\]

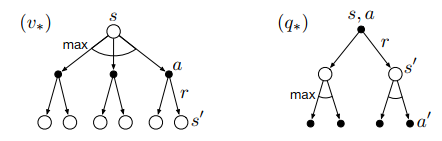

下图展示了\(v_*(s)\)和\(q_*(s,a)\)的贝尔曼最优方程的回溯图(弧线表示在给定策略下取最大值而不是期望值)

后续概念

强化学习的方法

强化学习方法可以分为基于模型的(model-based)和不基于模型的(model-free),二者之间的区别在于是否有完备的环境知识,若存在MDP中的状态转移概率矩阵\(\mathcal{P}\),且能得到相应的奖励\(\mathcal{R}\),则是基于模型的;否则,是不基于模型的。

强化学习的问题

一般来说,强化学习问题可以分为两步:一、预测问题——给定强化学习的相关要素,评估价值函数;二、控制问题——求解最优价值函数和最优策略。

FAQ

- Q:如果当前状态是\(S_t\),并根据随机策略\(\pi\)选择动作,那么如何用\(\pi\)和四参数\(p\)表示\(R_{t+1}\)的期望?

A:\(\mathbb{E}_\pi[R_{t+1}|S_t=s]=\displaystyle \sum_a\pi(a|s) \sum_{s^\prime,r}rp(s^\prime,r|s,a)\)

References

Richard S. Sutton and Andrew G. Barto. Reinforcement Learning: An Introduction (Second Edition). 2018.

Csaba Szepesvári. Algorithms for Reinforcement Learning. 2009.

Course: UCL Reinforcement Learning Course (by David Silver)

Ⅱ Finite Markov Decision Processes的更多相关文章

- Markov Decision Processes

为了实现某篇论文中的算法,得先学习下马尔可夫决策过程~ 1. https://leonardoaraujosantos.gitbooks.io/artificial-inteligence/conte ...

- Step-by-step from Markov Process to Markov Decision Process

In this post, I will illustrate Markov Property, Markov Reward Process and finally Markov Decision P ...

- Markov Decision Process in Detail

From the last post about MDP, we know the environment consists of 5 basic elements: S:State Space of ...

- 强化学习二:Markov Processes

一.前言 在第一章强化学习简介中,我们提到强化学习过程可以看做一系列的state.reward.action的组合.本章我们将要介绍马尔科夫决策过程(Markov Decision Processes ...

- 《Network Security A Decision and Game Theoretic Approach》阅读笔记

网络安全问题的背景 网络安全研究的内容包括很多方面,作者形象比喻为盲人摸象,不同领域的网络安全专家对网络安全的认识是不同的. For researchers in the field of crypt ...

- Multi-shot Pedestrian Re-identification via Sequential Decision Making

Multi-shot Pedestrian Re-identification via Sequential Decision Making 2019-07-31 20:33:37 Paper: ht ...

- POMDP

本文转自:http://www.pomdp.org/ 一.Background on POMDPs We assume that the reader is familiar with the val ...

- MR for Baum-Welch algorithm

The Baum-Welch algorithm is commonly used for training a Hidden Markov Model because of its superior ...

- Machine Learning and Data Mining(机器学习与数据挖掘)

Problems[show] Classification Clustering Regression Anomaly detection Association rules Reinforcemen ...

随机推荐

- Skywalking Php注册不上问题排查

Skywalking是一款分布式追踪应用,具体介绍可以参考 skywalking. 最近公司的一个Php应用在Skywalking后台查不到数据了: 登录到某台服务器上发现注册不上,启动时就报错了: ...

- CPF 入门教程 - 绘图(四)

CPF NetCore跨平台UI框架,增加了Vlc支持跨平台播放视频. 系列教程 CPF 入门教程(一) CPF 入门教程 - 数据绑定和命令绑定(二) CPF 入门教程 - 样式和动画(三) CPF ...

- JS实现简单的多选选项的全选反选按钮

1 <!DOCTYPE html> 2 <html> 3 <head lang="en"> 4 <!-- 5 需求: 6 1.写三个按钮: ...

- 论文阅读笔记: Multi-Perspective Sentence Similarity Modeling with Convolution Neural Networks

论文概况 Multi-Perspective Sentence Similarity Modeling with Convolution Neural Networks是处理比较两个句子相似度的问题, ...

- Linux 虚拟机绑定静态 IP

环境介绍 Machine: NUC8i5BEK OS: macOS Catalina 10.15.6 VirtualBox: 6.1.12 r139181 (Qt5.6.3) CentOS: 8.2. ...

- 2020 Java开发者数据分析:中国已成为 Java 第一大国

最近知名开发工具供应商Jetbrains在Java 25周年之际,对开发群体做了一次有意思的数据分析. 全文内容可见:https://blog.jetbrains.com/idea/2020/09/a ...

- FastReport.Mono添加了新的条形码ITF-14

FastReport.Mono 是一款为Mono Framework设计的功能全面的报表生成工具.FastReport.Mono 是一个多平台的报表解决方法.它可以应用于Windows, Linux, ...

- 音频数据增强及python实现

博客作者:凌逆战 博客地址:https://www.cnblogs.com/LXP-Never/p/13404523.html 音频时域波形具有以下特征:音调,响度,质量.我们在进行数据增强时,最好只 ...

- 【题解】[JSOI2007]字符加密

Link \(\text{Solution:}\) 后缀数组第一题祭-- 观察一下,这个是让求一个环形的原字符串的后缀,我们可以考虑一下断环为链. 对于\(aba\)我们扩展成\(abaaba,\)则 ...

- 从零开始针对 .NET 应用的 DevOps 运营实践 - 运行环境搭建

一.Overview 最近的一段时间,在公司里我都在进行基于 Jenkins 和 SonarQube 配合已有的 Gitlab 搭建部门的持续集成环境的工作,虽然之前有使用过 GitHub Actio ...