CoreML 简单使用

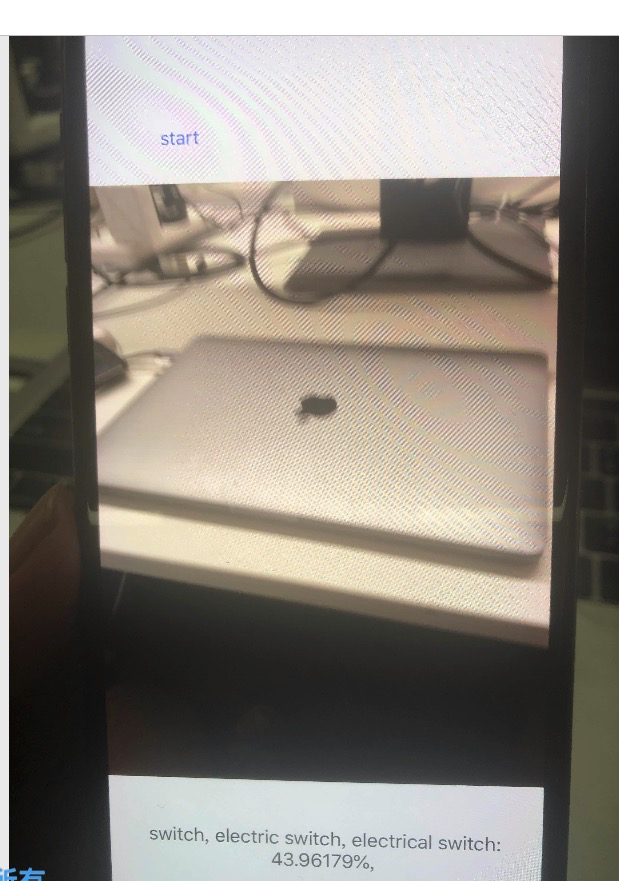

今天简单使用了下CoreML , 我的这个模型功能主要是 打开摄像头,然后对准物体,会自动帮我们识别摄像头中的物体,并且给我们大概的百分比值

代码如下:

@IBAction func startClick(_ sender: Any) {

startFlag = !startFlag

if startFlag {

startCaptureVideo()

startButton.setTitle("stop", for: .normal)

}else {

startButton.setTitle("start", for: .normal)

stop()

}

}

//1、初始化CaptureSeason

lazy var captureSession:AVCaptureSession? = {

//1.1 实例化

let captureSession = AVCaptureSession()

captureSession.sessionPreset = .photo

//1.2 获取默认设备

guard let captureDevice = AVCaptureDevice.default(for: .video) else {

return nil

}

guard let captureDeviceInput = try? AVCaptureDeviceInput(device: captureDevice) else {

return nil

}

captureSession.addInput(captureDeviceInput)

let previewLayer = AVCaptureVideoPreviewLayer(session: captureSession)

view.layer.addSublayer(previewLayer)

previewLayer.frame = view.frame

let dataOutput = AVCaptureVideoDataOutput()

dataOutput.setSampleBufferDelegate(self, queue: DispatchQueue(label: "kingboVision"))

captureSession.addOutput(dataOutput)

return captureSession

}()

func startCaptureVideo(){

captureSession?.startRunning()

}

func stop() {

captureSession?.stopRunning()

}

func captureOutput(_ output: AVCaptureOutput, didOutput sampleBuffer: CMSampleBuffer, from connection: AVCaptureConnection) {

print("Camera was safe ")

guard let pixelBuffer:CVPixelBuffer = CMSampleBufferGetImageBuffer(sampleBuffer) else

{

print("nil object ")

return

}

guard let model = try? VNCoreMLModel(for: SqueezeNet().model) else {return}

let request = VNCoreMLRequest(model: model) { [unowned self](finishRequest, error) in

//

guard let results = finishRequest.results as? [VNClassificationObservation] else {

return

}

guard let first = results.first else {

return

}

DispatchQueue.main.async {

self.descriptionLabel.text = "\(first.identifier): \(first.confidence * 100)%,"

}

}

print("start to VN")

try? VNImageRequestHandler(cvPixelBuffer: pixelBuffer, options: [:]).perform([request])

}

分为以下几步操作

1、我们工程inf.plist 文件中添加摄像头权限说明

Privacy - Camera Usage Description 相机权限设置 Privacy - Microphone Usage Description 麦克风权限设置

2、头文件引用

import AVKit

import Vision

3、准备模型

模型准备我这里是使用App 官网上的SqueezeNet模型

4、将模型拖动到工程里面即可

5、代码编写部分

5.1 初始化AVCaptureSession

let captureSession = AVCaptureSession()

captureSession.sessionPreset = .photo

5.2 获取当前iPhone 设备控制,当作输入数据来源

guard let captureDevice = AVCaptureDevice.default(for: .video) else {

return nil

}

captureSession.addInput(captureDeviceInput)

5.3 设置输出数据

//设置输出数据处理对象

let dataOutput = AVCaptureVideoDataOutput()

dataOutput.setSampleBufferDelegate(self, queue: DispatchQueue(label: "kingboVision"))

captureSession.addOutput(dataOutput)

AVCaptureVideoDataOutput 设置代理,处理数据流图片数据,因此当前ViewController需要实现AVCaptureVideoDataOutputSampleBufferDelegate 的代理,如下

class ViewController: UIViewController ,AVCaptureVideoDataOutputSampleBufferDelegate{

......

func captureOutput(_ output: AVCaptureOutput, didOutput sampleBuffer: CMSampleBuffer, from connection: AVCaptureConnection) {

//将视频数据转成CVPixBuffer

guard let pixelBuffer:CVPixelBuffer = CMSampleBufferGetImageBuffer(sampleBuffer) else

{

print("nil object ")

return

}

// 这里SquzzedNet是我从苹果中直接获取的模型

guard let model = try? VNCoreMLModel(for: SqueezeNet().model) else {return}

let request = VNCoreMLRequest(model: model) { [unowned self](finishRequest, error) in

//处理数据分析进行业务处理

guard let results = finishRequest.results as? [VNClassificationObservation] else {

return

}

guard let first = results.first else {

return

}

DispatchQueue.main.async {

self.descriptionLabel.text = "\(first.identifier): \(first.confidence * 100)%,"

}

}

print("start to VN")

try? VNImageRequestHandler(cvPixelBuffer: pixelBuffer, options: [:]).perform([request])

}

.....

}

5.4 将当前的摄像头显示在指定的View 上,(我们这里使用当前VC 的view)

let previewLayer = AVCaptureVideoPreviewLayer(session: captureSession)

view.layer.addSublayer(previewLayer)

previewLayer.frame = view.frame

效果如下:

CoreML 简单使用的更多相关文章

- CoreML试水--图片识别

今年的WWDC上,关于人工智能方面Apple开放了CoreML工具包. 今天就趁着时间还早果断的尝试了一下到底有多容易. import UIKit import CoreML import Visio ...

- Unity AR Foundation 和 CoreML: 实现手部的检测和追踪

0x00 前言 Unity的AR Foundation通过上层抽象,对ARKit和ARCore这些底层接口进行了封装,从而实现了AR项目的跨平台开发能力. 而苹果的CoreML是一个可以用来将机器学习 ...

- iOS11 SDK 新特性 CoreML 及swift 小demo

github代码 如果本博客对您有帮助,希望可以得到您的赞赏! swift 机器学习Core ML的简单调用小demo.完整代码附上: https://github.com/Liuyubao/LYBC ...

- coreml之通过URL加载模型

在xcode中使用mlmodel模型,之前说的最简单的方法是将模型拖进工程中即可,xcode会自动生成有关模型的前向预测接口,这种方式非常简单,但是更新模型就很不方便. 今天说下另外一种通过URL加载 ...

- Mac mini M1使用简单体验(编程、游戏、深度学习)

好久不见了各位! 前一阵子忍不住剁手买了M1芯片的mac mini,为了弥补自己的内疚感就卖了自己的旧的mbp2017款.数据也完全迁移到了新机器上,之前的工作也就由mbp2017彻底换成mac mi ...

- 【造轮子】打造一个简单的万能Excel读写工具

大家工作或者平时是不是经常遇到要读写一些简单格式的Excel? shit!~很蛋疼,因为之前吹牛,就搞了个这东西,还算是挺实用,和大家分享下. 厌烦了每次搞简单类型的Excel读写?不怕~来,喜欢流式 ...

- Fabio 安装和简单使用

Fabio(Go 语言):https://github.com/eBay/fabio Fabio 是一个快速.现代.zero-conf 负载均衡 HTTP(S) 路由器,用于部署 Consul 管理的 ...

- node.js学习(三)简单的node程序&&模块简单使用&&commonJS规范&&深入理解模块原理

一.一个简单的node程序 1.新建一个txt文件 2.修改后缀 修改之后会弹出这个,点击"是" 3.运行test.js 源文件 使用node.js运行之后的. 如果该路径下没有该 ...

- 哪种缓存效果高?开源一个简单的缓存组件j2cache

背景 现在的web系统已经越来越多的应用缓存技术,而且缓存技术确实是能实足的增强系统性能的.我在项目中也开始接触一些缓存的需求. 开始简单的就用jvm(java托管内存)来做缓存,这样对于单个应用服务 ...

随机推荐

- Quick BI功能篇之(一):20分钟入门

前言: 最近小编帮助隔壁团队一个小姐姐解决了个大难题:给老板汇报业绩分析,频次提高.效率提升,还得保证团队中的小伙伴们都得有点大数据时代的基本数据能力.小编觉得这么好的经验可以分享给更多志同道合的朋友 ...

- 配置Tomcat-8.5 JVM内存参数

配置Tomcat-8.5 JVM内存参数 apache-tomcat-8.5与之前的版本存在些许差异,配置方式有所改变,并且针对JVM一些参数不再支持.故本文档主要简介一下如何在apache-tomc ...

- JVM内核-原理、诊断与优化学习笔记(一):初识JVM

文章目录 JVM的概念 JVM是Java Virtual Machine的简称.意为Java虚拟机 虚拟机 有哪些虚拟机 VMWare或者Visual Box都是使用软件模拟物理CPU的指令集 JVM ...

- Spring源码由浅入深系列四 创建BeanFactory

继上一章refresh之后,上图描述了obtainFreshBeanFactory过程.

- UVA 240 Variable Radix Huffman Encoding

题目链接:https://vjudge.net/problem/UVA-240 题目大意 哈夫曼编码是一种最优编码方法.根据已知源字母表中字符出现的频率,将源字母表中字符编码为目标字母表中字符,最优的 ...

- error C1083: 无法打开包括文件: “ui_roadquery.h”: No such file or directory c:\users\administrator\desktop\g_w_j\04 开发阶段\开发工程\imcshowapp\imcshowapp\roadquery.h 5 1 IMCShowApp

1.我这里出现的原因是忘记将项目文件添加进入项目中,在项目中右击添加即可

- 使用SDK方式进行微信授权

1.在pom.xml中添加依赖 <dependency> <groupId>com.github.binarywang</groupId> <artifact ...

- 转——调试寄存器 原理与使用:DR0-DR7

下面介绍的知识性信息来自intel IA-32手册(可以在intel的开发手册或者官方网站查到),提示和补充来自学习调试器实现时的总结. 希望能给你带去有用的信息. (DRx对应任意的一个调试寄存器. ...

- linux 下安装maven私服

1.下载最新nexus安装包 下载地址:https://www.sonatype.com/download-oss-sonatype 2.下载JDK7,nexus2版本支持JDK7:nexus1版本支 ...

- flink widow&window funcion&水印

在定义了窗口分配器之后,我们需要为每一个窗口明确的指定计算逻辑,这个就是窗口函数要做的事情, 当系统决定一个窗口已经准备好执行之后,这个窗口函数将被用来处理窗口中的每一个元素(可能是 分组的). 谁可 ...