【Java爬虫】爬取南通大学教务处成绩

没使用自动登录,所以获取是比较麻烦。。

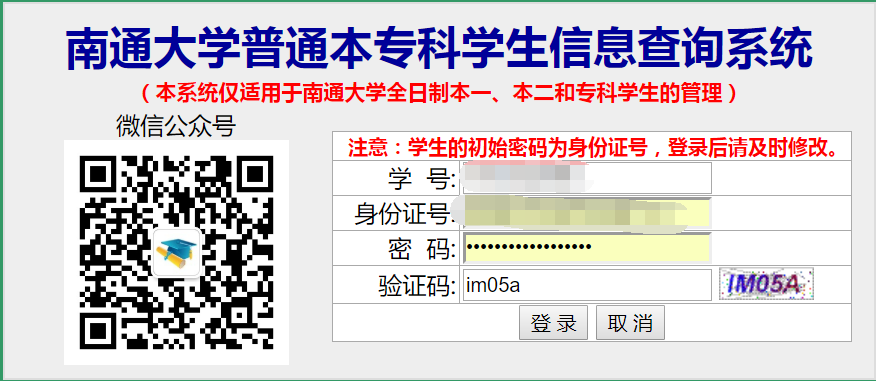

1、http://jwgl.ntu.edu.cn/cjcx 进入官网,进行账号密码登录

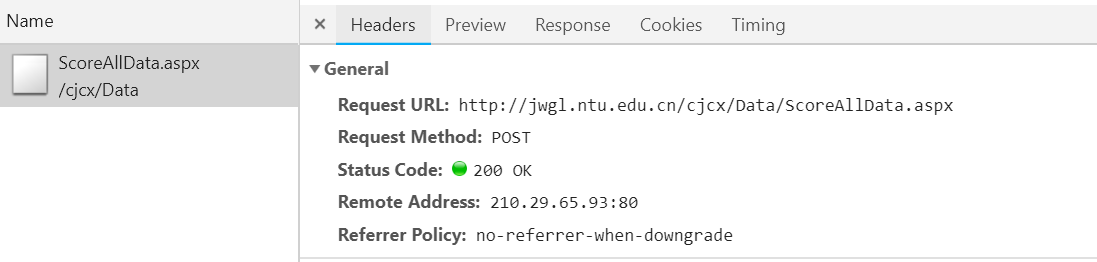

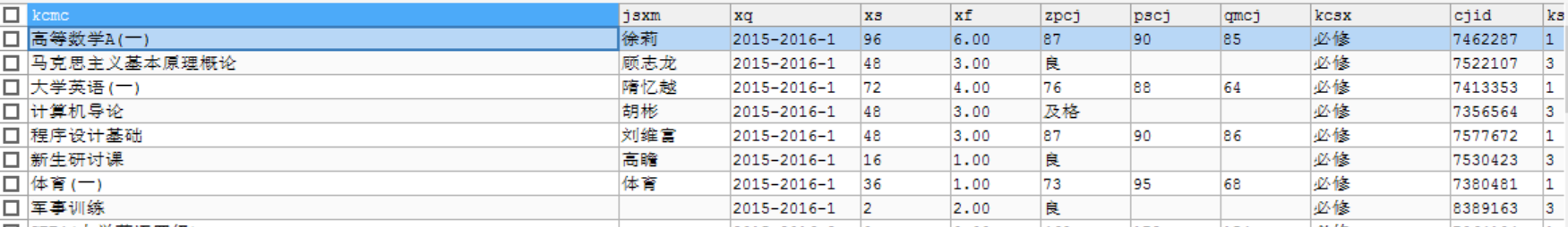

2、点击全部成绩查询(也一定要点进去,不然cookie不会返回值),按F12进入控制台,找到Network,看到了ScoreAllData.aspx

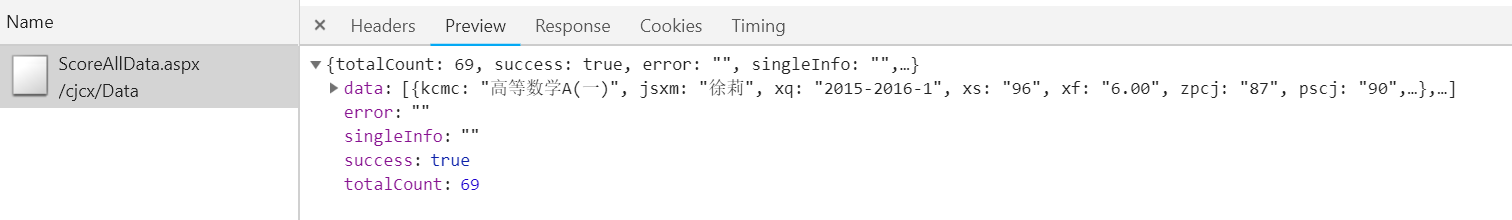

首先看到Response中能看到返回的json数据,证明我们url找对了。。

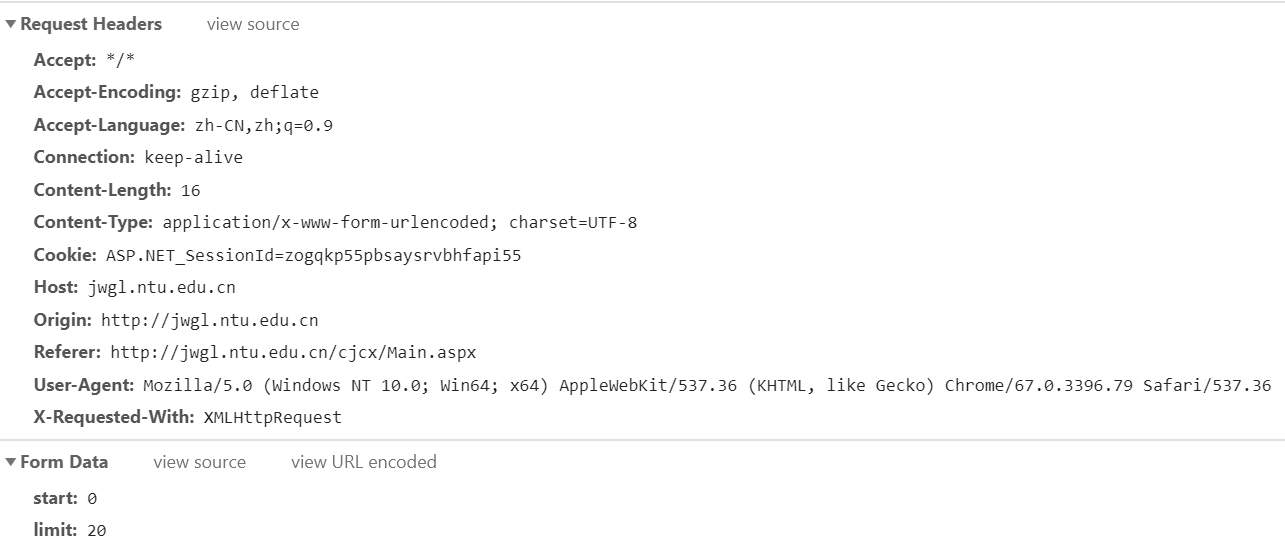

接下来我们需要看request中的数据

可以看到form data中的start和limit,经过测试,我发现limit只有一个20的值,但是start是可以改变的,所以说换页的时候需要更改start的数据。

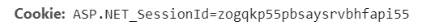

还有cookie,登录信息的数据是存在cookie里的(应该是),

获取这个Id的值,用来使用jsoup爬取数据。

3、下面放代码,再进行分析(代码运行的时候,浏览器页面不要关闭,因为是从cookie获取的值,浏览器一关,cookie就 GG)

package com; import java.io.IOException;

import java.sql.SQLException;

import java.util.ArrayList;

import java.util.List; import org.apache.commons.dbutils.QueryRunner;

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document; import com.edu.utils.DruidUtils;

import com.google.gson.Gson;

import com.google.gson.reflect.TypeToken; import net.sf.json.JSONArray;

import net.sf.json.JSONObject; public class Post {

public static void main(String[] args) throws SQLException {

List<Score> scoreList = new ArrayList<>();

try {

scoreList = post(scoreList);

QueryRunner qr = new QueryRunner(DruidUtils.getDatasource());

String sql = "insert into score values(?,?,?,?,?,?,?,?,?,?,?,?)";

for(Score s:scoreList) {

qr.update(sql,s.getKcmc(),s.getJsxm(),s.getXq(),s.getXs(),s.getXf(),s.getZpcj(),s.getPscj(),s.getQmcj(),s.getKcsx(),s.getCjid(),s.getKsfsm(),s.getPxcj());

}

} catch (IOException e) {

e.printStackTrace();

}

} public static List<Score> post(List<Score> scoreList) throws IOException {

// 获取请求连接

Connection con = Jsoup.connect("http://jwgl.ntu.edu.cn/cjcx/Data/ScoreAllData.aspx")

.cookie("ASP.NET_SessionId","zogqkp55pbsaysrvbhfapi55")

.referrer("http://jwgl.ntu.edu.cn/cjcx/Main.aspx")

.ignoreContentType(true)

.userAgent(

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.79 Safari/537.36");

Document doc = con.post();

JSONObject jsonObject = JSONObject.fromObject(doc.body().text());

Integer count = (Integer) jsonObject.get("totalCount");

for(int i=0;i<count;i+=20) {

con = Jsoup.connect("http://jwgl.ntu.edu.cn/cjcx/Data/ScoreAllData.aspx")

.cookie("ASP.NET_SessionId","zogqkp55pbsaysrvbhfapi55")

.referrer("http://jwgl.ntu.edu.cn/cjcx/Main.aspx")

.ignoreContentType(true)

.userAgent(

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.79 Safari/537.36");

con.data("start",String.valueOf(i));

con.data("limit","20");

Document scores = con.post();

JSONObject scoresObject = JSONObject.fromObject(scores.body().text());

JSONArray jsonArray = scoresObject.getJSONArray("data");

Gson g = new Gson();

List<Score> ps = g.fromJson(jsonArray.toString(), new TypeToken<List<Score>>(){}.getType());

if(ps!=null) {

scoreList.addAll(ps);

}

}

return scoreList;

}

}

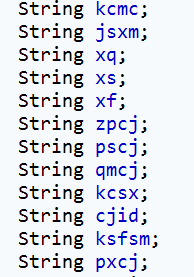

Score类是返回data的实体类,用来封装数据。

通过post方法进行数据的爬取,在Connection对象里进行cookie,userAgent等数据的封装,注意这个cookie里的值是第二步中从控制台获取到cookie值。

使用JsonObject和Gson进行数据的封装,然后再把数据存入本地数据库中。

4、在JSP中显示或者导出到Excel

(有空再写)

【Java爬虫】爬取南通大学教务处成绩的更多相关文章

- [python爬虫]爬取学校教务处成绩

学校教务处网站 登陆窗口 表单数据 观察登陆窗口和提交的表单数据可知只要将账号.密码.验证码正确赋值提交即可模拟登陆. 账号和密码都有,问题的关键就在验证码上. 右键验证码图片审查观察源码如下图: 刚 ...

- 一个简单java爬虫爬取网页中邮箱并保存

此代码为一十分简单网络爬虫,仅供娱乐之用. java代码如下: package tool; import java.io.BufferedReader; import java.io.File; im ...

- Java爬虫爬取网站电影下载链接

之前有看过一段时间爬虫,了解了爬虫的原理,以及一些实现的方法,本项目完成于半年前,一直放在那里,现在和大家分享出来. 网络爬虫简单的原理就是把程序想象成为一个小虫子,一旦进去了一个大门,这个小虫子就像 ...

- java爬虫爬取的html内容中空格( )变为问号“?”的解决方法

用java编写的爬虫,使用xpath爬取内容后,发现网页源码中的 全部显示为?(问号),但是使用字符串的replace("?", ""),并不能替换,网上找了一 ...

- java爬虫爬取网页内容前,对网页内容的编码格式进行判断的方式

近日在做爬虫功能,爬取网页内容,然后对内容进行语义分析,最后对网页打标签,从而判断访问该网页的用户的属性. 在爬取内容时,遇到乱码问题.故需对网页内容编码格式做判断,方式大体分为三种:一.从heade ...

- java爬虫爬取资源,小白必须会的入门代码块

java作为目前最火的语言之一,他的实用性也在被无数的java语言爱好者逐渐的开发,目前比较流行的爬取资源,用java来做也更简单一些,下面是爬取网页上所有手机型号,参数等极为简便的数据 packag ...

- 用Java爬虫爬取凤凰财经提供的沪深A股所有股票代号名称

要爬取的凤凰财经网址:http://app.finance.ifeng.com/list/stock.php?t=hs 本作主要采用的技术是jsoup,相关介绍网页:https://www.jians ...

- java爬虫爬取https协议的网站时,SSL报错, java.lang.IllegalArgumentException TSLv1.2 报错

目前在广州一家小公司实习,这里的学习环境还是挺好的,今天公司从业十几年的大佬让我检查一下几年前的爬虫程序是否还能使用…… 我从myeclipse上check out了大佬的程序,放到workspace ...

- Java爬虫爬取京东商品信息

以下内容转载于<https://www.cnblogs.com/zhuangbiing/p/9194994.html>,在此仅供学习借鉴只用. Maven地址 <dependency ...

随机推荐

- JVM 内存模型及垃圾回收

java内存模型 根据 JVM 规范,JVM 内存共分为虚拟机栈.堆.方法区.程序计数器.本地方法栈五个部分. 程序计数器:程序计数器是指CPU中的寄存器,它保存的是程序当前执行的指令的地址(也可以说 ...

- 16.ajax_case05

# 抓取36氪快讯 # https://36kr.com/newsflashes import requests import json header = { 'Accept': 'text/html ...

- 阿里云香港ECS搭建Shadowscoks

注(转https://yijingping.github.io/2016/11/29/fanqiang.html) 1 为什么FQ 作为一个技术人员, 最常用的就是Google.StackOverfl ...

- C++: Basic knowledge Part 1

1.在 C++ 程序中调用被 C 编译器编译后的函数,为什么要加 extern “C”? 首先,extern 是 C/C++ 语言中表明函数和全局变量作用范围的关键字,该关键字告诉编译器,其声明的函数 ...

- 转载别人的ftp,觉得目录结构不错,学习

开发简单的FTP:1. 用户登陆2. 上传/下载文件3. 不同用户家目录不同4. 查看当前目录下文件5. 充分使用面向对象知识 REDMAE 1 用户登陆 2 3 1.查看用户目录文件 4 2.上传文 ...

- Java监控工具介绍,VisualVm ,JProfiler,Perfino,Yourkit,Perf4J,JProbe,Java微基准测试【转】

Java监控工具介绍,VisualVm ,JProfiler,Perfino,Yourkit,Perf4J,JProbe,Java微基准测试[转] 本文是本人前一段时间做一个简单Java监控工具调研总 ...

- 理清Java中try-catch-finally带return的执行顺序

前言:try-catch-finally带return和异常时,它们之间执行顺序问题是留下来的一个小疑问,今天搞清楚它们 第一种情况:无异常 //1.try-catch-finally都带有retur ...

- Ubuntu GitHub操作——分支、合并与标签

分支 分支是用来将特性开发绝缘开来的.在你创建仓库的时候,master 是"默认的"分支.在其他分支上进行开发,完成后再将它们合并到主分支上. 创建一个叫做"featur ...

- springboot下slf4j配置

我们在引用的时候直接写 private static final Logger logger = LoggerFactory.getLogger(XXXServiceImpl.class); log. ...

- 微信支付URL编解码小方法

--> 打开chrome --> F12或Fn+F12打开控制台 --> encodeURIComponent("url") --> 回车