使用nodejs爬前程无忧前端技能排行(半半成品)

最近准备换工作,需要更新一下技能树。为做到有的放矢,想对招聘方的要求做个统计。正好之前了解过nodejs,所以做了个爬虫搜索数据。

具体步骤:

1. 先用fiddler分析请求需要的header和body。

2. 再用superagent构建上述数据发送客户端请求。

3. 最后对返回的数据使用cheerio整理。

折腾了几个晚上,只搞出了个架子,剩余工作等有时间再继续开发。

/*使用fiddler抓包,需要配置lan代理,且设置如下参数*/

process.env.https_proxy = "http://127.0.0.1:8888";

process.env.http_proxy = "http://127.0.0.1:8888";

process.env.NODE_TLS_REJECT_UNAUTHORIZED = "0"; /*使用到的模块*/

var request = require('superagent'); //发送客户端请求

require('superagent-proxy')(request); //使用代理发送请求

var cheerio = require('cheerio'); //以jq类似的方法操作返回的字符,不需要用正则

require('superagent-charset')(request);//node不支持gbk,gb2312,this will add request.Request.prototype.charset.

var async = require('async'); //异步流控制模块

var fs = require('fs'); /*相关参数,通过fiddler抓包后复制过来*/

var ws = fs.createWriteStream('res.html',{flags:'w+'}); //a+追加的读写模式,w+覆盖

var loginUrl = "https://login.51job.com/login.php";

var searchUrl = "http://search.51job.com/jobsearch/search_result.php";

var queryStrings = "fromJs=1&jobarea=020000&keyword=%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91&keywordtype=2&lang=c&stype=2&postchannel=0000&fromType=1&confirmdate=9";

var loginForms = {

lang: 'c',

action: 'save',

from_domain: 'i',

loginname: '***', //自己的用户名和密码

password: '***',

verifycode: '',

isread: 'on'

};

var searchForms = {

lang: 'c',

stype: '2',

postchannel: '0000',

fromType: '1',

line: '',

confirmdate: '9',

from: '',

keywordtype: '2',

keyword: '%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91',

jobarea: '020000',

industrytype: '',

funtype: ''

};

var searchFormsString='lang=c&stype=2&postchannel=0000&fromType=1&line=&confirmdate=9&from=&keywordtype=2&keyword=%C7%B0%B6%CB%BF%AA%B7%A2&jobarea=020000&industrytype=&funtype=';

var proxy0 = process.env.https_proxy;

var proxy = process.env.http_proxy; const agent = request.agent(); //agent()方法产生的实例会保存cookie供后续使用

request.post(loginUrl).proxy(proxy0).send(loginForms).end(function (err,res0) {

agent.post(searchUrl)

.proxy(proxy) //proxy()方法需紧跟在method方法之后调用,否则fiddler抓不到数据包

.type('application/x-www-form-urlencoded')

.query(queryStrings) //使用字符串格式

.send(searchFormsString)

.charset('gbk') //通过charset可知编码字符格式,不设置会有乱码

.end(function (err, res) {

/* 以下是处理返回数据的逻辑代码*/

var $ = cheerio.load(res.text); //res.text是返回的报文主体

async.each($('.el.title').nextAll('.el'), function(v, callback) {

//将多余的内容删除,保留岗位、公司链接

$(v).prepend($(v).find('.t1 a'));

$(v).find('.t1').remove();

ws.write($.html(v), 'utf8');

}, function(err) {

console.log(err);

});

console.log('successful');

})

}); //jquery内置document元素为root,cheerio需要通过load方法传入,然后用选择器查找指定元素,再执行相应操作。

// $.html(el);静态方法,返回el元素的outerHtml

//TODO

// 1.当前只请求到一页数据,还需构建所有页数的请求列表

// 2.向每条数据的岗位链接发送请求,获取技能关键字,存入文件中

// 3.node中io操作是异步的,且没有锁的概念,如何并发地向同一个文件正确地写入数据

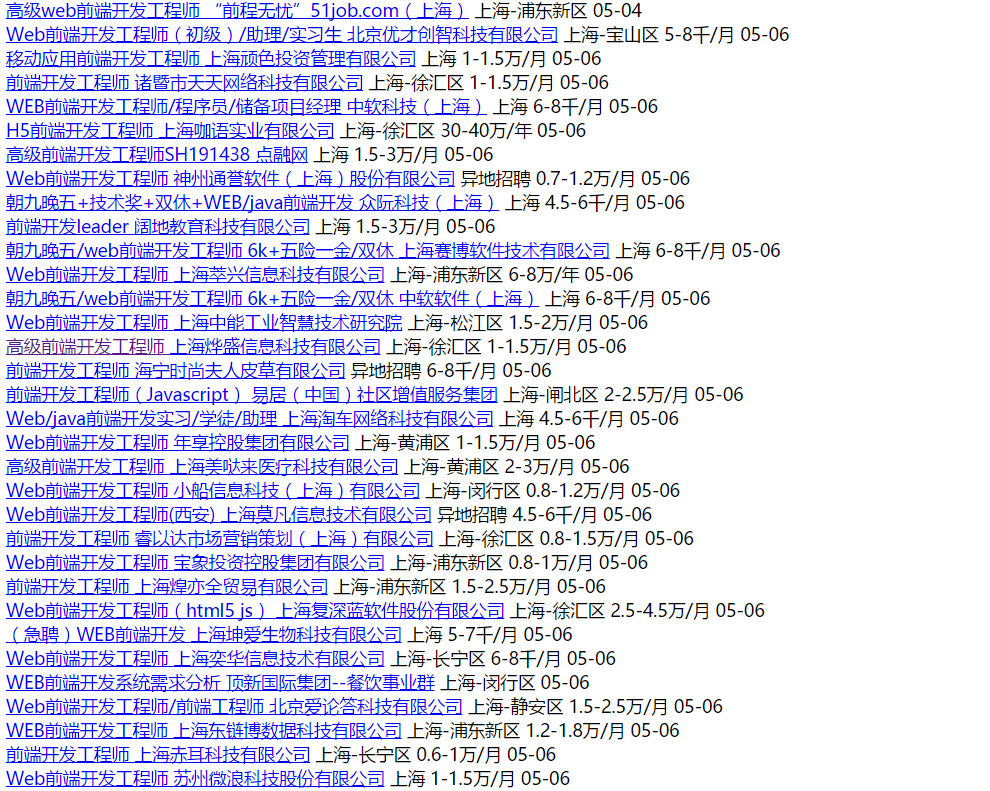

结果显示如下:

使用nodejs爬前程无忧前端技能排行(半半成品)的更多相关文章

- vue+node+mongoDB火车票H5(七)-- nodejs 爬12306查票接口

菜鸟一枚,业余一直想做个火车票查票的H5,前端页面什么的已经写好了,node+mongoDB 也写了一个车站的接口,但 接下来的爬12306获取车次信息数据一直卡住,网上的爬12306的大部分是pyt ...

- 爬取豆瓣电影排行top250

功能描述V1.0: 爬取豆瓣电影排行top250 功能分析: 使用的库 1.time 2.json 3.requests 4.BuautifulSoup 5.RequestException 上机实验 ...

- 【nodeJS爬虫】前端爬虫系列

写这篇 blog 其实一开始我是拒绝的,因为爬虫爬的就是cnblog博客园.搞不好编辑看到了就把我的账号给封了:). 言归正传,前端同学可能向来对爬虫不是很感冒,觉得爬虫需要用偏后端的语言,诸如 ph ...

- 京东前端:PhantomJS 和NodeJS在网站前端监控平台的最佳实践

1. 为什么需要一个前端监控系统 通常在一个大型的 Web 项目中有很多监控系统,比如后端的服务 API 监控,接口存活.调用.延迟等监控,这些一般都用来监控后台接口数据层面的信息.而且对于大型网站系 ...

- 使用nodejs爬取拉勾苏州和上海的.NET职位信息

最近开始找工作,本人苏州,面了几家都没有结果很是伤心.在拉勾上按照城市苏州关键字.NET来搜索一共才80来个职位,再用薪水一过滤,基本上没几个能投了.再加上最近苏州的房价蹭蹭的长,房贷压力也是非常大, ...

- Web前端技能

入门必备的技能: 第1项技能:HTML超文本标记语言: 技能要点: HTML文件的结构 HTML文件的编写方法 HTML基本标记 文字与段落标记 框架 使用表单 ...

- 前端技能汇总 Frontend Knowledge Structure

Frontend Knowledge Structure 项目起源 还记得@jayli 的这幅前端知识结构图么. 图片的形式具有诸多的不便.缺失源图的我们,无法为此图贡献些什么,随着时间的迁移,或许有 ...

- 从事web前端两年半后的迷茫

做了两年半的重构,突然有种迷茫的感觉,好像瓶颈了,不知道自己该怎么继续走下去,以前刚毕业的时候,总觉得自己有好多的东西要学在前端方面,所以有那个促使自己去学习的动力,每当没工作任务的时候,自己总是去主 ...

- 使用nodejs爬取和讯网高管增减持数据

为了抓取和讯网高管增减持的数据,首先得分析一下数据的来源: 网址: http://stockdata.stock.hexun.com/ggzjc/history.shtml 使用chrome开发者工具 ...

随机推荐

- SSH程序框架的整合(1)

spring整合hibernate 有两种方式 1.注解方式 2.xml方式实现 Spring整合Hibernate有什么好处? 1.由IOC容器来管理Hibernate的SessionFactory ...

- 老李推荐:第14章6节《MonkeyRunner源码剖析》 HierarchyViewer实现原理-装备ViewServer-启动ViewServer

老李推荐:第14章6节<MonkeyRunner源码剖析> HierarchyViewer实现原理-装备ViewServer-启动ViewServer poptest是国内唯一一家培养 ...

- 老李推荐:第14章1节《MonkeyRunner源码剖析》 HierarchyViewer实现原理-面向控件编程VS面向坐标编程

老李推荐:第14章1节<MonkeyRunner源码剖析> HierarchyViewer实现原理-面向控件编程VS面向坐标编程 poptest是国内唯一一家培养测试开发工程师的培训机 ...

- Best Time to Buy and Sell Stock系列

I题 Say you have an array for which the ith element is the price of a given stock on day i. If you we ...

- AVL树的旋转操作详解

[0]README 0.0) 本文部分idea 转自:http://blog.csdn.net/collonn/article/details/20128205 0.1) 本文仅针对性地分析AVL树的 ...

- firefox上安装selenium ide失败

Selenium 初学者第一步: 最近在学习selenium,但是在安装的时候遇到了问题.我是直接在firefox安装的Selenium IDE ,虽然下载安装之后存在于扩展中,但是工具栏里并没有显示 ...

- Java使用递归找出某目录下的所有子目录以及子文件

/* 使用递归找出某目录("C:\\JavaProducts")下的所有子目录以及子文件 */ import java.util.*; import java.io.*; publ ...

- 日志框架SLF4J

1.什么是SLF4J SLF4J:Simple Logging Facade for Java,为java提供的简单日志Facade.Facade门面,更底层一点说就是接口.它允许用户以自己的喜好,在 ...

- java线程的实现

一共有两种方法Thread类和Runnable接口,相对来讲,更趋向于用Runnable因为一个类可以实现多个接口,但是只能继承一个类,所以相对来说倾向用Runnable 第一种方法:用Thread其 ...

- java线程(三)

线程代码同步与线程锁 为什么要有同步代码块? 线程同步的出现是为了解决多个线程对统一资源操作而引发的数据混乱问题.这里引用一个经典demo-银行转账操作,场景如下,小明的账户目前有1000人民币,他在 ...