RNN总结

RNN既可以表述为循环神 经网络(recurrent neural network),也可以表述为递归神经网络(recursive neural network),前者一般用于处理以时间序列为输入的问题(比如把一个句子看成词组成的序列),每次向循环神经网络输入一个词,知道整个句子输入结束。后者一般用于处理图结构或树结构问题(比如为了处理歧义问题,我们构造语法树为输入,而不是循环输入每一个词)。

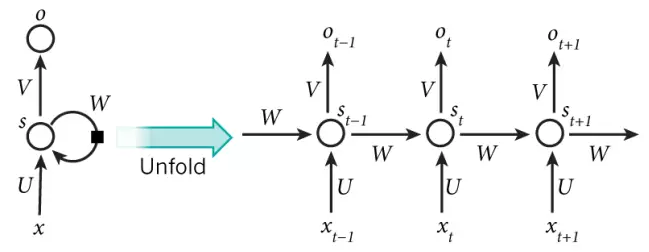

下图是循环神经网络的展开

图1

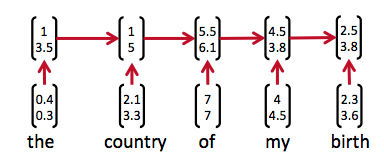

下面是一个句子对上图的应用

图2

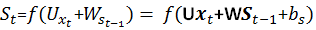

可以这样理解:将所有用到的英文词向量化之后,the表示为(0.4,0.3),对应图1中的x输入,经过神经元计算之后输出为(1,3.5),神经元内部的计算方式为:

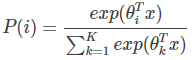

函数f通常是诸如tanh或者ReLU的非线性函数,U,x,St-1都为向量且U、V、W都是待训练参数。输出O可以选择softmax函数,其表达式如下

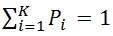

这里的变量i对应图1中的变量t,可见

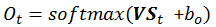

也就是说循环神经网络所有输出之和为1,输出O的计算公式为

其中V和St都是向量。也就是说神经元先计算隐状态St,然后计算输出Ot

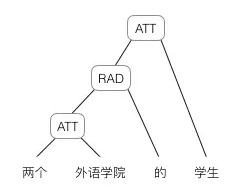

下面以树结构为例来说明递归神经网络的输入与计算

1.将句子分词之后,给每个词一个向量,这里词的向量化可以采用one-hot或者其他一些向量化工具,比如Google的gensim

2.将词按照树形结构输入,以图3为例

图3

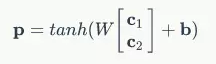

2.1 首先计算“两个”和“外语学院”的父节点的向量,计算方法是:假设“两个”的词向量表示为c1,“外语学院”的词向量表示为c2,那么父节点对应的向量P为

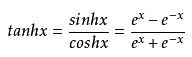

其中W和b是训练好的参数,tanh是双曲正切函数,表达式为

2.2 依次迭代计算各个父节点对应的向量,最终得到根节点对应向量。

因为是以语法树输入的,所以对于歧义问题有较好的处理能力,比如图3中的句子也可以用图4的语法树来表示:

图4

事实上,图3与图4对应的根节点向量完全不同,因为词向量的输入顺序是不一样的。

在得到根节点向量后,我们就可以去完成一些更高级的任务,比如计算语义相似度或者情感分析等。

RNN总结的更多相关文章

- RNN求解过程推导与实现

RNN求解过程推导与实现 RNN LSTM BPTT matlab code opencv code BPTT,Back Propagation Through Time. 首先来看看怎么处理RNN. ...

- 在RNN中使用Dropout

dropout在前向神经网络中效果很好,但是不能直接用于RNN,因为RNN中的循环会放大噪声,扰乱它自己的学习.那么如何让它适用于RNN,就是只将它应用于一些特定的RNN连接上. LSTM的长期记 ...

- RNN 入门学习资料整理

建议按序阅读 1. RNN的一些简单概念介绍 A guide to recurrent neural networks and backpropagation Deep learning:四十九(RN ...

- lecture7-序列模型及递归神经网络RNN

Hinton 第七课 .这里先说下RNN有recurrent neural network 和 recursive neural network两种,是不一样的,前者指的是一种人工神经网络,后者指的是 ...

- RNN 入门教程 Part 4 – 实现 RNN-LSTM 和 GRU 模型

转载 - Recurrent Neural Network Tutorial, Part 4 – Implementing a GRU/LSTM RNN with Python and Theano ...

- RNN 入门教程 Part 3 – 介绍 BPTT 算法和梯度消失问题

转载 - Recurrent Neural Networks Tutorial, Part 3 – Backpropagation Through Time and Vanishing Gradien ...

- RNN 入门教程 Part 2 – 使用 numpy 和 theano 分别实现RNN模型

转载 - Recurrent Neural Networks Tutorial, Part 2 – Implementing a RNN with Python, Numpy and Theano 本 ...

- RNN 入门教程 Part 1 – RNN 简介

转载 - Recurrent Neural Networks Tutorial, Part 1 – Introduction to RNNs Recurrent Neural Networks (RN ...

- CNN & RNN 及一些常识知识(不断扩充中)

参考: http://blog.csdn.net/iamrichardwhite/article/details/51089199 一.神经网络的发展历史 五六十年代,提出感知机 八十年代,提出多层感 ...

- 循环神经网络(RNN, Recurrent Neural Networks)介绍(转载)

循环神经网络(RNN, Recurrent Neural Networks)介绍 这篇文章很多内容是参考:http://www.wildml.com/2015/09/recurrent-neur ...

随机推荐

- Tesseract-OCR 训练教程(一)

实际应用中[font]替换为你自己的字体名,比如newfont.hehe等 1.根据tif生成box文件(位置宽高等信息)tesseract [font].font.exp0.tif [font].f ...

- tunning-prime优化mysql建议

#!/bin/sh # set tabstop=8 ################################################################## ...

- ReactNative——UI2.组件生命周期

对于习惯了iOS开发的同学,可能会对React Native中组件的生命周期很困惑.在iOS中有一个ViewDidLoad来初始化,那么在RN中,又是在哪里呢? 一.看图分析 在下图中描述了React ...

- 将整个文件夹推上github

/*游戏或者运动才能让我短暂的忘记心痛,现如今感觉学习比游戏和运动还重要——曾少锋*/ 首先你要有一个本地仓库和一个远程仓库(github中的仓库).git文件夹下面不能含有 git文件夹,如果有的话 ...

- Linux Shell查看物理CPU个数、核数、逻辑CPU个数

Linux Shell常用命令: ====================================== # 总核数 = 物理CPU个数 X 每颗物理CPU的核数 # 总逻辑CPU数 = 物理C ...

- JPQL详解

JPA在说jpql之前必须要说一下什么是JPA,否则在后续学习的时候,你会弄混的.JPA是一种规范,什么是规范呢,规范就是一个钥匙可以开这把锁.一般对于规范来说我们都是用接口,如果有人要我们则实现我们 ...

- 【问题】PPS、PPSX自动放映格式打开直接进入编辑模式

在做自动放映格式的PPT的时候,发现另存为PPS或PPSX格式后,自动放映无法实现,而是直接进入了PPT编辑模式,于是开始寻找原因.发现是文件关联有问题,这与安装多个版本的ppt有关系. 解决办法: ...

- 小米盒子root及sshdroid安装

1.root 参考屌丝猫的教程 主要原理是通过运行自定义recovery实现root功能 2.安装sshdroid以及幸运破解器 3.使用幸运破解器吧sshdroid编程系统应用,从而实现自启动

- spring cloud 之 Eureka 知识点

Eureka原理 当服务消费者想要调用服务提供者的API时,首先会在注册中心中查询当前可用的实例的网络地址(也可能是定时查询可用实例,本地缓存好可用服务列表),然后再使用客户端负载均衡,命中到其中一个 ...

- spring 注解列表

table th:first-of-type { width: 15%; } table th:nth-of-type(2) { } 注解 作用 例子 @SuppressWarnings 忽略警告 类 ...