将java开发的wordcount程序提交到spark集群上运行

今天来分享下将java开发的wordcount程序提交到spark集群上运行的步骤。

第一个步骤之前,先上传文本文件,spark.txt,然用命令hadoop fs -put spark.txt /spark.txt,即可。

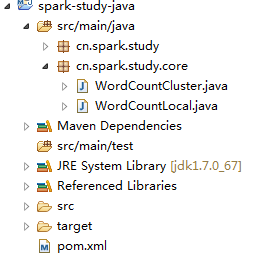

第一:看整个代码视图

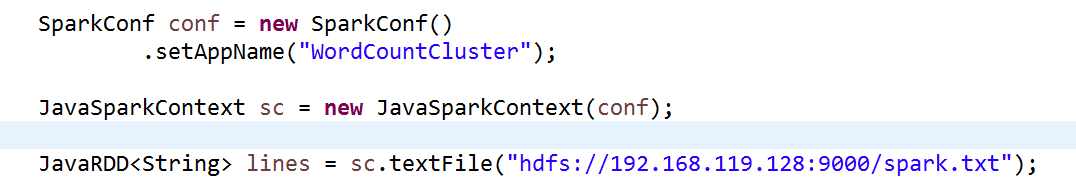

打开WordCountCluster.java源文件,修改此处代码:

第二步:

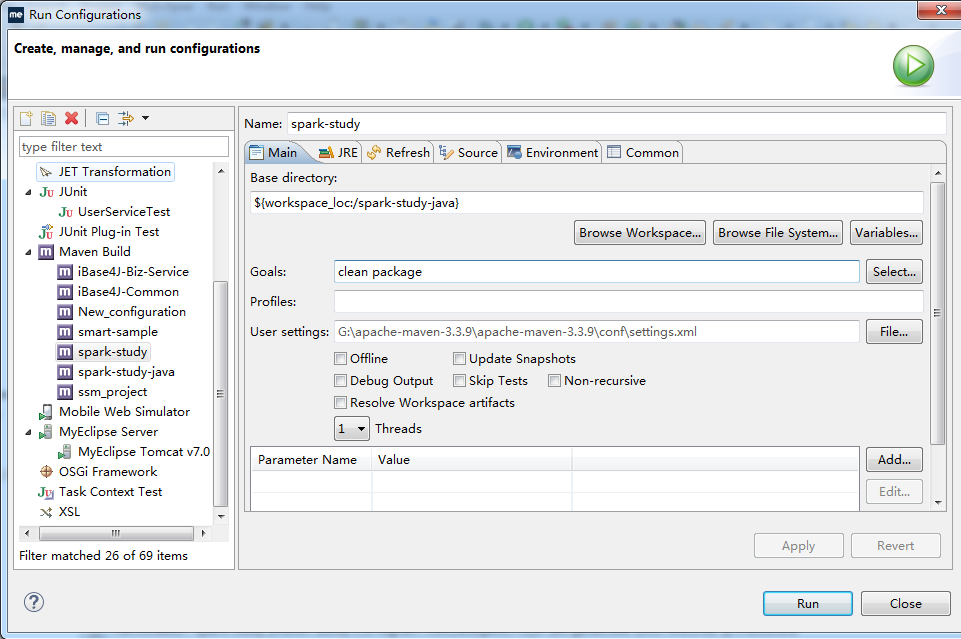

打好jar包,步骤是右击项目文件----RunAs--Run Configurations

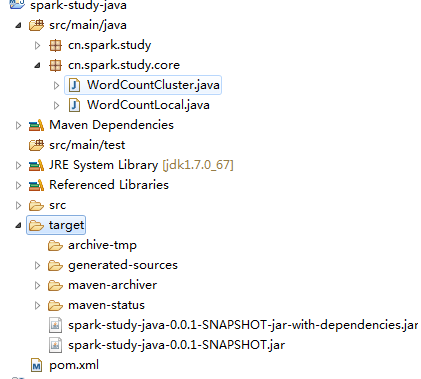

照图填写,然后开始拷贝工程下的jar包,如图,注意是拷贝那个依赖jar包,不是第二个

然后将复制到桌面的这个jar包和另外一个文件WordCount.sh上传到平台上,即拖拽到平台上

开始使用上传命令hadoop fs -put spark.txt /spark.txt。

第三步:要启动hadoop集群,启动方式见hadoop配置博文,注意,如果集群里面的datanode或者是namenode之一没有启动,则找到这样一个目录,并删除里面的文件,重新启动即可,如图:即home目录下的文件

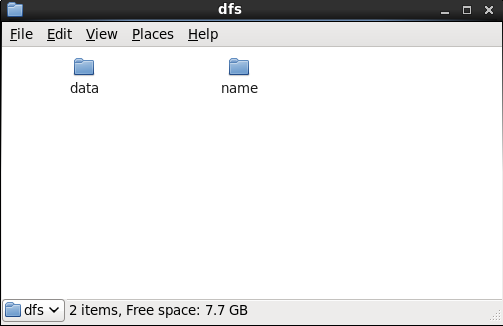

打开home目录下的hadoop----dfs-----把里面的两个目录都删除掉,即可

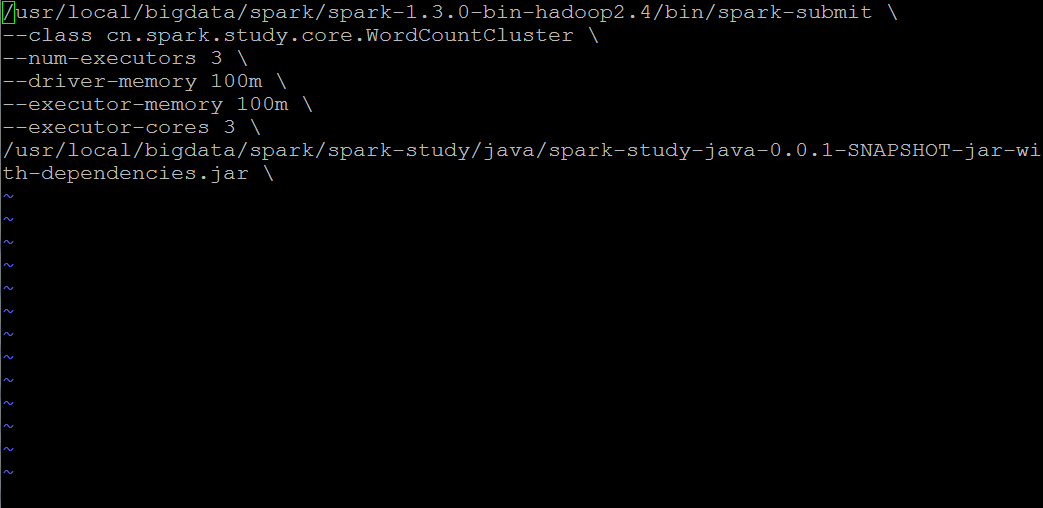

第四步:此时hadoop集群已经启动,然后我们开始修改WordCount.sh配置文件

几点注意:

1,class目录必须对应你的eclipse工程下的项目目录

2,关于spark-submit提交工具,路径要和你的spark集群上面的路径一致 ,这里找的是spark集群下的bin目录里面的文件,不是spark-study下的文件,切记

3,最后一行路径就是你的上传程序jar包到平台上后的路径,注意一定是后缀为jar的文件包,不能上传其它的后缀名,一律无效。

4,注意:修改过本地eclipse的程序文件,一定要生效的话,就要重新上传打包,然后部署。

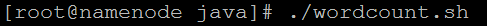

第五步,启动程序文件,即如下图,在wordcount.sh配置文件的目录下,执行以下命令即可

将java开发的wordcount程序提交到spark集群上运行的更多相关文章

- IntelliJ IDEA编写的spark程序在远程spark集群上运行

准备工作 需要有三台主机,其中一台主机充当master,另外两台主机分别为slave01,slave02,并且要求三台主机处于同一个局域网下 通过命令:ifconfig 可以查看主机的IP地址,如下图 ...

- Eclipse提交代码到Spark集群上运行

Spark集群master节点: 192.168.168.200 Eclipse运行windows主机: 192.168.168.100 场景: 为了测试在Eclipse上开发的代码在Spa ...

- [Spark Core] 在 Spark 集群上运行程序

0. 说明 将 IDEA 下的项目导出为 Jar 包,部署到 Spark 集群上运行. 1. 打包程序 1.0 前提 搭建好 Spark 集群,完成代码的编写. 1.1 修改代码 [添加内容,判断参数 ...

- hadoop 把mapreduce任务从本地提交到hadoop集群上运行

MapReduce任务有三种运行方式: 1.windows(linux)本地调试运行,需要本地hadoop环境支持 2.本地编译成jar包,手动发送到hadoop集群上用hadoop jar或者yar ...

- win10下将spark的程序提交给远程集群中运行

一,开发环境: 操作系统:win19 64位 IDE:IntelliJ IDEA JDK:1.8 scala:scala-2.10.6 集群:linux上cdh集群,其中spark为1.5.2,had ...

- 大数据学习day18----第三阶段spark01--------0.前言(分布式运算框架的核心思想,MR与Spark的比较,spark可以怎么运行,spark提交到spark集群的方式)1. spark(standalone模式)的安装 2. Spark各个角色的功能 3.SparkShell的使用,spark编程入门(wordcount案例)

0.前言 0.1 分布式运算框架的核心思想(此处以MR运行在yarn上为例) 提交job时,resourcemanager(图中写成了master)会根据数据的量以及工作的复杂度,解析工作量,从而 ...

- MapReduce编程入门实例之WordCount:分别在Eclipse和Hadoop集群上运行

上一篇博文如何在Eclipse下搭建Hadoop开发环境,今天给大家介绍一下如何分别分别在Eclipse和Hadoop集群上运行我们的MapReduce程序! 1. 在Eclipse环境下运行MapR ...

- 06、部署Spark程序到集群上运行

06.部署Spark程序到集群上运行 6.1 修改程序代码 修改文件加载路径 在spark集群上执行程序时,如果加载文件需要确保路径是所有节点能否访问到的路径,因此通常是hdfs路径地址.所以需要修改 ...

- 在集群上运行caffe程序时如何避免Out of Memory

不少同学抱怨,在集群的GPU节点上运行caffe程序时,经常出现"Out of Memory"的情况.实际上,如果我们在提交caffe程序到某个GPU节点的同时,指定该节点某个比较 ...

随机推荐

- PHP 审计

1.get 和post 上传数组,数组的sha1值相等 通过阅读代码,我们发现要想得到flag就要达到下面三个条件: 使 uname的sha1值 与 passwd的sha1的值 相等 但是同 ...

- 面试和工作中的map

map是C++ STL中的关联容器,存储的是键值对(key-value),可以通过key快速索引到value.map容器中的数据是自动排序的,其排序方式是严格的弱排序(stick weak order ...

- Go语言反射之类型反射

1 概述 类似于 Java,Go 语言也支持反射.支持反射的语言可以在运行时对程序进行访问和修改.反射的原理是在程序编译期将反射信息(如类型信息.结构体信息等)整合到程序中,并给提供给程序访问反射信息 ...

- Go语言中多字节字符的处理

1 概述 Go语言的字符串是使用 UTF-8 编码的.UTF-8 是 Unicode 的实现方式之一.本文内容包括:UTF-8 和 Unicode 的关系,Go语言提供的 unicode 包和 uni ...

- python2.7入门---2.x与3.x版本区别

Python的3.0版本,常被称为Python 3000,或简称Py3k.相对于Python的早期版本,这是一个较大的升级.为了不带入过多的累赘,Python 3.0在设计的时候没有考虑向 ...

- Spring MVC接受参数的注解

一.Request请求发出后,Headler Method是如何接收处理数据的? Headler Method绑定常用的参数注解,根据处理request的不同部分分为四类: A.处理 Request ...

- HBase——使用Put迁移MySql数据到Hbase

先上code: /** * 功能:迁移mysql上电池历史数据到hbase * Created by liuhuichao on 2016/12/6. */ public class MySqlToH ...

- 如何解决Django与Vue语法的冲突

当我们在django web框架中,使用vue的时候,会遇到语法冲突.因为vue使用{{}},而django也使用{{}},因此会冲突. 解决办法1:在django1.5以后,加入了标签:{% ver ...

- Git生成多个ssh key

在实际的工作中, 有可能需要连接多个远程仓库, 例如我想连接私有仓库.GitLab官网.GitHub官网, 那么同一台电脑就要生成多个ssh key: ssh-keygen -t rsa -C &qu ...

- ython进阶06 循环对象

这一讲的主要目的是为了大家在读Python程序的时候对循环对象有一个基本概念. 循环对象的并不是随着Python的诞生就存在的,但它的发展迅速,特别是Python 3x的时代,循环对象正在成为循环的标 ...