第十七节:Scrapy爬虫框架之item.py文件以及spider中使用item

Scrapy原理图:

item位于原理图的最左边

item.py文件是报存爬取数据的容器,他使用的方法和字典很相似,但是相比字典item多了额外的保护机制,可以避免拼写错误或者定义错误。

1、创建item

在创建item时需要继承scrapy.Item类,并且定义scrapy.Field字段。由于我们在上一节Scrapy爬虫框架之项目创建spider文件数据爬取当中提取了id、url、title、thumb四个字段。所以我们在item.py文件当中需要创建者四个字段。

# -*- coding: utf-8 -*-

# item.py import scrapy class Bole_mode(scrapy.Item):

id = scrapy.Field() # id

url = scrapy.Field() # 图片链接

title = scrapy.Field() # 标题

thumb = scrapy.Field() # 缩略图

2、spider使用item

之前说过item文件是报存爬取数据的容器,所以我们在上一节当中爬取下来的数据需要使用item进行暂存。

在进行使用之前需要对这个item进行实例化 item = Bole_mode()。

代码如下

# BLZXSPider.py import scrapy

import json

import sys sys.path.append(r'D:\spider\bole\item.py')

from bole.items import Bole_mode class BoleSpider(scrapy.Spider):

name = 'boleSpider' def start_requests(self):

url = "https://image.so.com/zj?ch=photography&sn={}&listtype=new&temp=1"

page = self.settings.get("MAX_PAGE")

for i in range(int(page)+1):

yield scrapy.Request(url=url.format(i*30)) def parse(self,response):

photo_list = json.loads(response.text)

item = Bole_mode()

for image in photo_list.get("list"):

item["id"] = image["id"]

item["url"] = image["qhimg_url"]

item["title"] = image["group_title"]

item["thumb"] = image["qhimg_thumb_url"]

yield item

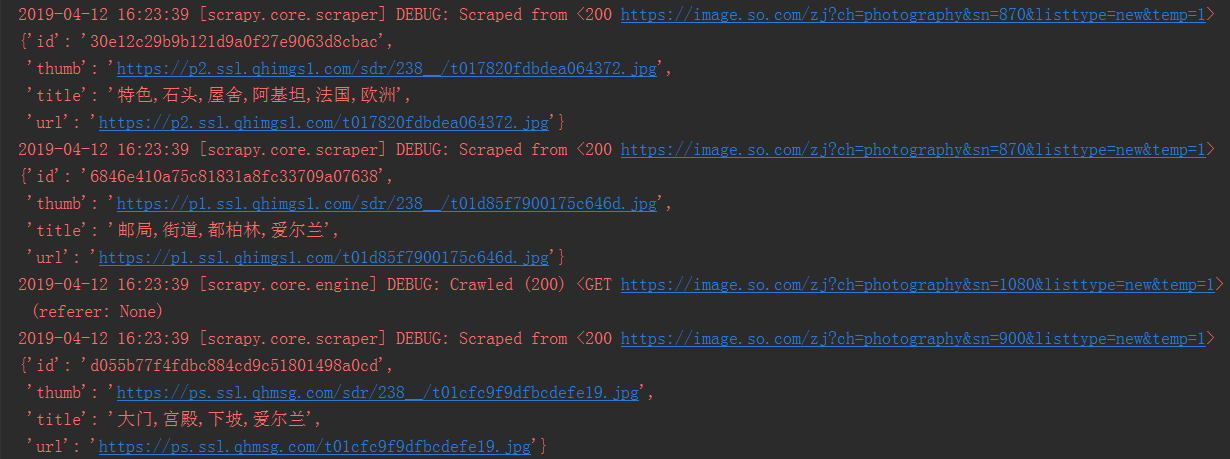

运行结果如下,可以看到每个url都已经请求成功。

第十七节:Scrapy爬虫框架之item.py文件以及spider中使用item的更多相关文章

- 第十六节:Scrapy爬虫框架之项目创建spider文件数据爬取

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中.其最初是为了页面抓取所设计的, 也可以应用在获取API所返回的数据或 ...

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- Scrapy爬虫框架(实战篇)【Scrapy框架对接Splash抓取javaScript动态渲染页面】

(1).前言 动态页面:HTML文档中的部分是由客户端运行JS脚本生成的,即服务器生成部分HTML文档内容,其余的再由客户端生成 静态页面:整个HTML文档是在服务器端生成的,即服务器生成好了,再发送 ...

- Scrapy爬虫框架中的两个流程

下面对比了Scrapy爬虫框架中的两个流程—— ① Scrapy框架的基本运作流程:② Spider或其子类的几个方法的执行流程. 这两个流程是互相联系的,可对比学习. 1 ● Scrapy框架的基本 ...

- Python爬虫教程-31-创建 Scrapy 爬虫框架项目

本篇是介绍在 Anaconda 环境下,创建 Scrapy 爬虫框架项目的步骤,且介绍比较详细 Python爬虫教程-31-创建 Scrapy 爬虫框架项目 首先说一下,本篇是在 Anaconda 环 ...

- Python-S9-Day126——Scrapy爬虫框架

01 今日内容概要 02 内容回顾和补充:scrapy 03 内容回顾和补充:网络和并发编程 04 Scrapy爬虫框架:pipeline做持久化(一) 05 Scrapy爬虫框架:pipeline做 ...

- Scrapy爬虫框架学习

一.Scrapy框架简介 1. 下载页面 2. 解析 3. 并发 4. 深度 二.安装 linux下安装 pip3 install scrapy windows下安装 a.pip3 install w ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影

前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大家讲解一个完整爬虫的流程. 工具和环境 语言:python 2 ...

随机推荐

- 初学者的疑惑,到底什么是javaBean?

JavaBeans是Java中一种特殊的类,可以将多个对象封装到一个对象(bean)中.特点是可序列化,提供无参构造器,提供getter方法和setter方法访问对象的属性.名称中的"Bea ...

- PHP 循环一个文件下的所有目录以及文件

function test($dir) { //判断dir是否目录 if(is_dir($dir)) { $files = []; //列出 dir 目录中的文件和目录: $list = scandi ...

- 【SpringCloud构建微服务系列】使用Spring Cloud Config统一管理服务配置

一.为什么要统一管理微服务配置 对于传统的单体应用而言,常使用配置文件来管理所有配置,比如SpringBoot的application.yml文件,但是在微服务架构中全部手动修改的话很麻烦而且不易维护 ...

- 进击的Python【第十二章】:mysql介绍与简单操作,sqlachemy介绍与简单应用

进击的Python[第十二章]:mysql介绍与简单操作,sqlachemy介绍与简单应用 一.数据库介绍 什么是数据库? 数据库(Database)是按照数据结构来组织.存储和管理数据的仓库,每个数 ...

- linux系统添加java和glassfish环境变量

第一种方法: 可以在/etc/profile里面增加 #java环境变量 JAVA_HOME=/home/harries/develop/jdk1.6.0_23export JRE_HOME=/hom ...

- D. Chloe and pleasant prizes 树上dp + dfs

http://codeforces.com/contest/743/problem/D 如果我们知道mx[1]表示以1为根节点的子树中,点权值的最大和是多少(可能是整颗树,就是包括了自己).那么,就可 ...

- 学习笔记 第十一章 CSS3布局基础

第11章 CSS3布局基础 [学习重点] 了解CSS2盒模型. 设计边框样式. 设计边界样式. 设计补白样式. 了解CSS3盒模型. 11.1 CSS盒模型基础 页面中所有元素基本显示形态为方形 ...

- 安卓(Android )软键盘的控制(显示和隐藏)

Activity 启动时软键盘默认状态 在清单文件(manifest .xml)中可以通过在 Activity 标签中增加属性控制软键盘的默认状态: android:windowSoftInputMo ...

- linux下php开启pdo扩展

前提:网页报错 为解决问题:Undefined class constant 'MYSQL_ATTR_INIT_COMMAND' 解决方案 : 下载安装PHP_MYSQL扩展 wget http:// ...

- Java Hello World 错误 找不到或无法加载主类

Java 有几年没用了 生疏了好多 最近又捡起来 结果第一个Hello World 就在黑窗口内报错! 遇到几个小问题. 1. 安装JDK后 在 CMD 中 执行 java -version 正常 因 ...