TVM图优化(以Op Fusion为例)

首先给出一个TVM 相关的介绍,这个是Tianqi Chen演讲在OSDI18上用的PPThttps://files.cnblogs.com/files/jourluohua/Tianqi-Chen-TVM-Stack-Overview.rar

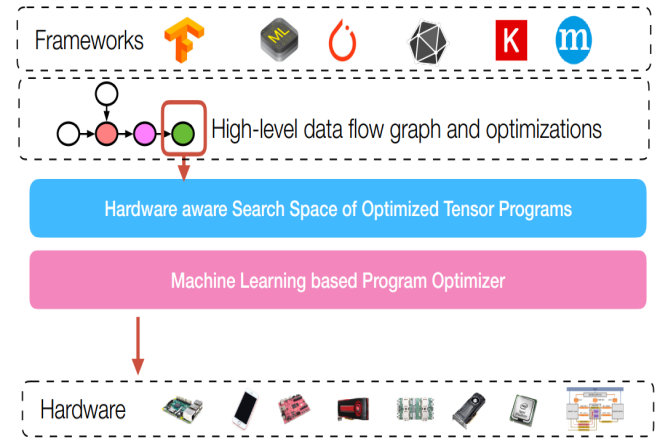

对于图优化来说,位于整个软件编译栈比较高的层次:

首先给出计算图的定义

Computational graphs: a common way to represent programs in deep learning frameworks

对于图优化来说,有很多种图优化手段:Operator Fusion

Constant Parameter Path Pre-Computation

Static Memory Reuse Analysis

Data Layout Transformation

AlterOpLayout

SimplifyInference

这里仅以Operator Fusion做例子介绍

Operator fusion : combine multiple operators together into a single kernel without saving the intermediate results back into global memory

也就说是说算子融合省掉了中间数据的store过程

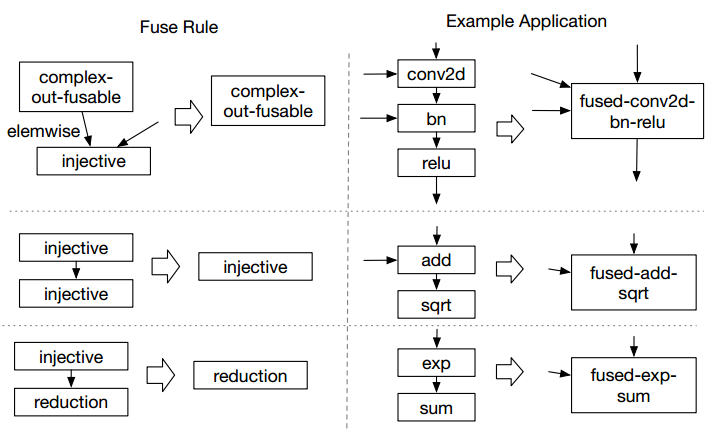

在TVM中,有三种融合规则:

其中,算子属于哪一类是算子本身的特性(这个地方不是特别懂,这个属性有非常多的值),但是能融合的规则只有这三种。

但是这种store是如何减少的,在IR上有明确的体现。

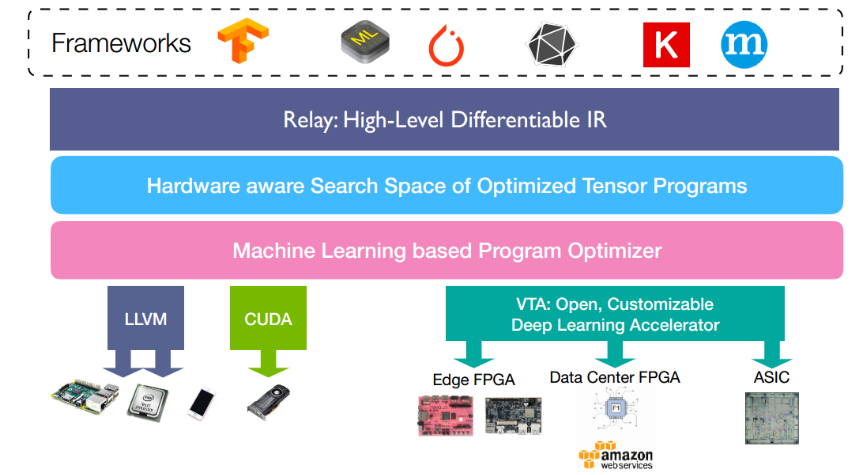

下边的例子,我会使用tvm.relay来进行介绍,relay是TVM中实现的一种高级IR,可以简单理解为另一种计算图表示。其在TVM所处的位置如下图所示

比如,我们假设我们要完成一个y = exp(x+1.0)的计算图

给出测试代码(来自于源码中的test_pass_fuse_ops.py,有改动):

import tvm

from tvm import relay def test_fuse_simple():

"""Simple testcase."""

def before():

x = relay.var("x", shape=(10, 20))

y = relay.add(x, relay.const(1, "float32"))

z = relay.exp(y)

return relay.Function([x], z) def expected():

x = relay.var("p", shape=(10, 20))

y = relay.add(x, relay.const(1, "float32"))

z = relay.exp(y)

f1 = relay.Function([x], z)

x = relay.var("x", shape=(10, 20))

y = relay.Call(f1, [x])

return relay.Function([x], y) z = before()

z = relay.ir_pass.infer_type(z)

# print(z.astext())

zz = relay.ir_pass.fuse_ops(z, opt_level=2)

print(zz.astext())

zz = relay.ir_pass.infer_type(zz)

zz = relay.ir_pass.fuse_ops(zz)

zz = relay.ir_pass.infer_type(zz)

after = relay.ir_pass.infer_type(expected())

# print(after.astext())

assert relay.ir_pass.alpha_equal(zz, after)

在融合前,其IR(方便用户看的一种形式,不是真正的IR)

fn (%x: Tensor[(10, 20), float32])

-> Tensor[(10, 20), float32] {

%0 = fn(%p0: Tensor[(10, 20), float32],

%p1: float32)

-> Tensor[(10, 20), float32] {

%1 = add(%p0, %p1)

%1

}

%2 = %0(%x, 1f)

%3 = fn(%p01: Tensor[(10, 20), float32])

-> Tensor[(10, 20), float32] {

%4 = exp(%p01)

%4

}

%5 = %3(%2)

%5

}

融合后:

fn (%x: Tensor[(10, 20), float32])

-> Tensor[(10, 20), float32] {

%0 = fn(%p0: Tensor[(10, 20), float32])

-> Tensor[(10, 20), float32] {

%1 = add(%p0, 1f)

%2 = exp(%1)

%2

}

%3 = %0(%x)

%3

}

可以很明显的发现,省掉了一次数据store过程

TVM图优化(以Op Fusion为例)的更多相关文章

- TVM图优化与算子融合

TVM图优化与算子融合 计算图的定义 Computational graphs: a common way to represent programs in deep learning framewo ...

- 『The Captain 最短路建图优化』

The Captain(BZOJ 4152) Description 给定平面上的n个点,定义(x1,y1)到(x2,y2)的费用为min(|x1-x2|,|y1-y2|),求从1号点走到n号点的最小 ...

- BZOJ4383/LuoGuP3588 Pustynia/PUS 线段树建图优化

我会告诉你我看了很久很久才把题目看懂吗???怀疑智商了 原来他给的l,r还有k个数字都是下标... 比如给了一个样例 l, r, k, x1,x2,x3...xk,代表的是一个数组num[l]~num ...

- MXNet 图优化与算子融合

MXNet 图优化与算子融合Graph Optimization and Quantization based on subgraph and MKL-DNN Purpose MKL-DNN引入了两个 ...

- 深入理解图优化与g2o:g2o篇

内容提要 讲完了优化的基本知识,我们来看一下g2o的结构.本篇将讨论g2o的代码结构,并带着大家一起写一个简单的双视图bundle adjustment:从两张图像中估计相机运动和特征点位置.你可以把 ...

- 深入理解图优化与g2o:图优化篇

前言 本节我们将深入介绍视觉slam中的主流优化方法——图优化(graph-based optimization).下一节中,介绍一下非常流行的图优化库:g2o. 关于g2o,我13年写过一个文档,然 ...

- CF 291E. Tree-String Problem [dfs kmp trie图优化]

CF291E 题意:一棵树,每条边上有一些字符,求目标串出现了多少次 直接求目标串的fail然后一边dfs一边跑kmp 然后就被特殊数据卡到\(O(n^2)\)了... 因为这样kmp复杂度分析的基础 ...

- 从零开始一起学习SLAM | 理解图优化,一步步带你看懂g2o代码

首发于公众号:计算机视觉life 旗下知识星球「从零开始学习SLAM」 这可能是最清晰讲解g2o代码框架的文章 理解图优化,一步步带你看懂g2o框架 小白:师兄师兄,最近我在看SLAM的优化算法,有种 ...

- 视觉SLAM漫淡(二):图优化理论与g2o的使用

视觉SLAM漫谈(二):图优化理论与g2o的使用 1 前言以及回顾 各位朋友,自从上一篇<视觉SLAM漫谈>写成以来已经有一段时间了.我收到几位热心读者的邮件.有的希望我介绍一下当前 ...

随机推荐

- 阶段5 3.微服务项目【学成在线】_day04 页面静态化_23-页面预览-页面预览开发

1.用户进入cms前端,点击“页面预览”在浏览器请求cms页面预览链接. 2.cms根据页面id查询DataUrl并远程请求DataUrl获取数据模型. 3.cms根据页面id查询页面模板内容 4.c ...

- MVP模式的学习

简书: http://www.jianshu.com/p/f6fd9656f619 Github: https://github.com/tsaievan/YFMVPDemo

- Ocelot 配置参数

Downstream是下游服务配置 UpStream是上游服务配置 Aggregates 服务聚合配置 ServiceName, LoadBalancer, UseServiceDiscovery 配 ...

- 微信小程序 请求签名接口超时 踩坑路。。

我们公司一般做开发都是先用测试机的接口调试功能,等功能都调试的差不多了,再换成线上的正式接口,因为正式接口要验证签名. 这几个功能都调试的差不多了,准备换成线上正式接口了,结果却出了问题,提示请求超时 ...

- 【Qt开发】Qt5 中对 C++11 一些新特性的封装

C++11 是现在的 C++ 标准的名称,C++11 为 C++ 语言带来很多新特性. 而 Qt 4.8 是 Qt 首个在其 API 中开始使用一些新的 C++11 特性的版本,我之前写过一篇博文:C ...

- 转换函数conversion function

类转换分为两个角度 转换自身为其他类型 把其他类型转换为自身 Example: 这里我们可以将b转换为class xxx 的类型(方式2),也可以将me转换为double,然后再讲结果转换为doubl ...

- 创建多个Fragment可滑动界面

创建新项目,选择Tabbed Activity 默认就有2个Fragment,这里我们删除相关代码. 在切换时 FragmentPagerAdapter onDestroyView onCreateV ...

- codevs 2853:方格游戏

(排版没搞好,这一行用来卖萌~) 题目描述 Description 菜菜看到了一个游戏,叫做方格游戏~ 游戏规则是这样的: 在一个n*n的格子中,在每个1*1的格子里都能获得一定数量的积分奖励,记左上 ...

- new , delete常见用法和与malloc,free比较

new/delete是C++的运算符.malloc与free是C++/C语言的标准库函数,new/delete只能在C++中使用,malloc与free在C与C++中都能够使用,它们都可用于申请动态内 ...

- 使用window.open 实现弹框和居中对齐

// 打开页面方法 window.open(url, '_blank', centerStyle('600', '400')+',toolbar=no,menubar=no,resizeable=no ...