梯度下降算法 Gradient Descent

梯度下降算法 Gradient Descent

梯度下降算法是一种被广泛使用的优化算法。在读论文的时候碰到了一种参数优化问题:

在函数\(F\)中有若干参数是不确定的,已知\(n\)组训练数据,期望找到一组参数使得残差平方和最小。通俗一点地讲就是,选择最合适的参数,使得函数的预测值与真实值最相符。

\]

其中,\(\hat{f}\)为真实值,\(f\)为测量值。在函数\(F\)中,存在n,m,p等参数,也存在自变量。训练数据给出了若干组自变量与真实值,算法需要找到合适的参数使得函数与训练数据相符。

这时就要用到今天的算法:梯度下降算法!

梯度下降算法的分类:

- 梯度下降算法 Batch Gradient Descent

- 随机梯度下降算法 Stochastic Gradient Descent

- 小批量梯度下降算法 Mini-batch Gradient Descent

梯度下降算法

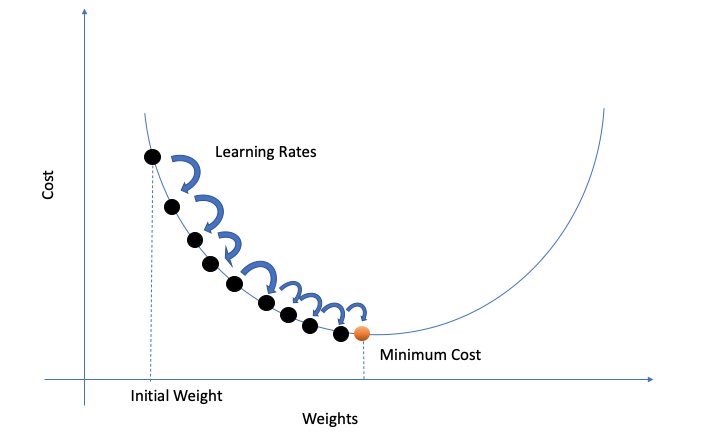

在梯度下降算法中,我们根据梯度方向,迭代地调整参数。我们把所有参数(例如n,m,p之类的)打包进一个变量组\(\theta=\{n,m,p,..\}\),然后对这个变量组迭代更新;定义函数\(L=\sum_{i=1}^n (\hat{f}_i - f_i)^2\)为误差函数。

\]

其中,\(r\)为学习率。r的大小决定了参数移动的“步幅”,若r值过小,往往需要更长的时间才能算出结果;而值过大又可能导致无法得到最优值。

梯度的方向是函数增大最快的方向,那么梯度的反方向就是减小最快的方向。因此我们沿着梯度更小的方向进行参数更新可以有效地找到全局最优解。

def SGD(f, theta0, alpha, num_iters):

"""

Arguments:

f -- the function to optimize, it takes a single argument

and yield two outputs, a cost and the gradient

with respect to the arguments

theta0 -- the initial point to start SGD from

num_iters -- total iterations to run SGD for

Return:

theta -- the parameter value after SGD finishes

"""

theta = theta0

for iter in range(num_iters):

# For python 2.x - use xrange

grad = f(theta)[1]

# there is NO dot product ! return theta

theta = theta - r*(alpha * grad)

随机梯度下降算法

梯度下降算法看似已经解决了问题,但是还面临着“数据运算量过大”的问题。假设一下,我们现在有10000组训练数据,有10个参量,那么仅迭代一次就产生了10000*10=100000次运算。如果想让它迭代1000次的话,就需要10^8的运算量。显然易见,这个算法没法处理大规模的数据。

那么如何改进呢?在一次迭代中,将训练数据的量由“全体”改为“随机的一个”。这便是随机梯度下降算法(SGD)

优点:

打个比方,我们开发了一个新的软件,需要向100个用户收集体验数据并进行产品升级。在梯度下降方法中,我们会先向这100个用户挨个询问,然后进行一次优化;再挨个询问,再进行一次调整...在随机梯度下降方法中,我们会在询问完第一个用户之后就进行一次优化,然后拿着优化后的用户询问第二个客户,然后再优化;这样我们在完成一轮调查之后,就已经调整了100次!可以大大提高运行效率!

缺点:

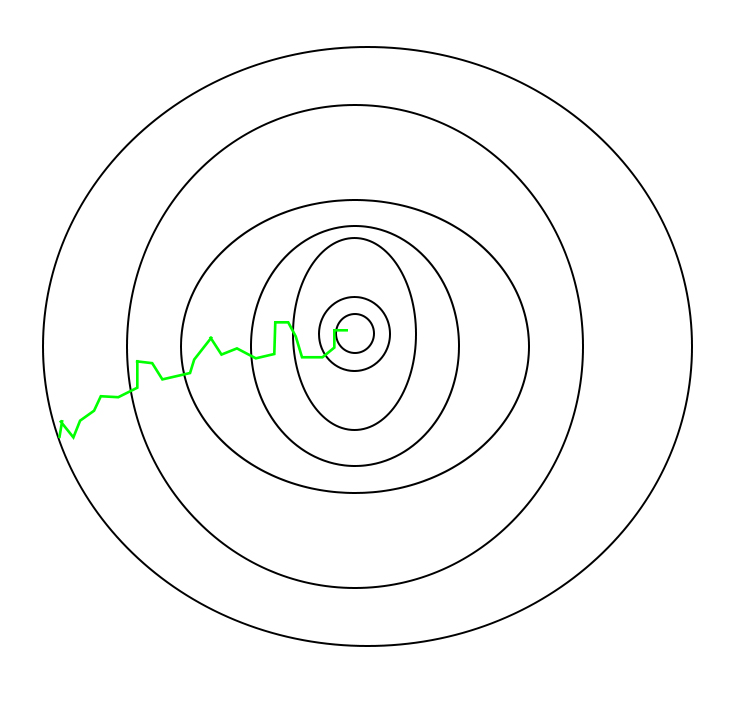

但是SGD在接近最优点之后很难稳定下来,而是在最优点附近徘徊,而难以到达最优。这一问题可以通到在后期适度降低学习率来解决。

并且由于随机性较大,所以下降的过程中较为曲折:

小批量梯度下降算法

小批量梯度下降算法则是吸收了前两者的优点。该算法存在一个变量Batch_size,指一次迭代中随机的选择多少的训练数据。如果Batch_size=n,就是梯度下降算法;如果Batch_size=1,就是随机梯度下降算法。

这样的小批量不仅可以减少计算的成本,还可以提高算法的稳定性。

梯度下降算法 Gradient Descent的更多相关文章

- 梯度下降算法(Gradient descent)GD

1.我们之前已经定义了代价函数J,可以将代价函数J最小化的方法,梯度下降是最常用的算法,它不仅仅用在线性回归上,还被应用在机器学习的众多领域中,在后续的课程中,我们将使用梯度下降算法最小化其他函数,而 ...

- 机器学习(1)之梯度下降(gradient descent)

机器学习(1)之梯度下降(gradient descent) 题记:最近零碎的时间都在学习Andrew Ng的machine learning,因此就有了这些笔记. 梯度下降是线性回归的一种(Line ...

- 梯度下降(gradient descent)算法简介

梯度下降法是一个最优化算法,通常也称为最速下降法.最速下降法是求解无约束优化问题最简单和最古老的方法之一,虽然现在已经不具有实用性,但是许多有效算法都是以它为基础进行改进和修正而得到的.最速下降法是用 ...

- 梯度下降(Gradient Descent)小结 -2017.7.20

在求解算法的模型函数时,常用到梯度下降(Gradient Descent)和最小二乘法,下面讨论梯度下降的线性模型(linear model). 1.问题引入 给定一组训练集合(training se ...

- 梯度下降(Gradient descent)

首先,我们继续上一篇文章中的例子,在这里我们增加一个特征,也即卧室数量,如下表格所示: 因为在上一篇中引入了一些符号,所以这里再次补充说明一下: x‘s:在这里是一个二维的向量,例如:x1(i)第i间 ...

- (二)深入梯度下降(Gradient Descent)算法

一直以来都以为自己对一些算法已经理解了,直到最近才发现,梯度下降都理解的不好. 1 问题的引出 对于上篇中讲到的线性回归,先化一个为一个特征θ1,θ0为偏置项,最后列出的误差函数如下图所示: 手动求解 ...

- CS229 2.深入梯度下降(Gradient Descent)算法

1 问题的引出 对于上篇中讲到的线性回归,先化一个为一个特征θ1,θ0为偏置项,最后列出的误差函数如下图所示: 手动求解 目标是优化J(θ1),得到其最小化,下图中的×为y(i),下面给出TrainS ...

- (3)梯度下降法Gradient Descent

梯度下降法 不是一个机器学习算法 是一种基于搜索的最优化方法 作用:最小化一个损失函数 梯度上升法:最大化一个效用函数 举个栗子 直线方程:导数代表斜率 曲线方程:导数代表切线斜率 导数可以代表方向, ...

- <反向传播(backprop)>梯度下降法gradient descent的发展历史与各版本

梯度下降法作为一种反向传播算法最早在上世纪由geoffrey hinton等人提出并被广泛接受.最早GD由很多研究团队各自发表,可他们大多无人问津,而hinton做的研究完整表述了GD方法,同时hin ...

- 梯度下降法Gradient descent(最速下降法Steepest Descent)

最陡下降法(steepest descent method)又称梯度下降法(英语:Gradient descent)是一个一阶最优化算法. 函数值下降最快的方向是什么?沿负梯度方向 d=−gk

随机推荐

- 设计模式常用的UML图------类图

关系 UML将事物之间的联系归纳为6种,对应响应的图形 关联 定义:表示拥有的关系,具有方向性,一个类单向访问一个类,为单向关联.两个类可以相互访问,为双向关联. 聚合 定义:整体与部分的关系. 组合 ...

- 2、yaml配置文件当中的坑(数字的定义和支持进制书写格式)

6.进制数的转换 6.1.问题回顾 我记得我刚刚开始使用SpringBoot的时候,有一天在做到SpringBoot整合第三方技术的时候 我刚好在那天学习到整合Mybatis,做Web项目嘛,不连数据 ...

- 6.YAML文件详解、PyYaml操作

YAML简介: yaml是一种数据格式,支持注释,换行,多行字符串,裸字符串(正序,字符串) YAML作用: 用于全局的配置文件 用于测试用例编写 YAML语法规则: 区分大小写 使用缩进 ...

- 手把手教你使用LabVIEW实现Mask R-CNN图像实例分割

前言 前面给大家介绍了使用LabVIEW工具包实现图像分类,目标检测,今天我们来看一下如何使用LabVIEW实现Mask R-CNN图像实例分割. 一.什么是图像实例分割? 图像实例分割(Instan ...

- echarts标题(title)配置

var option = { //标题 title : { show:true,//显示策略,默认值true,可选为:true(显示) | fa ...

- 秀++视频算法仓库-厂家对接规约V5

一.概要 (1)每个算法厂家在秀++云平台上会有一个厂商标识,譬如CS101:算法厂家可能有多个算法引擎,每个引擎有一个标识譬如Q101,引擎可以理解为一个可执行程序,可以同时分析多路算法:每个算法在 ...

- 2022春每日一题:Day 15

题目:Balanced lineup 题目说的很清楚了,没有修改,直接RMQ,模板题. 代码: #include <cstdio> #include <cstdlib> #in ...

- vim-瞬间移动打发

一,常用基本命令 set rnu 显示相对行号 1.ctrl+F 将屏幕向下滚动一屏 2.ctrl+u pageUp,ctrl+d pageDown 3.行内移动:W,b在单词间移动,ge向上跳,f ...

- linux deb系 apache 配置解析php文件

安装apache服务器和php服务 sudo apt-get install apache2 php 然后其实一般来说什么也不用安装了就可以成功解析php文件了 制作一个测试文件,test.php放到 ...

- Spring01:概述、工厂模式解耦、Spring中的IOC

四天课程安排 第一天:Spring框架的概述.Spring中基于XML的IOC配置 第二天: Spring中基于注解的IOC和IOC的案例(单表增删改查,持久层随意) 第三天:Spring中的AOP和 ...