Spark Shuffle机制

Spark Shuffle

一.HashShuffle

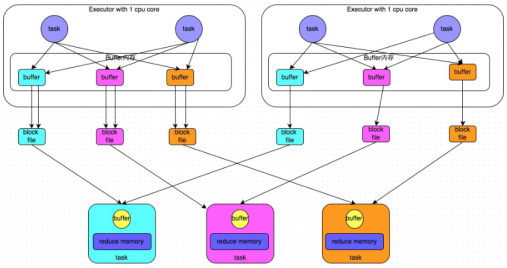

普通机制:产生磁盘小文件的数量为:M(map task number)*R(reduce task number)

过程:

1.map task处理完数据之后,写到buffer缓冲区,buffer的大小为32k,个数与reduce task个数一致

2. 每个buffer缓存区满32k后会溢写磁盘,每个buffer最终对应一个磁盘小文件

3.reduce task拉取数据

问题:

1.shuffle write,read 频繁

2.占用内存过多,容易造成gc以及出现OOM

3.磁盘小文件多,会造成频繁I/O,效率降低

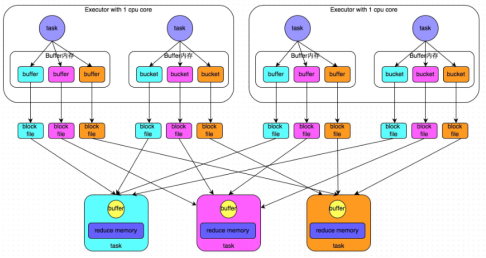

合并机制:产生磁盘小文件的数量为:C(core number)*R(reduce task number)

过程:

1.map task处理完数据之后,写到buffer缓冲区,buffer的大小为32k,个数与reduce task个数一致

2.Executor中每个core中的task共用一份buffer缓冲区

3.每个buffer缓存区满32k后会溢写磁盘,每个buffer最终对应一个磁盘小文件

4.reduce task拉取数据

二.SortShuffle

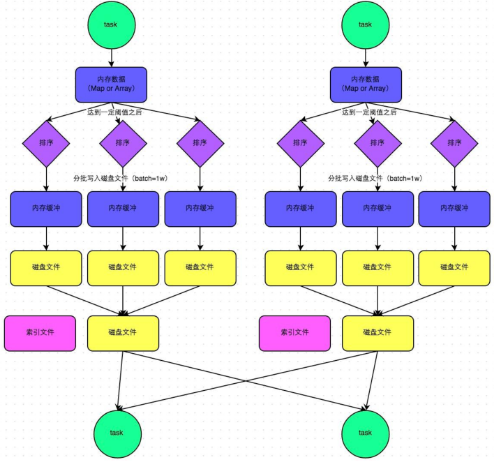

普通机制:产生磁盘小文件数量:2*M(map task number)

步骤:

1.map task处理完数据之后,首先写入一个5M的数据结构

2.sortShuffle有不定期估算机制,来估算这个内存结构的大小,当估算超过真实的大小,会申请内存:2*估算大小-当前大小

3.申请到内存继续写入内存数据结构,申请不到会溢写磁盘

4.溢写磁盘过程中有排序,每批1万条数据溢写,最终对应两个磁盘文件:一个索引文件,一个数据文件

5.reduce task拉取数据首先读取索引文件,再拉取数据

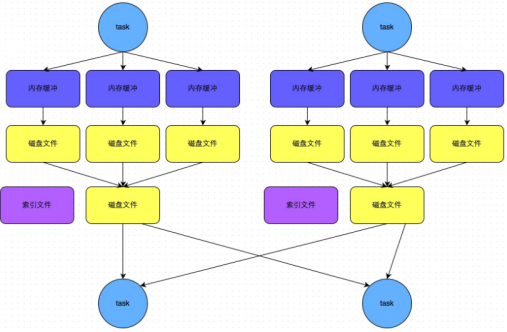

bypass机制:产生磁盘小文件数量:2*M(map task number)

步骤:

1.map task处理完数据之后,首先写入一个5M的数据结构

2.sortShuffle有不定期估算机制,来估算这个内存结构的大小,当估算超过真实的大小,会申请内存:2*估算大小-当前大小

3.申请到内存继续写入内存数据结构,申请不到会溢写磁盘

4.溢写磁盘过程中没有排序,每批1万条数据溢写,最终对应两个磁盘文件:一个索引文件,一个数据文件

5.reduce task拉取数据首先读取索引文件,再拉取数据

Spark Shuffle机制的更多相关文章

- Spark Shuffle机制详细源码解析

Shuffle过程主要分为Shuffle write和Shuffle read两个阶段,2.0版本之后hash shuffle被删除,只保留sort shuffle,下面结合代码分析: 1.Shuff ...

- spark shuffle 机制

spark shuffle 分为两种 1.byPassSortShuffle 发生条件分区数<=200:无排序及聚合操作 主要是直接按照分区号写文件,有多少分区写多少文件 不做任何排序,简单直接 ...

- 【Spark】Spark的Shuffle机制

MapReduce中的Shuffle 在MapReduce框架中,shuffle是连接Map和Reduce之间的桥梁,Map的输出要用到Reduce中必须经过shuffle这个环节,shuffle的性 ...

- 【Spark篇】---Spark中Shuffle机制,SparkShuffle和SortShuffle

一.前述 Spark中Shuffle的机制可以分为HashShuffle,SortShuffle. SparkShuffle概念 reduceByKey会将上一个RDD中的每一个key对应的所有val ...

- spark的shuffle机制

对于大数据计算框架而言,Shuffle阶段的设计优劣是决定性能好坏的关键因素之一.本文将介绍目前Spark的shuffle实现,并将之与MapReduce进行简单对比.本文的介绍顺序是:shuffle ...

- Spark Shuffle原理、Shuffle操作问题解决和参数调优

摘要: 1 shuffle原理 1.1 mapreduce的shuffle原理 1.1.1 map task端操作 1.1.2 reduce task端操作 1.2 spark现在的SortShuff ...

- Spark Shuffle数据处理过程与部分调优(源码阅读七)

shuffle...相当重要,为什么咩,因为shuffle的性能优劣直接决定了整个计算引擎的性能和吞吐量.相比于Hadoop的MapReduce,可以看到Spark提供多种计算结果处理方式,对shuf ...

- 【Spark学习】Apache Spark安全机制

Spark版本:1.1.1 本文系从官方文档翻译而来,转载请尊重译者的工作,注明以下链接: http://www.cnblogs.com/zhangningbo/p/4135808.html 目录 W ...

- Spark工作机制简述

Spark工作机制 主要模块 调度与任务分配 I/O模块 通信控制模块 容错模块 Shuffle模块 调度层次 应用 作业 Stage Task 调度算法 FIFO FAIR(公平调度) Spark应 ...

随机推荐

- [Jenkins][Git]ssh原理以及与https的区别

-------------------------------------------------------------------- 本文参考多篇文章结合自身情况完成,可自由转载,需保留本文出处! ...

- 原生js ajax请求

什么是ajax AJAX 是一种用于创建快速动态网页的技术. 通过在后台与服务器进行少量数据交换,AJAX 可以使网页实现异步更新. 这意味着可以在不重新加载整个网页的情况下,对网页的某部分进行更新, ...

- 关于tensorflow conv2d卷积备忘的一点理解

**************input************** [[[[-0.36166722 0.04847232 1.20818889 -0.1794038 -0.53244466] [ ...

- HTTPS过程以及详细案例

1.HTTPS的过程 1.客户端向服务端发送请求,客户端主要向服务器提供以下信息: 支持的协议版本,比如TLS 1.0版. 一个客户端生成的随机数,稍后用于生成"对话密钥". 支持 ...

- RocketMQ源码 — 四、 Consumer 接收消息过程

Consumer consumer pull message 订阅 在Consumer启动之前先将自己放到一个本地的集合中,再以后获取消费者的时候会用到,同时会将自己订阅的信息告诉broker 接收消 ...

- linux命令-awk入门

最近经常查看nginx日志,有时候需要做一些统计分析,于是就想起了awk,学习了就顺便做一个记录. 目录 概述:简单介绍awk背景原理 基本用法:常用到的awk语法 内建变量 综合实例 概述 awk是 ...

- Facebook ATC弱网环境搭建

用户的网络环境千姿百态,弱网的.高延时的.丢包的.常有用户反馈偶发bug,我们测试人员却始终无法复现,根据用户的描述,开发排查可能是网络不稳定导致的,所以急需建个弱网环境来测试. 弱网工具简介: Au ...

- python重试库retryiny源码剖析

上篇博文介绍了常见需要进行请求重试的场景,本篇博文试着剖析有名的python第三方库retrying源码. 在剖析其源码之前,有必要讲一下retrying的用法,方便理解. 安装: pip insta ...

- 2016 ACM/ICPC亚洲区青岛站现场赛(部分题解)

摘要 本文主要列举并求解了2016 ACM/ICPC亚洲区青岛站现场赛的部分真题,着重介绍了各个题目的解题思路,结合详细的AC代码,意在熟悉青岛赛区的出题策略,以备战2018青岛站现场赛. HDU 5 ...

- Javascript Cookie小插件

var ManagerCookie = function(){ //添加cookie function addCookie(key,value,time,path){ key = encodeURI( ...