手把手教你使用Python爬取西刺代理数据(下篇)

/1 前言/

前几天小编发布了手把手教你使用Python爬取西次代理数据(上篇),木有赶上车的小伙伴,可以戳进去看看。今天小编带大家进行网页结构的分析以及网页数据的提取,具体步骤如下。

/2 首页分析及提取/

首先进入网站主页,如下图所示。

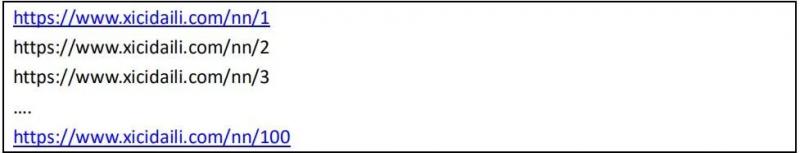

简单分析下页面,其中后面的 1 是页码的意思,分析后发现每一页有100 多条数据,然后网站底部总共有 2700+页 的链接,所以总共ip 代理加起来超过 27 万条数据,但是后面的数据大部分都是很多年前的数据了,比如 2012 年,大概就前 5000 多条是最近一个月的,所以决定爬取前面100 页。通 过网站 url 分析,可以知道这 100 页的 url 为:

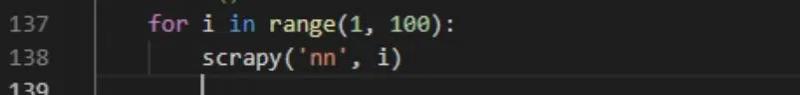

规律显而易见,在程序中,我们使用一个 for 循环即可完整这个操作:

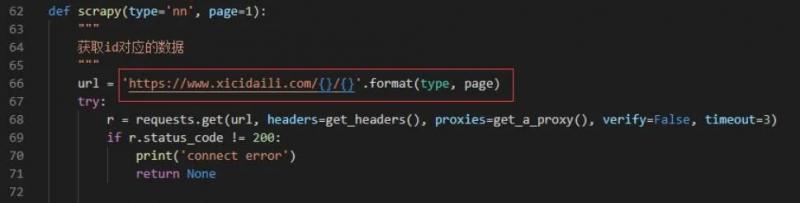

其中 scrapy 函数是爬取的主要逻辑,对应的代码为:

通过这个方式,我们可以得到每一页的数据。

/3 网页元素分析及提取/

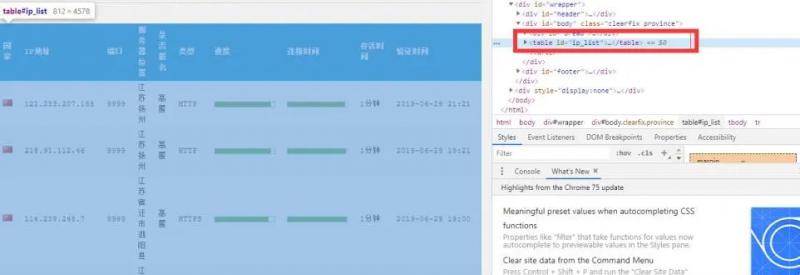

接下来就是对页面内的元素进行分析,提取其中的代理信息。

如上图,我们目的是进行代理地域分布分析,同时,在爬取过程中需要使用爬取的数据进行代 理更新,所以需要以下几个字段的信息:

Ip 地址、端口、服务器位置、类型

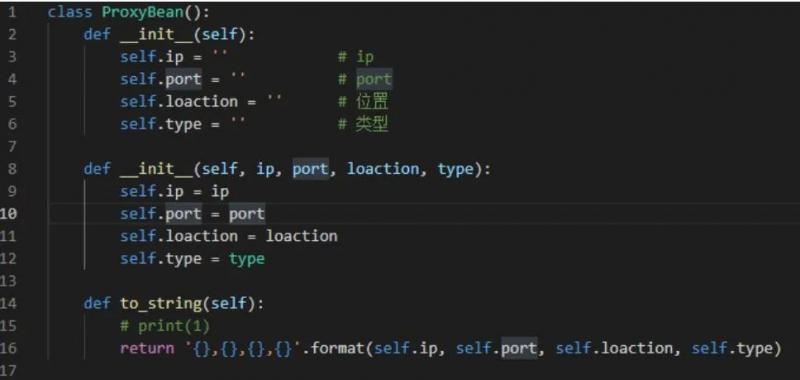

为此,先构建一个类,用于保存这些信息:

这样,每爬取一条信息,只要实例化一个 ProxyBean 类即可,非常方便。

接下来就是提取元素过程了,在这个过程我使用了正则表达式和 BeautifulSoup 库进行关键数据提取。

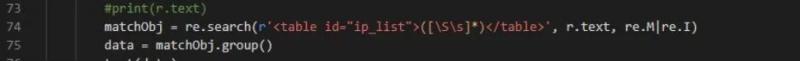

首先,通过分析网页发现,所有的条目实际上都是放在一个

我们首先通过正则表达式将该标签的内容提取出来:

正则表达式为:

, 表示搜索

之 间的任意字符组成的数据。Python 中的实现如下:

其中得到的 data 就是这个标签的内容了。下面进一步分析。

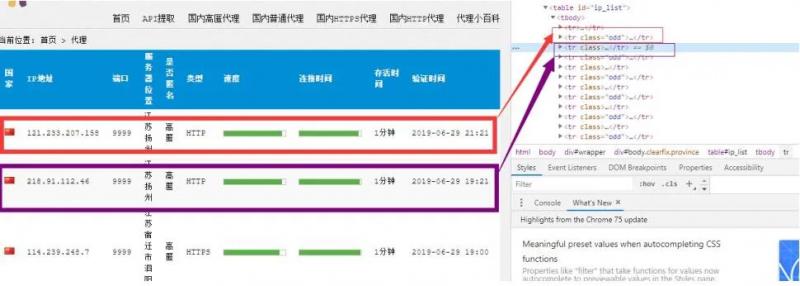

进入到 table 中,发现每一个代理分别站 table 的一列

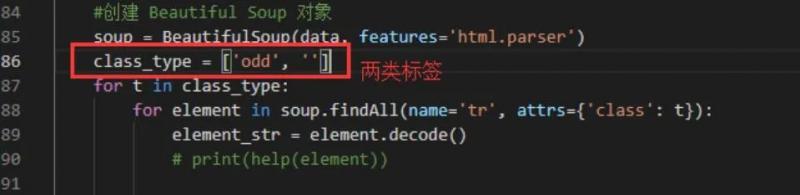

这个时候,可以使用 BeautifulSoup 对标签进行提取:

通过这种方式,就能获取到每一个列的列表了。

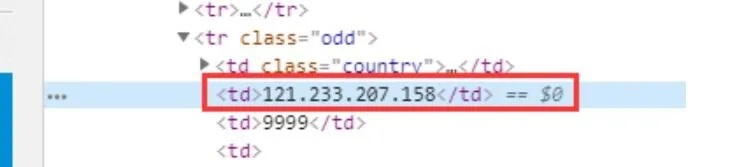

接下来就是从每个列中获取 ip、端口、位置、类型等信息了。进一步分析页面:

1、IP 字段:

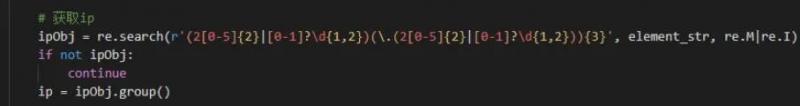

我们使用正则表达式对 IP 进行解析,IP 正则如下:

** (2[0-5]{2}|[0-1]?\d{1,2})(.(2[0-5]{2}|[0-1]?\d{1,2})){3}**

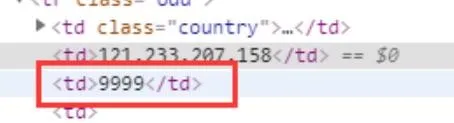

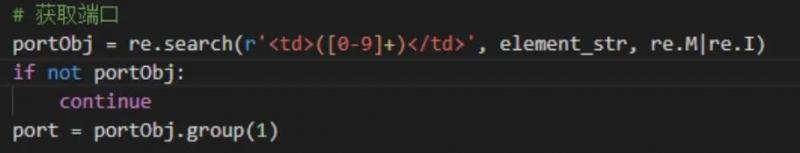

2、 端口字段

端口由

包裹,并且中间全部是数字,故可构造如下正则进行提取:

<td>([0-9]+)</td>

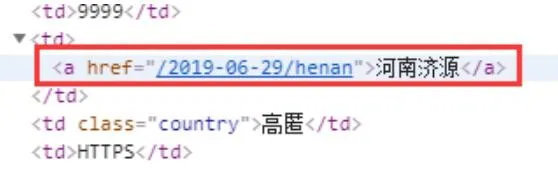

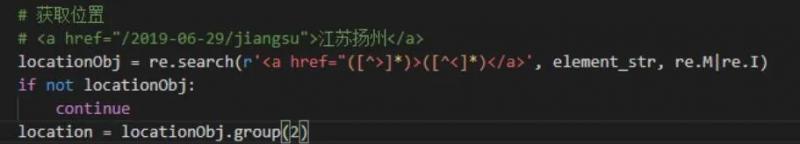

3、 位置字段

位置字段如下:

由 便签包裹,构造如下正则即可提取:

<a href="([>]*)>([<]*)

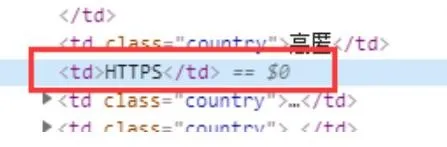

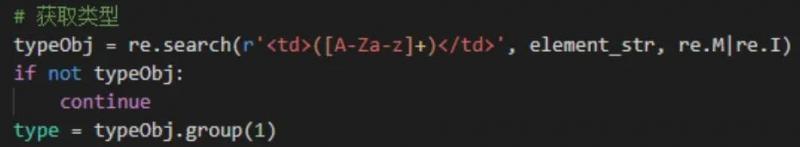

4、类型字段

类型字段如下:

由

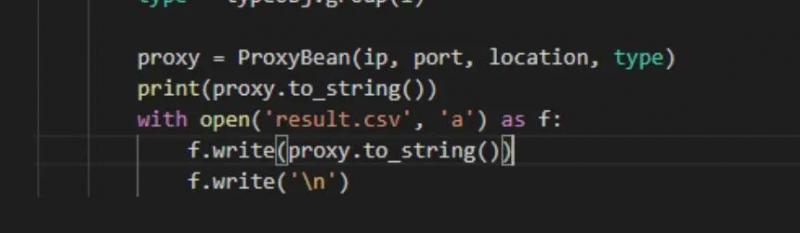

数据全部获取完之后,将其保存到文件中即可:

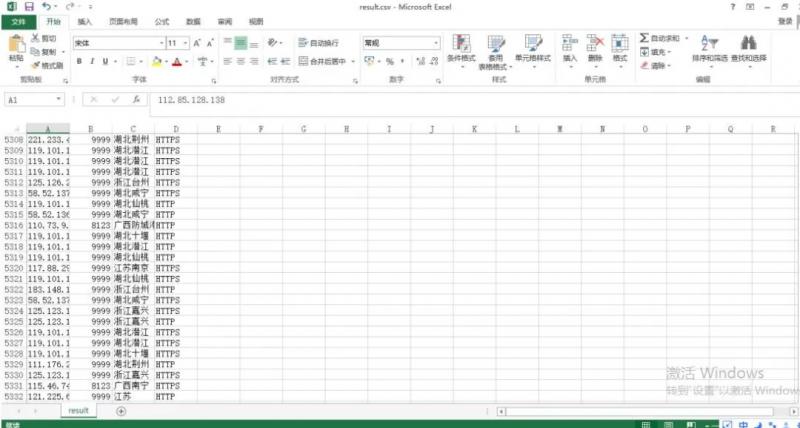

最后爬取的数据集如下图所示:

此次总共爬取了前面 5300 多条数据。

/4 小结/

本次任务主要爬取了代理网站上的代理数据。主要做了以下方面的工作:

1、学习 requests 库的使用以及爬虫程序的编写;

2、学习使用反爬虫技术手段,并在实际应用中应用这些技术,如代理池技术;

3、学习使用正则表达式,并通过正则表达式进行网页元素提取;

4、学习使用 beautifulsoup 库,并使用该库进行网页元素的提取。

Python爬虫是一项综合技能,在爬取网站的过程中能够学到很多知识,希望大家多多专研,需要代码的小伙伴,可以在[Python爬虫与数据挖掘]公众号后台回复“代理”二字,即可获取。

想学习更多关于Python的知识,可以参考Python爬虫与数据挖掘网站:http://pdcfighting.com/

本文由博客群发一文多发等运营工具平台 OpenWrite 发布

手把手教你使用Python爬取西刺代理数据(下篇)的更多相关文章

- 使用XPath爬取西刺代理

因为在Scrapy的使用过程中,提取页面信息使用XPath比较方便,遂成此文. 在b站上看了介绍XPath的:https://www.bilibili.com/video/av30320885?fro ...

- Python四线程爬取西刺代理

import requests from bs4 import BeautifulSoup import lxml import telnetlib #验证代理的可用性 import pymysql. ...

- Scrapy爬取西刺代理ip流程

西刺代理爬虫 1. 新建项目和爬虫 scrapy startproject daili_ips ...... cd daili_ips/ #爬虫名称和domains scrapy genspider ...

- python scrapy 爬取西刺代理ip(一基础篇)(ubuntu环境下) -赖大大

第一步:环境搭建 1.python2 或 python3 2.用pip安装下载scrapy框架 具体就自行百度了,主要内容不是在这. 第二步:创建scrapy(简单介绍) 1.Creating a p ...

- python+scrapy 爬取西刺代理ip(一)

转自:https://www.cnblogs.com/lyc642983907/p/10739577.html 第一步:环境搭建 1.python2 或 python3 2.用pip安装下载scrap ...

- python3爬虫-通过requests爬取西刺代理

import requests from fake_useragent import UserAgent from lxml import etree from urllib.parse import ...

- python爬取高匿代理IP(再也不用担心会进小黑屋了)

为什么要用代理IP 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经做案例的人,却不知道如何去学习更加高深的知识.那么针对这三类人 ...

- 爬取西刺ip代理池

好久没更新博客啦~,今天来更新一篇利用爬虫爬取西刺的代理池的小代码 先说下需求,我们都是用python写一段小代码去爬取自己所需要的信息,这是可取的,但是,有一些网站呢,对我们的网络爬虫做了一些限制, ...

- 爬取西刺网的免费IP

在写爬虫时,经常需要切换IP,所以很有必要自已在数据维护库中维护一个IP池,这样,就可以在需用的时候随机切换IP,我的方法是爬取西刺网的免费IP,存入数据库中,然后在scrapy 工程中加入tools ...

随机推荐

- 电脑网络诊断显示Win10无法与设备或资源(DNS)通信解决办法

最近是做多错多还是人有点儿衰神附体,软件,电脑系统,各种问题层出不穷,今天早上打开电脑发现不少软件都无法联网,神马百度商桥,腾讯浏览器,百度云...昨天百度商桥打不开还以为是软件出了问题,因为火狐浏览 ...

- Ubuntu系统在Anaconda中安装Python3.6的虚拟环境

原因:Anaconda的python版本是3.7的,TensorFlow尚不支持此版本,于是我们创建一个Python的虚拟环境以支持TensorFlow 创建tf环境 conda create --n ...

- [leetcode] 树 -Ⅰ

均为 Simple 难度的水题. 二叉树的中序遍历 题目[94]:给定一个二叉树,返回它的中序 遍历. 解题思路:Too simple. class Solution { public: vector ...

- H - 覆盖的面积(线段树-线段扫描 + 离散化(板题))

给定平面上若干矩形,求出被这些矩形覆盖过至少两次的区域的面积. Input 输入数据的第一行是一个正整数T(1<=T<=100),代表测试数据的数量.每个测试数据的第一行是一个正整数N(1 ...

- npm ERR! code ELIFECYCLE npm ERR! errno 1 npm ERR! test_vue_0613@1.0.0 dev: 错误的解决方法

错误原因在于由于文件 node_modules 太大,在项目上传时有些人会删掉 导致我们下载的项目中缺少这个文件 在尝试把自己项目的 node_modules文件夹直接复制过去之后发现问题还没有得到解 ...

- 如何在VMwareWorkstation中安装Ubuntu系统

文章更新于:2020-03-17 注:如果安装之后重启停留在Write through,则关闭客户机,将 ISO 镜像换为物理光驱,或取消勾选开机连接.再次开机即可正常进入系统. 文章目录 一.安装环 ...

- java web知识点复习,重新编写学生选课系统的先关操作。

为了复习之前学习的相关的html,javaweb等知识.自己有重新编写了一遍学生选课系统. 下面主要展示登录界面的代码,以及各个大的主页面的相关jsp. <%@ page language=&q ...

- 家庭版记账本app进度之关于listview显示账单,并为其添加点击事件

这个主要学习是关于listview的学习. 怎样去自定义adapter,以及使用.自己创建文件,还有就是为listview的每一个子控件添加点击事件. 在整个过程中收获到的知识点如下: 一.对于数据库 ...

- "字母全变大写"组件:<uppercase> —— 快应用组件库H-UI

<import name="uppercase" src="../Common/ui/h-ui/text/c_text_uppercase">& ...

- 接口自动化测试之-requests模块详解

一.requests背景 Requests 继承了urllib2的所有特性.Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国 ...