CDH5部署三部曲之三:问题总结

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

系列文章链接

本文是《CDH5部署三部曲》的终篇,前面两章完成了CDH5集群的部署和启动,本章将实战中遇到的问题做个总结,如果碰巧您也遇到过这些问题,希望本文能给您一些参考;

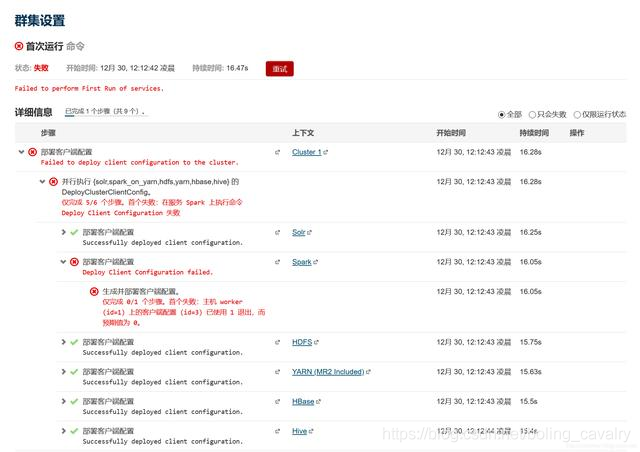

启动集群服务报错

- 首次启动集群服务报错,如下图:

- 上述错误一般是对应节点的/usr/java/default目录下没有JDK所致,假设已将JDK部署在/usr/lib/jvm/jdk1.8.0_191,那么只需执行以下命令建立软链接即可:

mkdir /usr/java &&ln -s /usr/lib/jvm/jdk1.8.0_191 /usr/java/default

- 点击页面上的重试按钮;

NFS Gateway启动失败

- 发现NFS Gateway服务有问题,检查日志:

- 日志如下,在worker1节点上,portmap和rpcbind这两个服务不存在导致的:

No portmap or rpcbind service is running on this host. Please start portmap or rpcbind service before attempting to start the NFS Gateway role on this host.

- 于是安装所需服务:

yum install -y nfs-utils rpcbind

- 启动服务:

systemctl start rpcbind

- 再次启动:

- 等待HDFS服务重启完成后,如下图,可见NFS Gateway问题已经消失:

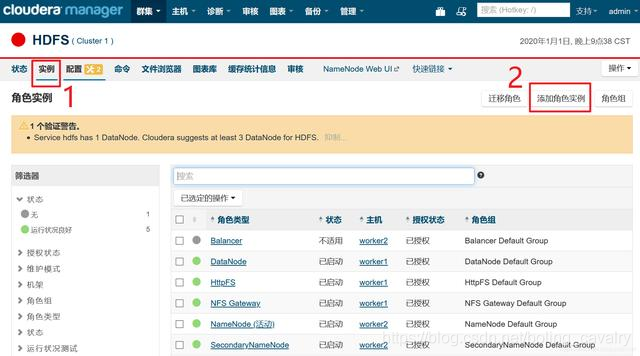

HDFS副本不足的块

- 问题如下图绿框所示:

- 目前只有一个datanode,可以增加一个,如下图,进入HDFS的实例页面,点击"添加角色实例":

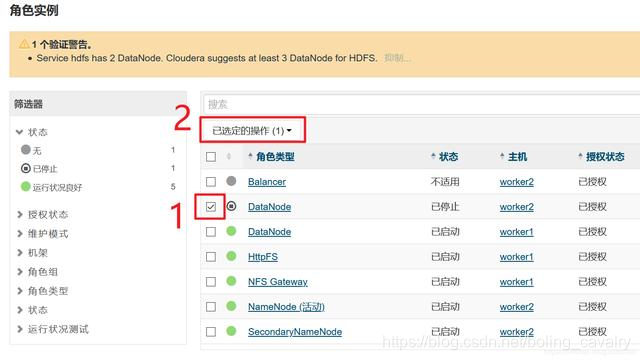

- 点击下图红框位置,增加一个DataNode:

- 如下图,确保worker1和worker2都选上:

- 勾选后,点击红框2中的按钮,在下拉菜单中点击“启动”:

- 现在有了两个DataNode,所以副本数可以设置为2,如下图红框所示,按照顺序找出参数进行设置,记得点击右下角的"保存更改"按钮:

- 上述设置完成后,新写入hdfs的文件副本数为2,如果要将之前已经写入的文件的副本数也调整为2,请SSH登录worker1节点,执行以下命令切换到hdfs账号:

su - hdfs

- 以hdfs账号的身份执行以下命令,即可完成副本数设置:

hadoop fs -setrep -R 2 /

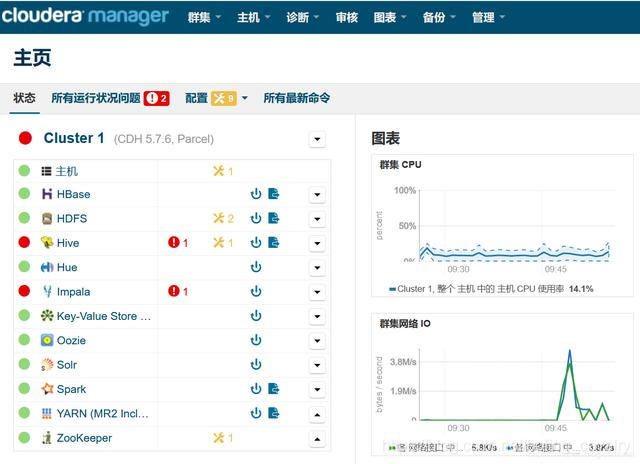

- 返回管理页面,可见HDFS的状态变成了健康:

Hive报错

- 如下图红框所示,Hive启动失败,日志中提示Version information not found in metastore

- 从上图可见Hive服务在worker2上,于是SSH登录worker2,将/usr/share/java目录下的mysql-connector-java.jar文件复制到这个目录下:/opt/cloudera/parcels/CDH-5.7.6-1.cdh5.7.6.p0.6/lib/hive/lib/

- 在Hive的配置页面,搜索"hive.metastore.schema.verification",如下图,确保红框3中的复选框取消勾选:

- 修改配置datanucleus.autoCreateSchema,如下图,确保红框3中的复选框被选中:

- 重启完成后,Hive状态为健康:

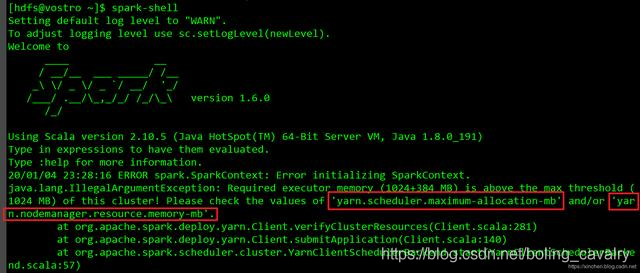

spark-shell执行失败

- 在worker1或者worker2上执行spark-shell命令进入spark控制台时,会产生内存相关的错误,需要调整YARM相关的内存参数:

- 在YARN的配置页面,调整yarn.scheduler.maximum-allocation-mb和yarn.nodemanager.resource.memory-mb这两个参数的值,原有的值都是1G,现在都改成2G,如下图:

- 重启YARN;

- 重启Spark;

- 执行spark-shell命令之前,先执行命令su - hdfs切换到hdfs账号;

- 这次终于成功进入spark-shell交互模式:

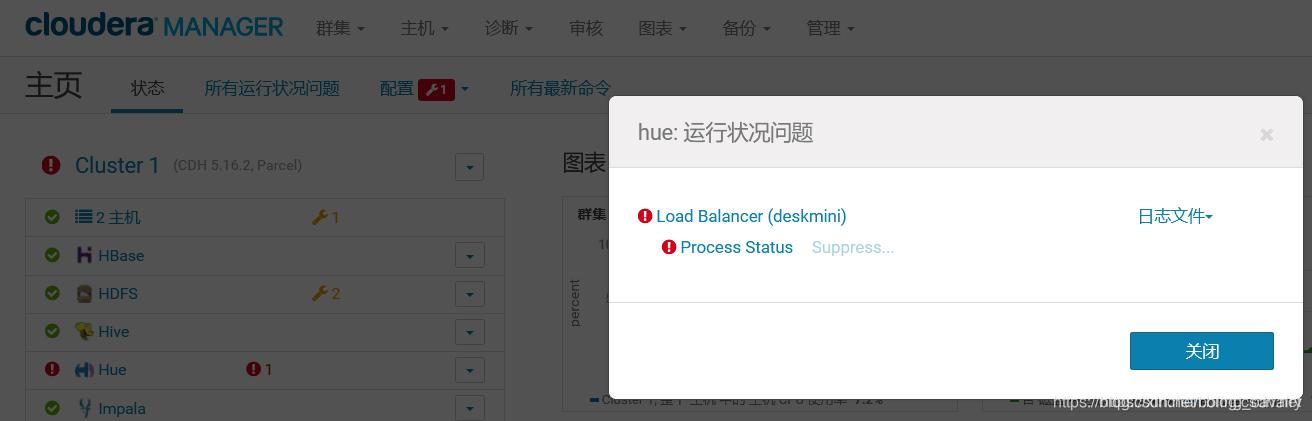

Hue启动失败

- Hue启动失败如下图:

- 上述失败是由于文件夹、文件、httpd服务没有准备好导致的,执行以下命令修复此问题:

mkdir /var/log/hue-httpd/

chown hue:hue /var/log/hue-httpd/

cd /var/log/hue-httpd/

touch error_log

chown hue:hue /var/log/hue-httpd/error_log

yum install -y httpd mod_ssl cyrus-sasl-plain cyrus-sasl-devel cyrus-sasl-gssapi

- 在网页上重启Hue服务,稍后可见服务已经正常:

以上就是本次实战过程中遇到的所有问题和解决方法,至此《CDH5部署三部曲》全部完成,如果您正在部署CDH,希望此系列文章能给您一些参考。

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

CDH5部署三部曲之三:问题总结的更多相关文章

- CDH5部署三部曲之一:准备工作

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- CDH5部署三部曲之二:部署和设置

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Docker下实战zabbix三部曲之三:自定义监控项

通过上一章<Docker下实战zabbix三部曲之二:监控其他机器>的实战,我们了解了对机器的监控是通过在机器上安装zabbix agent来完成的,zabbix agent连接上zabb ...

- Flink on Yarn三部曲之三:提交Flink任务

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Flink的DataSource三部曲之三:自定义

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- SQL Server 2008 数据库镜像部署实例之三 配置见证服务器

SQL Server 2008 数据库镜像部署实例之三 配置见证服务器 前面已经完成了镜像数据库的配置,并进行那个了故障转移测试.接下来将部署见证服务器,实现自动故障转移. 一.关于见证服务器 1.若 ...

- kubernetes下的Nginx加Tomcat三部曲之三:实战扩容和升级

本章是<kubernetes下的Nginx加Tomcat三部曲系列>的终篇,今天咱们一起在kubernetes环境对下图中tomcat的数量进行调整,再修改tomcat中web工程的源码, ...

- Docker搭建disconf环境,三部曲之三:细说搭建过程

Docker下的disconf实战全文链接 <Docker搭建disconf环境,三部曲之一:极速搭建disconf>: <Docker搭建disconf环境,三部曲之二:本地快速构 ...

- CoProcessFunction实战三部曲之三:定时器和侧输出

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

随机推荐

- Activiti7 zip部署,查询及其删除

zip部署 package com.itheima.activiti; import org.activiti.engine.ProcessEngine; import org.activiti.en ...

- Zabbix如何监控Linux防火墙服务

今天在巡检的时候,突然想到Zabbix能否监控Linux的防火墙服务呢? 显然是可以的,但是Zabbix 5下默认的模板"Template OS Linux by Zabbix agent& ...

- 20190925-03Redis端口号的由来及单线程加多路IO复用 000 024

- i春秋公益赛之signin

题目链接:https://buuoj.cn/challenges#gyctf_2020_signin 查看程序保护 只开了canary和NX保护,在IDA查看反编译出来的为代码时发现程序给了一个后门 ...

- jzoj 6798. 【2014广州市选day2】regions

Description 在平面上堆叠着若干矩形,这些矩形的四边与平面X坐标轴或Y坐标轴平行.下图展示了其中一种情况,3个矩形的边将平面划分成8个区域: 下面展示了另一种稍稍复杂一些的情况: 你的任务是 ...

- Kubernetes K8S之Pod跨namespace名称空间访问Service服务

Kubernetes的两个Service(ServiceA.ServiceB)和对应的Pod(PodA.PodB)分别属于不同的namespace名称空间,现需要PodA和PodB跨namespace ...

- Coneology(POJ 2932)

原题如下: Coneology Time Limit: 5000MS Memory Limit: 65536K Total Submissions: 4937 Accepted: 1086 D ...

- Django进入监听端口就自动打开指定页面,无需导航栏手动添加(Django六)

在我们进入监听端口时画面如下:而因为在urls.py中写过如下语句 我们在监听端口后加上/login就会跳转到login.html页面,如下图 那么如何一打开监听端口就可以走动跳转到login.htm ...

- k8s数据管理(八)

volume 我们经常会说:容器和 Pod 是短暂的.其含义是它们的生命周期可能很短,会被频繁地销毁和创建.容器销毁时,保存在容器内部文件系统中的数据都会被清除. 为了持久化保存容器的数据,可以使用 ...

- bash运行脚本的几种方式

转载自https://www.jianshu.com/p/ba6efda13e23 转载地址:http://www.jquerycn.cn/a_8354 bash shell 脚本执行的方法有多种,本 ...