Python3.5:爬取网站上电影数据

首先我们导入几个pyhton3的库:

from urllib import request

import urllib

from html.parser import HTMLParser

在Python2和Python3之间一个重要区别就是,在Python2有urllib,urllib2两个库,在Python3整合到一起,里面的函数方式也有一点变,先定义一个函数,将header,url,request,都打包成一个函数方便调用,且看下面代码:

def print_movies(url):

# 伪装成浏览器访问网站,但其实没啥用,很容易被中间件检测出来,但没有又不行,所以蛮写吧

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36'}

# Python3的urllib

req = urllib.request.Request(url, headers=header)

s = urllib.request.urlopen(req)

parser = MovieParser()

parser.feed((s.read()).decode('utf-8'))

s.close()

再重载HTMLParser库的handle_starttag(self, tag, attrs),系统就会默认调用用户重载的,具体调用方式在官方文档里面详细介绍:HTMLParser,

class MovieParser(HTMLParser):

def __init__(self):

HTMLParser.__init__(self)

self.movies = []

# 重载HTMLParser自带的函数

def handle_starttag(self, tag, attrs):

def _attr(attrlist, attrname):

for attr in attrlist:

if attr[0] == attrname:

return attr[1]

return None

# 可以在这class后面找到每个li标签的特征属性比如catrgory在下面判断

if tag == 'li' and _attr(attrs, 'data-title'):

movie= {}

movie['title'] = _attr(attrs, 'data-title')

movie['rate'] = _attr(attrs, 'data-rate')

movie['director'] = _attr(attrs, 'data-director')

movie['actors'] = _attr(attrs, 'data-actors')

self.movies.append(movie)

print('%(title)s|%(rate)s|%(director)s|%(actors)s' % movie)

当我们执行到parser.feed((s.read()).decode('utf-8'))时,知道为什么要这样写,首先parser时HTMLParser的子类所以包括feed(),在注入数据时,s.read()是返回bytes类型,但feed()只接受str类型,所以直接在后面加个decode('utf-8')即转码(三个bytes转换为一个中文),又可以转换为str,基本获取数据就这么简单,要是想获取别的网站的数据,可以换个url和条件判断就可以了,我把全部代码贴上来:

from urllib import request

import urllib

from html.parser import HTMLParser class MovieParser(HTMLParser):

def __init__(self):

HTMLParser.__init__(self)

self.movies = []

# 重载HTMLParser自带的函数

def handle_starttag(self, tag, attrs):

def _attr(attrlist, attrname):

for attr in attrlist:

if attr[0] == attrname:

return attr[1]

return None

# 可以在这class后面找到每个li标签的特征属性比如catrgory在下面判断

if tag == 'li' and _attr(attrs, 'data-title'):

movie= {}

movie['title'] = _attr(attrs, 'data-title')

movie['rate'] = _attr(attrs, 'data-rate')

movie['director'] = _attr(attrs, 'data-director')

movie['actors'] = _attr(attrs, 'data-actors')

self.movies.append(movie)

print('%(title)s|%(rate)s|%(director)s|%(actors)s' % movie) def print_movies(url):

# 伪装成浏览器访问网站,但其实没啥用,很容易被中间件检测出来,但没有又不行,所以蛮写吧

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36'}

# Python3的urllib

req = urllib.request.Request(url, headers=header)

s = urllib.request.urlopen(req)

parser = MovieParser()

parser.feed((s.read()).decode('utf-8'))

s.close() if __name__ == '__main__':

url = 'https://movie.douban.com/'

# 返回一个电影列表

print_movies(url)

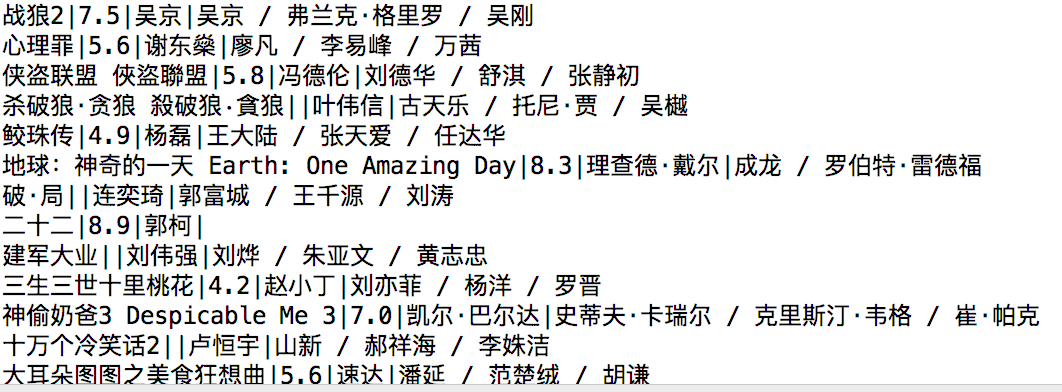

运行结果为:

Python3.5:爬取网站上电影数据的更多相关文章

- Python爬取网站上面的数据很简单,但是如何爬取APP上面的数据呢

- 使用scrapy爬取网站的商品数据

目标是爬取网站http://www.muyingzhijia.com/上全部的商品数据信息,包括商品的一级类别,二级类别,商品title,品牌,价格. 搜索了一下,python的scrapy是一个不错 ...

- 基础爬虫,谁学谁会,用requests、正则表达式爬取豆瓣Top250电影数据!

爬取豆瓣Top250电影的评分.海报.影评等数据! 本项目是爬虫中最基础的,最简单的一例: 后面会有利用爬虫框架来完成更高级.自动化的爬虫程序. 此项目过程是运用requests请求库来获取h ...

- 使用Selenium爬取网站表格类数据

本文转载自一下网站:Python爬虫(5):Selenium 爬取东方财富网股票财务报表 https://www.makcyun.top/web_scraping_withpython5.html 需 ...

- C# 爬取网页上的数据

最近工作中需求定时爬取不同城市每天的温度.其实就是通过编程的方法去抓取不同网站网页进行分析筛选的过程..NET提供了很多类去访问并获得远程网页的数据,比如WebClient类和HttpWebReque ...

- Python3爬虫爬取淘宝商品数据

这次的主要的目的是从淘宝的搜索页面获取商品的信息.其实分析页面找到信息很容易,页面信息的存放都是以静态的方式直接嵌套的页面上的,很容易找到.主要困难是将信息从HTML源码中剥离出来,数据和网页源码结合 ...

- python3 requests_html 爬取智联招聘数据(简易版)

PS重点:我回来了-----我回来了-----我回来了 1. 基础需要: python3 基础 html5 CS3 基础 2.库的选择: 原始库 urllib2 (这个库早些年的用过,后来淡忘了) ...

- python 实现爬取网站下所有URL

python3 实现爬取网站下所有URL 获取首页元素信息: 首页的URL链接获取: 遍历第一次返回的结果: 递归循环遍历: 全部代码如下: 小结: python3.6 requests && ...

- Python转页爬取某铝业网站上的数据

天行健,君子以自强不息:地势坤,君子以厚德载物! 好了废话不多说,正式进入主题,前段时间应朋友的请求,爬取了某铝业网站上的数据.刚开始呢,还是挺不愿意的(主要是自己没有完整的爬取过网上的数据哎,即是不 ...

随机推荐

- SUCTF--WEB

题目:flag 在哪? 介绍:网址(http://23.106.143.230/a_real_babyweb.php) 1,打开网址,抓包可以发现在 HTTP 头里面有 Cookie:suctf{Th ...

- Tomcat:Can't load AMD 64-bit .dll on a IA 32 platform(问题记录)

从报错看,这主要是应为64位-32位不兼容导致的.好在,在报此错的情况下,tomcat还是跑起来了. 具体来说,从网上搜索的一些资料来看,应该是jdk版本与tomcat不一致 .tomcat我的是64 ...

- centos6.5 短信猫部署发短信

本文为在centos下部署短信猫发短信使用,以下为具体环境和步骤说明,欢迎留言! 一.环境说明 服务器:centos6.5 x64 依赖包:lockdev-1.0.1-18.el6.x86_64.rp ...

- day01_HTML

今日任务 网站信息页面案例 网站图片信息页面案例 网站友情链接页面案例 网站首页案例 网站后台页面案例 教学目标 了解什么是标记语言 了解HTML的框架标签 掌握HTML的主要标签(字体,图片,列表, ...

- java基础回顾(一)

java的特点:开源.安全.跨平台.简单易懂.一次编译可多处运行. JDK:java开发工具包 JDK = JRE+JAVA开发工具 保证能够实现java开发的最小单元 JRE:java运行环境 JR ...

- 51Nod 1267 4个数和为0 二分

给出N个整数,你来判断一下是否能够选出4个数,他们的和为0,可以则输出"Yes",否则输出"No".Input第1行,1个数N,N为数组的长度(4 <= ...

- 超简单的php缓存类

<?php class Cache { private $dir = "data/cache/";//定义缓存目录 private $key='c_a_sss'; // 文件 ...

- 【epubcfi函数generateRangeFromCfi和generateCfiFromRange】两者的区别和适用性,以及另一种实现

epubcfi是描述epub规范电子书中文本位置的一种描述符,它是形如" epubcfi(/6/4[Section0017.xhtml]!4/42/178/1:0,4/42/198/1:1) ...

- Pythonh中的zip()与*zip()函数详解

前言 实验环境: Python 3.6: 示例代码地址:下载示例: 本文中元素是指列表.元组.字典等集合类数据类型中的下一级项目(可能是单个元素或嵌套列表). zip(*iterables)函数详解 ...

- Spring Cloud 前后端分离后引起的跨域访问解决方案

背景 Spring Cloud 微服务试点改造,目前在尝试前后端分离. 前台A应用(本机8080端口),通过网管(本机8769端口)调用后台应用B(本机8082端口).应用C发布的http服务.. A ...