我的第一个python爬虫

我的第一个爬虫,哈哈,纯面向过程

实现目标:

1.抓取本地conf文件,其中的URL地址,然后抓取视频名称以及对应的下载URL

2.抓取URL会单独写在本地路径下,以便复制粘贴下载

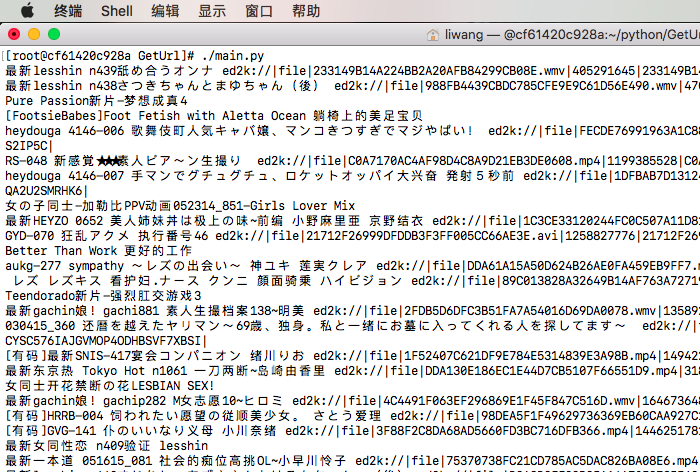

废话补多少,代码实现效果如下:

代码如下:

#!/usr/local/python/bin/python3

import requests

import re

import chardet

import random

import signal

import time

import os

import sys

def DealwithURL(url):

r = requests.get(url)

pattern = re.compile('<meta http-equiv="refresh" content="0.1;url=')

findurl=re.findall(pattern,r.text)

if findurl:

pattern = re.compile('<meta http-equiv="refresh" content="0.1;url=(.*)"')

transferurl = re.findall(pattern,r.text)[0]

return transferurl

else :

return True

def GetNewURL(url):

r = requests.get(url)

r.encoding='utf-8'

pattern = re.compile('alert(.*)">')

findurl=re.findall(pattern,r.text)

findurl_str = (" ".join(findurl))

return (findurl_str.split(' ',1)[0][2:])

def gettrueurl(url):

if DealwithURL(url)==True:

return url

else :

return GetNewURL(DealwithURL(url))

def SaveLocalUrl(untreatedurl,treatedurl):

if untreatedurl == treatedurl :

pass

else :

try:

fileconf = open(r'main.conf','r')

rewritestr = ""

for readline in fileconf:

if re.search(untreatedurl,readline):

readline = re.sub(untreatedurl,treatedurl,readline)

rewritestr = rewritestr + readline

else :

rewritestr = rewritestr + readline

fileconf.close()

fileconf = open(r'main.conf','w')

fileconf.write(rewritestr)

fileconf.close()

except:

print ("get new url but open files ng write to logs")

def handler(signum,frame):

raise AssertionError

def WriteLocalDownloadURL(downfile,downurled2k):

urlfile = open(downfile,'a+')

urlfile.write(downurled2k+'\n')

def GetDownloadURL(sourceurl,titleurl,titlename,update_file,headers):

downurlstr = (" ".join(titleurl))

downnamestr = (" ".join(titlename))

r = requests.get((sourceurl+downurlstr),headers)

pattern = re.compile('autocomplete="on">(.*)/</textarea></div>')

downurled2k = re.findall(pattern,r.text)

downurled2kstr = (" ".join(downurled2k))

WriteLocalDownloadURL(update_file , downurled2kstr)

print (downnamestr , downurled2kstr)

def ReadLocalFiles() :

returndict={}

localfiles = open(r'main.conf')

readline = localfiles.readline().rstrip()

while readline :

if readline.startswith('#'):

pass

else:

try:

readline = readline.rstrip()

returndict[readline.split('=')[0]] = readline.split('=')[1]

except:

print ("Please Check your conf %s" %(readline))

sys.exit(1)

readline = localfiles.readline().rstrip()

localfiles.close()

return returndict

def GetListURLinfo(sourceurl , title , getpagenumber , total,update_file,headers):

if total >= 100:

total = 100

if total <= 1:

total = 2

getpagenumber = total

for number in range(0,total) :

try:

signal.signal(signal.SIGALRM,handler)

signal.alarm(3)

url = sourceurl + title + '-' + str(random.randint(1,getpagenumber)) + '.html'

r = requests.get(url,headers)

pattern = re.compile('<div class="info"><h2>(.*)</a><em></em></h2>')

r.encoding = chardet.detect(r.content)['encoding']

allurl = re.findall(pattern,r.text)

for lineurl in allurl:

try:

signal.signal(signal.SIGALRM,handler)

signal.alarm(3)

pattern = re.compile('<a href="(.*)" title')

titleurl = re.findall(pattern,lineurl)

pattern = re.compile('title="(.*)" target=')

titlename = re.findall(pattern,lineurl)

GetDownloadURL(sourceurl,titleurl,titlename,update_file,headers)

signal.alarm(0)

except AssertionError:

print (lineurl,titlename , "Timeout Error: the cmd 10s have not finished")

continue

# title = '/list/'+str(random.randint(1,8))

# print (title)

# print (title_header)

except AssertionError:

print ("GetlistURL Infor Error")

continue

def GetTitleInfo(url,down_page,update_file,headers):

title = '/list/'+str(random.randint(1,8))

titleurl = url + title + '.html'

r = requests.get(titleurl,headers)

r.encoding = chardet.detect(r.content)['encoding']

pattern = re.compile(' 当前:.*/(.*)页 ')

getpagenumber = re.findall(pattern,r.text)

getpagenumber = (" ".join(getpagenumber))

GetListURLinfo(url , title , int(getpagenumber) , int(down_page),update_file,headers)

def write_logs(time,logs):

loginfo = str(time)+logs

try:

logfile = open(r'logs','a+')

logfile.write(loginfo)

logfile.close()

except:

print ("Write logs error,code:154")

def DeleteHisFiles(update_file):

if os.path.isfile(update_file):

try:

download_files = open(update_file,'r+')

download_files.truncate()

download_files.close()

except:

print ("Delete " + update_file + "Error --code:166")

else :

print ("Build New downfiles")

def main():

headers = {"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_5) AppleWebKit 537.36 (KHTML, like Gecko) Chrome","Accept": "text/html,application/xhtml+xml,application/xml; q=0.9,image/webp,*/*;q=0.8"}

readconf = ReadLocalFiles()

try:

file_url = readconf['url']

down_page = readconf['download_page']

update_file = readconf['download_local_files']

except:

print ("Get local conf error,please check it")

sys.exit(-1)

DeleteHisFiles(update_file)

untreatedurl = file_url

treatedurl = gettrueurl(untreatedurl)

SaveLocalUrl(untreatedurl,treatedurl)

url = treatedurl

GetTitleInfo(url,int(down_page),update_file,headers)

if __name__=="__main__":

main()

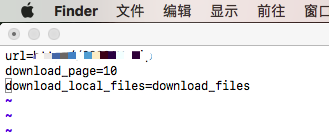

对应的main.conf如下:

本着对爬虫的好奇来写下这些代码,如有对代码感兴趣的,可以私聊提供完整的conf信息,毕竟,我也是做运维的,要脸,从不用服务器下片。

我的第一个python爬虫的更多相关文章

- 一个python爬虫小程序

起因 深夜忽然想下载一点电子书来扩充一下kindle,就想起来python学得太浅,什么“装饰器”啊.“多线程”啊都没有学到. 想到廖雪峰大神的python教程很经典.很著名.就想找找有木有pdf版的 ...

- 记我的第一个python爬虫

捣鼓了两天,终于完成了一个小小的爬虫代码.现在才发现,曾经以为那么厉害的爬虫,在自己手里实现的时候,也不过如此.但是心里还是很高兴的. 其实一开始我是看的慕课上面的爬虫教学视屏,对着视屏的代码一行行的 ...

- 我的第一个Python爬虫——谈心得

2019年3月27日,继开学到现在以来,开了软件工程和信息系统设计,想来想去也没什么好的题目,干脆就想弄一个实用点的,于是产生了做“学生服务系统”想法.相信各大高校应该都有本校APP或超级课程表之类的 ...

- 一个Python爬虫工程师学习养成记

大数据的时代,网络爬虫已经成为了获取数据的一个重要手段. 但要学习好爬虫并没有那么简单.首先知识点和方向实在是太多了,它关系到了计算机网络.编程基础.前端开发.后端开发.App 开发与逆向.网络安全. ...

- 我的第一个 python 爬虫脚本

#!/usr/bin/env python# coding=utf-8import urllib2from bs4 import BeautifulSoup #res = urllib.urlopen ...

- 写一个python 爬虫爬取百度电影并存入mysql中

目标是利用python爬取百度搜索的电影 在类型 地区 年代各个标签下 电影的名字 评分 和图片连接 以及 电影连接 首先我们先在mysql中建表 create table liubo4( id in ...

- 第一个python爬虫程序

1.安装Python环境 官网https://www.python.org/下载与操作系统匹配的安装程序,安装并配置环境变量 2.IntelliJ Idea安装Python插件 我用的idea,在工具 ...

- 一个python爬虫工具类

写了一个爬虫工具类. # -*- coding: utf-8 -*- # @Time : 2018/8/7 16:29 # @Author : cxa # @File : utils.py # @So ...

- 我的第一个python爬虫程序

程序用来爬取糗事百科上的图片的,程序设有超时功能,具有异常处理能力 下面直接上源码: #-*-coding:utf-8-*- ''' Created on 2016年10月20日 @author: a ...

随机推荐

- 可空类型(Nullable)

C# 单问号 ? 与 双问号 ?? ? : 单问号用于对 int,double,bool 等无法直接赋值为 null 的数据类型进行 null 的赋值,意思是这个数据类型是 NullAble 类型的. ...

- JS高级-ES6

let/const case1 { //js var a = 10 a = 20 // es6 let b = 10 b = 30 const c = 10 c = 40 //报错 } case2 { ...

- mysql 使用 GROUP BY 时报错 ERROR 1055 (42000)

解决方法1:SET sql_mode=(SELECT REPLACE(@@sql_mode,'ONLY_FULL_GROUP_BY',''));这种修改只是暂时性的,还是在 my.ini 文件中的sq ...

- java 栈 最大深度

1. 概述 某公司面试,总监大叔过来,问了图论及栈的最大深度,然后^_^ 一直记着,今天搞一下 2. 代码 package com.goodfan.test; public class JavaS ...

- android 开发 更好的数据存放,回调,处理class模式,适合与各种布局适配器class一起使用

预先导入数据模式: /** * Created by lenovo on 2018/5/18. */ public class DeivceListData { private DeivceListD ...

- Java 身份证判断性别获取年龄

import com.alibaba.fastjson.JSON; import org.junit.Test; import java.text.SimpleDateFormat; import j ...

- linux面试题-基础题1

第1章 基础题1 1.1 在装系统创建Linux分区时,一般至少需要创建两个分区( ) A.FAT.NTFS B. /usr.swap C. /boot.swap D.swap./ 1.2 ...

- STS(eclipse)3.7.3新建项目报错:org.apache.maven.archiver.MavenArchiver.getManifest(org.apache.maven.project.MavenProject, org.apache.maven.archiver.MavenArchiveConfiguration)

烦人的版本兼容问题 没有使用sts3.7.3系统内嵌的maven3.3.3,调整为稍高版本的maven3.5.2,懒得修改配置了. 升级eclipse插件吧. Eclipse,Help -> I ...

- Activity中满屏和去标题的实现方法

两种方式: 在xml文件中进行配置 在项目的清单文件AndroidManifest.xml中,找到需要全屏或设置成无标题栏的Activity,在该Activity进行如下配置即可. 实现全屏效果: a ...

- SQL With (递归CTE查询)

指定临时命名的结果集,这些结果集称为公用表表达式 (CTE).该表达式源自简单查询,并且在单条 SELECT.INSERT.UPDATE 或 DELETE 语句的执行范围内定义.该子句也可用在 CRE ...