基于nodeJS的小说爬虫实战

背景与需求分析

最近迷恋于王者荣耀、斗鱼直播与B站吃播视频,中毒太深,下班之后无心看书。

为了摆脱现状,能习惯看书,我开始看小说了,然而小说网站广告多而烦,屌丝心态不愿充钱,于是想到了爬虫。

功能分析

为了将网上小说内容获取到本地,进行了功能分析:

1、获取每个章节列表地址

2、更加每个章节地址,获取每个章节的内容

3、将获取的各个章节内容有序的写入文件

技术调研

作为一个前端er,实现爬虫nodeJS必须是首选,虽然数据挖掘Python才是真理

npm依赖如下

1、爬取内容 superagent

2、分析爬取的内容 cheerio

3、并发 async

4、文件写入 fs

编码实现

xiaoshuo.js代码如下

const cheerio = require('cheerio')

const superagent = require('superagent')

require('superagent-charset')(superagent)

const async = require('async');

const fs = require('fs');

let baseUrl = 'http://www.xxx.com/book/14435/';

let infos = [];

let urls = [];

let titles = [];

let fileName = '';

superagent.get(baseUrl).charset('UTF-8').end((err,res)=>{

var $ = cheerio.load(res.text);

// 读取章节列表页面

$('.am-book-list').eq(1).find('.am-u-lg-4 a').each((i, v) => {

let link = 'http://www.xxx.com' + $(v).attr('href')

urls.push(link);

fileName = $('.am-book-info h2').text()+'.txt';

})

let id = 0;

//获取每个章节列表

async.mapLimit(urls,urls.length,(url,callback)=>{

id++

fetchUrl(url,callback,id);

},(err,results)=>{

//将文件写入本地

fs.existsSync(fileName);

for(var i = 0;i<results.length-1;i++){

fs.appendFileSync(fileName, results[i].title) //

fs.appendFileSync(fileName, results[i].content)

}

})

})

function fetchUrl(url,callback,id){

superagent.get(url)

.charset('UTF-8')

.end(function(err,res){

let $ = cheerio.load(res.text);

let arr = []

let content = reconvert($("#am-read-centent").text())

const obj = {

id: id,

err: 0,

title: '\n'+$('#am-book-h3').text(), //标题

content: '\n'+trim(content.toString()) //内容

}

callback(null,obj)

})

}

function reconvert(str) {

str = str.replace(/(&#x)(\w{1,4});/gi, function ($0) {

return String.fromCharCode(parseInt(escape($0).replace(/(%26%23x)(\w{1,4})(%3B)/g, "$2"), 16));

});

return str

}

function trim(str){

return str.replace(/(^\s*)|(\s*$)/g, '').replace(/ /g, '')

}

为了避免坐牢,站点使用xxx代替,

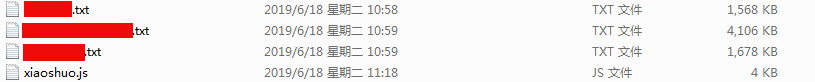

运行效果

在命令行运行 node xiaoshuo,试验了本小说,好像还是ok的,哈哈哈

基于nodeJS的小说爬虫实战的更多相关文章

- python 基于aiohttp的异步爬虫实战

钢铁知识库,一个学习python爬虫.数据分析的知识库.人生苦短,快用python. 之前我们使用requests库爬取某个站点的时候,每发出一个请求,程序必须等待网站返回响应才能接着运行,而在整个爬 ...

- 基于NodeJs的网页爬虫的构建(二)

好久没写博客了,这段时间已经忙成狗,半年时间就这么没了,必须得做一下总结否则白忙.接下去可能会有一系列的总结,都是关于定向爬虫(干了好几个月后才知道这个名词)的构建方法,实现平台是Node.JS. 背 ...

- 基于NodeJs的网页爬虫的构建(一)

好久没写博客了,这段时间已经忙成狗,半年时间就这么没了,必须得做一下总结否则白忙.接下去可能会有一系列的总结,都是关于定向爬虫(干了好几个月后才知道这个名词)的构建方法,实现平台是Node.JS. 背 ...

- 浏览器自动刷新——基于Nodejs的Gulp LiveReload与VisualStudio完美结合。

本文版权桂博客园和作者吴双共同所有,转载和爬虫请注明原文地址 http://www.cnblogs.com/tdws/p/6016055.html 写在前面 大家好我是博客园的蜗牛,博客园的蜗牛就是我 ...

- 基于nodejs模拟浏览器post请求爬取json数据

今天想爬取某网站的后台传来的数据,中间遇到了很多阻碍,花了2个小时才请求到数据,所以我在此总结了一些经验. 首先,放上我所爬取的请求地址http://api.chuchujie.com/api/?v= ...

- 爬虫实战:爬虫之 web 自动化终极杀手 ( 上)

欢迎大家前往腾讯云技术社区,获取更多腾讯海量技术实践干货哦~ 作者:陈象 导语: 最近写了好几个简单的爬虫,踩了好几个深坑,在这里总结一下,给大家在编写爬虫时候能给点思路.本次爬虫内容有:静态页面的爬 ...

- iKcamp团队制作|基于Koa2搭建Node.js实战项目教学(含视频)☞ 环境准备

安装搭建项目的开发环境 视频地址:https://www.cctalk.com/v/15114357764004 文章 Koa 起手 - 环境准备 由于 koa2 已经开始使用 async/await ...

- 32个Python爬虫实战项目,满足你的项目慌

爬虫项目名称及简介 一些项目名称涉及企业名词,小编用拼写代替 1.[WechatSogou]- weixin公众号爬虫.基于weixin公众号爬虫接口,可以扩展成其他搜索引擎的爬虫,返回结果是列表,每 ...

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

随机推荐

- 逻辑卷----LVM的基础和应用

逻辑卷管理器 Logical Volume Manager-------逻辑卷宗管理器.逻辑扇区管理器.逻辑磁盘管理器,是Linux核心所提供的逻辑卷管理(Logical volume managem ...

- for 循环用了那么多次,但你真的了解它么?

其实我们写代码的时候一直都在使用for循环,但是偶尔还是会纠结用哪一个循环. 一.基础的for循环 0.使用while也是一种循环方式,此处探究for相关的循环,就不做拓展了. 1.遍历数组的时候,初 ...

- attr(name|properties|key,value|fn)

attr(name|properties|key,value|fn) 概述 设置或返回被选元素的属性值.大理石平台厂家 参数 nameStringV1.0 属性名称 propertiesMapV1 ...

- Https Get Post

#region Http 访问 public string GetHttpUrl(string Url) { try { HttpWebRequest request = (HttpWebReques ...

- Confluence 6 在一个空间中查看所有附加的文件

有下面 2 种方法可以让你查看空间的所有附件.你可以: 使用 Space Attachments Macro 来在一个页面中显示列表文件. 进入空间后,然后从边栏的底部选择 空间工具(Space to ...

- P2015 二叉苹果树,树形dp

P2015 二叉苹果树 题目大意:有一棵二叉树性质的苹果树,每一根树枝上都有着一些苹果,现在要去掉一些树枝,只留下q根树枝,要求保留最多的苹果数(去掉树枝后不一定是二叉树) 思路:一开始就很直接的想到 ...

- Linux网络编程一、tcp三次握手,四次挥手

一.TCP报文格式 (图片来源网络) SYN:请求建立连接标志位 ACK:应答标志位 FIN:断开连接标志位 二.三次握手,数据传输,四次挥手 (流程图,图片来源于网络) (tcp状态转换图,图片来源 ...

- Android_activity实现一个简单的新建联系表

项目展示: 第一个Activity用于显示联系人信息 第二个Activity输入联系人信息 要求: 运行“新建联系人”程序,结果如下图所示: 点击“新建联系人”按钮,打开输入信息界面并输入姓名.公司. ...

- 线程系列5--java中的ThreadLocal类实现线程范围内的数据共享(二)

ThreadLocal类可以理解成一个类似与map集合使用,以当前线程当做key 来使用,将线程氛围内需要共享的数据当做value,形成键值对的形式使用.ThreadLocal和线程同步机制都是为了解 ...

- Laravel5.2中Eloquent与DB类的区别是什么?

要了解这些先看看关于数据库组件的那些事儿(就是 Eloquent ORM) 数据库组件大概分了三层: 数据库连接层 查询构造层 应用层 来看一下每一层有哪些东西,分别对应文档的哪一部分: 数据库连接层 ...