B站弹幕爬取 / jieba分词 - 全站第一的视频弹幕都在说什么?

前言

本次爬取的视频av号为75993929(11月21的b站榜首),讲的是关于动漫革命机,这是一部超魔幻现实主义动漫(滑稽),有兴趣的可以亲身去感受一下这部魔幻大作。

准备工作

- B站弹幕的爬取的接口

https://api.bilibili.com/x/v1/dm/list.so?oid=

打开开发者模式,其中的oid的值

- 获取视频发出以来的所有弹幕,构造URL

https://api.bilibili.com/x/v2/dm/history?type=1&oid=129995312&date=2019-11-17

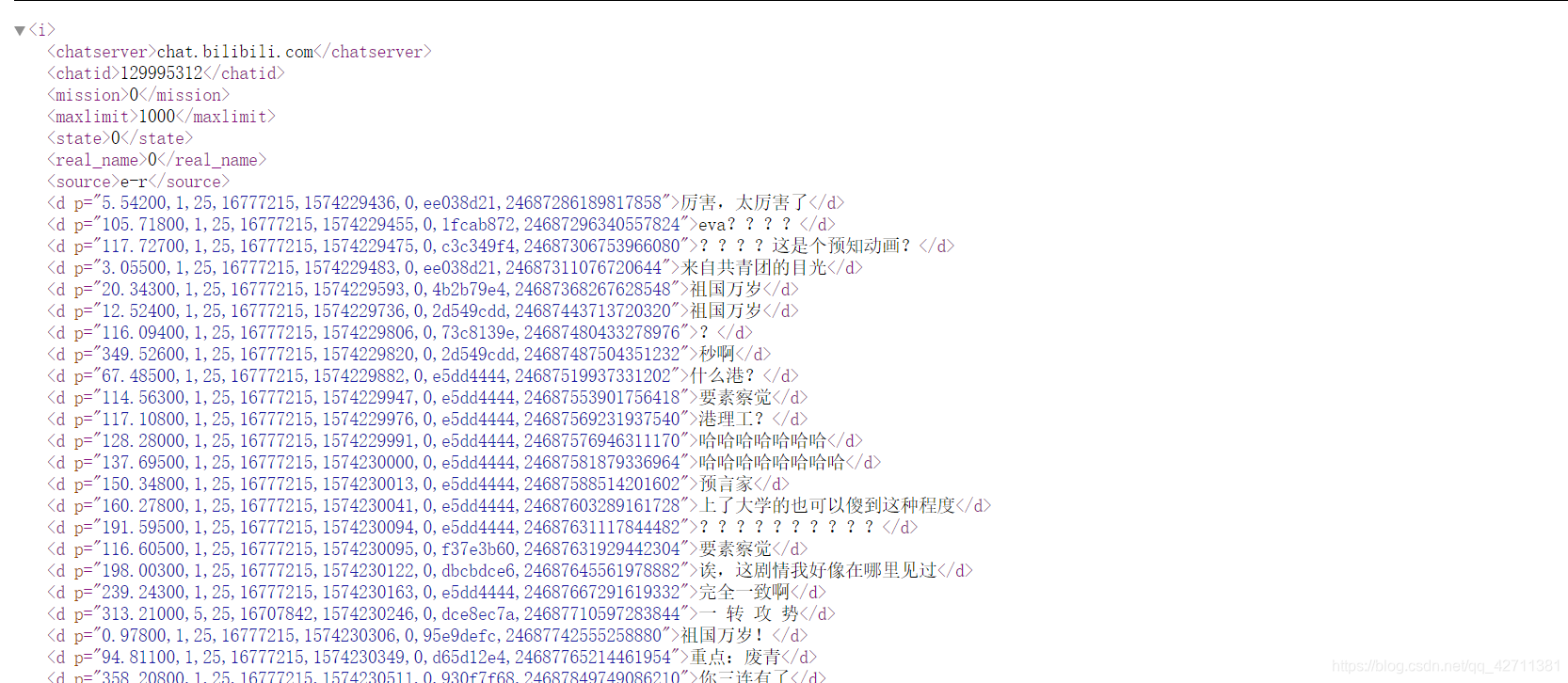

- 访问一下弹幕页面,发现弹幕都放在标签中。

代码

import requests

from pyquery import PyQuery as pq

import jieba

import pandas as pd

# 通过时间来获取弹幕信息需要登陆才行,所以带上登陆后的cookie。否则只能获取当日的一千条弹幕

headers={

"放入cookie"

}

word = []

def getInfo(date):

response = requests.get("https://api.bilibili.com/x/v2/dm/history?type=1&oid=129995312&date=2019-11-"+str(date), headers=headers)

# 解决中文乱码问题

response.encoding = response.apparent_encoding

doc = pq(response.content)

# 获取所有的d标签

result = doc("d")

for line in result:

word.append(line.text)

# 将弹幕信息保存到csv文件中去

def savaFile():

sr = pd.Series(word)

sr.to_csv("评革命机B站弹幕.csv", encoding='utf-8', index=None)

# 利用jieba库对弹幕内容进行分词

def seperate():

data = pd.read_csv(open("评革命机B站弹幕.csv", encoding='utf-8'))

# 传入自定义的字典,毕竟b站玩梗玩到飞起

jieba.load_userdict('dict.txt')

strs = ""

for i in data.values:

strs += "".join(i[0])

l = jieba.cut(strs, cut_all=True)

res = '/'.join(l)

# 保存到文件中去

with open("word.txt", 'w', encoding='utf-8') as f:

f.write(res)

# 分析词语出现的频率

def analyse():

res = set()

def dropNa(s):

return s and s.strip()

data = open("word.txt", encoding='utf-8').read()

data = data.split('/')

newdata = []

for i in data:

# 去除掉一些无用的

if '哈' in i or len(i) == 1 or '嘿' in i:

continue

newdata.append(i)

data = newdata

# 去除空串

data = list(filter(dropNa, data))

df = pd.Series(data)

# 统计出现频率同时写入文件中

df.value_counts().to_csv("弹幕TOP.csv")

for i in range(18, 22):

getInfo(i)

savaFile()

seperate()

analyse()

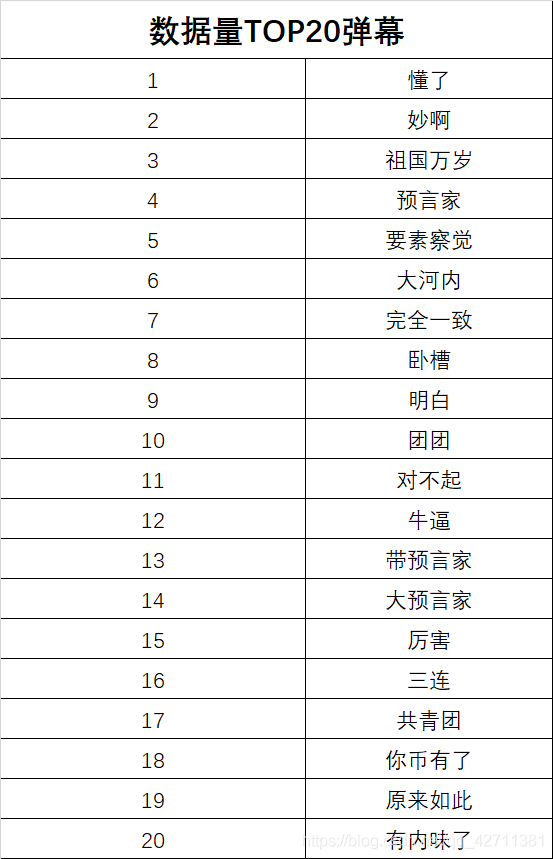

结果展示

大河内老师不愧是早稻田大学人类科学系的毕业的

这些弹幕突然就有内味了

预知为何弹幕会呈现这种情况,详情请见这部动画曾因不切实际被人嘲讽,但6年后现实却打了所有人的脸! 【革命机】

存在的问题

- jieba分词的效果其实不太理想,希望未来能够找到改进方法。

- 本来想做成词云的,但是效果也不佳,待改进。

B站弹幕爬取 / jieba分词 - 全站第一的视频弹幕都在说什么?的更多相关文章

- python预课05 爬虫初步学习+jieba分词+词云库+哔哩哔哩弹幕爬取示例(数据分析pandas)

结巴分词 import jieba """ pip install jieba 1.精确模式 2.全模式 3.搜索引擎模式 """ txt ...

- B站弹幕爬取

B站弹幕爬取 单个视频弹幕的爬取 B站弹幕都是以xml文件的形式存在的,而xml文件的请求地址是如下形式: http://comment.bilibili.com/233182992.xml ...

- Java爬虫——B站弹幕爬取

如何通过B站视频AV号找到弹幕对应的xml文件号 首先爬取视频网页,将对应视频网页源码获得 就可以找到该视频的av号aid=8678034 还有弹幕序号,cid=14295428 弹幕存放位置为 h ...

- quotes 整站数据爬取存mongo

安装完成scrapy后爬取部分信息已经不能满足躁动的心了,那么试试http://quotes.toscrape.com/整站数据爬取 第一部分 项目创建 1.进入到存储项目的文件夹,执行指令 scra ...

- Scrapy+selenium爬取简书全站

Scrapy+selenium爬取简书全站 环境 Ubuntu 18.04 Python 3.8 Scrapy 2.1 爬取内容 文字标题 作者 作者头像 发布日期 内容 文章连接 文章ID 思路 分 ...

- Python爬取B站耗子尾汁、不讲武德出处的视频弹幕

本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理. 前言 耗子喂汁是什么意思什么梗呢?可能很多人不知道,这个梗是出自马保国,经常上网的人可能听说过这个 ...

- bilibili弹幕爬取与比对分析

最近受人之托研究了下b站的数据爬取做个小工具,最后朋友说不需要了,本着开源共享的原则,将研究成果与大家分享一波,话不多说直接上干货 需求分析 给定up主uid和用户uid,爬取用户在该up主所有视频中 ...

- B站自动爬取器并制作词云

效果 词云展示 弹幕展示 爬取弹幕过程 基本步骤 1.寻找视频url 2.构造请求头 3.寻找弹幕地址 4.根据弹幕地址运用正则或xpath爬取 寻找B站视频的url 制作请求头 headers = ...

- Scrapy:腾讯招聘整站数据爬取

项目地址:https://hr.tencent.com/ 步骤一.分析网站结构和待爬取内容 以下省略一万字 步骤二.上代码(不能略了) 1.配置items.py import scrapy class ...

随机推荐

- linux自定义开机欢迎页面图案

1:编辑etc目录下motd文件 佛祖图案 [root@host1 ~]# vim /etc/motd _oo0oo_ 088888880 88" . "88 (| -_- |) ...

- (Concurrent)HashMap的存储过程及原理。

1.前言 看完咕泡Jack前辈的有关hashMap的视频(非宣传,jack自带1.5倍嘴速,高效),收益良多,所以记录一下学习到的东西. 2.基础用法 源码的注释首先就介绍了哈希表是基于Map接口,所 ...

- Python 分析电影《南方车站的聚会》

<南方车站的聚会>由刁亦男执导,主要演员包括:胡歌.桂纶镁.廖凡.万茜等,该片于 2019 年 5 月 18 在戛纳电影节首映,2019 年 12 月 6 日在中国正式上映.故事灵感来自真 ...

- 《Java练习题》习题集三

编程合集: https://www.cnblogs.com/jssj/p/12002760.html Java总结:https://www.cnblogs.com/jssj/p/11146205.ht ...

- 《Java知识应用》Java通过Get和Post实现HTTP请求。

Http请求,是非常常见并且的数据交互方式. 下面讲解:Get和Post的两个实战案例. 用于测试的Action(controller). @RequestMapping(value = " ...

- JS正则表达式语法(含ES6)(表格简要总结)

文章目录 JS正则表达式 1. JS中正则表达式定义 2. 直接量字符 3. 字符类 4. 重复字符 5. 选择,分组和引用 6. 指定匹配位置 7. 修饰符 8. String 方法 9. RegE ...

- python的memory_profiler模块使用

本文主要介绍了python内存分析工具: memory_profiler,可以展示每一行代码执行所增加的内存,方便做内存调优和排除bug memory_profiler是第三方模块,需要安装才能使用 ...

- Ansible自动化部署入门到进阶笔记

目录 一.基本部署 安装Ansible Ansible配置文件 定义Inventory 使用秘钥方式连接 使用帮助 Ansible命令应用基础 二.常见模块 三.Ansible playbook 四. ...

- 一起学Spring之Web基础篇

概述 在日常的开发中Web项目集成Spring框架,已经越来越重要,而Spring框架已经成为web开发的主流框架之一.本文主要讲解Java开发Web项目集成Spring框架的简单使用,以及使用Spr ...

- ssm集成(maven)& 分模块开发--详细教程

1 maven版本的ssm 1.1 最简单的版本步骤: (1) 创建maven web项目 (2) 在pom.xml中导入依赖的jar包 (3) 再写配置文件: web.xml <!DOCTYP ...