ELK技术-Logstash

1.背景

1.1 简介

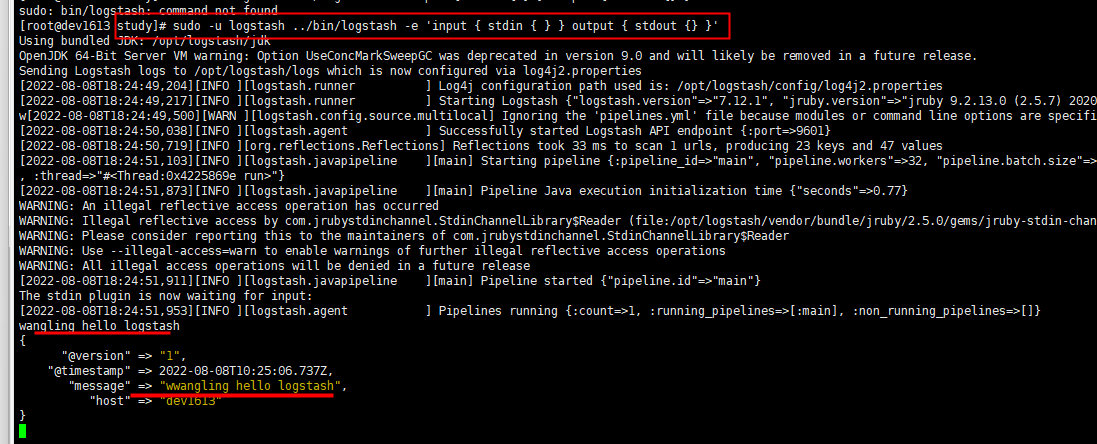

Logstash 是一个数据流引擎

- 它是用于数据物流的开源流式 ETL(Extract-Transform-Load)引擎

- 在几分钟内建立数据流管道

- 具有水平可扩展及韧性且具有自适应缓冲

- 不可知的数据源

- 具有 200 多个集成和处理器的插件生态系统

- 使用 Elastic Stack 监视和管理部署

Logstash 几乎可以摄入各种类别的数据

Logstash 相关概念

- Logstash 实例是一个正在运行的 Logstash 进程。建议在 Elasticsearch 的单独主机上运行 Logstash,以确保两个组件有足够的计算资源可用。

- 管道(pipeline)是配置为处理给定工作负载的插件集合。一个 Logstash 实例可以运行多个管道。(彼此独立)

- 输入插件(input plugins)用于从给定的源系统中提取或接收数据。 Logstash 参考指南中提供了支持的输入插件列表:https://www.elastic.co/guide/en/logstash/current/input-plugins.html

- 过滤器插件(filter plugin)用于对传入事件应用转换和丰富。 Logstash 参考指南中提供了支持的过滤器插件列表:Filter plugins | Logstash Reference [8.3] | Elastic

- 输出插件(output plugin)用于将数据加载或发送到给定的目标系统。 Logstash 参考指南中提供了支持的输出插件列表:https://www.elastic.co/guide/en/logstash/current/output-plugins.html

1.2 学习参考

- Logstash官方文档:《Logstash官方文档》

- 中国社区官方博客:《Logstash入门教程》

- 其他参考技术博客:《通过Logstash实现mysql数据定时增量同步到ES》

- Logstash解析:《解析插件-Grok》

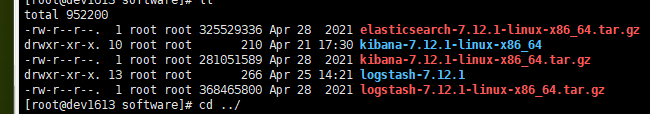

1.3 本例测试版本

[root@dev1613 study]# sudo -u logstash ../bin/logstash --version

Using bundled JDK: /opt/logstash/jdk

logstash 7.12.1

2.功能应用

2.1 基础测试

sudo -u logstash ../bin/logstash -e 'input { stdin { } } output { stdout {} }'

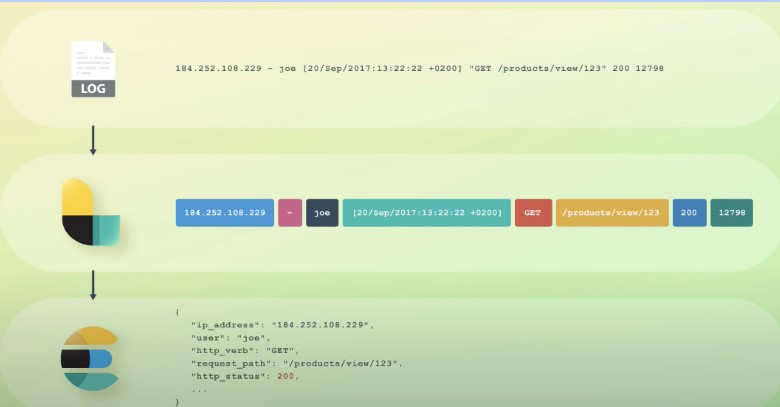

2.2 Logstash解析日志文件

日志原始内容

2022-07-06 18:48:37.453 ERROR 14677 --- [ dispatcher 108] c.a.c.s.dashboard.metric.MetricFetcher : Failed to fetch metric from <http://10.32.4.230:8719/metric?startTime=1657104506000&endTime=1657104512000&refetch=false>: socket timeout

2022-07-06 18:48:44.439 ERROR 14677 --- [ dispatcher 109] c.a.c.s.dashboard.metric.MetricFetcher : Failed to fetch metric from <http://10.32.4.230:8719/metric?startTime=1657104513000&endTime=1657104519000&refetch=false>: socket timeout

2022-07-06 18:48:51.514 ERROR 14677 --- [ dispatcher 110] c.a.c.s.dashboard.metric.MetricFetcher : Failed to fetch metric from <http://10.32.4.230:8719/metric?startTime=1657104520000&endTime=1657104526000&refetch=false>: socket timeout

Logstash配置文件

input {

file {

path => "/opt/logstash/study/outlog.log"

start_position => "beginning"

stat_interval => "3"

type => "sentinel-log"

}

}

filter {

grok {

match => ["message","%{TIMESTAMP_ISO8601:datetime} %{LOGLEVEL:loglevel} %{NUMBER:textid} %{GREEDYDATA:errormsg}"]

}

json {

source => "request"

}

}

output {

stdout { codec => rubydebug }

}

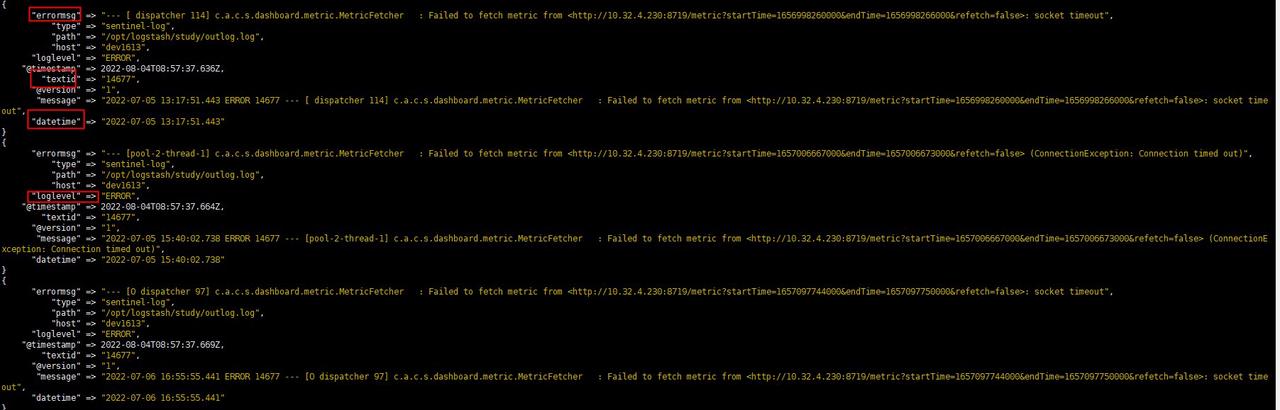

Grok日志解析在线测试

日志解析结构化输出

2.3 Logstash-数据库同步

基础数据内容

CREATE TABLE `study_logstash_es` (

`id` int NOT NULL AUTO_INCREMENT COMMENT '自增主键',

`study_code` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL COMMENT '编码',

`study_name` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL COMMENT '名称',

`study_tag` varchar(64) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL DEFAULT '' COMMENT '标签',

`study_level` smallint NOT NULL DEFAULT '0' COMMENT '等级,如1,2,3',

`is_delete` tinyint unsigned NOT NULL DEFAULT '0' COMMENT '0 未删除 1 删除',

`create_time` datetime DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间',

`update_time` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间',

`operate_user` varchar(32) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci DEFAULT NULL COMMENT '操作人',

PRIMARY KEY (`id`),

UNIQUE KEY `uniq_study_code` (`study_code`)

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_general_ci COMMENT='学习-logstash同步msql数据到es';

PUT /study_logstash_es

{

"settings": {

"index": {

"number_of_shards": 1,

"number_of_replicas": 1

}

}, "mappings": {

"properties": {

"id": {

"type": "integer"

},

"study_code": {

"type": "text"

},

"study_name": {

"type": "text"

},

"operate_user": {

"type": "text"

},

"study_tag": {

"type": "keyword"

},

"is_delete": {

"type": "integer"

},

"study_level": {

"type": "integer"

},

"mark_time": {

"type": "date",

"format": "epoch_millis"

},

"update_time": {

"type": "date"

}

}

}

}

Logstash配置文件

input {

jdbc {

jdbc_driver_library => "/opt/logstash/study/mysql-connector-java-8.0.30.jar"

jdbc_driver_class => "com.mysql.cj.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://xxx.xxx.xx.x:3306/study_database?serverTimezone=Asia/Shanghai&allowMultiQueries=true&characterEncoding=utf-8"

jdbc_user => "root"

jdbc_password => "xxxxx"

jdbc_paging_enabled => true

jdbc_page_size => "2"

use_column_value => true

tracking_column => "mark_time"

tracking_column_type => "numeric"

schedule => "* * * * *"

statement => "SELECT id,study_code,study_name,study_tag,study_level,operate_user,update_time,UNIX_TIMESTAMP(update_time) as mark_time from study_logstash_es where UNIX_TIMESTAMP(update_time)>:sql_last_value AND update_time < NOW()"

}

}

output{

elasticsearch{

hosts => ["xxx.xxx.16.4:9200","xxx.xxx.16.xx:9200","192.xxx.xx.xx:9200"]

index => "study_logstash_es"

timeout => 300

user => "xxx"

password => "xxxxx"

}

}

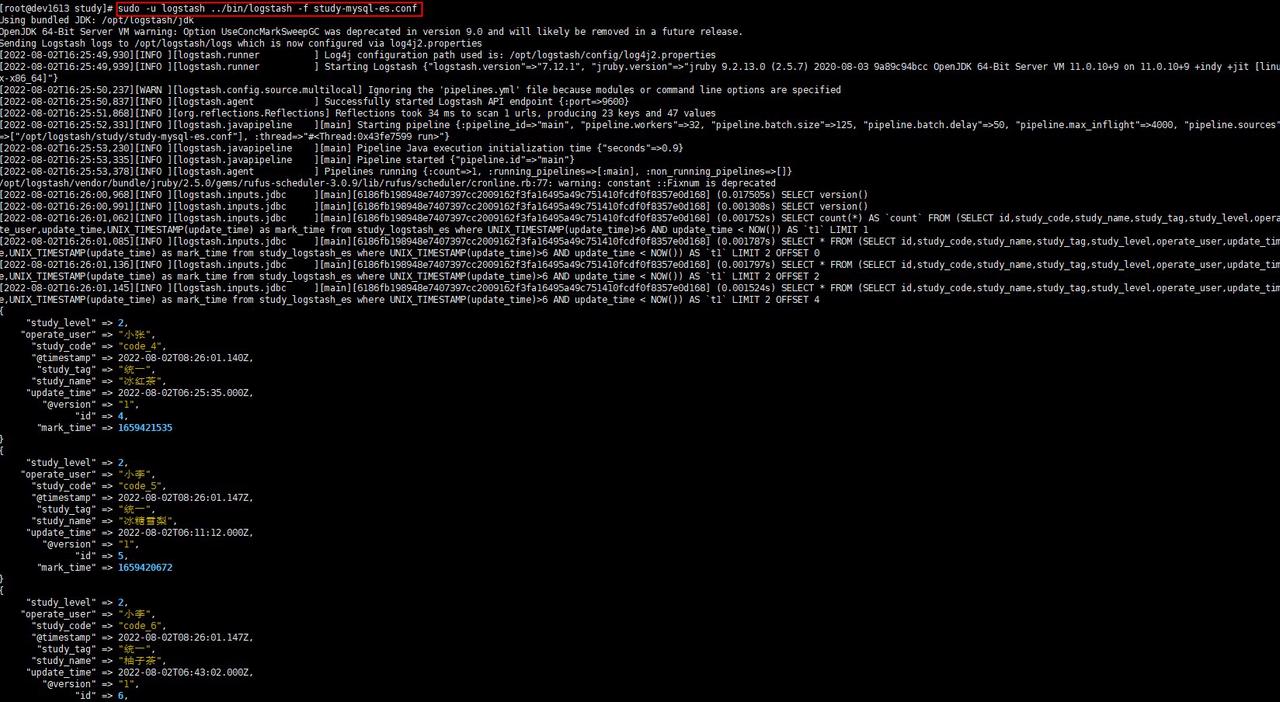

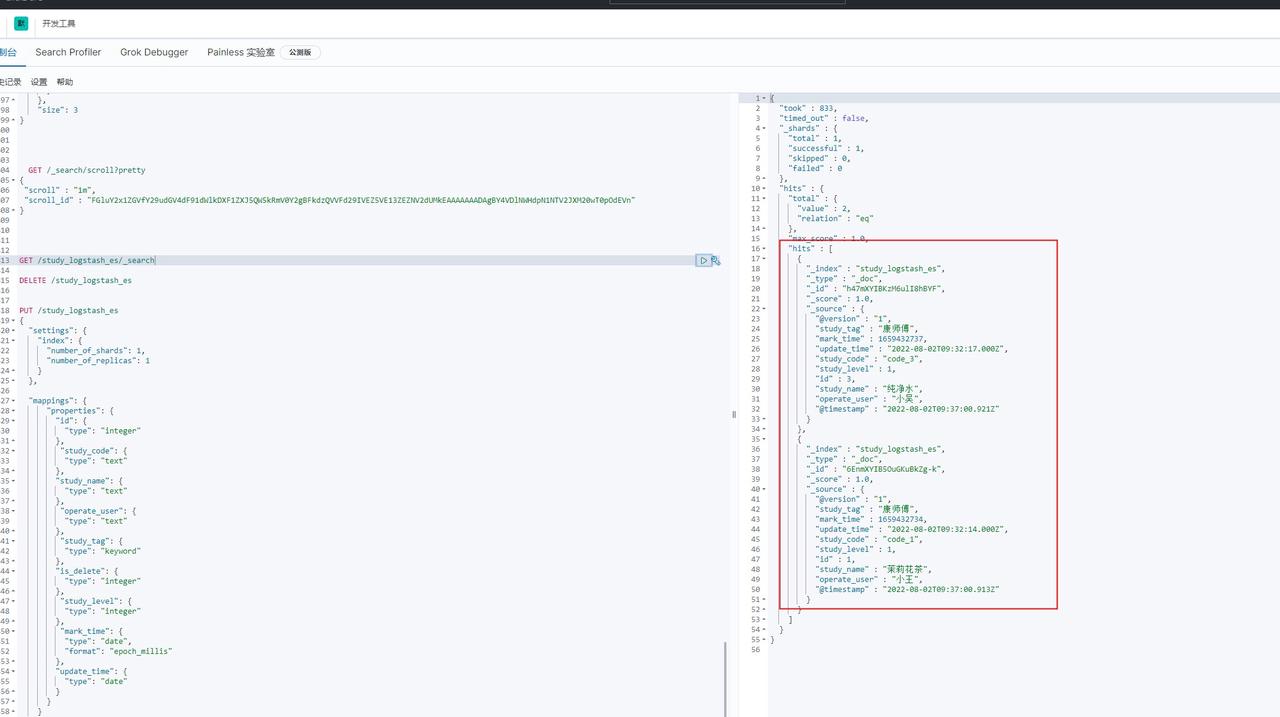

数据同步es

2.4 Logstash-kafka消息同步

input {

kafka {

bootstrap_servers => "xxx.xxx.xx.4:9092,xxx.xxx.16.4:9093,xxx.xxx.16.4:9094" #kafka服务器地址

topics => "xxxlog"

# batch_size => 5

codec => "json"

group_id => "logstash"

consumer_threads => 3

}

}

filter {

# 丢弃所有的header请求

if [request][method] == "HEAD" {

drop { }

}

# 因为[request][querystring]这个玩意中的字段类型可能不一样,所以全部干成字符串

ruby {

code => "event.set('[request][querystring]', event.get('[request][querystring]').to_s) if event.get('[request][querystring]')"

}

if [request][uri] =~ "^/ucenter-admin-view/v3(.*)" {

mutate {

add_field => { "log_source" => "用户中心管理后台" }

add_field => { "log_source_id" => "1" }

}

}

else if [request][uri] =~ "^/ucenter-org-view/v3/(.*)" {

mutate {

add_field => { "log_source" => "用户中心工作台" }

add_field => { "log_source_id" => "2" }

}

}

else if [request][uri] =~ "^/safety-admin-api(.*)" {

mutate {

add_field => { "log_source" => "安全管理平台" }

add_field => { "log_source_id" => "3" }

}

}

else{

mutate {

add_field => { "log_source" => "其他" }

add_field => { "log_source_id" => "0" }

}

}

grok {

match => { "[request][uri]" => "%{URIPATH:[request][path]}" }

named_captures_only => false

}

}

output{

# stdout {

# codec => json

# }

elasticsearch{

hosts => ["xxx.xxx.xx.4:9200","xxx.xxx.16.13:9200","xxx.xxx.16.14:9200"]

index => "apisixlog"

timeout => 300

user => "elastic"

password => "HApn2xCJMuRlg0UOIV0P"

}

3.总结

- Logstash基于 输入(inputs),过滤器(filters)和输出(outputs)可以方便快捷的处理数据,将一些非结构化数据,处理为结构化数据。Logstash支持数据中转,数据同步等场景的应用。本例只是简要测试,在实际业务使用时,可基于某一个输入插件/输出插件参考官方文档,结合项目使用。

- Logstash收集大量日志时,存在耗内存的情况,建议参考官方推荐的FileBeat模式。详情参考文档:《开源日志管理方案 ELK 和 EFK 的区别》,《通过Filebeat把日志传入到Elasticsearch》。

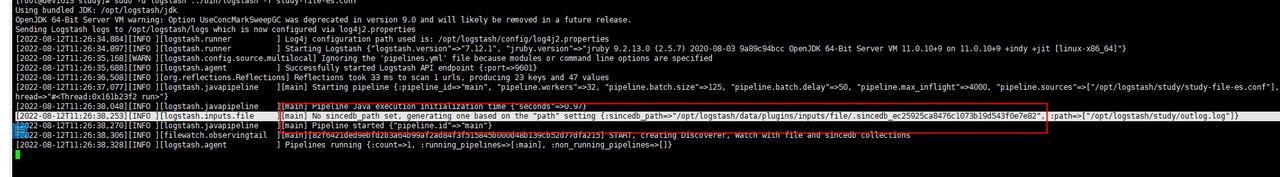

- Logstash在配置文件调整后,启动命令,可能出现如下报错:

- Logstash启动命名常用如下:

sudo -u logstash ../bin/logstash -f study-file-es.conf

表示当前窗口启动,关闭或退出命令行时,logstash实例关闭。 sudo -u logstash ../bin/logstash -f study-file-es.conf --config.reload.automatic

表示当前窗口启动,配置文件变化时,不用重新启动实例,可自动加载。关闭或退出命令行时,logstash实例关闭。 sudo -u logstash ../bin/logstash -f study-mysql-es.conf & test.out --config.reload.automatic

表示后台启动,关闭退出命令,实例在后台一直运行。 ps -ef|grep logstash

kill-9 进程号, 关闭对应的实例

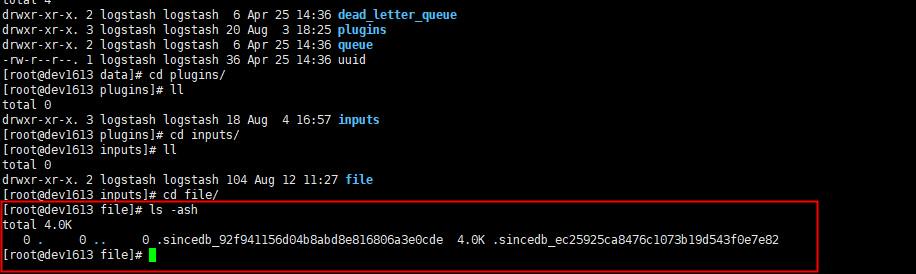

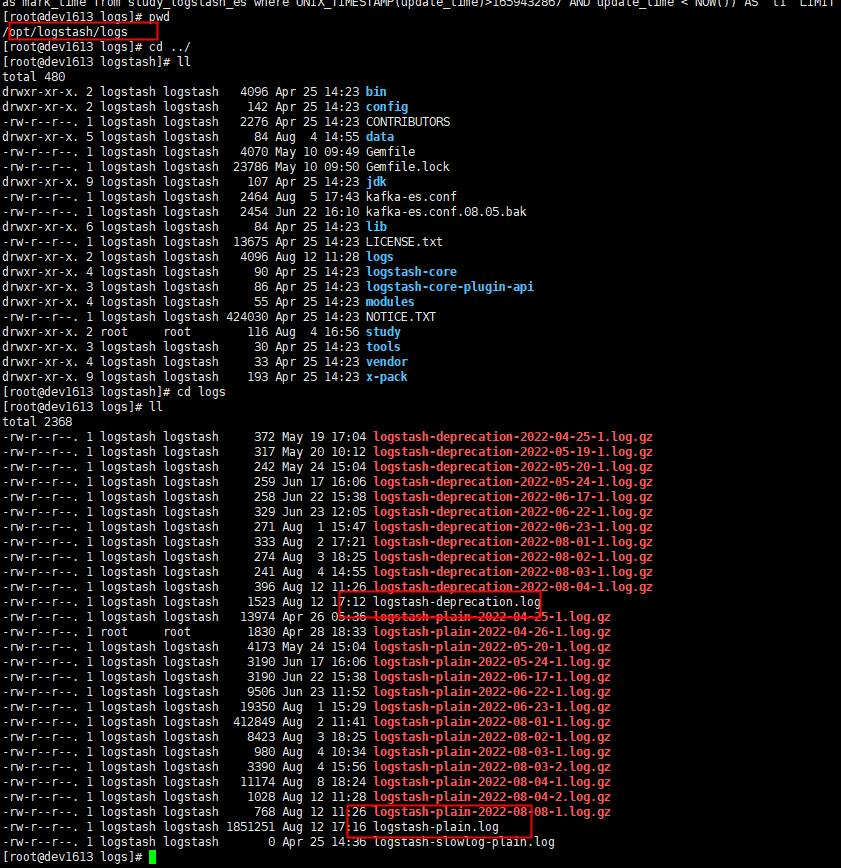

- Logstash运行日志查看

ELK技术-Logstash的更多相关文章

- ELK技术栈之-Logstash详解

ELK技术栈之-Logstash详解 前言 在第九章节中,我们已经安装好Logstash组件了,并且启动实例测试它的数据输入和输出,但是用的是最简单的控制台标准输入和标准输出,那这节我们就来深入的 ...

- ELK技术实战-安装Elk 5.x平台

ELK技术实战–了解Elk各组件 转载 http://www.ywnds.com/?p=9776 ELK技术实战-部署Elk 2.x平台 ELK Stack是软件集合Elasticsearch. ...

- [转] ELK 之 Logstash

[From] https://blog.csdn.net/iguyue/article/details/77006201 ELK 之 Logstash 简介: ELK 之 LogstashLogsta ...

- 应用编排服务之ELK技术栈示例模板详解

日志对互联网应用的运维尤为重要,它可以帮助我们了解服务的运行状态.了解数据流量来源甚至可以帮助我们分析用户的行为等.当进行故障排查时,我们希望能够快速的进行日志查询和过滤,以便精准的定位并解决问题. ...

- 使用ELK(Elasticsearch + Logstash + Kibana) 搭建日志集中分析平台实践--转载

原文地址:https://wsgzao.github.io/post/elk/ 另外可以参考:https://www.digitalocean.com/community/tutorials/how- ...

- ELk(Elasticsearch, Logstash, Kibana)的安装配置

目录 ELk(Elasticsearch, Logstash, Kibana)的安装配置 1. Elasticsearch的安装-官网 2. Kibana的安装配置-官网 3. Logstash的安装 ...

- CentOS 6.x ELK(Elasticsearch+Logstash+Kibana)

CentOS 6.x ELK(Elasticsearch+Logstash+Kibana) 前言 Elasticsearch + Logstash + Kibana(ELK)是一套开源的日志管理方案, ...

- 基于CentOS6.5或Ubuntu14.04下Suricata里搭配安装 ELK (elasticsearch, logstash, kibana)(图文详解)

前期博客 基于CentOS6.5下Suricata(一款高性能的网络IDS.IPS和网络安全监控引擎)的搭建(图文详解)(博主推荐) 基于Ubuntu14.04下Suricata(一款高性能的网络ID ...

- 键盘侠Linux干货| ELK(Elasticsearch + Logstash + Kibana) 搭建教程

前言 Elasticsearch + Logstash + Kibana(ELK)是一套开源的日志管理方案,分析网站的访问情况时我们一般会借助 Google / 百度 / CNZZ 等方式嵌入 JS ...

随机推荐

- node.js的express模块实现GET和POST请求

一.环境 1.安装express npm i express@4.17.1 // 安装express模块 2.安装nodemon npm i nodemon -g 3.安装cors npm insta ...

- ssh隧道连接的方式连接数据库

最好用xshell做隧道连接,其他工具没接触过过 1.先新建一个会话 2.点进刚刚建好的连接,右击属性 3.点进隧道,添加,输入映射到本地的配置 4.完成之后用数据库连接工具连接即可 参考连接: ht ...

- 4.怎么理解相互独立事件?真的是没有任何关系的事件吗? 《zobol的考研概率论教程》

1.从条件概率的定义来看独立事件的定义 2.从古典概率的定义来看独立事件的定义 3.P(A|B)和P(A)的关系是什么? 4.由P(AB)=P(A)P(B)推出"独立" 5.从韦恩 ...

- C语言学习之我见-strcmp()字符串比较函数

strcmp()函数,用于两个字符串的比较. (1)函数原型 int strcmp(const char *_Str1,const char *_Str2); (2)头文件 string.h (3)功 ...

- 一条 SQL 语句是如何执行的

一条 SQL 语句是如何执行的 SQL查询语句 select * from user where ID=10; MySQL 的基本架构可以分为 Server 层和存储引擎两部分.Server 层又包含 ...

- linux系统漏洞lynis扫描

1.下载lynis https://cisofy.com/downloads/lynis/ 或者 yum --enablerepo=epel -y install lynis 2. rz上传压缩包解压 ...

- java--运算符和表达式

运算符:就是对常量或者遍历进行操作的符号: 表达式:用运算符把常量或者变量连接起来符合java语法的式子称为表达式,不同运算符连接的表达式体现的是不同类型的表达式. 一.算术运算符 1.使用%运算符: ...

- S32K148-CAN收发

最近在搞一个转换板开发,大概意思把CAN信号转换成SPI信号,方案有两种:1)通过硬件电路直接把信号的bit位一位一位移给两个集成芯片:2)通过MCU接收CAN信号,再把信号变量转换成SPI信号发送给 ...

- 聊一聊 C# 后台GC 到底是怎么回事?

一:背景 写这一篇的目的主要是因为.NET领域内几本关于阐述GC方面的书,都是纯理论,所以懂得人自然懂,不懂得人也没法亲自验证,这一篇我就用 windbg + 源码 让大家眼见为实. 二:为什么要引入 ...

- NOI / 2.1基本算法之枚举-8759:火车上的人数

8759:火车上的人数 总时间限制: 1000ms 内存限制: 65536kB 描述 火车从始发站(称为第1站)开出,在始发站上车的人数为a,然后到达第2站,在第2站有人上.下车,但上.下 ...