机器学习:逻辑回归(OvR 与 OvO)

一、基础理解

- 问题:逻辑回归算法是用回归的方式解决分类的问题,而且只可以解决二分类问题;

- 方案:可以通过改造,使得逻辑回归算法可以解决多分类问题;

- 改造方法:

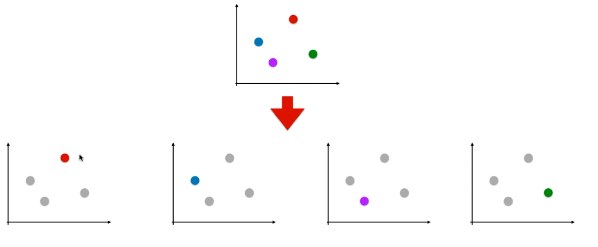

- OvR(One vs Rest),一对剩余的意思,有时候也称它为 OvA(One vs All);一般使用 OvR,更标准;

- OvO(One vs One),一对一的意思;

- 改造方法不是指针对逻辑回归算法,而是在机器学习领域有通用性,所有二分类的机器学习算法都可使用此方法进行改造,解决多分类问题;

二、原理

1)OvR

- 思想:n 种类型的样本进行分类时,分别取一种样本作为一类,将剩余的所有类型的样本看做另一类,这样就形成了 n 个二分类问题,使用逻辑回归算法对 n 个数据集训练出 n 个模型,将待预测的样本传入这 n 个模型中,所得概率最高的那个模型对应的样本类型即认为是该预测样本的类型;

- 时间复杂度:如果处理一个二分类问题用时 T,此方法需要用时 n.T;

2)OvO

- 思想: n 类样本中,每次挑出 2 种类型,两两结合,一共有 Cn2 种二分类情况,使用 Cn2 种模型预测样本类型,有 Cn2 个预测结果,种类最多的那种样本类型,就认为是该样本最终的预测类型;

- 时间复杂度:如果处理一个二分类问题用时 T,此方法需要用时 Cn2 .T = [n.(n - 1) / 2] . T;

3)区别

- OvO 用时较多,但其分类结果更准确,因为每一次二分类时都用真实的类型进行比较,没有混淆其它的类别;

三、scikit-learn 中的逻辑回归

- scikit-learn的LogisticRegression 算法内包含了:正则化、优化损失函数的方法、多分类方法等;

LogisticRegression(C=1.0, class_weight=None, dual=False, fit_intercept=True,

intercept_scaling=1, max_iter=100, multi_class='ovr', n_jobs=1,

penalty='l2', random_state=None, solver='liblinear', tol=0.0001,

verbose=0, warm_start=False)# LogisticRegression() 实例对象,包含了很多参数;

不懂的要学会 看文档、看文档、看文档:help(算法、实例对象);

C=1.0:正则化的超参数,默认为 1.0;

- multi_class='ovr':scikit-learn中的逻辑回归默认支持多分类问题,分类方式为 'OvR';

- solver='liblinear'、'lbfgs'、'sag'、'newton-cg':scikit-learn中优化损失函数的方法,不是梯度下降法;

- 多分类中使用 multinomial (OvO)时,只能使用 'lbfgs'、'sag'、'newton-cg' 来优化损失函数;

- 当损失函数使用了 L2 正则项时,优化方法只能使用 'lbfgs'、'sag'、'newton-cg';

- 使用 'liblinear' 优化损失函数时,正则项可以为 L1 和 L2 ;

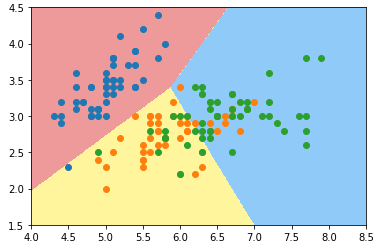

1)例(3 种样本类型):LogisticRegression() 默认使用 OvR

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets iris = datasets.load_iris()

# [:, :2]:所有行,0、1 列,不包含 2 列;

X = iris.data[:,:2]

y = iris.target from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=666) from sklearn.linear_model import LogisticRegression log_reg = LogisticRegression()

log_reg.fit(X_train, y_train) log_reg.score(X_test, y_test)

# 准确率:0.6578947368421053- 绘制决策边界

def plot_decision_boundary(model, axis): x0, x1 = np.meshgrid(

np.linspace(axis[0], axis[1], int((axis[1]-axis[0])*100)).reshape(-1,1),

np.linspace(axis[2], axis[3], int((axis[3]-axis[2])*100)).reshape(-1,1)

)

X_new = np.c_[x0.ravel(), x1.ravel()] y_predict = model.predict(X_new)

zz = y_predict.reshape(x0.shape) from matplotlib.colors import ListedColormap

custom_cmap = ListedColormap(['#EF9A9A','#FFF59D','#90CAF9']) plt.contourf(x0, x1, zz, linewidth=5, cmap=custom_cmap) plot_decision_boundary(log_reg, axis=[4, 8.5, 1.5, 4.5])

# 可视化时只能在同一个二维平面内体现两种特征;

plt.scatter(X[y==0, 0], X[y==0, 1])

plt.scatter(X[y==1, 0], X[y==1, 1])

plt.scatter(X[y==2, 0], X[y==2, 1])

plt.show()

2)使用 OvO 分类

log_reg2 = LogisticRegression(multi_class='multinomial', solver='newton-cg')

# 'multinomial':指 OvO 方法; log_reg2.fit(X_train, y_train)

log_reg2.score(X_test, y_test)

# 准确率:0.7894736842105263 plot_decision_boundary(log_reg2, axis=[4, 8.5, 1.5, 4.5])

plt.scatter(X[y==0, 0], X[y==0, 1])

plt.scatter(X[y==1, 0], X[y==1, 1])

plt.scatter(X[y==2, 0], X[y==2, 1])

plt.show()

3)使用所有分类数据

- OvR

X = iris.data

y = iris.target X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=666) log_reg_ovr = LogisticRegression()

log_reg_ovr.fit(X_train, y_train)

log_reg_ovr.score(X_test, y_test)

# 准确率:0.9473684210526315 - OvO

log_reg_ovo = LogisticRegression(multi_class='multinomial', solver='newton-cg')

log_reg_ovo.fit(X_train, y_train)

log_reg_ovo.score(X_test, y_test)

# 准确率:1.0

4)分析

- 通过准确率对比可以看出,使用 OvO 方法改造 LogisticRegression() 算法,得到的模型准确率较高;

四、OvR 和 OvO 的封装

- scikit-learn单独封装了实现 OvO 和 OvR 的类,使得任意二分类算法都可以通过使用这两个类解决多分类问题;

1)OvR 的封装

- 模块

from sklearn.multiclass import OneVsRestClassifier

- 使用方法

- ovr = OneVsRestClassifier(二分类算法的实例对象):得到一个可以解决多分类的实例对象;

- ovr.fit(X_train, y_train):拟合多分类实例对象;

- 例

from sklearn.multiclass import OneVsRestClassifier ovr = OneVsRestClassifier(log_reg)

ovr.fit(X_train, y_train)

ovr.score(X_test, y_test)

# 准确率:0.9473684210526315

2)OvO 的封装

- 模块

from sklearn.multiclass import OneVsOneClassifier

- 使用方法:同理 OvR;

- 例

from sklearn.multiclass import OneVsOneClassifier ovo = OneVsOneClassifier(log_reg)

ovo.fit(X_train, y_train)

ovo.score(X_test, y_test)

# 准确率:1.0

机器学习:逻辑回归(OvR 与 OvO)的更多相关文章

- 机器学习---逻辑回归(二)(Machine Learning Logistic Regression II)

在<机器学习---逻辑回归(一)(Machine Learning Logistic Regression I)>一文中,我们讨论了如何用逻辑回归解决二分类问题以及逻辑回归算法的本质.现在 ...

- 机器学习/逻辑回归(logistic regression)/--附python代码

个人分类: 机器学习 本文为吴恩达<机器学习>课程的读书笔记,并用python实现. 前一篇讲了线性回归,这一篇讲逻辑回归,有了上一篇的基础,这一篇的内容会显得比较简单. 逻辑回归(log ...

- 机器学习---逻辑回归(一)(Machine Learning Logistic Regression I)

逻辑回归(Logistic Regression)是一种经典的线性分类算法.逻辑回归虽然叫回归,但是其模型是用来分类的. 让我们先从最简单的二分类问题开始.给定特征向量x=([x1,x2,...,xn ...

- 机器学习——逻辑回归(Logistic Regression)

1 前言 虽然该机器学习算法名字里面有"回归",但是它其实是个分类算法.取名逻辑回归主要是因为是从线性回归转变而来的. logistic回归,又叫对数几率回归. 2 回归模型 2. ...

- 吴裕雄 python 机器学习——逻辑回归

import numpy as np import matplotlib.pyplot as plt from matplotlib import cm from mpl_toolkits.mplot ...

- python机器学习-逻辑回归

1.逻辑函数 假设数据集有n个独立的特征,x1到xn为样本的n个特征.常规的回归算法的目标是拟合出一个多项式函数,使得预测值与真实值的误差最小: 而我们希望这样的f(x)能够具有很好的逻辑判断性质,最 ...

- Spark 机器学习------逻辑回归

package Spark_MLlib import javassist.bytecode.SignatureAttribute.ArrayType import org.apache.spark.s ...

- python机器学习——逻辑回归

我们知道感知器算法对于不能完全线性分割的数据是无能为力的,在这一篇将会介绍另一种非常有效的二分类模型--逻辑回归.在分类任务中,它被广泛使用 逻辑回归是一个分类模型,在实现之前我们先介绍几个概念: 几 ...

- 机器学习-逻辑回归与SVM的联系与区别

(搬运工) 逻辑回归(LR)与SVM的联系与区别 LR 和 SVM 都可以处理分类问题,且一般都用于处理线性二分类问题(在改进的情况下可以处理多分类问题,如LR的Softmax回归用在深度学习的多分类 ...

- 逻辑回归模型(Logistic Regression, LR)基础

逻辑回归模型(Logistic Regression, LR)基础 逻辑回归(Logistic Regression, LR)模型其实仅在线性回归的基础上,套用了一个逻辑函数,但也就由于这个逻辑函 ...

随机推荐

- k-近邻算法 标签分类

k-近邻算法根据特征比较,然后提取样本集中特征最相似数据(最邻近)的分类标签.那么,如何进行比较呢? 怎么判断红色圆点标记的电影所属的类别呢? 如下图所示. 答:距离度量.这个电影分类的例子有2个特征 ...

- HTML5 上传图片 到ASP.NET MVC

@{ ViewBag.Title = "Home Page"; } <!DOCTYPE HTML PUBLIC> <html> <head> & ...

- SpringMVC传递参数和获取参数以及返回数据

1.传递form表单,参数接收到对象,name和对象属性对应上即可: 2.springmvc不能直接通过form表单传递多个对象的list集合,要么采用ajax传递,要么采用封装了list属性的b ...

- Owin and Startup class

https://docs.microsoft.com/en-us/aspnet/aspnet/overview/owin-and-katana/owin-startup-class-detection ...

- 进程【TLCL】

ps命令 ps x 加上 "x" 选项(注意没有开头的 "-" 字符),告诉 ps 命令,展示所有进程,不管它们由什么 终端(如果有的话)控制. 在 TTY 一 ...

- UVA 11186 Circum Triangle (枚举三角形优化)(转)

题意:圆上有n个点,求出这n个点组成的所有三角形的面积之和 题解: 当我们要求出S(i,j,k)时,我们需要假设k在j的左侧,k在i与j之间,k在i的右侧. 如果k在 j的左侧 那么 S(i,j,k ...

- 如何用Qt写一个同一时间只能运行一个实例的应用程序

http://blog.sina.com.cn/s/blog_6343941a0100nk2x.html 可以达到的目的: 1.应用只启动一个实例,依赖于QtNetwork模块 2.启动时向另一个实例 ...

- jsp: jstl标签库 uri标签

与 URL 相关的标签主要是用来将其他文件包含进来,或者提供页面之间的重定位以及 URL 地址的生成.参数的输出等等.一般包括如下几个标签<c:import>标签:与传统 JSP 页面中的 ...

- wpf 界面平级之间设置上下顺序关系(ZIndex)

只能用于平级之间设置上下顺序 this.grid1.SetValue(Grid.ZIndexProperty, 9999); Panel.SetZIndex(th ...

- 卸载全部appx应用(包括应用商店)

在PowerShell中粘贴: Get-AppXPackage | Remove-AppxPackage