[01-01] 示例:用Java爬取新闻

1、分析url

- 先得到所有版面的url

- 访问版面网页并抓取其中的所有文章的url

- 最后访问文章url就可以得到新闻网页内容了

2、代码部分

public class CrawlerUtil {

/**

* 获取主网页的内容

*

* @param url 网页url

* @param requestMethod 请求方式

* @param refer post内容

* @return 网页内容

*/

public static String sendHttpRequest(String url, RequestMethod requestMethod, String refer) {

refer = refer == null || "".equals(refer) ? null : refer;

StringBuffer buffer = new StringBuffer();

try {

//建立连接

URL requestUrl = new URL(url);

HttpURLConnection connection = (HttpURLConnection) requestUrl.openConnection();

connection.setRequestMethod(requestMethod.getValue());

switch (requestMethod) {

case GET:

connection.connect();

break;

case POST:

if (refer != null) {

OutputStream out = connection.getOutputStream();

out.write((refer.getBytes("UTF-8")));

out.close();

}

break;

default:

break;

}

//获取网页内容

InputStream in = connection.getInputStream();

InputStreamReader inputStreamReader = new InputStreamReader(in, "UTF-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

String str = null;

while ((str = bufferedReader.readLine()) != null) {

buffer.append(str);

}

//关闭资源

bufferedReader.close();

inputStreamReader.close();

in.close();

in = null;

connection.disconnect();

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

return buffer.toString();

}

}public class CrawlerUtil {

/**

* 获取主网页的内容

*

* @param url 网页url

* @param requestMethod 请求方式

* @param refer post内容

* @return 网页内容

*/

public static String sendHttpRequest(String url, RequestMethod requestMethod, String refer) {

refer = refer == null || "".equals(refer) ? null : refer;

StringBuffer buffer = new StringBuffer();

try {

//建立连接

URL requestUrl = new URL(url);

HttpURLConnection connection = (HttpURLConnection) requestUrl.openConnection();

connection.setRequestMethod(requestMethod.getValue());

switch (requestMethod) {

case GET:

connection.connect();

break;

case POST:

if (refer != null) {

OutputStream out = connection.getOutputStream();

out.write((refer.getBytes("UTF-8")));

out.close();

}

break;

default:

break;

}

//获取网页内容

InputStream in = connection.getInputStream();

InputStreamReader inputStreamReader = new InputStreamReader(in, "UTF-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

String str = null;

while ((str = bufferedReader.readLine()) != null) {

buffer.append(str);

}

//关闭资源

bufferedReader.close();

inputStreamReader.close();

in.close();

in = null;

connection.disconnect();

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

return buffer.toString();

}

}

/**

* 双流新闻网地址

*/

private static final String NEWS_URL = "http://epaper.slnews.net.cn/html/%s/%s.htm";

/**

* 获取特定日期的新闻网的版面地址url

* <p>

* 默认不填写factor参数的话,则url为第一版面链接,填入factor值node_2

* </p>

*

* @param date 日期

* @param factor 板面,形式为node_?

* 文章,形式为content_?

* @return 新闻网地址url

*/

public static String takePageUrl(Date date, String factor) {

SimpleDateFormat format = new SimpleDateFormat("yyyy-MM/dd");

factor = factor == null ? "node_2" : factor;

return String.format(NEWS_URL, format.format(date), factor);

}/**

* 双流新闻网地址

*/

private static final String NEWS_URL = "http://epaper.slnews.net.cn/html/%s/%s.htm";

/**

* 获取特定日期的新闻网的版面地址url

* <p>

* 默认不填写factor参数的话,则url为第一版面链接,填入factor值node_2

* </p>

*

* @param date 日期

* @param factor 板面,形式为node_?

* 文章,形式为content_?

* @return 新闻网地址url

*/

public static String takePageUrl(Date date, String factor) {

SimpleDateFormat format = new SimpleDateFormat("yyyy-MM/dd");

factor = factor == null ? "node_2" : factor;

return String.format(NEWS_URL, format.format(date), factor);

}

/**

* 获取内容匹配的元素集合

*

* @param content 网页内容

* @param reg 匹配正则

* @return 元素集合

*/

private static List<String> takeElementList(String content, String reg) {

log.debug("start take elements from content by Reg");

List<String> list = new ArrayList<String>();

//定义正则规则

Pattern pattern = Pattern.compile(reg);

Matcher matcher = pattern.matcher(content);

while (matcher.find()) {

String element = matcher.group(1);

list.add(element);

log.debug(element);

}

log.debug("take elements end");

return list;

}/**

* 获取内容匹配的元素集合

*

* @param content 网页内容

* @param reg 匹配正则

* @return 元素集合

*/

private static List<String> takeElementList(String content, String reg) {

log.debug("start take elements from content by Reg");

List<String> list = new ArrayList<String>();

//定义正则规则

Pattern pattern = Pattern.compile(reg);

Matcher matcher = pattern.matcher(content);

while (matcher.find()) {

String element = matcher.group(1);

list.add(element);

log.debug(element);

}

log.debug("take elements end");

return list;

}

/**

* 获取特定日期新闻网的版面链接元素

*

* @param date 日期

* @return 版面链接的元素集合

*/

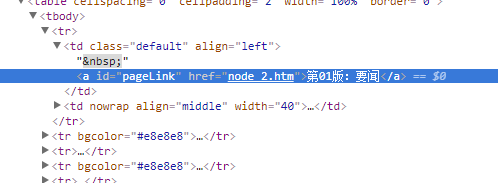

public static List<String> takeNodeUrlEleList(Date date) {

String url = takePageUrl(date, null);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

String reg = "<a id=pageLink href=.*?(node_\\d+?)\\.htm>.*?<\\/a>";

return takeElementList(content, reg);

}

/**

* 获取指定日期指定版面的所有文章链接元素集合

*

* @param date 日期

* @param node 版面元素,格式为node_?

* @return 文章链接的元素集合

*/

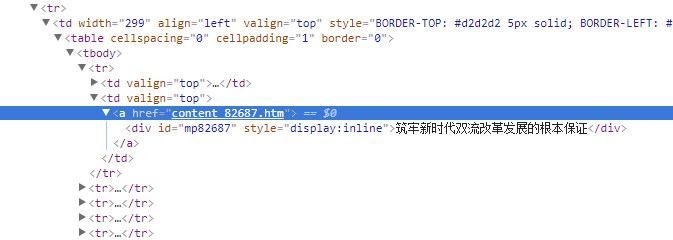

public static List<String> takeNewsUrlEleList(Date date, String node) {

String url = takePageUrl(date, node);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

String reg = "<a href=.*?(content_\\d+?)\\.htm>";

return takeElementList(content, reg);

}/**

* 获取特定日期新闻网的版面链接元素

*

* @param date 日期

* @return 版面链接的元素集合

*/

public static List<String> takeNodeUrlEleList(Date date) {

String url = takePageUrl(date, null);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

String reg = "<a id=pageLink href=.*?(node_\\d+?)\\.htm>.*?<\\/a>";

return takeElementList(content, reg);

}

/**

* 获取指定日期指定版面的所有文章链接元素集合

*

* @param date 日期

* @param node 版面元素,格式为node_?

* @return 文章链接的元素集合

*/

public static List<String> takeNewsUrlEleList(Date date, String node) {

String url = takePageUrl(date, node);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

String reg = "<a href=.*?(content_\\d+?)\\.htm>";

return takeElementList(content, reg);

}

/**

* 抓取指定日期新闻页面内容集合

*

* @param date 日期

* @return 新闻页面内容

*/

public static List<String> takeNewsPageList(Date date) {

log.info("start crawl news page content. date:" + date);

List<String> newsList = new ArrayList<String>();

List<String> nodeEleList = NewsCrawler.takeNodeUrlEleList(date);

for (String nodeEle : nodeEleList) {

List<String> newsEleList = NewsCrawler.takeNewsUrlEleList(date, nodeEle);

for (String newsEle : newsEleList) {

String url = NewsCrawler.takePageUrl(date, newsEle);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

newsList.add(content);

}

}

log.info("crawl news page content end. page amount:" + newsList.size());

return newsList;

}/**

* 抓取指定日期新闻页面内容集合

*

* @param date 日期

* @return 新闻页面内容

*/

public static List<String> takeNewsPageList(Date date) {

log.info("start crawl news page content. date:" + date);

List<String> newsList = new ArrayList<String>();

List<String> nodeEleList = NewsCrawler.takeNodeUrlEleList(date);

for (String nodeEle : nodeEleList) {

List<String> newsEleList = NewsCrawler.takeNewsUrlEleList(date, nodeEle);

for (String newsEle : newsEleList) {

String url = NewsCrawler.takePageUrl(date, newsEle);

String content = CrawlerUtil.sendHttpRequest(url, RequestMethod.GET, null);

newsList.add(content);

}

}

log.info("crawl news page content end. page amount:" + newsList.size());

return newsList;

}

[01-01] 示例:用Java爬取新闻的更多相关文章

- MinerHtmlThread.java 爬取页面线程

MinerHtmlThread.java 爬取页面线程 package com.iteye.injavawetrust.miner; import org.apache.commons.logging ...

- MinerConfig.java 爬取配置类

MinerConfig.java 爬取配置类 package com.iteye.injavawetrust.miner; import java.util.List; /** * 爬取配置类 * @ ...

- Java爬取网络博客文章

前言 近期本人在某云上购买了个人域名,本想着以后购买与服务器搭建自己的个人网站,由于需要筹备的太多,暂时先搁置了,想着先借用GitHub Pages搭建一个静态的站,搭建的过程其实也曲折,主要是域名地 ...

- Java爬取校内论坛新帖

Java爬取校内论坛新帖 为了保持消息灵通,博主没事会上上校内论坛看看新帖,作为爬虫爱好者,博主萌生了写个爬虫自动下载的想法. 嗯,这次就选Java. 第三方库准备 Jsoup Jsoup是一款比较好 ...

- Java爬取B站弹幕 —— Python云图Wordcloud生成弹幕词云

一 . Java爬取B站弹幕 弹幕的存储位置 如何通过B站视频AV号找到弹幕对应的xml文件号 首先爬取视频网页,将对应视频网页源码获得 就可以找到该视频的av号aid=8678034 还有弹幕序号, ...

- java爬取网页内容 简单例子(2)——附jsoup的select用法详解

[背景] 在上一篇博文java爬取网页内容 简单例子(1)——使用正则表达式 里面,介绍了如何使用正则表达式去解析网页的内容,虽然该正则表达式比较通用,但繁琐,代码量多,现实中想要想出一条简单的正则表 ...

- java爬取并下载酷狗TOP500歌曲

是这样的,之前买车送的垃圾记录仪不能用了,这两天狠心买了好点的记录仪,带导航.音乐.蓝牙.4G等功能,寻思,既然有这些功能就利用起来,用4G听歌有点奢侈,就准备去酷狗下点歌听,居然都是需要办会员才能下 ...

- Java爬取并下载酷狗音乐

本文方法及代码仅供学习,仅供学习. 案例: 下载酷狗TOP500歌曲,代码用到的代码库包含:Jsoup.HttpClient.fastJson等. 正文: 1.分析是否可以获取到TOP500歌单 打开 ...

- Java爬取先知论坛文章

Java爬取先知论坛文章 0x00 前言 上篇文章写了部分爬虫代码,这里给出一个完整的爬取先知论坛文章代码. 0x01 代码实现 pom.xml加入依赖: <dependencies> & ...

随机推荐

- git 本地仓库与远程仓库建立连接

我们在使用git clone的时候可能会报错: Could not read from remote repository.Please make sure you have the correct ...

- Python简单的网络编程

OSI 模型介绍 应用层 -- 对接受的数据进行解释.加密与解密.压缩与解压缩 会话层 -- 通过传输层(端口号: 传输端口和接受端口) 建立数据传输的通路 传输层 -- 定义了一些传输数据的协议和端 ...

- vue2.X的路由

以 / 开头的嵌套路径会被当作根路径. <router-link> 在vue-router1.X中是以<a v-link=""></a>存在的 ...

- cf666E. Forensic Examination(广义后缀自动机 线段树合并)

题意 题目链接 Sol 神仙题Orz 后缀自动机 + 线段树合并 首先对所有的\(t_i\)建个广义后缀自动机,这样可以得到所有子串信息. 考虑把询问离线,然后把\(S\)拿到自动机上跑,同时维护一下 ...

- Power BI 与 Azure Analysis Services 的数据关联:3、还原备份文件到Azure Analysis Services

Power BI 与 Azure Analysis Services 的数据关联:3.还原备份文件到Azure Analysis Services 配置存储设置 备份前,需要为服务器配置存储设置. ...

- (后端)NoSuchMethodError

这个错误是说编译时有这个方法,但运行时没有了 请使用:mvn clean install

- 外网访问局域网ip的方法

https://jingyan.baidu.com/article/48b558e335e3ac7f39c09a59.html 步骤: 1.浏览器内输入:192.168.1.1进入路由器管理界面 2. ...

- python第七十九天--第十四周作业

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- Paramiko和堡垒机实现

一.Paramiko paramiko模块,基于SSH用于连接远程服务器并执行相关操作. 1.安装:pip install paramiko 2.SSHClient:用于连接远程服务器并执行基本命令 ...

- Sudoku 个人项目1

Github项目地址:Github 项目相关要求 随机构造出N个不重复的已解答的数独棋盘(0 < N <= 1000000) 在生成数独矩阵时,左上角的第一个数为:(学号后两位相加)% 9 ...