hdfs的透明加密记录

1、背景

我们知道,在hdfs中,我们的数据是以block块存储在我们的磁盘上的,那么默认情况下,它是以密文存储的,还是以明文存储的呢?如果是明文存储的,那么是否就不安全呢?那么在hdfs中是如何做才能做到数据的透明加密呢?

2、常见的加密层级

- 应用层加密: 这是

最安全和最灵活的方法。加密内容最终由应用程序来控制。并且可以精确的反应用户的需求。但是,编写应用程序来实现加密一般都比较困难。 - 数据库层加密: 类似于应用程序级加密。大多数数据库供应商都提供某种形式的加密。但是

可能存在性能问题。比如:索引无法加密。 - 文件系统层加密: 这种方式对性能影响不大,且对应用程序是透明的,一般也比较容易实施。但是如果需要应对细粒度的要求策略,可能无法完全满足。比如:加密文件系统(EFS)用于在(NTFS)文件系统卷上存储已加密的文件。

- 磁盘层加密: 易于部署和高性能,但是相当不灵活,只能防止用户从物理层面盗窃数据。

3、透明加密介绍

- HDFS透明加密(

Transparent Encryption)支持端对端的透明加密,启用以后,对于一些需要加密的HDFS目录里的文件可以实现透明的加密和解密,而不需要修改用户的业务代码。端对端是指加密和解密只能通过客户端来操作。 - 对于

加密区域里的文件,HDFS保存的即是加密后的文件,文件加密的密钥也是加密的。让非法用户即使从操作系统层面拷走文件,也是密文,没法查看。 - HDFS

集群管理和密钥的管理是互相独立的职责,由不同的用户角色(HDFS管理员、密钥管理员)承担。 - 只有

HDFS客户端可以加密或解密数据,密钥管理在HDFS外部,HDFS无法访问未加密的数据或加密密钥。

4、HDFS透明加密的核心概念

4.1 加密区域

加密区域就是HDFS上的一个目录,只不过该目录相对而言稍微特殊点。 文件写入的时候会被透明加密,文件读取的时候会被透明解密。

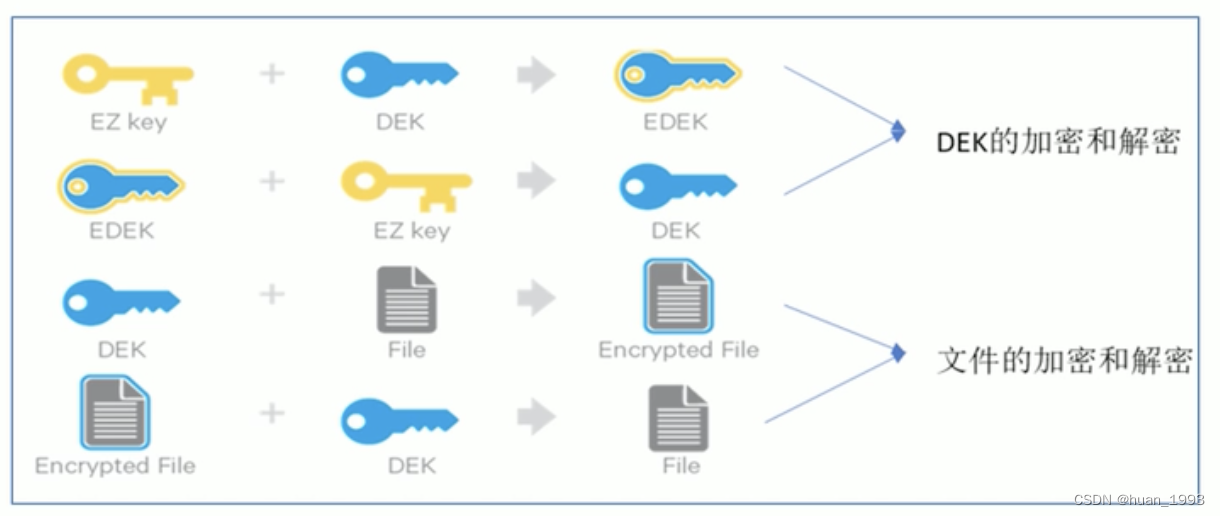

4.2 加密区域密钥-EZ KEY

当加密区域被创建时,都会有一个加密区域密钥(EZ密钥, encryption zone key)与之对应,EZ密钥存储在HDFS外部的密钥库中。

4.3 数据加密密钥-DEK

加密区域里的每个文件都有其自己的加密密钥,叫做数据加密密钥(DEK, data. encryption key)。

4.4 加密数据加密密钥 EDEK

DEK会使用其各自的加密区域的EZ密钥进行加密,以形成 加密数据加密密钥(EDEK)

4.5 DEK的加解密和文件的加解密

4.6 密钥库

存储密钥(key)的叫做密钥库(keystore),将HDFS与外部企业级密钥库(keystore)集成是部署透明加密的第一步。为什么密钥库独立与HDFS之外?

可以指责分离,而且也更加安全。 这样hdfs管理员和keystore管理员就是2个人,各个处理各自的事情。

4.7 KMS 密钥管理服务

- Hadoop

密钥管理服务(Key Management Server,简称KMS),用作HDFS客户端与密钥库之间的代理。 - KMS主要有以下几个职责

- 访问加密区域密钥(EZ Key)

- 生成EDEK,

EDEK存储在NameNode上 - 为HDFS客户端解密EDEK

5、配置透明加密

5.1 关闭hdfs集群

[hadoopdeploy@hadoop01 sh]$ stop-dfs.sh

Stopping namenodes on [hadoop01]

Stopping datanodes

Stopping secondary namenodes [hadoop03]

[hadoopdeploy@hadoop01 sh]$

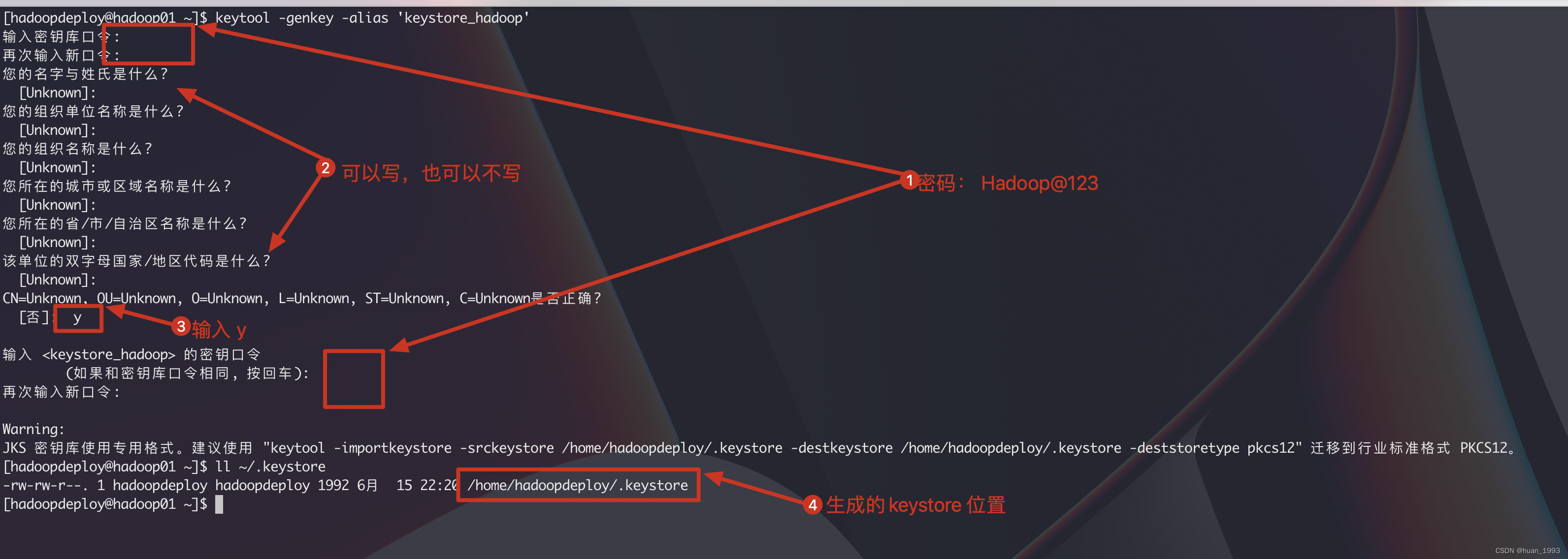

5.2 创建keystore

密钥库的密码为Hadoop@123

[hadoopdeploy@hadoop01 ~]$ keytool -genkey -alias 'keystore_hadoop'

输入密钥库口令:

再次输入新口令:

您的名字与姓氏是什么?

[Unknown]:

您的组织单位名称是什么?

[Unknown]:

您的组织名称是什么?

[Unknown]:

您所在的城市或区域名称是什么?

[Unknown]:

您所在的省/市/自治区名称是什么?

[Unknown]:

该单位的双字母国家/地区代码是什么?

[Unknown]:

CN=Unknown, OU=Unknown, O=Unknown, L=Unknown, ST=Unknown, C=Unknown是否正确?

[否]: y

输入 <keystore_hadoop> 的密钥口令

(如果和密钥库口令相同, 按回车):

再次输入新口令:

Warning:

JKS 密钥库使用专用格式。建议使用 "keytool -importkeystore -srckeystore /home/hadoopdeploy/.keystore -destkeystore /home/hadoopdeploy/.keystore -deststoretype pkcs12" 迁移到行业标准格式 PKCS12。

[hadoopdeploy@hadoop01 ~]$ ll ~/.keystore

-rw-rw-r--. 1 hadoopdeploy hadoopdeploy 1992 6月 15 22:20 /home/hadoopdeploy/.keystore

[hadoopdeploy@hadoop01 ~]$

5.3 编辑 kms-site.xml文件

<configuration>

<!-- 设置密钥库的提供者,jceks:标识的是java密钥库 -->

<property>

<name>hadoop.kms.key.provider.uri</name>

<value>jceks://file@/${user.home}/kms.jks</value>

</property>

<!-- 密钥库的密码文件,该文件中保存的是访问密钥库的密码, 需要放置在hadoop的配置文件夹下 ...../etc/hadoop -->

<property>

<name>hadoop.security.keystore.java-keystore-provider.password-file</name>

<value>kms.keystore.password.txt</value>

</property>

<property>

<name>hadoop.kms.http.port</name>

<value>16000</value>

</property>

<!-- 对外暴露的kms服务地址 -->

<property>

<name>dfs.encryption.key.provider.uri</name>

<value>kms://http@hadoop01:16000/kms</value>

</property>

<!-- 认证方式 -->

<property>

<name>hadoop.kms.authentication.type</name>

<value>simple</value>

</property>

</configuration>

需要创建kms.keystore.password.txt文件,并设置密钥库的密码

[hadoopdeploy@hadoop01 hadoop]$ cat /opt/bigdata/hadoop-3.3.4/etc/hadoop/kms.keystore.password.txt

Hadoop@123

[hadoopdeploy@hadoop01 hadoop]$

5.4 编辑 kms-env.sh

export KMS_HOME=/opt/bigdata/hadoop-3.3.4

export KMS_LOG=${KMS_HOME}/logs/kms

export KMS_ADMIN_PORT=16001

5.5 修改core-site.xml

<!-- 指定访问kms服务的地址 -->

<property>

<name>hadoop.security.key.provider.path</name>

<value>kms://http@hadoop01:16000/kms</value>

</property>

5.6 修改hdfs-site.xml

<!-- 指定访问kms服务的地址 -->

<property>

<name>dfs.encryption.key.provider.uri</name>

<value>kms://http@hadoop01:16000/kms</value>

</property>

5.7 同步配置到集群另外的机器上

[hadoopdeploy@hadoop01 hadoop]$ scp kms-site.xml kms-env.sh core-site.xml hdfs-site.xml hadoop01:$PWD

[hadoopdeploy@hadoop01 hadoop]$ scp kms-site.xml kms-env.sh core-site.xml hdfs-site.xml hadoop02:$PWD

5.8 启动hdfs集群

[hadoopdeploy@hadoop01 hadoop]$ start-dfs.sh

Starting namenodes on [hadoop01]

Starting datanodes

Starting secondary namenodes [hadoop03]

[hadoopdeploy@hadoop01 hadoop]$ jps

2080 NameNode

2243 DataNode

2471 Jps

[hadoopdeploy@hadoop01 hadoop]$

5.9 启动kms服务

[hadoopdeploy@hadoop01 hadoop]$ hadoop --daemon start kms

WARNING: KMS_LOG has been replaced by HADOOP_LOG_DIR. Using value of KMS_LOG.

WARNING: /opt/bigdata/hadoop-3.3.4//temp does not exist. Creating.

WARNING: /opt/bigdata/hadoop-3.3.4/logs/kms does not exist. Creating.

[hadoopdeploy@hadoop01 hadoop]$ jps

2080 NameNode

2243 DataNode

2870 KMSWebServer

2904 Jps

[hadoopdeploy@hadoop01 hadoop]$

hadoop --daemon stop kms 停止kms服务

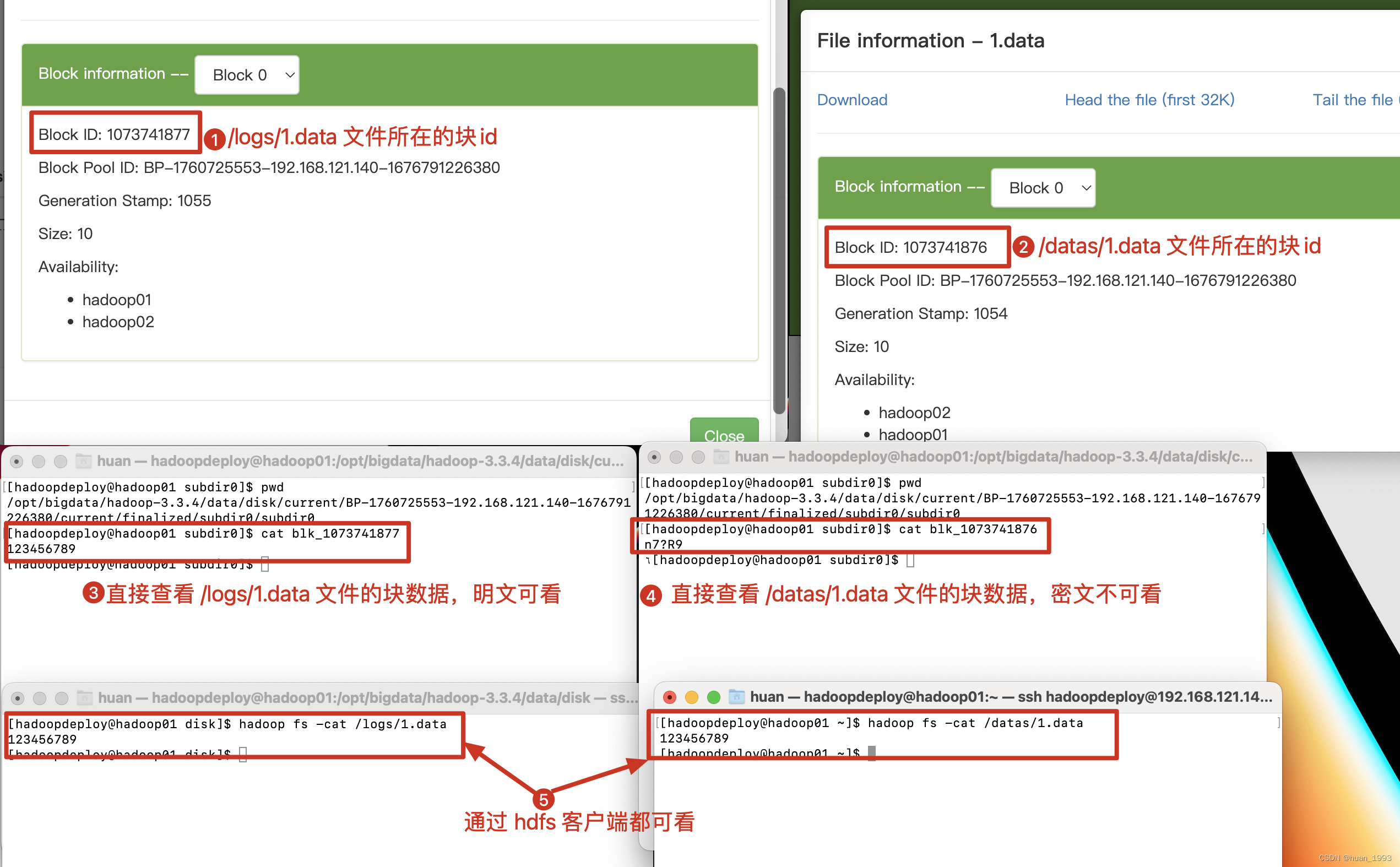

6、测试透明加密

需求: 在hdfs上创建2个目录logs和datas,只要是在datas目录中上传文件都需要透明加密,logs目录不需要,同时往logs和datas目录中上传一个文件,然后查看对应文件在磁盘上的block块,直接在操作系统上查看这个块,看文件是否加密。

6.1 准备数据

[hadoopdeploy@hadoop01 hadoop]$ hadoop fs -mkdir /logs

[hadoopdeploy@hadoop01 hadoop]$ hadoop fs -mkdir /datas

[hadoopdeploy@hadoop01 hadoop]$ hadoop fs -ls /

Found 2 items

drwxr-xr-x - hadoopdeploy supergroup 0 2023-06-16 21:10 /datas

drwxr-xr-x - hadoopdeploy supergroup 0 2023-06-16 21:10 /logs

[hadoopdeploy@hadoop01 hadoop]$ echo 123456789 > 1.data

[hadoopdeploy@hadoop01 hadoop]$ cat 1.data

123456789

[hadoopdeploy@hadoop01 hadoop]$

在 / 目录下创建2个文件夹 logs和datas, 并创建一个文件1.data,内容为123456789, 1.data先不传递到logs和datas目录中。

6.2 创建key

# 创建一个key ,名字是 ezk_datas

[hadoopdeploy@hadoop01 hadoop]$ hadoop key create ezk_datas

ezk_datas has been successfully created with options Options{cipher='AES/CTR/NoPadding', bitLength=128, description='null', attributes=null}.

org.apache.hadoop.crypto.key.kms.LoadBalancingKMSClientProvider@3d5c822d has been updated.

# 查看key 列表

[hadoopdeploy@hadoop01 hadoop]$ hadoop key list -metadata

Listing keys for KeyProvider: org.apache.hadoop.crypto.key.kms.LoadBalancingKMSClientProvider@2f8dad04

ezk_datas : cipher: AES/CTR/NoPadding, length: 128, description: null, created: Fri Jun 16 21:36:51 CST 2023, version: 1, attributes: [key.acl.name=ezk_datas]

[hadoopdeploy@hadoop01 hadoop]$

6.3 创建加密区域

[hadoopdeploy@hadoop01 hadoop]$ hdfs crypto -createZone -keyName ezk_datas -path /datas

Added encryption zone /datas

[hadoopdeploy@hadoop01 hadoop]$

ezk_datas: 为我们创建的ezk的名字

/datas: hdfs上的一个目录

6.4 文件上传

# 往/datas目录上传一个文件

[hadoopdeploy@hadoop01 hadoop]$ hadoop fs -put 1.data /datas

# 往/logs目录上传一个文件

[hadoopdeploy@hadoop01 hadoop]$ hadoop fs -put 1.data /logs

[hadoopdeploy@hadoop01 hadoop]$

6.5 查看加密文件

7、参考资料

1、https://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-hdfs/TransparentEncryption.html

hdfs的透明加密记录的更多相关文章

- hadoop 透明加密

hadoop 透明加密 hadoop 透明加密 kms transparent 2015年04月09日 18:12:20 糖糖_ 阅读数:12248 标签: transparenthadoop kms ...

- SqlServer2008数据库透明加密

前几天研究了一下sql数据库的透明加密,记下来加深一下理解. 用脚本创建文件夹 --查文件夹有没有 EXEC master.dbo.xp_fileexist 'D:\DATA\storedcerts' ...

- KingbaseES 表空间加密-透明加密

透明存储加密是指数据在写到磁盘上时对其进行加密,当授权用户重新读取数据时再对其进行解密.加密解密过程对用户都是透明的,无需对应用程序进行修改,授权用户甚至不会注意到数据已经在存储介质上加密.当前的透明 ...

- ORACLE透明加密

--官网文档:https://www.oracle.com/technetwork/cn/tutorials/tde-096009-zhs.html#t概述Oracle 数据库 10g 第 2 版透明 ...

- .NET和JAVA同等加密方法,MD5和DES对称加密记录

C#版: using System; using System.Security.Cryptography; using System.Text; namespace ConsoleApplicati ...

- 参考别人的代码写的aes加密,记录一下(AES,ECB模式,填充PKCS5Padding,数据块128位,偏移量无,以hex16进制输出)

package org.jimmy.autosearch2019.test; import java.security.SecureRandom; import javax.crypto.Cipher ...

- Hadoop HDFS 源码解析记录

版权说明: 本文章版权归本人及博客园共同所有,转载请标明原文出处( https://www.cnblogs.com/mikevictor07/p/12047502.html ),以下内容为个人理解,仅 ...

- 读Hadoop3.2源码,深入了解java调用HDFS的常用操作和HDFS原理

本文将通过一个演示工程来快速上手java调用HDFS的常见操作.接下来以创建文件为例,通过阅读HDFS的源码,一步步展开HDFS相关原理.理论知识的说明. 说明:本文档基于最新版本Hadoop3.2. ...

- (转)笔记320 SQLSERVER中的加密函数 2013-7-11

1 --SQLSERVER中的加密函数 2013-7-11 2 ENCRYPTBYASYMKEY() --非对称密钥 3 ENCRYPTBYCERT() --证书加密 4 ENCRYPTBYKEY() ...

- Oracle中对列加密的方法

Oracle中对列加密的方法 2011-12-22 17:21:13 分类: Linux Oracle支持多种列加密方式: 1,透明数据加密(TDE):create table encrypt_col ...

随机推荐

- NC20240 [SCOI2005]互不侵犯KING

题目链接 题目 题目描述 在N×N的棋盘里面放K个国王,使他们互不攻击,共有多少种摆放方案. 国王能攻击到它上下左右,以及左上 左下右上右下八个方向上附近的各一个格子,共8个格子. 输入描述 只有一行 ...

- CSS实现图形效果

CSS实现图形效果 CSS实现正方形.长方形.圆形.半圆.椭圆.三角形.平行四边形.菱形.梯形.六角星.五角星.心形.消息框. 正方形 <section> <div id=" ...

- JavaScript 的新数组分组方法

对数组中的项目进行分组,你可能已经做过很多次了.每次都会手动编写一个分组函数,或者使用 lodash 的 groupBy 函数. 好消息是,JavaScript 现在有了分组方法,所以你再也不必这样做 ...

- C++ 多线程的错误和如何避免(15)

尽量不使用无锁架构,除非绝对必要 复杂性中有一些东西吸引了每一位工程师.与常规同步机制(如互斥锁.条件变量.异步等)相比,无锁编程听起来非常性感.然而,与我交谈过的每一位经验丰富的 C++ 开发人员都 ...

- React native随笔——解决navigation导航栏 android和ios样式不统一

navigation导航栏存在android和ios样式不统一的问题.Android手机上标题不居中,导航栏与状态栏重合. 解决方法为在navigationOptions中进行如下配置. 一.Andr ...

- Avalonia 跨平台框架中如何以正确的姿势使用 OpenGL ES 渲染。

前言 这是一篇很水的文章,没有任何技术含量,在 Github 已经有很多人对 Avalonia 的 OpenGL ES 支持进行了讨论,但是我还是想写一篇文章来记录一下我是如何在 Avalonia 中 ...

- 【Azure Logic App】在Logic App中使用 Transfer XML组件遇见错误 undefined

问题描述 在Azure Logic App中,使用Transform XML组件进行XML内容的转换,但是最近这个组件运行始终失败. 问题解答 点击Transform XML组件上的错误案例,并不能查 ...

- 【Azure 媒体服务】使用媒体服务 v3 对视频进行上载、编码和流式传输时遇见的AAD错误

问题描述 使用媒体服务 v3 对视频进行上载.编码和流式传输示例时,遇见了AAD错误. TIP: Make sure that you have filled out the appsettings. ...

- 浅入 ABP 系列(7):对象映射

目录 基础 DTO和实体 麻烦的映射 AutoMapper 集成 IObjectMapper/ObjectMapper 对象拓展 写博客的过程中,发现很多基础理论太薄弱,因此很多专业词汇可能会解释错误 ...

- Jepsen 测试框架在图数据库 Nebula Graph 中的实践

在本篇文章中主要介绍图数据库 Nebula Graph 在 Jepsen 这块的实践. Jepsen 简介 Jepsen 是一款用于系统测试的开源软件库,致力于提高分布式数据库.队列.共识系统等的安全 ...