深入爬虫书scrapy 之json内容没有写入文本

settings.py设置

ITEM_PIPELINES = {

'tets.pipelines.TetsPipeline': 300,

}

spider代码

xpath后缀添加.extract() parse()返回return item

import scrapy

from tets.items import TetsItem class KugouSpider(scrapy.Spider):

name = 'kugou'

allowed_domains = ['www.kugou.com']

start_urls = ['http://www.kugou.com/'] def parse(self, response):

item = TetsItem()

item['title'] = response.xpath("/html/head/title/text()").extract()

print(item['title'])

return item

piplines代码

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import codecs

import json class TetsPipeline(object):

def __init__(self):

# self.file = codecs.open("D:/git/learn_scray/day11/mydata2.txt", "wb", encoding="utf-8")

self.file = codecs.open("D:/git/learn_scray/day11/1.json", "wb", encoding="utf-8") # 处理文本(xx.txt)

# def process_item(self, item, spider):

# l = str(item) + "\n"

# print(l)

# self.file.write(l)

# return item

def process_item(self, item, spider):

print("进入")

# print(item)

i = json.dumps(dict(item), ensure_ascii=False)

# print("进入json")

# print(i)

l = i + "\n"

print(l)

self.file.write(l)

return item def close_spider(self, spider):

slef.file.close()

items.py

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class TetsItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

title = scrapy.Field()

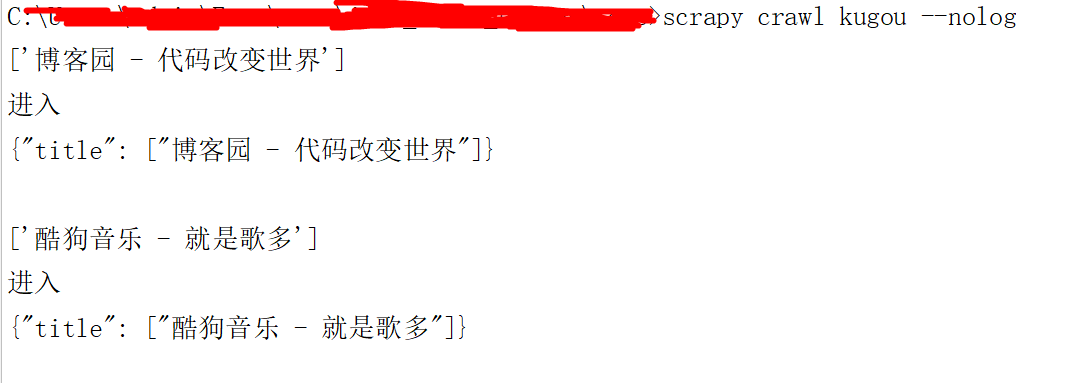

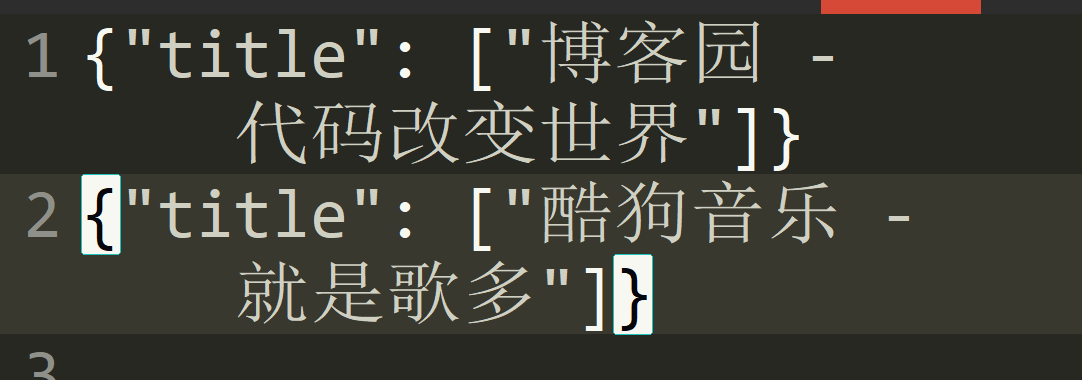

结果如图下

深入爬虫书scrapy 之json内容没有写入文本的更多相关文章

- 服务端JSON内容中有富文本时

问题背景 由于数据中存在复杂的富文本,包含各种引号和特殊字符,导致后端和前端通过JSON格式进行数据交互引发前端JSON解析出错. 解决方案 后端将富文本内容 ConvertToBase64Strin ...

- python根据索引删除内容并写入文本

在python中,有个好用的模块linecache,该模块允许从任何文件里得到任何的行,并且使用缓存进行优化,常见的情况是从单个文件读取多行.linecache.getline(filename,li ...

- scrapy(四): 爬取二级页面的内容

scrapy爬取二级页面的内容 1.定义数据结构item.py文件 # -*- coding: utf-8 -*- ''' field: item.py ''' # Define here the m ...

- Scrapy 框架 使用 selenium 爬取动态加载内容

使用 selenium 爬取动态加载内容 开启中间件 DOWNLOADER_MIDDLEWARES = { 'wangyiPro.middlewares.WangyiproDownloaderMidd ...

- Learning Scrapy笔记(六)- Scrapy处理JSON API和AJAX页面

摘要:介绍了使用Scrapy处理JSON API和AJAX页面的方法 有时候,你会发现你要爬取的页面并不存在HTML源码,譬如,在浏览器打开http://localhost:9312/static/, ...

- 爬虫框架scrapy的基本内容

Scrapy介绍 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 可以帮助用户简单快速的部署一个专业的网络爬虫.如果说前面我们写的定制bs4爬虫是”手动挡“,那Scrapy就相当 ...

- 【C#】菜单功能,将剪贴板JSON内容或者xml内容直接粘贴为类

VS 2015菜单功能,将剪贴板JSON内容或者xml内容直接粘贴为类

- .net mvc web api 返回 json 内容,过滤值为null的属性

原文:http://blog.csdn.net/xxj_jing/article/details/49508557 版权声明:本文为博主原创文章,未经博主允许不得转载. .net mvc web ap ...

- 使用jsonpath解析json内容

JsonPath提供的json解析非常强大,它提供了类似正则表达式的语法,基本上可以满足所有你想要获得的json内容.下面我把官网介绍的每个表达式用代码实现,可以更直观的知道该怎么用它. 一.首先需要 ...

随机推荐

- hibernate3缓存(hibernate)

一级缓存:当应用程序调用Session 的save() .update() .savaeOrUpdate() .get() 或load() ,以及调用查询接口的list() .iterate() 或f ...

- Ukulele 天空之城

- PAT 乙级 1027

题目 题目地址:PAT 乙级 1027 思路 本题需要注意两点: 1. 对于每行输出字符的循环和判断没有完全搞清楚,导致在4 * 的条件下会输出7个字符,n的结果是-3. 2. 没有考虑到小于等于0的 ...

- 【树链剖分 差分】bzoj3626: [LNOI2014]LCA

把LCA深度转化的那一步还是挺妙的.之后就是差分加大力数据结构了. Description 给出一个n个节点的有根树(编号为0到n-1,根节点为0).一个点的深度定义为这个节点到根的距离+1.设dep ...

- URL链接后面的参数解析,与decode编码解码;页面刷新回到顶部jquery

function request() { var urlStr = location.search; ) { theRequest = []; return; } urlStr = urlStr.su ...

- centos 7.3安装教程

进入安装初始化界面 等待检查完就可以进入安装了,不想等待的按ESC退出,没关系的 语言这里我们推荐使用英文: 然后点击Continue继续 选择-系统SYSTEM-安装位置INSTALLTION DE ...

- POJ 1160 四边形不等式优化DP Post Office

d(i, j)表示用i个邮局覆盖前j个村庄所需的最小花费 则有状态转移方程:d(i, j) = min{ d(i-1, k) + w(k+1, j) } 其中w(i, j)的值是可以预处理出来的. 下 ...

- nginx+django+uwsgi+https 配置问题点

- ssl 证书申请 申请域名的网站申请下载对应文件即可 - nginx 配置 https [root@VM_2_29_centos conf]# nginx -t nginx: [emerg] u ...

- NOS跨分区灾备设计与实现

本文来自网易云社区 作者:王健 摘要 NOS(网易对象存储)在实现多机房(杭州机房,北京机房等)部署后,允许一个用户在建桶时选择桶所属机房.在此基础上,我们实现了跨机房的数据复制,进一步实现了跨机房的 ...

- CI - Set CSRF Hash and Cookie

/** * Set CSRF Hash and Cookie * * @return string */ protected function _csrf_set_hash() { if ($this ...