【ElasticSearch】大数据量情况下的前缀、中缀实时搜索方案

简述

业务开发中经常会遇到这样一种情况,用户在搜索框输入时要实时展示搜索相关的结果。要实现这个场景常用的方案有Completion Suggester、search_as_you_type。那么这两种方式有什么区别呢?一起来了解下。

环境说明:

数据量:9000w+

es版本:7.10.1

脚本执行工具:kibana

Completion Suggester和search_as_you_type的区别

1.Completion Suggester是基于前缀匹配、且数据结构存储在内存中,超级快,缺点是耗内存

2.search_as_you_type可以是前缀、中缀匹配,可以很快,但是要选好查询方式

3.Api调用方式不同,Completion Suggester是通过Suggest语句查询,search_as_you_type和常规查询方式一致

举个栗子

如何实现前缀匹配需求

使用Completion Suggester,示例如下:

- 创建索引

PUT /es_demo

{

"mappings": {

"properties": {

"title_comp": {

"type": "completion",

"analyzer": "standard"

}

}

}

}

- 初始化数据

POST _bulk

{"index":{"_index":"es_demo","_id":"1"}}

{"title_comp": "愤怒的小鸟"}

{"index":{"_index":"es_demo","_id":"2"}}

{"title_comp": "最后一只渡渡鸟"}

{"index":{"_index":"es_demo","_id":"3"}}

{"title_comp": "今天不加班啊"}

{"index":{"_index":"es_demo","_id":"4"}}

{"title_comp": "愤怒的青年"}

{"index":{"_index":"es_demo","_id":"5"}}

{"title_comp": "最后一只996程序猿"}

{"index":{"_index":"es_demo","_id":"6"}}

{"title_comp": "今日无事,勾栏听曲"}

- 查询DSL

通过前缀查询,查找以“愤怒”开头的字符串

GET /es_demo/_search

{

"suggest": {

"title_suggest": {

"prefix": "愤怒",

"completion": {

"field": "title_comp"

}

}

}

}

- 查询代码demo

@SpringBootTest

public class SuggestTest {

@Autowired

private RestHighLevelClient restHighLevelClient;

@Test

public void testComp() {

List<Map<String, Object>> list = suggestComplete("愤怒");

list.forEach(m -> System.out.println("[" + m.get("title_comp") + "]"));

}

public List<Map<String, Object>> suggestComplete(String keyword) {

CompletionSuggestionBuilder completionSuggestionBuilder = SuggestBuilders.completionSuggestion("title_comp");

completionSuggestionBuilder.size(5)

//跳过重复的

.skipDuplicates(true);

SuggestBuilder suggestBuilder = new SuggestBuilder();

suggestBuilder.addSuggestion("suggest_title", completionSuggestionBuilder)

.setGlobalText(keyword);

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();

searchSourceBuilder.suggest(suggestBuilder);

SearchRequest searchRequest = new SearchRequest("es_demo").source(searchSourceBuilder);

try {

SearchResponse response = restHighLevelClient.search(searchRequest, RequestOptions.DEFAULT);

CompletionSuggestion completionSuggestion = response.getSuggest().getSuggestion("suggest_title");

List<Map<String, Object>> suggestList = new LinkedList<>();

for (CompletionSuggestion.Entry.Option option : completionSuggestion.getOptions()) {

Map<String, Object> map = new HashMap<>();

map.put("title_comp", option.getHit().getSourceAsMap().get("title_comp"));

suggestList.add(map);

}

return suggestList;

} catch (IOException e) {

throw new RuntimeException("ES查询出错");

}

}

}

查询结果:

[愤怒的小鸟]

[愤怒的青年]

如何实现中缀匹配需求

使用search_as_you_type,此处提供了hanlp_index和standard两种分词器的字段示例。示例如下:

- 创建索引

PUT /es_search_as_you_type

{

"mappings": {

"properties": {

"title": {

"type": "text",

"fields": {

"han": {

"type": "search_as_you_type",

"analyzer": "hanlp_index"

},

"stan": {

"type": "search_as_you_type",

"analyzer": "standard"

}

}

}

}

}

}

- 初始化数据

POST _bulk

{"index":{"_index":"es_search_as_you_type","_id":"1"}}

{"title": "愤怒的小鸟"}

{"index":{"_index":"es_search_as_you_type","_id":"2"}}

{"title": "最后一只渡渡鸟"}

{"index":{"_index":"es_search_as_you_type","_id":"3"}}

{"title": "今天不加班啊"}

{"index":{"_index":"es_search_as_you_type","_id":"4"}}

{"title": "愤怒的青年"}

{"index":{"_index":"es_search_as_you_type","_id":"5"}}

{"title": "最后一只996程序猿"}

{"index":{"_index":"es_search_as_you_type","_id":"6"}}

{"title": "今日无事,勾栏听曲"}

- 查询DSL

GET /es_search_as_you_type/_search

{

"query": {

"match": {

"title.stan": {

"query": "的小",

"operator": "and"

}

}

}

}

- 查询代码demo

@SpringBootTest

public class SuggestTest {

@Autowired

private RestHighLevelClient restHighLevelClient;

@Test

public void testSearchAsYouType() {

List<Map<String, Object>> list = suggestSearchAsYouType("的小");

list.forEach(m -> System.out.println("[" + m.get("title") + "]"));

}

public List<Map<String, Object>> suggestSearchAsYouType(String keyword) {

//这里使用了search_as_you_type的2gram字段,可以根据自己需求调整配置

MatchQueryBuilder matchQueryBuilder = matchQuery("title.stan._2gram", keyword).operator(Operator.AND);

//需要返回的字段

String[] includeFields = new String[]{"title"};

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder()

.query(matchQueryBuilder).size(5)

.fetchSource(includeFields, null)

.trackTotalHits(false)

.trackScores(true)

.sort(SortBuilders.scoreSort());

SearchRequest searchRequest = new SearchRequest("es_search_as_you_type").source(searchSourceBuilder);

try {

SearchResponse response = restHighLevelClient.search(searchRequest, RequestOptions.DEFAULT);

org.elasticsearch.search.SearchHits hits = response.getHits();

List<Map<String, Object>> suggestList = new LinkedList<>();

for (org.elasticsearch.search.SearchHit hit : hits) {

Map<String, Object> map = new HashMap<>();

map.put("title", hit.getSourceAsMap().get("title").toString());

suggestList.add(map);

}

return suggestList;

} catch (IOException e) {

throw new RuntimeException("ES查询出错");

}

}

}

查询结果:

[愤怒的小鸟]

分词器说明

查看分词结果的方式

第一种

指定分词器

GET _analyze

{

"analyzer": "standard",

"text": [

"愤怒的小鸟"

]

}

第二种

指定使用某个字段的分词器

POST es_search_as_you_type/_analyze

{

"field": "title.stan",

"text": [

"愤怒的青年"

]

}

hanlp_index和standard分词器的区别

standard分词器

- 默认会过滤掉符号

- 中文以单个字为最小单位,英文则会以空格符或其他符号或中文分隔作为一个单词

例:

GET _analyze

{

"analyzer": "standard",

"text": [

"愤怒的小鸟"

]

}

分词结果:

{

"tokens" : [

{

"token" : "愤",

"start_offset" : 0,

"end_offset" : 1,

"type" : "<IDEOGRAPHIC>",

"position" : 0

},

{

"token" : "怒",

"start_offset" : 1,

"end_offset" : 2,

"type" : "<IDEOGRAPHIC>",

"position" : 1

},

{

"token" : "的",

"start_offset" : 2,

"end_offset" : 3,

"type" : "<IDEOGRAPHIC>",

"position" : 2

},

{

"token" : "小",

"start_offset" : 3,

"end_offset" : 4,

"type" : "<IDEOGRAPHIC>",

"position" : 3

},

{

"token" : "鸟",

"start_offset" : 4,

"end_offset" : 5,

"type" : "<IDEOGRAPHIC>",

"position" : 4

}

]

}

hanlp_index分词器

- 默认不会过滤符号

- 通过语义等对字符串进行分词,会分出词语

例:

GET _analyze

{

"analyzer": "hanlp_index",

"text": [

"愤怒的小鸟"

]

}

分词结果:

{

"tokens" : [

{

"token" : "愤怒",

"start_offset" : 0,

"end_offset" : 2,

"type" : "a",

"position" : 0

},

{

"token" : "的",

"start_offset" : 2,

"end_offset" : 3,

"type" : "ude1",

"position" : 1

},

{

"token" : "小鸟",

"start_offset" : 3,

"end_offset" : 5,

"type" : "n",

"position" : 2

}

]

}

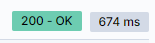

生产实践中的查询情况

基本都是几百毫秒就解决。ps:如果一条数据字段很多,最好只返回几个需要的字段即可,否则数据传输就要占用较多时间。

总结

当然,无论是Completion Suggester还是search_as_you_type的查询配置方式都还有很多,例如Completion Suggester的Context Suggester,search_as_you_type的2gram、3gram,还有查询类型match_bool_prefix、match_phrase、match_phrase_prefix等等。各种组合起来都会产生不同的效果,笔者这里只是列举出一种还算可以的方式。关于其他的查询类型和配置如何使用以及分别是怎么工作的,下次有空再聊聊。

官方文档链接

https://www.elastic.co/guide/en/elasticsearch/reference/7.10/search-as-you-type.html

【ElasticSearch】大数据量情况下的前缀、中缀实时搜索方案的更多相关文章

- 大数据量情况下求top N的问题

上周五的时候去参加了一个面试,被问到了这个问题.问题描述如下: 假如存在一个很大的文件,文件中的每一行是一个字符串.请问在内存有限的情况下(内存无法加载这个文件中的所有内容),如何计算出出现频率最高的 ...

- phpExcel导入大数据量情况下内存溢出解决方案

PHPExcel版本:1.7.6+ 在不进行特殊设置的情况下,phpExcel将读取的单元格信息保存在内存中,我们可以通过 PHPExcel_Settings::setCacheStorageMeth ...

- phpExcel大数据量情况下内存溢出解决

版本:1.7.6+ 在不进行特殊设置的情况下,phpExcel将读取的单元格信息保存在内存中,我们可以通过 PHPExcel_Settings::setCacheStorageMethod() 来设置 ...

- 大数据量情况下高效比较两个list

比如,对两个list<object>进行去重,合并操作时,一般的写法为两个for循环删掉一个list中重复的,然后再合并. 如果数据量在千条级别,这个速度还是比较快的.但如果数据量超过20 ...

- MYSQL的大数据量情况下的分页查询优化

最近做的项目需要实现一个分页查询功能,自己先看了别人写的方法: <!-- 查询 --> <select id="queryMonitorFolder" param ...

- C#拼接SQL语句,SQL Server 2005+,多行多列大数据量情况下,使用ROW_NUMBER实现的高效分页排序

/// <summary>/// 单表(视图)获取分页SQL语句/// </summary>/// <param name="tableName"&g ...

- 大数据量冲击下Windows网卡异常分析定位

背景 mqtt的服务端ActiveMQ在windows上,多台PC机客户端不停地向MQ发送消息. 现象 观察MQ自己的日志data/activemq.log里显示,TCP链接皆异常断开.此时尝试从服务 ...

- 大数据量场景下storm自定义分组与Hbase预分区完美结合大幅度节省内存空间

前言:在系统中向hbase中插入数据时,常常通过设置region的预分区来防止大数据量插入的热点问题,提高数据插入的效率,同时可以减少当数据猛增时由于Region split带来的资源消耗.大量的预分 ...

- 一脸懵逼学习HBase---基于HDFS实现的。(Hadoop的数据库,分布式的,大数据量的,随机的,实时的,非关系型数据库)

1:HBase官网网址:http://hbase.apache.org/ 2:HBase表结构:建表时,不需要指定表中的字段,只需要指定若干个列族,插入数据时,列族中可以存储任意多个列(即KEY-VA ...

- MySQL数据库如何解决大数据量存储问题

利用MySQL数据库如何解决大数据量存储问题? 各位高手您们好,我最近接手公司里一个比较棘手的问题,关于如何利用MySQL存储大数据量的问题,主要是数据库中的两张历史数据表,一张模拟量历史数据和一张开 ...

随机推荐

- Linx 阶段一

Linux Linux常用命令 具体演示 1). ls 2). pwd 3). touch 4). mkdir 5). rm 使用技巧 1. 连按 Tab健自动补齐文件名 2. ll 查看当前目录文件 ...

- xlsx纯前端导出表格,完善边框等样式

仅用xlsx是无法实现文字样式及表格边框的style的,因此配合使用xlsx-style 以下源码直接复制过去用 // 源码什么的都不需要改动 import * as XLSXStyle from ' ...

- mysql基础_事务

定义 一个事务其实就是一个完整的业务逻辑,是一个最小的工作单元,不可再分,事务会把所有的操作作为一个整体一起向系统提交或撤销操作请求,即这些操作要么同时成功,要么同时失败. 例如:王五向赵六的账户上转 ...

- selenium配置远程测试环境

开头 因为测试的时候需要不断打开浏览器,这样效率感觉不高,于是想着能不能开启一个浏览器,然后通过代码直接链接来调试就好了. 前提 要先安装好selenium 和 会查看配置自己的google版本和路径 ...

- 2020-10-24:go中channel的recv流程是什么?

福哥答案2020-10-24: ***[评论](https://user.qzone.qq.com/3182319461/blog/1603496305)

- AcWing 3956. 截断数组

给定一个长度为 n 的数组 a1,a2,-,an. 现在,要将该数组从中间截断,得到三个非空子数组. 要求,三个子数组内各元素之和都相等. 请问,共有多少种不同的截断方法? 输入格式 第一行包含整数 ...

- linux 管理进程和计划任务

目录 一.进程原理 二.进程工作过程 三.进程类型 四.管理进程 五.前后台调度 六.定时任务 七.管理定时任务 一.进程原理 进程:指正在运行的程序称之为进程 程序:指的是没有运行的代码 线程:真正 ...

- RabbitMQ系列-概念及安装

1. 消息队列 消息队列是指利用队列这种数据结构进行消息发送.缓存.接收,使得进程间能相互通信,是点对点的通信 而消息代理是对消息队列的扩展,支持对消息的路由,是发布-订阅模式的通信,消息的发送者并不 ...

- < Python全景系列-8 > Python超薄感知,超强保护:异常处理的绝佳实践

欢迎来到我们的系列博客<Python全景系列>!在这个系列中,我们将带领你从Python的基础知识开始,一步步深入到高级话题,帮助你掌握这门强大而灵活的编程语法.无论你是编程新手,还是有一 ...

- 【一步步开发AI运动小程序】十、姿态动作相似度比较

随着人工智能技术的不断发展,阿里体育等IT大厂,推出的"乐动力"."天天跳绳"AI运动APP,让云上运动会.线上运动会.健身打卡.AI体育指导等概念空前火热.那 ...