用Keras搭建神经网络 简单模版(五)——RNN LSTM Regressor 循环神经网络

# -*- coding: utf-8 -*-

import numpy as np

np.random.seed(1337)

import matplotlib.pyplot as plt

from keras.models import Sequential

from keras.layers import LSTM,TimeDistributed,Dense

from keras.optimizers import Adam BATCH_START = 0

TIME_STEPS = 20

BATCH_SIZE = 50

INPUT_SIZE = 1

OUTPUT_SIZE = 1

CELL_SIZE = 20

LR = 0.006 def get_batch():

global BATCH_START,TIME_STEPS

# xs shape(50,20,)

#xs=np.arange(0,0+20*50).reshape(50,20)

xs = np.arange(BATCH_START,BATCH_START+TIME_STEPS*BATCH_SIZE).reshape((BATCH_SIZE,TIME_STEPS)) / (10*np.pi)

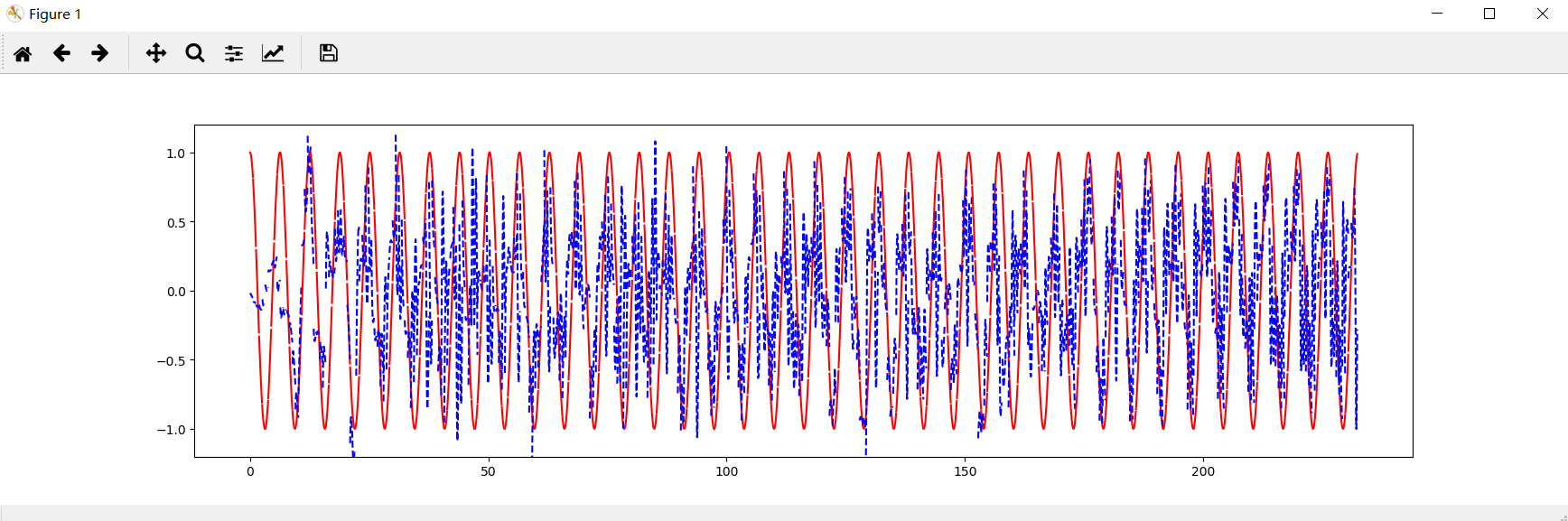

seq = np.sin(xs)

res = np.cos(xs)

BATCH_START += TIME_STEPS

#plt.plot(xs[0,:],res[0,:],'r',xs[0,:],seq[0,:],'b--')

#plt.show()

return [seq[:,:,np.newaxis], res[:,:,np.newaxis],xs] #get_batch()

#exit() model = Sequential() model.add(LSTM(output_dim=CELL_SIZE,

return_sequences=True, # 每一个时间点都输出一个output

batch_input_shape=(BATCH_SIZE,TIME_STEPS,INPUT_SIZE),

stateful = True,# batch和batch之间是否有联系

# 前一个batch的最后一步和后一个batch的第一步是有联系的

)) model.add(TimeDistributed(Dense(OUTPUT_SIZE))) # dense对每一个output连接,对每一个时间点都要计算 adam = Adam(LR)

model.compile(optimizer = adam,

loss = 'mse',) print('Training ------------')

for step in range(501):

# data shape = (batch_num,steps,inputs/output)

X_batch, Y_batch, xs = get_batch()

cost = model.train_on_batch(X_batch, Y_batch)

pred = model.predict(X_batch,BATCH_SIZE)

plt.plot(xs[0,:], Y_batch[0].flatten(),'r',xs[0,:],pred.flatten()[:TIME_STEPS],'b--')

plt.ylim((-1.2,1.2))

plt.draw()

plt.pause(0.5)

if step % 10 == 0:

print('train cost',cost)

用Keras搭建神经网络 简单模版(五)——RNN LSTM Regressor 循环神经网络的更多相关文章

- 用Keras搭建神经网络 简单模版(三)—— CNN 卷积神经网络(手写数字图片识别)

# -*- coding: utf-8 -*- import numpy as np np.random.seed(1337) #for reproducibility再现性 from keras.d ...

- 用Keras搭建神经网络 简单模版(一)——Regressor 回归

首先需要下载Keras,可以看到我用的是TensorFlow 的backend 自己构建虚拟数据,x是-1到1之间的数,y为0.5*x+2,可视化出来 # -*- coding: utf-8 -*- ...

- 用Keras搭建神经网络 简单模版(六)——Autoencoder 自编码

import numpy as np np.random.seed(1337) from keras.datasets import mnist from keras.models import Mo ...

- 用Keras搭建神经网络 简单模版(四)—— RNN Classifier 循环神经网络(手写数字图片识别)

# -*- coding: utf-8 -*- import numpy as np np.random.seed(1337) from keras.datasets import mnist fro ...

- 用Keras搭建神经网络 简单模版(二)——Classifier分类(手写数字识别)

# -*- coding: utf-8 -*- import numpy as np np.random.seed(1337) #for reproducibility再现性 from keras.d ...

- TensorFlow系列专题(七):一文综述RNN循环神经网络

欢迎大家关注我们的网站和系列教程:http://panchuang.net/ ,学习更多的机器学习.深度学习的知识! 目录: 前言 RNN知识结构 简单循环神经网络 RNN的基本结构 RNN的运算过程 ...

- keras搭建密集连接网络/卷积网络/循环网络

输入模式与网络架构间的对应关系: 向量数据:密集连接网络(Dense层) 图像数据:二维卷积神经网络 声音数据(比如波形):一维卷积神经网络(首选)或循环神经网络 文本数据:一维卷积神经网络(首选)或 ...

- 大话循环神经网络(RNN)

在上一篇文章中,介绍了 卷积神经网络(CNN)的算法原理,CNN在图像识别中有着强大.广泛的应用,但有一些场景用CNN却无法得到有效地解决,例如: 语音识别,要按顺序处理每一帧的声音信息,有些结果 ...

- RNN循环神经网络学习——概述

循环神经网络(Recurrent Neural NetWork,RNN)是一种将节点定向连接成环的人工神经网络,其内部状态可以展示动态时序行为. 循环神经网络的主要用途是处理和预测序列数据.循环神经网 ...

随机推荐

- mongodb索引 多健索引

多健索引与单键索引创建形式相同,区别在于字段的值,单键索引,顾名思义,他的值为一个单一的值,例如字符串,数字或者日期,而多健索引,他的值具有多个记录,例如一个数组,两者建立方式类似 增加一条数组记录 ...

- 第95题:不同的二叉搜素树II

一. 问题描述 给定一个整数 n,生成所有由 1 ... n 为节点所组成的二叉搜索树. 示例: 输入: 3 输出: [ [1,null,3,2], [3,2,null,1], [3,1,null,n ...

- dpkg: error processing package XXX (--configure) 解决方法 (ubuntu右上角红色警告)

在 Ubuntu 执行 sudo apt-get upgrade 时,出现了如下的报错: Setting up bluez (4.101-0ubuntu13.1) ... reload: Job is ...

- groovy基本语法--JSON

1.groovy提供了对JSON解析的方法 ①JsonSlurper JsonSlurper是一个将JSON文本或阅读器内容解析为Groovy数据的类结构,例如map,列表和原始类型, ...

- 富文本编辑器粘贴word

很多时候我们用一些管理系统的时候,发布新闻.公告等文字类信息时,希望能很快的将word里面的内容直接粘贴到富文本编辑器里面,然后发布出来.减少排版复杂的工作量. 下面是借用百度doc 来快速实现这个w ...

- js快速将字符串数组转化为数字数组(互换)

1.数字数组转化为字符串数组 var arr = [1, 2, 3, 4, 5, 6, 7, 8, 9]; arr.map(String); //结果: ['1', '2', '3', '4', '5 ...

- C++问题--fread文件读不完整问题解决

今天突然遇到一个问题,用fwrite/fread读写文件,发现当fread读取文件时只能读一半, 即使用foef()查看是否读到文件结尾,也是显示文件已经读取到文件末尾,查看文件的返回值发现文件只读取 ...

- 2019CCPC-江西省赛C题 HDU6569 GCD预处理+二分

Trap Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 262144/262144 K (Java/Others)Total Subm ...

- c实现队列

使用链表实现队列的入队和出队 #include <iostream> #include <stdio.h> #include <string.h> #include ...

- 第十七节:Runnable创建线程,Thread创建线程,唤醒线程和计数器多线程,线程同步与等待

Runnable创建线程 public class RunnableDemo implements Runnable{ @Override public void run(){ int i = 1; ...