获取kafka最新offset-java

之前笔者曾经写过通过scala的方式获取kafka最新的offset

但是大多数的情况我们需要使用java的方式进行获取最新offset

scala的方式可以参考: http://www.cnblogs.com/weishao-lsv/p/8159396.html

以下是通过java代码获取kafka最新offset

GetOffsetShellWrap

public class GetOffsetShellWrap {

private static Logger log = LoggerFactory.getLogger(GetOffsetShellWrap.class);

private String topic;

private int port;

private String host;

private int time;

public GetOffsetShellWrap(String topic,int port,String host,int time) {

this.topic = topic;

this.port = port;

this.host = host;

this.time = time;

}

public Map<String, String> getEveryPartitionMaxOffset() {

//1.获取topic所有分区 以及每个分区的元数据 => 返回 Map<分区id,分区元数据>

TreeMap<Integer, PartitionMetadata> partitionIdAndMeta = findTopicEveryPartition();

Map<String, String> map = new HashMap<String, String>();

for (Entry<Integer, PartitionMetadata> entry : partitionIdAndMeta.entrySet()) {

int leaderPartitionId = entry.getKey();

//2.根据每个分区的元数据信息 ==> 获取leader分区的主机

String leadBroker = entry.getValue().leader().host();

String clientName = "Client_" + topic + "_" + leaderPartitionId;

SimpleConsumer consumer = new SimpleConsumer(leadBroker, port,100000, 64 * 1024, clientName);

//3.从leader主机获取分区的offset

long readOffset = getLastOffset(consumer, topic, leaderPartitionId, clientName);

map.put(String.valueOf(leaderPartitionId), String.valueOf(readOffset));

if (consumer != null)

consumer.close();

}

return map;

}

private TreeMap<Integer, PartitionMetadata> findTopicEveryPartition(){

TreeMap<Integer, PartitionMetadata> map = new TreeMap<Integer, PartitionMetadata>();

SimpleConsumer consumer = null;

try {

consumer = new SimpleConsumer(host, port, 100000, 64 * 1024,"leaderLookup" + new Date().getTime());

List<String> topics = Collections.singletonList(topic);

TopicMetadataRequest req = new TopicMetadataRequest(topics);

kafka.javaapi.TopicMetadataResponse resp = consumer.send(req);

List<TopicMetadata> metaData = resp.topicsMetadata();

if(metaData!=null && !metaData.isEmpty()){

TopicMetadata item = metaData.get(0);

for (PartitionMetadata part : item.partitionsMetadata()) {

map.put(part.partitionId(), part);

}

}

} catch (Exception e) {

e.printStackTrace();

} finally {

if (consumer != null)

consumer.close();

}

return map;

}

private long getLastOffset(SimpleConsumer consumer, String topic,int leaderPartitionId, String clientName) {

TopicAndPartition topicAndPartition = new TopicAndPartition(topic,leaderPartitionId);

Map<TopicAndPartition, PartitionOffsetRequestInfo> requestInfo = new HashMap<TopicAndPartition, PartitionOffsetRequestInfo>();

requestInfo.put(topicAndPartition, new PartitionOffsetRequestInfo(time, 1));

kafka.javaapi.OffsetRequest request = new kafka.javaapi.OffsetRequest(requestInfo, kafka.api.OffsetRequest.CurrentVersion(),clientName);

OffsetResponse response = consumer.getOffsetsBefore(request);

if (response.hasError()) {

log.error("Error fetching data Offset Data the Broker. Reason: "+ response.errorCode(topic, leaderPartitionId));

return 0;

}

long[] offsets = response.offsets(topic, leaderPartitionId);

return offsets[0];

}

}

GetOffsetShellWrapJavaTest

public class GetOffsetShellWrapJavaTest {

public static void main(String[] args) {

int port = 9092;

String topic = "2017-11-6-test";

int time = -1;

GetOffsetShellWrap offsetSearch = new GetOffsetShellWrap(topic,port,"hadoop-01",time);

Map<String, String> map = offsetSearch.getEveryPartitionMaxOffset();

for (String key : map.keySet()) {

System.out.println(key+"---"+map.get(key));

}

}

}

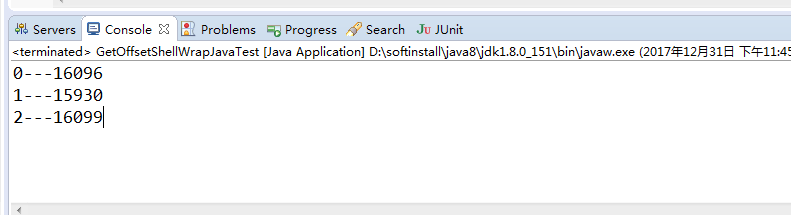

结果输出:

0---16096 1---15930 2---16099

获取kafka最新offset-java的更多相关文章

- 获取kafka最新offset-scala

无论是在spark streaming消费kafka,或是监控kafka的数据时,我们经常会需要知道offset最新情况 kafka数据的topic基于分区,并且通过每个partition的主分区可以 ...

- sparkStreaming获取kafka数据(java版本)

环境 spark-2.2.0 kafka_2.11-0.10.0.1 jdk1.8 配置好jdk,创建项目并将kafka和spark的jar包添加到项目中,除此之外还需要添加spark-streami ...

- 工具篇-Spark-Streaming获取kafka数据的两种方式(转载)

转载自:https://blog.csdn.net/weixin_41615494/article/details/7952173 一.基于Receiver的方式 原理 Receiver从Kafka中 ...

- Spark-Streaming获取kafka数据的两种方式:Receiver与Direct的方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 Receiver 使用Kafka的高层次Consumer API来 ...

- SparkStreaming获取kafka数据的两种方式:Receiver与Direct

简介: Spark-Streaming获取kafka数据的两种方式-Receiver与Direct的方式,可以简单理解成: Receiver方式是通过zookeeper来连接kafka队列, Dire ...

- spark-streaming获取kafka数据的两种方式

简单理解为:Receiver方式是通过zookeeper来连接kafka队列,Direct方式是直接连接到kafka的节点上获取数据 一.Receiver方式: 使用kafka的高层次Consumer ...

- 获取Kafka每个分区最新Offset的几种方法

目录 脚本方法 Java 程序 参考资料 脚本方法 ./bin/kafka-run-class.sh kafka.tools.GetOffsetShell --broker-list localhos ...

- 关于怎么获取kafka指定位置offset消息(转)

1.在kafka中如果不设置消费的信息的话,一个消息只能被一个group.id消费一次,而新加如的group.id则会被“消费管理”记录,并指定从当前记录的消息位置开始向后消费.如果有段时间消费者关闭 ...

- 如何获取流式应用程序中checkpoint的最新offset

对于流式应用程序,保证应用7*24小时的稳定运行,是非常必要的.因此对于计算引擎,要求必须能够适应与应用程序逻辑本身无关的问题(比如driver应用失败重启.网络问题.服务器问题.JVM崩溃等),具有 ...

随机推荐

- centos6.5搭建zabbix3.4

centos6.5搭建zabbix3.4 参考资料:https://blog.csdn.net/qq_36331560/article/details/80517282 客户端: https://bl ...

- 40 final、finally、finalize的区别

1.final 用于声明属性.方法.类.分别表示属性不可被改变,方法不可被覆盖,类不可被继承. (1)一个类不能既被声明为abstract的,又被声明为final的. (2)被声明为final的变量必 ...

- 正则获取a标签和a标签中的href地址

/(<\/?a.*?>)/ a标签 /<a\b.*?</a>/ 表式以"<a "(有空格) 开始 以"</a>" ...

- 51Nod 1413 权势二进制 (思维)

题意 : 一个十进制整数被叫做权势二进制, 当他的十进制表示的时候只由0或1组成.例如0, 1, 101, 110011都是权势二进制而2, 12, 900不是.当给定一个n (1<=n< ...

- mac 的 quickTime Player 设置播放速度

按住 option 点击 下一个视频的图标每次调整幅度为0.1,大于 1.9 声音会消失. 按住 option+J 调慢播放速度 option+L 调快播放速度 每次调整幅度为0.1

- (63)通信协议之一json

1.什么是JSON JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式.它基于JavaScript的一个子集. JSON采用完全独立于语言的文本格式,但是也使 ...

- HDU3465--Life is a Line(树状数组求逆序数,离散化)

Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 131072/65536 K (Java/Others) Total Submission(s ...

- 【Python】Python读取文件报错:UnicodeDecodeError: 'gbk' codec can't decode byte 0x99 in position 20: illegal multibyte sequence

环境描述 text.txt 今天的天气不错 是个皻的选择 读取文件的代码 #!/usr/bin/python #-*- coding:UTF-8 -*- f = open(r'D:\Python\Py ...

- JS中集合对象(Array、Map、Set)及类数组对象的使用与对比(转载)

在使用js编程的时候,常常会用到集合对象,集合对象其实是一种泛型,在js中没有明确的规定其内元素的类型,但在强类型语言譬如Java中泛型强制要求指定类型. ES6引入了iterable类型,Array ...

- OOM和SOF代码

OutOfMemoryError大数组,例如图片加载. public class MockOutOfMemoryError { public static void main(String[] arg ...