scrapy框架爬取国际庄2011-2022的天气情况

目标网站:http://www.tianqihoubao.com/lishi/

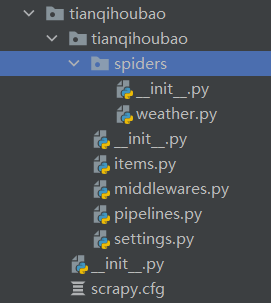

一.创建项目+初始化爬虫文件:

scrapy startpoject tianqihoubao

cd tianqihoubao

scrapy genspider weather www.tianqihoubao.com

二.配置settings.py

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Safari/537.36 Edg/99.0.1150.30'

ROBOTSTXT_OBEY = False #君子协议 注释掉或者改为false

ITEM_PIPELINES = {

'tianqihoubao.pipelines.TianqihoubaoPipeline': 300,

'tianqihoubao.pipelines.MySQLStoreCnblogsPipeline': 300

}

# 连接数据MySQL

# 数据库地址

MYSQL_HOST = 'localhost'

# 数据库用户名:

MYSQL_USER = 'root'

# 数据库密码

MYSQL_PASSWORD = '123456'

# 数据库端口

MYSQL_PORT = 3306

# 数据库名称

MYSQL_DBNAME = 'data'

# 数据库编码

MYSQL_CHARSET = 'utf8'

三.修改items.py

import scrapy class TianqihoubaoItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

riqi = scrapy.Field()

tianqi = scrapy.Field()

qiwen = scrapy.Field()

wind = scrapy.Field()

四.编写weather.py

scrapy.Request()教程:Scrapy爬虫入门教程十一 Request和Response(请求和响应)

import scrapy from tianqihoubao.items import TianqihoubaoItem class WeatherSpider(scrapy.Spider):

name = 'weather'

allowed_domains = ['www.tianqihoubao.com']

start_urls = ['http://www.tianqihoubao.com/lishi/shijiazhuang.html'] def parse(self, response):

#for path in self.start_urls:

data = response.xpath('//div[@id="content"]/table[@class="b"]/tr')

next_page = response.xpath('//div[@id="content"]/div[@class="box pcity"]/ul/li/a/@href').extract()

for i in data[1:]:

item = TianqihoubaoItem()

item['riqi'] = i.xpath('./td/a/text()').extract()[0].replace('\r\n', '').replace('\n', '').replace(' ', '').strip()

item['tianqi'] = i.xpath('./td/text()').extract()[2].replace('\r\n', '').replace('\n', '').replace(' ', '').strip()

item['qiwen'] = i.xpath('./td/text()').extract()[3].replace('\r\n', '').replace('\n', '').replace(' ', '').strip()

item['wind'] = i.xpath('./td/text()').extract()[4].replace('\r\n', '').replace('\n', '').replace(' ', '').strip()

#print(item['tianqi']) yield item print("下一页", next_page)

if next_page and len(next_page) > 5:

# 翻页

for i in next_page:

yield scrapy.Request(url='http://www.tianqihoubao.com'+i, callback=self.parse)

else:

print("没有下一页了" * 10)

print(data)

五.配置pipelines.py(一个保存为csv,一个保存到mysql上)

import copy

import csv

import time from pymysql import cursors

from twisted.enterprise import adbapi class TianqihoubaoPipeline(object):

# 保存为csv格式

def __init__(self):

# 打开文件,指定方式为写,利用第3个参数把csv写数据时产生的空行消除

self.f = open("weather.csv", "a", newline="", encoding="utf-8")

# 设置文件第一行的字段名,注意要跟spider传过来的字典key名称相同

self.fieldnames = ["riqi", "tianqi", "qiwen", "wind"]

# 指定文件的写入方式为csv字典写入,参数1为指定具体文件,参数2为指定字段名

self.writer = csv.DictWriter(self.f, fieldnames=self.fieldnames)

# 写入第一行字段名,因为只要写入一次,所以文件放在__init__里面

self.writer.writeheader() def process_item(self, item, spider):

# 写入spider传过来的具体数值

self.writer.writerow(item)

# 写入完返回

return item def close(self, spider):

self.f.close() class MySQLStoreCnblogsPipeline(object):

# 初始化函数

def __init__(self, db_pool):

self.db_pool = db_pool # 从settings配置文件中读取参数

@classmethod

def from_settings(cls, settings):

# 用一个db_params接收连接数据库的参数

db_params = dict(

host=settings['MYSQL_HOST'],

user=settings['MYSQL_USER'],

password=settings['MYSQL_PASSWORD'],

port=settings['MYSQL_PORT'],

database=settings['MYSQL_DBNAME'],

charset=settings['MYSQL_CHARSET'],

use_unicode=True,

# 设置游标类型

cursorclass=cursors.DictCursor

)

# 创建连接池

db_pool = adbapi.ConnectionPool('pymysql', **db_params) # 返回一个pipeline对象

return cls(db_pool) # 处理item函数

def process_item(self, item, spider):

# 对象拷贝,深拷贝 --- 这里是解决数据重复问题!!!

asynItem = copy.deepcopy(item) # 把要执行的sql放入连接池

query = self.db_pool.runInteraction(self.insert_into, asynItem) # 如果sql执行发送错误,自动回调addErrBack()函数

query.addErrback(self.handle_error, item, spider) # 返回Item

return item # 处理sql函数

def insert_into(self, cursor, item):

# 创建sql语句

sql = "INSERT INTO weather (riqi,tianqi,qiwen,wind) VALUES ('{}','{}','{}','{}')".format(

item['riqi'], item['tianqi'], item['qiwen'], item['wind'])

# 执行sql语句

cursor.execute(sql)

# 错误函数 def handle_error(self, failure, item, spider):

# #输出错误信息

print("failure", failure)

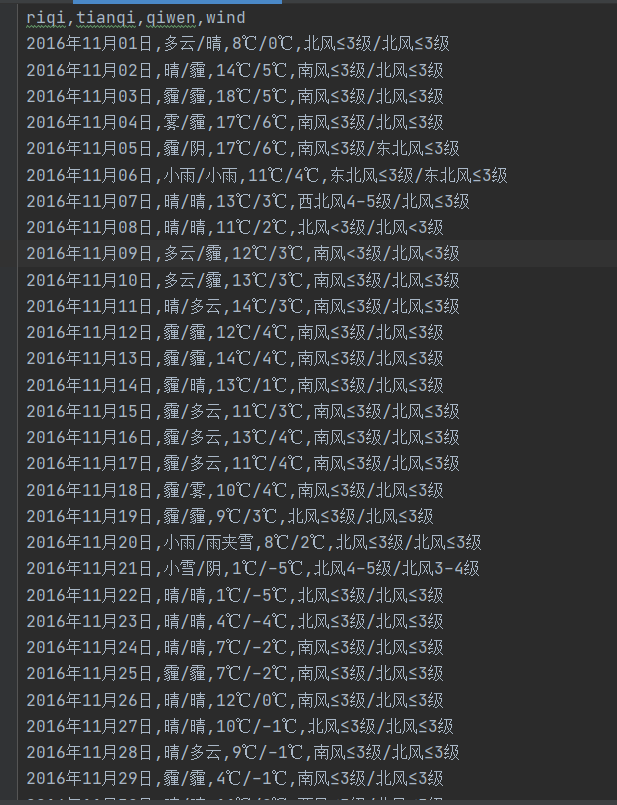

六.结果

这个在爬取的时候没有按时间顺序来,后续在搞一搞

scrapy框架爬取国际庄2011-2022的天气情况的更多相关文章

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

- scrapy框架爬取笔趣阁

笔趣阁是很好爬的网站了,这里简单爬取了全部小说链接和每本的全部章节链接,还想爬取章节内容在biquge.py里在加一个爬取循环,在pipelines.py添加保存函数即可 1 创建一个scrapy项目 ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- 使用scrapy框架爬取自己的博文(3)

既然如此,何不再抓一抓网页的文字内容呢? 谷歌浏览器有个审查元素的功能,就是按树的结构查看html的组织形式,如图: 这样已经比较明显了,博客的正文内容主要在div 的class = cnblogs_ ...

- 使用scrapy框架爬取自己的博文

scrapy框架是个比较简单易用基于python的爬虫框架,http://scrapy-chs.readthedocs.org/zh_CN/latest/ 这个是不错的中文文档 几个比较重要的部分: ...

- 基于python的scrapy框架爬取豆瓣电影及其可视化

1.Scrapy框架介绍 主要介绍,spiders,engine,scheduler,downloader,Item pipeline scrapy常见命令如下: 对应在scrapy文件中有,自己增加 ...

- scrapy框架爬取豆瓣读书(1)

1.scrapy框架 Scrapy,Python开发的一个快速.高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据.Scrapy用途广泛,可以用于数据挖掘.监测和自动化测试 ...

随机推荐

- 矩池云助力科研算力免费上"云",让 AI 教学简单起来

矩池云是一个专业的国内深度学习云平台,拥有着良好的深度学习云端训练体验,和高性价比的GPU集群资源.而且对同学们比较友好,会经常做一些大折扣的活动,最近双十一,全场所有的RTX 2070.Platin ...

- laravel 和 tp的区别

https://www.cnblogs.com/xiaoyantongxue/p/15442844.html laravel 数据库储存的时间字段 created_at updated_at ...

- PHP pdf转png windows版本

链接:https://pan.baidu.com/s/1Bli-2HkucRTYTeujkcsmjg&shfl=sharepset 提取码:2une 1.php_imagick扩展 (1)下载 ...

- CVE-2021-3129:Laravel远程代码漏洞复现分析

摘要:本文主要为大家带来CVE-2021-3129漏洞复现分析,为大家在日常工作中提供帮助. 本文分享自华为云社区<CVE-2021-3129 分析>,作者:Xuuuu . CVE-202 ...

- [Java编程思想] 第二章 一切都是对象

第二章 一切都是对象 2.1 用引用操纵对象 创建一个String引用: String s; 这里所创建的只是引用,并不是对象. 创建一个引用的同时便初始化: String s = &qu ...

- FatFs知识点总结[多篇转载]

一.实用简单的fatfs基础知识点总结: https://my.oschina.net/u/274829/blog/282135 二.深入点的FAT表解析: http://blog.chinaunix ...

- shellLab实验报告

一.预备知识 阅读课本CSAPP的第八章后完成本次实验,要求熟练掌握以下内容: 进程的概念.状态以及控制进程的几个函数(fork,waitpid,execve). 信号的概念,会编写正确安全的信号处理 ...

- luoguP6620 [省选联考 2020 A 卷] 组合数问题(斯特林数)

luoguP6620 [省选联考 2020 A 卷] 组合数问题(斯特林数) Luogu 题外话: LN切这题的人比切T1的多. 我都想到了组合意义乱搞也想到可能用斯特林数为啥还是没做出来... 我怕 ...

- KestrelServer详解[2]: 网络链接的创建

<注册监听终结点(Endpoint)>已经详细讲述了如何使用KestrelServer,现在我们来简单聊聊这种处理器的总体设计和实现原理.当KestrelServer启动的时候,注册的每个 ...

- Oracle入门基础(一)一一基本查询

SQL> --当前用户 SQL> show user SQL> --当前用户下的表 SQL> select * from tab; TNAME TABTYPE CLUSTERI ...