Pandas文本数据处理

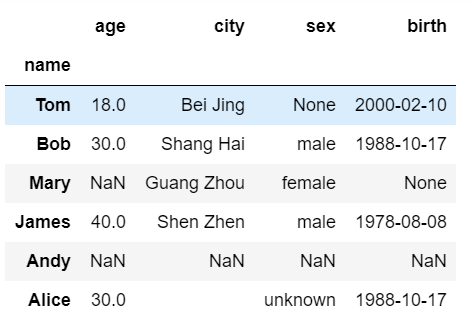

先初始化数据

import pandas as pd

import numpy as np

index = pd.Index(data=["Tom", "Bob", "Mary", "James", "Andy", "Alice"], name="name")

data = {

"age": [18, 30, np.nan, 40, np.nan, 30],

"city": ["Bei Jing", "Shang Hai", "Guang Zhou", "Shen Zhen", np.nan, " "],

"sex": [None, "male", "female", "male", np.nan, "unknown"],

"birth": ["2000-02-10", "1988-10-17", None, "1978-08-08", np.nan, "1988-10-17"]

}

user_info = pd.DataFrame(data=data, index=index)

user_info["birth"] = pd.to_datetime(user_info.birth)

user_info

为什么要用str属性

文本数据也就是我们常说的字符串,Pandas 为 Series 提供了 str 属性,通过它可以方便的对每个元素进行操作。在之前已经了解过,在对 Series 中每个元素处理时,我们可以使用 map 或 apply 方法。

# 将每个城市都转为小写:

user_info.city.map(lambda x: x.lower())

What?竟然出错了,错误原因是因为 float 类型的对象没有 lower 属性。这是因为缺失值 (np.nan)属于float 类型

这时候我们的 str 属性操作来了,来看看如何使用吧

# 将文本转为小写

user_info.city.str.lower()

# 统计每个字符串的长度

user_info.city.str.len()

替换和分割

替换操作

# 将空字符串替换成下划线:

user_info.city.str.replace(" ", "_")

# 使用正则表达式将所有开头为 S 的城市替换为空字符串:

user_info.city.str.replace("^S.*", " ")

分割操作

# 根据空字符串来分割某一列:

user_info.city.str.split(" ")

"""

name

Tom [Bei, Jing]

Bob [Shang, Hai]

Mary [Guang, Zhou]

James [Shen, Zhen]

Andy NaN

Alice [, ]

Name: city, dtype: object

""" #分割列表中的元素可以使用 get 或 [] 符号进行访问:

user_info.city.str.split(" ").str.get(0)

"""

name

Tom Bei

Bob Shang

Mary Guang

James Shen

Andy NaN

Alice

Name: city, dtype: object

""" user_info.city.str.split(" ").str[1]

"""

name

Tom Jing

Bob Hai

Mary Zhou

James Zhen

Andy NaN

Alice

Name: city, dtype: object

""" # 设置参数 expand=True 可以轻松扩展此项以返回 DataFrame

user_info.city.str.split(" ", expand=True)

"""

0 1

name

Tom Bei Jing

Bob Shang Hai

Mary Guang Zhou

James Shen Zhen

Andy NaN NaN

Alice

"""

提取子串

从一个长的字符串中提取出子串。

提取第一个匹配的子串

extract 只能够匹配出第一个子串,extract 方法接受一个正则表达式并至少包含一个捕获组,指定参数 expand=True 可以保证每次都返回 DataFrame。

\s+ :一个或多个空字符串

(\w+):分组捕获任意多个字符

(\w+)\s+:在一个或多个空字符串前,分组捕获任意多个字符

# 匹配空字符串前面的所有的字母

user_info.city.str.extract("(\w+)\s+", expand=True)

"""

0

name

Tom Bei

Bob Shang

Mary Guang

James Shen

Andy NaN

Alice NaN

""" # 如果使用多个组提取正则表达式会返回一个 DataFrame,每个组只有一列。

# 匹配出空字符串前面和后面的所有字母

user_info.city.str.extract("(\w+)\s+(\w+)", expand=True)

"""

0 1

name

Tom Bei Jing

Bob Shang Hai

Mary Guang Zhou

James Shen Zhen

Andy NaN NaN

Alice NaN NaN

"""

匹配所有子串

extract 只能够匹配出第一个子串,使用 extractall 可以匹配出所有的子串。

# 将所有组的空白字符串前面的字母都匹配出来

user_info.city.str.extractall("(\w+)\s+")

"""

0

name match

Tom 0 Bei

Bob 0 Shang

Mary 0 Guang

James 0 Shen

"""

测试是否包含子串

使用 contains 来测试是否包含子串 --> 布尔值

# 测试城市是否包含子串 'Zh':

user_info.city.str.contains("Zh")

# 测试是否是以字母 'S' 开头:

user_info.city.str.contains("^S")

生成哑变量

这是一个神奇的功能,通过 get_dummies 方法可以将字符串转为哑变量, sep 参数是指定哑变量之间的分隔符

user_info.city.str.get_dummies(sep=" ")

方法摘要

| 方法 | 描述 |

| cat() | 连接字符串 |

| split() | 在分隔符上分割字符串 |

| rsplit() | 从字符串末尾开始分隔字符串 |

| get() | 索引到每个元素(检索第i个元素) |

| join() | 使用分隔符在系列的每个元素中加入字符串 |

| get_dummies() | 在分隔符上分割字符串,返回虚拟变量的DataFrame |

| contains() | 如果每个字符串都包含pattern / regex,则返回布尔数组 |

| replace() | 用其他字符串替换pattern / regex的出现 |

| repeat() ) | 重复值(s.str.repeat(3)等同于x * 3 t2 ) |

| pad() | 将空格添加到字符串的左侧,右侧或两侧 |

| center() | 相当于str.center |

| ljust() | 相当于str.ljust |

| rjust() | 相当于str.rjust |

| zfill() | 等同于str.zfill |

| wrap() | 将长长的字符串拆分为长度小于给定宽度的行 |

| slice() | 切分Series中的每个字符串 |

| slice_replace() | 用传递的值替换每个字符串中的切片 |

| count() | 计数模式的发生 |

| startswith() | 相当于每个元素的str.startswith(pat) |

| endswith() | 相当于每个元素的str.endswith(pat) |

| findall() | 计算每个字符串的所有模式/正则表达式的列表 |

| match() | 在每个元素上调用re.match,返回匹配的组作为列表 |

| extract() | 在每个元素上调用re.search,为每个元素返回一行DataFrame,为每个正则表达式捕获组返回一列 |

| extractall() | 在每个元素上调用re.findall,为每个匹配返回一行DataFrame,为每个正则表达式捕获组返回一列 |

| len() | 计算字符串长度 |

| normalize() | 返回Unicode标准格式。相当于unicodedata.normalize |

Pandas文本数据处理的更多相关文章

- Pandas缺失数据处理

Pandas缺失数据处理 Pandas用np.nan代表缺失数据 reindex() 可以修改 索引,会返回一个数据的副本: df1 = df.reindex(index=dates[0:4], co ...

- pandas | 使用pandas进行数据处理——DataFrame篇

本文始发于个人公众号:TechFlow,原创不易,求个关注 今天是pandas数据处理专题的第二篇文章,我们一起来聊聊pandas当中最重要的数据结构--DataFrame. 上一篇文章当中我们介绍了 ...

- Pandas系列(四)-文本数据处理

内容目录 1. 为什么要用str属性 2. 替换和分割 3. 提取子串 3.1 提取第一个匹配的子串 3.2 匹配所有子串 3.3 测试是否包含子串 3.4 生成哑变量 3.5 方法摘要 一.为什么要 ...

- pynlpir + pandas 文本分析

pynlpir是中科院发布的一个分词系统,pandas(Python Data Analysis Library) 是python中一个常用的用来进行数据分析和统计的库,利用这两个库能够对中文文本数据 ...

- Pandas日期数据处理:如何按日期筛选、显示及统计数据

前言 pandas有着强大的日期数据处理功能,本期我们来了解下pandas处理日期数据的一些基本功能,主要包括以下三个方面: 按日期筛选数据 按日期显示数据 按日期统计数据 运行环境为 windows ...

- Pandas文本操作之读取操作

读写文本格式的数据 pandas中的解析函数 函数 说明 read_csv 从文件.url.文件型对象中加载带分隔符的数据,默认分隔符为逗号 read_table 从文件.url.文件型对象中加载带分 ...

- 5,pandas高级数据处理

1.删除重复元素 使用duplicated()函数检测重复的行,返回元素为布尔类型的Series对象,每个元素对应一行,如果该行不是第一次出现,则元素为True - keep参数:指定保留哪一重复的行 ...

- pandas之数据处理

首先,数据加载 pandas提供了一些用于将表格型数据读取为DataFrame对象的函数,期中read_csv和read_table这两个使用最多. 1.删除重复元素 使用duplicated()函数 ...

- Python——Pandas 时间序列数据处理

介绍 Pandas 是非常著名的开源数据处理库,我们可以通过它完成对数据集进行快速读取.转换.过滤.分析等一系列操作.同样,Pandas 已经被证明为是非常强大的用于处理时间序列数据的工具.本节将介绍 ...

随机推荐

- 文件操作——RandomAccessFile

文件操作——RandomAccessFile 构建RandomAccessFileJava提供了一个可以对文件随机访问的操作,访问包括读和写操作.该类名为RandomAccessFile.该类的读 ...

- 品Spring:关于@Scheduled定时任务的思考与探索,结果尴尬了

非Spring风格的代码与Spring的结合 现在的开发都是基于Spring的,所有的依赖都有Spring管理,这没有问题. 但是要突然写一些非Spring风格的代码时,可能会很不习惯,如果还要和Sp ...

- css3:bacground-size

个人博客: https://chenjiahao.xyz CSS3之背景尺寸Background-size是CSS3中新加的一个有关背景的属性,这个属性是改变背景尺寸的通过各种不同是属性值改变背景尺寸 ...

- 服务器时间误差导致的google sign-in后台验证错误(远程调试java程序)

https://developers.google.com/identity/sign-in/web/backend-auth import com.google.api.client.googlea ...

- mpvue 页面预加载,新增preLoad生命周期

存在的必要性:mpvue开发微信小程序,在页面跳转到新页面的过程中会有200ms左右的延迟,这个200ms如果用来请求新页面的接口,那么跳转到新页面或许已经渲染好了页面. 就是两种方式: 1.新页面跳 ...

- apply、bind、call方法的作用与区别

js中call.apply.bind方法的作用和区别 1. call方法 作用:专门用于修改方法内部的 this 指向 格式:xxx.call( 对象名, 参数1, 参数2 , ...);.即:将 x ...

- django html母版

08.12自我总结 django母版 一.母版写的格式 在需要导入的地方写 {% block 名字定义 %} {% endblock %} 二.导入模板 {% extends 'FUCK.html' ...

- Ubunut18 安装docker环境&&AWD攻防平台部署

docker:有两个版本:docker-ce(社区版)和docker-ee(企业版). 参考官网地址:https://docs.docker.com/engine/installation/linux ...

- Mobius 反演与杜教筛

积性函数 积性函数 指对于所有互质的整数 aaa 和 bbb 有性质 f(ab)=f(a)f(b)f(ab)=f(a)f(b)f(ab)=f(a)f(b) 的数论函数. 特别地,若所有的整数 aaa ...

- [网络流 24 题] luoguP2763 试题库问题

[返回网络流 24 题索引] 题目描述 假设一个试题库中有 nnn 道试题.每道试题都标明了所属类别.同一道题可能有多个类别属性.现要从题库中抽取 mmm 道题组成试卷.并要求试卷包含指定类型的试题. ...