【爬虫案例】用Python爬取百度热搜榜数据!

一、爬取目标

您好,我是@马哥python说,一名10年程序猿。

本次爬取的目标是:百度热搜榜

分别爬取每条热搜的:

热搜标题、热搜排名、热搜指数、描述、链接地址。

下面,对页面进行分析。

经过分析,此页面有XHR链接,可以针对接口进行爬取。

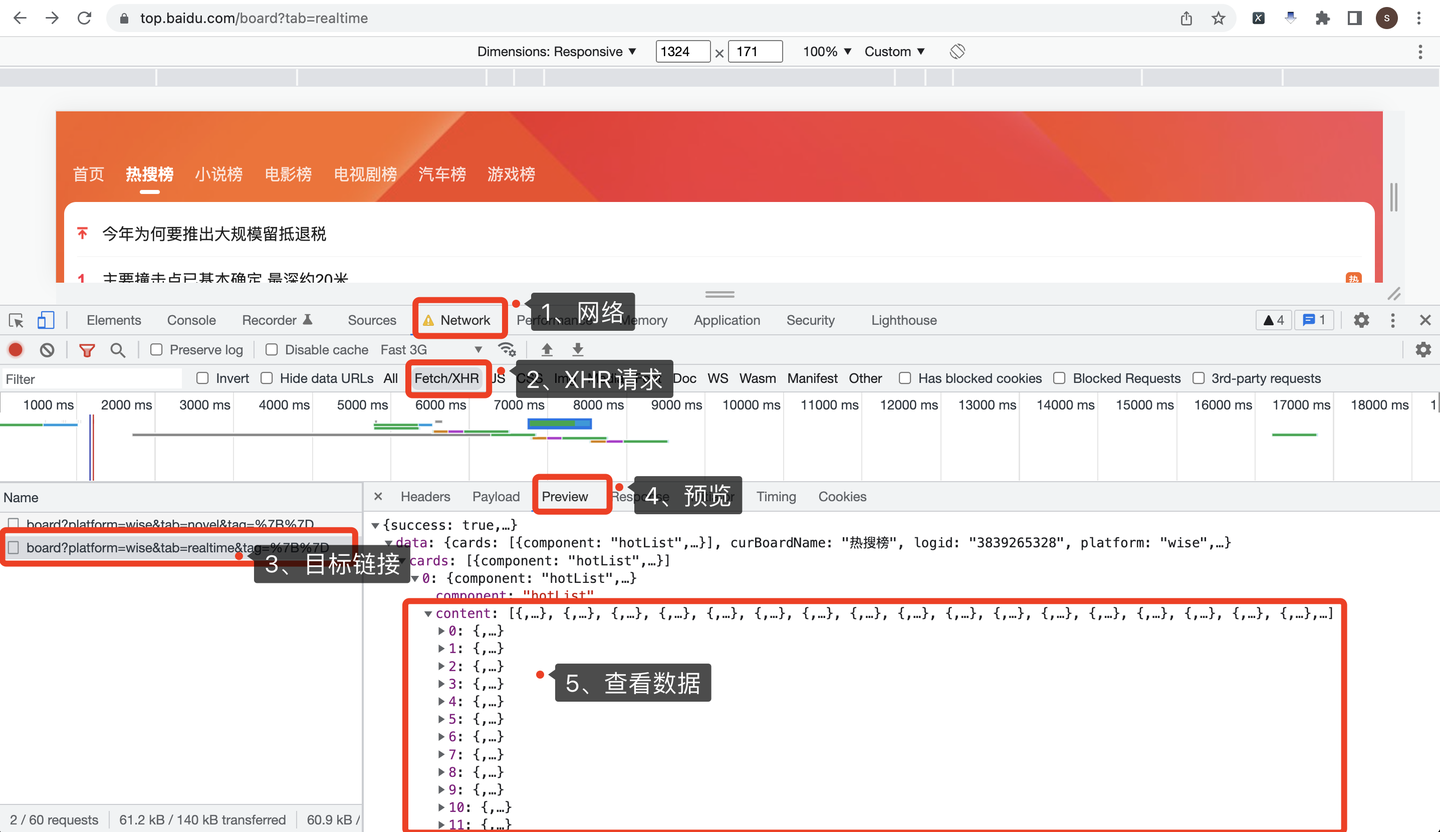

打开Chrome浏览器,按F12进入开发者模式,依次点击:

- 点击Network,选择网络

- 点击XHR,选择XHR请求

- 选择目标链接地址

- 击Preview,选择预览

- 查看返回数据

操作过程,如下图所示:

二、编写爬虫代码

首先,导入需要用到的库:

import requests # 发送请求

import pandas as pd # 存入excel数据

定义一个百度热搜榜接口地址:

# 百度热搜榜地址

url = 'https://top.baidu.com/api/board?platform=wise&tab=realtime'

构造一个请求头,伪装爬虫:

# 构造请求头

header = {

'User-Agent': 'Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Mobile Safari/537.36',

'Host': 'top.baidu.com',

'Accept': 'application/json, text/plain, */*',

'Accept-Language': 'zh-CN,zh;q=0.9,en-US;q=0.8,en;q=0.7',

'Accept-Encoding': 'gzip, deflate, br',

'Referer': 'https://top.baidu.com/board?tab=novel',

}

向百度页面发送requests请求:

# 发送请求

r = requests.get(url, header)

返回的数据是json格式的,直接用r.json()接收:

# 用json格式接收请求数据

json_data = r.json()

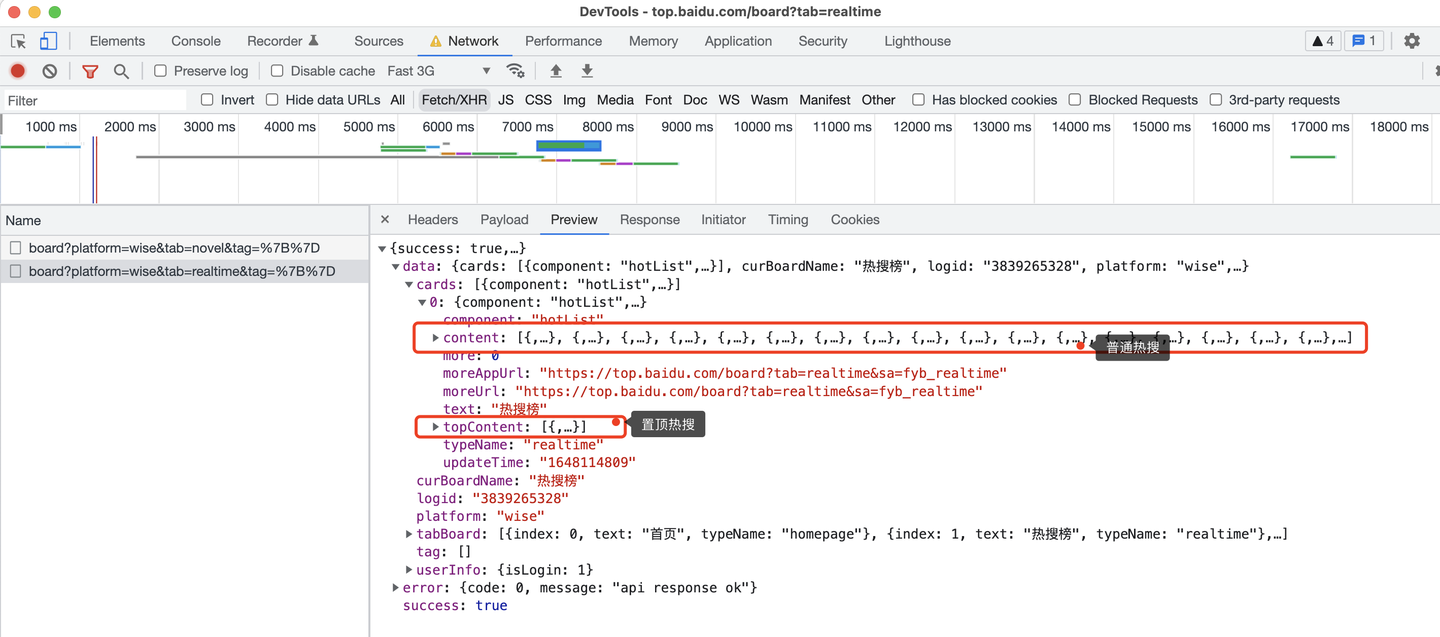

这里,需要注意的是,页面上有2种热搜:

百度热搜榜最上面一条是置顶热搜,下面从1到30是普通热搜,接口返回的数据也是区分开的:

所以,爬虫代码需要分开处理逻辑:

置顶热搜:

# 爬取置顶热搜

top_content_list = json_data['data']['cards'][0]['topContent']

普通热搜:

# 爬取普通热搜

content_list = json_data['data']['cards'][0]['content']

然后再分别进行json解析,对应的字段(标题、排名、热搜指数、描述、链接地址)。

最后,保存结果数据到excel即可。

df = pd.DataFrame( # 拼装爬取到的数据为DataFrame

{

'热搜标题': title_list,

'热搜排名': order_list,

'热搜指数': score_list,

'描述': desc_list,

'链接地址': url_list

}

)

df.to_excel('百度热搜榜.xlsx', index=False) # 保存结果数据

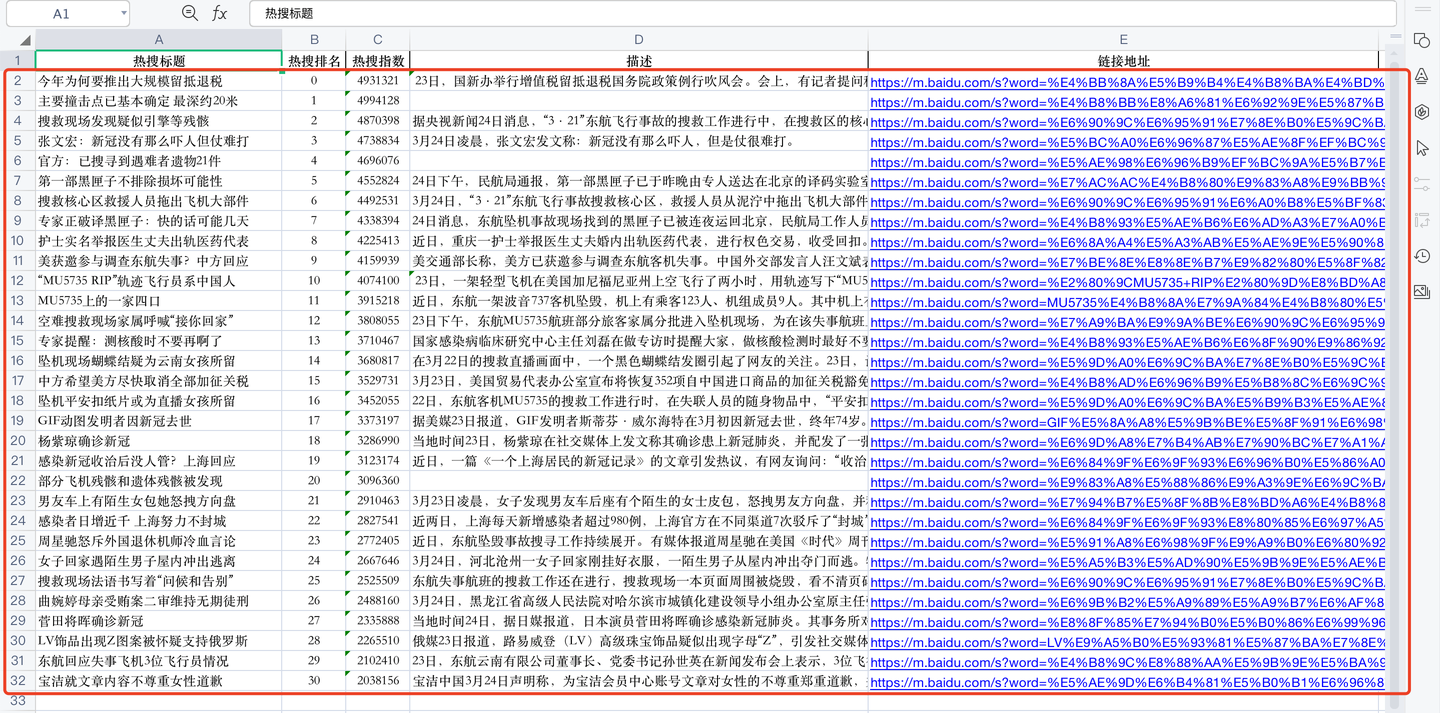

最后,查看一下爬取到的数据:

一共31条数据(1条置顶热搜+30条普通热搜)。

每条数据包含:热搜标题、热搜排名、热搜指数、描述、链接地址。

三、同步视频讲解

讲解视频:https://www.zhihu.com/zvideo/1490668062617161728

四、完整源码

get完整源码:【爬虫案例】用Python爬取百度热搜榜数据!

我是@马哥python说,持续分享python源码干货中!

【爬虫案例】用Python爬取百度热搜榜数据!的更多相关文章

- BeautifulSoup爬取微博热搜榜

获取url 设定请求头 requests发出get请求 实例化BeautifulSoup对象 BeautifulSoup提取数据 import requests 2 from bs4 import B ...

- Python爬取微博热搜以及链接

基本操作,不再详述 直接贴源码(根据当前时间创建文件): import requests from bs4 import BeautifulSoup import time def input_to_ ...

- nodejs实现定时爬取微博热搜

The summer is coming " 我知道,那些夏天,就像青春一样回不来. - 宋冬野 青春是回不来了,倒是要准备渡过在西安的第三个夏天了. 废话 我发现,自己对 coding 这 ...

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

- python网络爬虫第三弹(<爬取get请求的页面数据>)

一.urllib库 urllib是python自带的一个用于爬虫的库,其主要作用就是通过代码模拟浏览器发送请求,其常被用到的子模块在 python3中的为urllib.request 和 urllib ...

- Python开发简单爬虫(二)---爬取百度百科页面数据

一.开发爬虫的步骤 1.确定目标抓取策略: 打开目标页面,通过右键审查元素确定网页的url格式.数据格式.和网页编码形式. ①先看url的格式, F12观察一下链接的形式;② 再看目标文本信息的标签格 ...

- 爬虫实战(一) 用Python爬取百度百科

最近博主遇到这样一个需求:当用户输入一个词语时,返回这个词语的解释 我的第一个想法是做一个数据库,把常用的词语和词语的解释放到数据库里面,当用户查询时直接读取数据库结果 但是自己又没有心思做这样一个数 ...

- Python——爬取百度百科关键词1000个相关网页

Python简单爬虫——爬取百度百科关键词1000个相关网页——标题和简介 网站爬虫由浅入深:慢慢来 分析: 链接的URL分析: 数据格式: 爬虫基本架构模型: 本爬虫架构: 源代码: # codin ...

- 爬虫系列(1)-----python爬取猫眼电影top100榜

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天在整理代码时,整理了一下之前自己学习爬虫的一些代码,今天先上一个简单的例子,手把手教你入门Python爬虫,爬取 ...

随机推荐

- MySQL连接数超出最大值报错及修改

报错: create connection SQLException, url: jdbc:mysql://xx.xxx.x.xx:6306/hksk-cloud-mes?characterEncod ...

- 基于quartus的FPGA学习系列

基于quartus学习 1.学习目标 quartus是altera的FPGA设计软件,用起来的感觉要比xilinx快.这里可以使用其完成各种基本的设计(就是不使用非必须IP核),一些基础的实验都可以在 ...

- #启发式合并,LIS,平衡树#洛谷 4577 [FJOI2018]领导集团问题

题目 在一棵树上选择最多的点,使得存在祖先关系的点满足\(w_x\leq w_y\),其中\(x\)是\(y\)的祖先 分析 祖先链上要满足\(LIS\),考虑将子节点的LIS序列合并至节点\(x\) ...

- 王莉:将开发文档英文化和本地化,我们努力让OpenHarmony走向全球

编者按:在 OpenHarmony 生态发展过程中,涌现了大批优秀的代码贡献者,本专题旨在表彰贡献.分享经验,文中内容来自嘉宾访谈,不代表 OpenHarmony 工作委员会观点. 王莉 华为技术有限 ...

- 我为什么选择Wiki.js记笔记?

很长一段时间里,我都被困扰着,感觉陷入了笔记的泥潭,而积累的如此多的笔记也没有形成我自己的知识体系. 之前的记笔记方式 笔记的来源 微信公众号 技术博客 纸质书籍 官网文档 PDF 自己的零散想法 网 ...

- HarmonyOS课程体验官招募(第四期),寻找乐于分享,精益求精的伙伴

华为开发者联盟HarmonyOS课程体验官(第四期)活动,开始招募啦! 如果你精益求精.乐于分享:如果你愿意为学堂课程优化改进出谋划策,那就快来加入我们吧!学堂期待与你共同成长.一起进步! [活动 ...

- Thymeleaf SSTI模板注入分析

环境搭建 先搭建一个SpringMVC项目,参考这篇文章,或者参考我以前的spring内存马分析那篇文章 https://blog.csdn.net/weixin_65287123/article/d ...

- Spring6

0x00 环境配置 环境: IDEA >= 2022.1.4 JDK 17 Maven 3.8.6 Spring 6.0.0 JUnit 4.13.2 Log4j2 新建模块 spring001 ...

- .NET 9 预览版 3 发布

我们很高兴地宣布发布 .NET 9 预览版 3,其中包含 .NET 库.运行时和 SDK 的新功能和改进.此预览版带来了旨在提高性能.提高开发人员工作效率以及向 .NET 生态系统引入新功能的增强功能 ...

- mysql 必知必会整理—数据汇总与分组[七]

前言 简单整理一下数据汇总与分组 正文 我们经常需要汇总数据而不用把它们实际检索出来,为此MySQL提供了专门的函数.使用这些函数,MySQL查询可用于检索数据,以便分析和报表生成. 这种类型的检索例 ...