python爬虫之抓取小说(逆天邪神)

2022-03-06 23:05:11

申明:自我娱乐,对自我学习过程的总结。

正文:

环境:

系统:win10,

python版本:python3.10.2,

工具:pycharm。

项目目标:

实现对单本小说的更新判断,省去人工登录浏览器看小说的繁琐操作。

如果小说内容更新了,那么自动下载你没看过的小说内容到本地,并保存为txt格式。

对项目代码封装成可单独运行在win10上的exe文件。

最终效果:都已实现。可以判断小说更新了没;更新了就下载下来;通过调整小说的已看章节数(就是你上次浏览小说章节位置记录)可以达到直接保存整本小说。

项目实现流程:

1. 主程序

我这里只写了一个main.py,就一个主函数解决了。

# 这个是一个爬取小说的工具

# 内容针对逆天邪神

# 功能1:是判断小说是否更新,如果更新就下载下来

# 功能2:下载整本小说(单线程),一般都是自动下载最新更新的几章,单线程足够。——懒

import requests

import re

from bs4 import BeautifulSoup

import os

if __name__ == '__main__':

novel_url = "https://www.bige3.com/book/1030/" # 逆天邪神

return_value = is_update(novel_url) # 更新章节数

if return_value == 0:

print("小说尚未更新!")

else:

print("小说已更新" + str(return_value) +"章!")

print("正在下载已更新的小说......")

download_novel(return_value)

# os.system("pause") # 调试时注释掉,封装时打开,用于观察结果

2. 功能函数

2.1 功能函数is_update()

def is_update(url):

heards = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.102 Safari/537.36"

}

try:

resp = requests.get(url, headers=heards)

resp.raise_for_status() # 检查Response状态码,若不是200则产生HttpError异常

resp.encoding = 'utf-8'

except:

print("爬取失败")

resp = re.findall(r'<a href =.*?>(.*?)</a>', resp.text)

# print("请求返回的列表中的最后一章是:" + resp[-1])

with open("小说更新记录.txt", "r", encoding='utf-8') as f: # 打开文件

data = f.read() # 读取文件

# print("source_novel_data is:" + str(data))

if data == str(resp[-1]):

# print("===章节一致,小说尚未更新!")

return 0

else:

# print("!==小说更新啦,并将更新值加入到小说更新记录.txt")

data_num = re.findall(r'\d+', data) # list

data_num = ''.join(data_num) # str

resp_num = re.findall(r'\d+', resp[-1])

resp_num = ''.join(resp_num)

gap_num = int(resp_num)-int(data_num) # 更新章节数

with open("小说更新记录.txt", "w", encoding='utf-8') as f: # 打开文件

f.write(str(resp[-1])) # 读取文件

print("writing is ok!")

return gap_num

2.2 功能函数download_novel(return_value)

# 单线程方式

def download_novel(return_value):

if return_value >= 1:

for i in range(1, return_value+1, 1):

print(i)

with open("小说更新记录.txt", "r", encoding='utf-8') as f: # 打开文件

data = f.read() # 读取文件 str

data_num = re.findall(r'\d+', data) # list

data_num = ''.join(data_num) # str

download_num = int(data_num)+1-(i-1)

# print(download_num)

print(novel_url+str(download_num)+'.html')

resp = requests.get(novel_url+str(download_num)+'.html')

# print(resp.content)

soup = BeautifulSoup(resp.text, 'lxml')

soup.select('#chaptercontent')

mytxt = soup.text[soup.text.find('下一章'):soup.text.rfind('『点此报错')]

mytxt = mytxt[3:]

mytxt = mytxt.strip()

mytxt = mytxt.replace(' ', '\n')

novel_save_location = "./novel_downloads/逆天邪神第"+str(download_num-1)+"章.txt"

with open(novel_save_location, "w", encoding='utf-8') as f: # 打开文件

f.write(mytxt)

print("下载完毕!")

else:

print("invalid parameter!")

注意:

调试时要创建文件夹

novel_downloads,并标注为Exclusion,防止pycharm自动创建索引,使电脑卡顿。封装后的main.exe要保证它所在的路径下有两个东西:文件夹

novel_downloads和文件小说更新记录.txt。初始阶段保证文件

小说更新记录.txt里有个数字就行,随便啥(1 or 1935等)

全部代码:(直接能爬)

# 这个是一个爬取小说的工具

# 内容针对逆天邪神

# 功能1:是判断小说是否更新,如果更新就下载下来

# 功能2:下载整本小说(单线程),一般都是自动下载最新更新的几章,单线程足够。——懒

import requests

from lxml import etree

import re

from bs4 import BeautifulSoup

import os

def is_update(url):

heards = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.102 Safari/537.36"

}

try:

resp = requests.get(url, headers=heards)

resp.raise_for_status() # 检查Response状态码,若不是200则产生HttpError异常

resp.encoding = 'utf-8'

except:

print("爬取失败")

resp = re.findall(r'<a href =.*?>(.*?)</a>', resp.text)

# print("请求返回的列表中的最后一章是:" + resp[-1])

with open("小说更新记录.txt", "r", encoding='utf-8') as f: # 打开文件

data = f.read() # 读取文件

# print("source_novel_data is:" + str(data))

if data == str(resp[-1]):

# print("===章节一致,小说尚未更新!")

return 0

else:

# print("!==小说更新啦,并将更新值加入到小说更新记录.txt")

data_num = re.findall(r'\d+', data) # list

data_num = ''.join(data_num) # str

resp_num = re.findall(r'\d+', resp[-1])

resp_num = ''.join(resp_num)

gap_num = int(resp_num)-int(data_num) # 更新章节数

with open("小说更新记录.txt", "w", encoding='utf-8') as f: # 打开文件

f.write(str(resp[-1])) # 读取文件

print("writing is ok!")

return gap_num

# 单线程方式

def download_novel(return_value):

if return_value >= 1:

for i in range(1, return_value+1, 1):

print(i)

with open("小说更新记录.txt", "r", encoding='utf-8') as f: # 打开文件

data = f.read() # 读取文件 str

data_num = re.findall(r'\d+', data) # list

data_num = ''.join(data_num) # str

download_num = int(data_num)+1-(i-1)

# print(download_num)

print(novel_url+str(download_num)+'.html')

resp = requests.get(novel_url+str(download_num)+'.html')

# print(resp.content)

soup = BeautifulSoup(resp.text, 'lxml')

soup.select('#chaptercontent')

mytxt = soup.text[soup.text.find('下一章'):soup.text.rfind('『点此报错')]

mytxt = mytxt[3:]

mytxt = mytxt.strip()

mytxt = mytxt.replace(' ', '\n')

novel_save_location = "./novel_downloads/逆天邪神第"+str(download_num-1)+"章.txt"

with open(novel_save_location, "w", encoding='utf-8') as f: # 打开文件

f.write(mytxt)

print("下载完毕!")

else:

print("invalid parameter!")

if __name__ == '__main__':

novel_url = "https://www.bige3.com/book/1030/" # 逆天邪神

return_value = is_update(novel_url)

if return_value == 0:

print("小说尚未更新!")

else:

print("小说已更新" + str(return_value) +"章!")

print("正在下载已更新的小说......")

download_novel(return_value)

os.system("pause")

缺点:单线程,没有用到异步协程,也没有用线程池实现对小说下载章节数较多时的快速下载优势。之后有空再优化代码,并实现相应的功能。

实现效果:

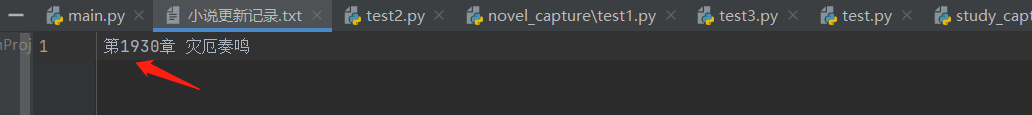

例如章节是目前是

最新章节为:1936章 灾厄奏鸣 ,我改个数字演示。

不改话,就没有新章节更新:

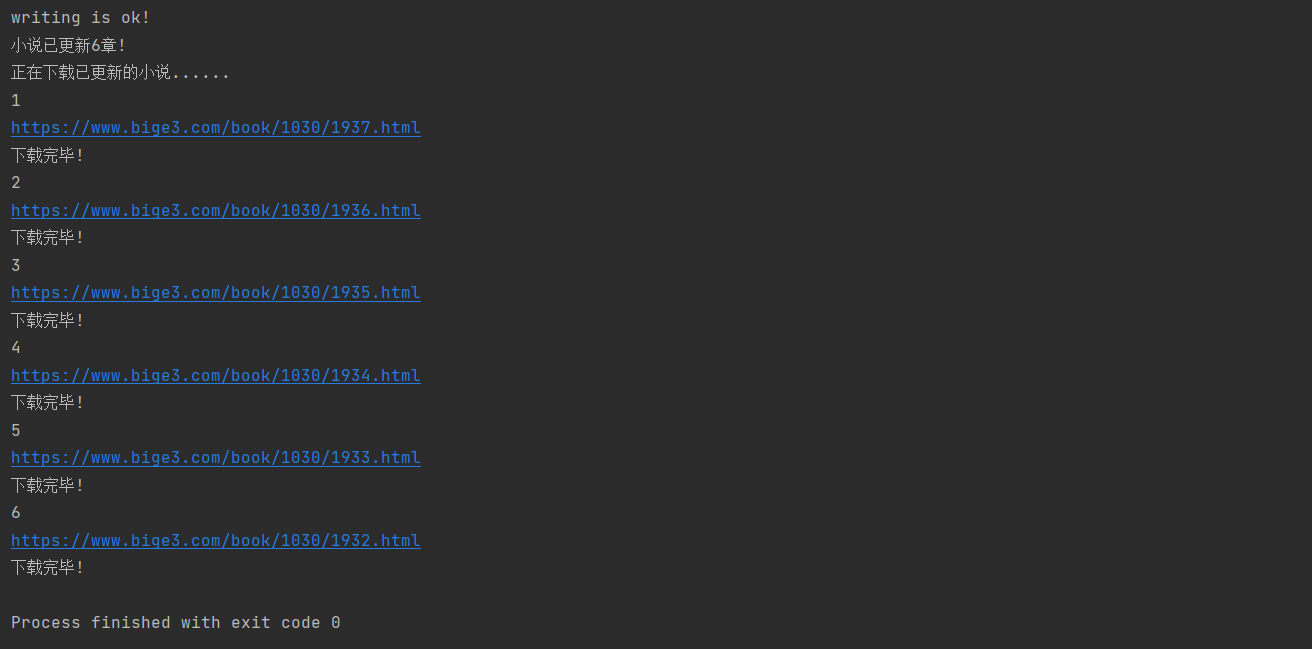

改后跑起来,应该是

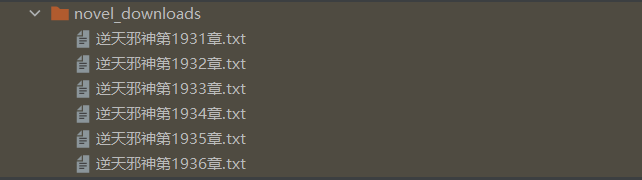

对应的文件夹里是:

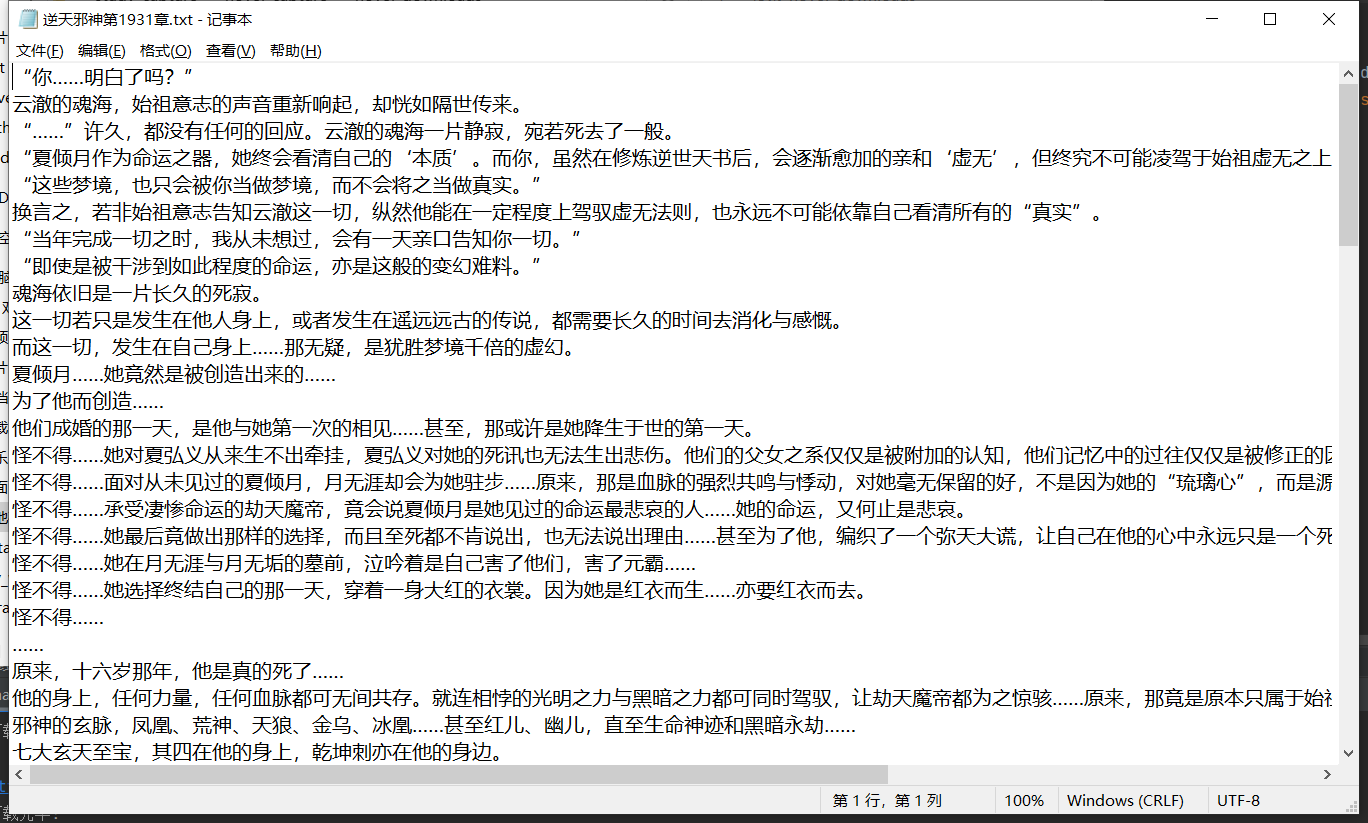

打开后内容是:

Over!!!!!

封装问题

步骤:

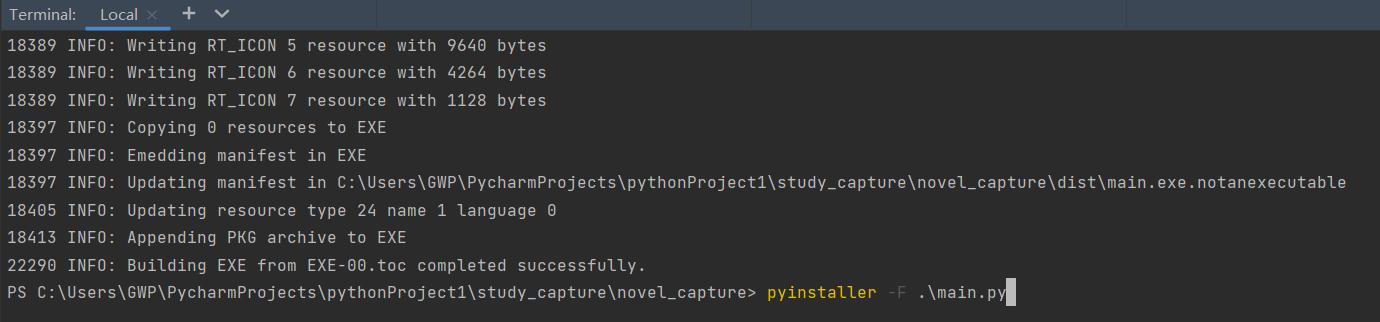

在pycharm项目路径下打开终端输入:

pip install pyinstallercd到项目的.py文件路径下

cd .\study_capture\novel_capture\执行:

pyinstaller -F .\main.py

结果是:

项目中用到的知识点:

这里面可以有些在优化程序时被我给去掉了,嘿嘿

请求网页数据

resp = requests.get(url, headers=heards)

python中list与string的转换

data_num = re.findall(r'\d+', data) # 正则出来的是list

data_num = ''.join(data_num) # str

小说章节数的确认

resp = re.findall(r'<a href =.*?>(.*?)</a>', resp.text)

TXT文本的读取

encoding='utf-8' 是有必要的,不然会报错。

with open("小说更新记录.txt", "r", encoding='utf-8') as f: # 打开文件

data = f.read() # 读取文件

TXT文本的回写

with open("小说更新记录.txt", "w", encoding='utf-8') as f: # 打开文件

f.write(str(resp[-1])) # 读取文件

BS4对HTML进行值的筛选

#表示识别标签

soup = BeautifulSoup(resp.text, 'lxml')

soup.select('#chaptercontent')

取列表元素最后一个

resp[-1]

将列表中的章节数字拿出

data_num = re.findall(r'\d+', data) # list

python特定位置的字符串截取

soup.text str型

find('下一章') 左边开始第一个索引

rfind('『点此报错') 右边开始第一个索引

mytxt = soup.text[soup.text.find('下一章'):soup.text.rfind('『点此报错')]

字符串的拼接:

novel_save_location = "./novel_downloads/逆天邪神第"+str(download_num-1)+"章.txt"

小说保存时:

1.里面有空白,直接用

mytxt = mytxt.strip()

时没有去掉,不知道啥原因。我记得听网课说是:去掉空格,空白,换行符,其他好像都去了,最后还剩小说之间一些空白。

解决方式:因为没有发现是啥符号(notepad++),于是之间将空白拿过来用(copy)。

mytxt=mytxt.replace(' ', '\n')

#目的是:在TXT文本中句子太长,于是我直接在每句话结束后换行。效果还行,与网站对比。

感谢观看!!!第一次写,好慢,好菜,回去写作业去了。呜呜呜

python爬虫之抓取小说(逆天邪神)的更多相关文章

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

- 【转】Python爬虫:抓取新浪新闻数据

案例一 抓取对象: 新浪国内新闻(http://news.sina.com.cn/china/),该列表中的标题名称.时间.链接. 完整代码: from bs4 import BeautifulSou ...

- Python爬虫:抓取新浪新闻数据

案例一 抓取对象: 新浪国内新闻(http://news.sina.com.cn/china/),该列表中的标题名称.时间.链接. 完整代码: from bs4 import BeautifulSou ...

- Python爬虫实现抓取腾讯视频所有电影【实战必学】

2019-06-27 23:51:51 阅读数 407 收藏 更多 分类专栏: python爬虫 前言本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问 ...

- 初次尝试python爬虫,爬取小说网站的小说。

本次是小阿鹏,第一次通过python爬虫去爬一个小说网站的小说. 下面直接上菜. 1.首先我需要导入相应的包,这里我采用了第三方模块的架包,requests.requests是python实现的简单易 ...

- Python爬虫,抓取淘宝商品评论内容!

作为一个资深吃货,网购各种零食是很频繁的,但是能否在浩瀚的商品库中找到合适的东西,就只能参考评论了!今天给大家分享用python做个抓取淘宝商品评论的小爬虫! 思路 我们就拿"德州扒鸡&qu ...

- python爬虫数据抓取方法汇总

概要:利用python进行web数据抓取方法和实现. 1.python进行网页数据抓取有两种方式:一种是直接依据url链接来拼接使用get方法得到内容,一种是构建post请求改变对应参数来获得web返 ...

- python爬虫批量抓取ip代理

使用爬虫抓取数据时,经常要用到多个ip代理,防止单个ip访问太过频繁被封禁.ip代理可以从这个网站获取:http://www.xicidaili.com/nn/.因此写一个python程序来获取ip代 ...

- Python爬虫:抓取手机APP的数据

摘要 大多数APP里面返回的是json格式数据,或者一堆加密过的数据 .这里以超级课程表APP为例,抓取超级课程表里用户发的话题. 1.抓取APP数据包 表单: 表单中包括了用户名和密码,当然都是加密 ...

随机推荐

- 只要一行代码,实现五种 CSS 经典布局

常用的页面布局,其实就那么几个.下面我会介绍5个经典布局,只要掌握了它们,就能应对绝大多数常规页面. 这几个布局都是自适应的,自动适配桌面设备和移动设备.代码实现很简单,核心代码只有一行,有很大的学习 ...

- LNMP架构搭建

目录 一:LNMP架构简介 1.Nginx与uwsgi 二:django框架+python 1.创建用户 2.安装依赖包 3.安装uwsgi和django 4.测试python 5.创建django项 ...

- 火山引擎MARS-APM Plus x 飞书 |降低线上OOM,提高App性能稳定性

通过使用火山引擎MARS-APM Plus的memory graph功能,飞书研发团队有效分析定位问题线上case多达30例,线上OOM率降低到了0.8‰,降幅达到60%.大幅提升了用户体验,为飞书的 ...

- 学习Java第17天

今天差不多搞清了Javaweb的基本学习路线及网站开发的基本流程,以前好像走了不少弯路,不过还好,明天开始学习Javaweb sql 总结了许多 新的学习方法,记笔记很重要,学多少忘多少. 练习也很重 ...

- 随机IP代理插件Scrapy-Proxies

安装: pip install scrapy_proxies github: https://github.com/aivarsk/scrapy-proxies scrapy爬虫配置文件setti ...

- 「CTSC2006」歌唱王国

概率生成函数\(g(x)=\sum_{i\geq 0}t_ix^i\),\(t_i\)表示结果为\(i\)的概率 令\(f(x)\)表示i位表示串结束时长度为i的概率,\(G(x)\)表示i位表示串长 ...

- Disruptor-高性能队列

简介 Disruptor是英国外汇交易公司LMAX开发的一个高性能队列,研发的初衷是解决内存队列的延迟问题.与Kafka.RabbitMQ用于服务间的消息队列不同,disruptor一般用于线程间消息 ...

- Embedded Python应用小结

转载请注明来源:https://www.cnblogs.com/hookjc/ (1)初始化Python脚本运行环境 Py_Initialize(); (2) 脚本的编译 bytecode = Py_ ...

- Eclipse 堆栈和内存大小设置(转载)

1, 设置Eclipse内存使用情况 修改eclipse根目录下的eclipse.ini文件 -vmargs //虚拟机设置 -Xms40m -Xmx256m -XX:PermSize=128M ...

- 【struts2】中method={1}详解

我们在使用struts2的时候,有时候为了简化struts2的配置项而采用通配符的方式,如下代码: <action name="ajaxregister!*" class=& ...