使用Scrapy爬取图片入库,并保存在本地

使用Scrapy爬取图片入库,并保存在本地

上

篇博客已经简单的介绍了爬取数据流程,现在让我们继续学习scrapy

目标:

爬取爱卡汽车标题,价格以及图片存入数据库,并存图到本地

好了不多说,让我们实现下效果

我们仍用scrapy框架来编写我们的项目:

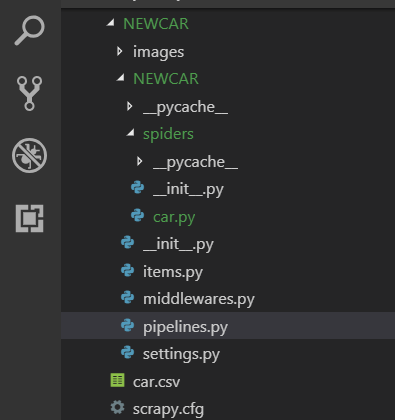

1.首先用命令创建一个爬虫项目(结合上篇博客),并到你的项目里如图所示

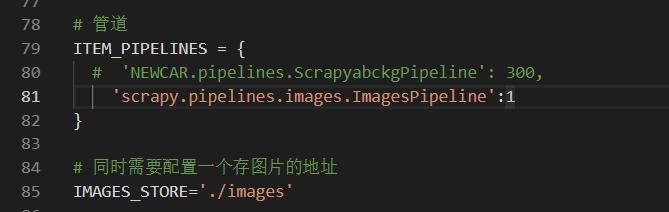

2.先到你的settings.py中配置 ,这里需要注意要 爬图(配置一个爬图管道 ImagesPipeline 为系统中下载图片的管道),

同时还有存图地址(在项目中创建一个为images的文件夹),

存图有多种方式,本人只是列举其中一种,大家可采取不同的方法

3.然后打开你的爬虫文件(即:car.py)开始编写你要爬取的数据,这里需要注意,要将start_urls[] 改为我们要爬取的Url 地址,然后根据xpath爬取图片

(这里代码得自己写,不要复制)

4.爬取的字段要跟 items.py里的一致

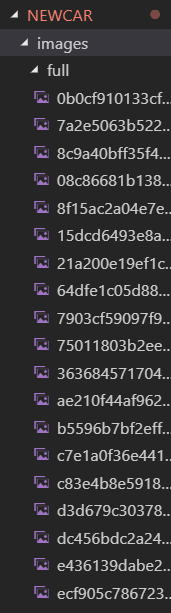

5.在命令行输入启动爬虫命令 scrapy crawl car 运行就能看到爬到图片存放在本地如下

6.最后入库,看你要入那个库,这里可入mysql和mongdb

mysql: 需提前创好库以及表,表中字段

import pymysql

# class NewcarPipeline(object):

# 连接mysql改为你的用户密码以及自己的库

# def __init__(self):

# self.conn = pymysql.connect(host='127.0.0.1',user='root', password='123456', db='zou')

# 建立cursor对象

# self.cursor = self.conn.cursor()

#

# 传值

# def process_item(self, item, spider):

# name = item['name']

# content = item['content']

# price = item['price']

# image = item['image_urls']

#

# insert into 你的表名,括号里面是你的字段要一一对应 # sql = "insert into zou(name,content,price) values(%s,%s,%s)"

# self.cursor.execute(sql, (name,content,price))

# self.conn.commit()

# return item

#关闭爬虫

# def close_spider(self, spider):

# self.conn.close()

mongdb: 不用提前建好库,表

from pymongo import MongoClient

# class NewcarPipeline(object):

# def open_spider(self, spider):

# # 连端口 ip

# self.con = MongoClient(host='127.0.0.1', port=27017)

# # 库

# db = self.con['p1']

# # 授权

# self.con = db.authenticate(name='wumeng', password='123456', source='admin')

# # 集合

# self.coll = db[spider.name] # def process_item(self, item, spider):

# # 添加数据

# self.coll.insert_one(dict(item))

# return item # def close_spider(self):

# # 关闭

# self.con.close()

7.运行 启动爬虫命令 scrapy crawl car 就可在库中看到数据.

至此爬虫项目做完了,这只是一个简单的爬虫,仅供参考,如遇其他方面的问题,可参考本人博客!尽情期待!

使用Scrapy爬取图片入库,并保存在本地的更多相关文章

- scrapy 爬取图片

scrapy 爬取图片 1.scrapy 有下载图片的自带接口,不用我们在去实现 setting.py设置 # 保存log信息的文件名 LOG_LEVEL = "INFO" # L ...

- python +requests 爬虫-爬取图片并进行下载到本地

因为写12306抢票脚本需要用到爬虫技术下载验证码并进行定位点击所以这章主要讲解,爬虫,从网页上爬取图片并进行下载到本地 爬虫实现方式: 1.首先选取你需要的抓取的URL:2.将这些URL放入待抓 ...

- python网络爬虫之使用scrapy爬取图片

在前面的章节中都介绍了scrapy如何爬取网页数据,今天介绍下如何爬取图片. 下载图片需要用到ImagesPipeline这个类,首先介绍下工作流程: 1 首先需要在一个爬虫中,获取到图片的url并存 ...

- python实现scrapy爬取图片到本地时的sha1摘要算法文件名

2017-03-29 Scrapy爬图片到本地应该会给图片自动生成sha1摘要算法文件名,我第一次用scrapy也不清楚太多,就在程序里自己写了一段实现这一功能的代码.需import hashlib ...

- 【Python】- scrapy 爬取图片保存到本地、且返回保存路径

https://blog.csdn.net/xueba8/article/details/81843534

- scrapy爬取图片并自定义图片名字

1 前言 Scrapy使用ImagesPipeline类中函数get_media_requests下载到图片后,默认的图片命名为图片下载链接的哈希值,例如:它的下载链接是http://img.iv ...

- python爬取网站视频保存到本地

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: Woo_home PS:如有需要Python学习资料的小伙伴可以加点 ...

- scrapy爬虫系列之三--爬取图片保存到本地

功能点:如何爬取图片,并保存到本地 爬取网站:斗鱼主播 完整代码:https://files.cnblogs.com/files/bookwed/Douyu.zip 主要代码: douyu.py im ...

- Python:爬取网站图片并保存至本地

Python:爬取网页图片并保存至本地 python3爬取网页中的图片到本地的过程如下: 1.爬取网页 2.获取图片地址 3.爬取图片内容并保存到本地 实例:爬取百度贴吧首页图片. 代码如下: imp ...

随机推荐

- String中substring方法内存泄漏问题

众所周知,JDK中以前String类中的substring方法存在内存泄漏问题,之所以说是以前,是因为JDK1.7及以后的版本已经修复了,我看都说JDK1.6的版本也存在这个问题,但是我本机上安装的1 ...

- STL序列容器之deque

一,deque的基础知识 1.deque的基础 deque是“double-ended-queue”的缩写,意思是双端队列,其和vector的区别在于vector是单端的. deque在头部和尾部插入 ...

- CentOS 由 JavaCPP 转让 FFMPEG

1. Java 与 FFMPEG FFMPEG 它是一种广泛使用的媒体处理库,于Java天地,处理视频较弱的能力,因此,有非常大的需求需求Java 转让 FFMPEG. Java 转让C 的方式有非常 ...

- 扪心自问,强大的UI框架,给我们带来了什么?(作者因此写了一个GuiLite)

MFC, QT, MINIGUI, ANDROID, IOS,如果这些平台,你都使用过,在下真心佩服,也相信你对这篇文章最具有发言权,真心期待你的回复和建议. 这些著名的UI说出来都让人如雷贯耳,如果 ...

- 测试了下boost的序列化反序列化功能

// testSerialization.cpp : Defines the entry point for the console application. // #include "st ...

- 大班模型行为PK(总结)

行为类模式包括责任链模式.命令模式.解释器模式.迭代模式.中介模式.备忘录模式.观察者模式.State模式.策略模式.模板方法.Visitor模式,我去,许多.. .主要有以下挑几个easy混乱和控制 ...

- Hadoop入门实验

一.实验目的 了解Hadoop的MapeReduce工作原理 二.实验内容 实现基于单机的伪分布式运行模拟 三.实验需要准备的软件和源 1.Jdk1.6以上 下载地址:http://www.oracl ...

- springmvc 与 springfox-swagger2整合

一.pom.xml引入基于maven的swagger依赖 <dependency> <groupId>io.springfox</groupId> <arti ...

- linq to entity GroupBy多个字段

var items = _voteRecordRepository.GetAll() .Where(x => programIds.Contains(x.ProgrammeId)) .Group ...

- DB First EF中的存储过程、函数、视图

视图约等于表(属性)存储过程变为方法,方法中调用存储过程 EF可以调用存储过程,DB First的流程是刷新模型,获取存储过程,调用参考:http://blog.csdn.net/sudazf/art ...