【六】强化学习之DQN---PaddlePaddlle【PARL】框架{飞桨}

相关文章:

【一】飞桨paddle【GPU、CPU】安装以及环境配置+python入门教学

代码链接:码云:https://gitee.com/dingding962285595/parl_work ;github:https://github.com/PaddlePaddle/PARL

1.前言铺垫

1.1值函数近似

用带参数的Q函数近似,比如使用:多项式函数,神经网络来代替Q表格。

这里近似可以有不同类别,如上图输入一个状态s和动作a得到一个q值,或者只输入状态s,有多少个动作就输出多少个Q值,右边容易求解最大Q值。

表格法的缺点: 使用值函数近似的优点:

➊表格可能占用极大内存 ➊仅需存储有限的参数

②当表格极大时,查表效率低下 ②状态泛化,相似的状态可以输出一样神经网络可以逼近任意连续函数

线性加权+激活函数 就可以拟合非线性函数。

这是一个简单的线性回归模型,来帮助我们快速求解4元一次方程。

代码对应如下:

#加载库

import paddle.fluid as fluid

import numpy as np

#生成数据

np.random.seed(0)

outputs = np.random.randint(5, size=(10, 4))

res = []

for i in range(10):

# 假设方程式为 y=4a+6b+7c+2d

y = 4*outputs[i][0]+6*outputs[i][1]+7*outputs[i][2]+2*outputs[i][3]

res.append([y])

# 定义数据

train_data=np.array(outputs).astype('float32')

y_true = np.array(res).astype('float32')

#定义网络

x = fluid.layers.data(name="x",shape=[4],dtype='float32')

y = fluid.layers.data(name="y",shape=[1],dtype='float32')

y_predict = fluid.layers.fc(input=x,size=1,act=None)

#定义损失函数

cost = fluid.layers.square_error_cost(input=y_predict,label=y)

avg_cost = fluid.layers.mean(cost)

#定义优化方法

sgd_optimizer = fluid.optimizer.SGD(learning_rate=0.05)

sgd_optimizer.minimize(avg_cost)

#参数初始化

cpu = fluid.CPUPlace()

exe = fluid.Executor(cpu)

exe.run(fluid.default_startup_program())

##开始训练,迭代500次

for i in range(500):

outs = exe.run(

feed={'x':train_data,'y':y_true},

fetch_list=[y_predict.name,avg_cost.name])

if i%50==0:

print ('iter={:.0f},cost={}'.format(i,outs[1][0]))

#存储训练结果

params_dirname = "result"

fluid.io.save_inference_model(params_dirname, ['x'], [y_predict], exe)

# 开始预测

infer_exe = fluid.Executor(cpu)

inference_scope = fluid.Scope()

# 加载训练好的模型

with fluid.scope_guard(inference_scope):

[inference_program, feed_target_names,

fetch_targets] = fluid.io.load_inference_model(params_dirname, infer_exe)

# 生成测试数据

test = np.array([[[9],[5],[2],[10]]]).astype('float32')

# 进行预测

results = infer_exe.run(inference_program,

feed={"x": test},

fetch_list=fetch_targets)

# 给出题目为 【9,5,2,10】 输出y=4*9+6*5+7*2+10*2的值

print ("9a+5b+2c+10d={}".format(results[0][0]))

得到结果:

9a+5b+2c+10d=[99.946]

输出结果应是一个近似等于100的值,每次计算结果略有不同。

2.DQN

先回顾一下Qlearing

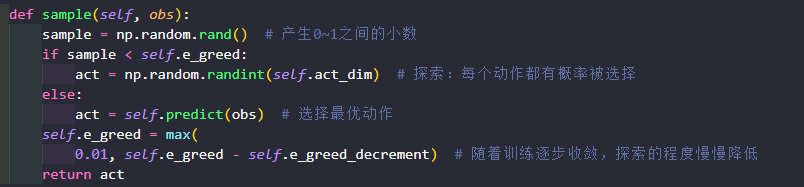

1.首先查表所有动作对应q值取出来,最有动作就是q值最大对应动作,2.在输出给环境,然后输出r和下一状态s Q(s,a)函数逼近目标值target,maxQ来更新。当然也用sample进行探索。

DQN改进就是用神经网络替代Q表格。

3.DQN创新点

- 本质上

DQN还是一个Q-learning算法,更新方式一致。为了更好的探索环境,同样的也采用ε-greedy方法训练。 - 在

Q-learning的基础上,DQN提出了两个技巧使得Q网络的更新迭代更稳定。- 经验回放

Experience Replay:主要解决样本关联性和利用效率的问题。使用一个经验池存储多条经验s,a,r,s',再从中随机抽取一批数据送去训练。 - 固定Q目标

Fixed-Q-Target:主要解决算法训练不稳定的问题。复制一个和原来Q网络结构一样的Target Q网络,用于计算Q目标值。

- 经验回放

是预测的q和targetQ相近,通过loss更新神经网络。

2.1 经验回放

import random

import collections #导入队列库,可以定义经验池队列

import numpy as np class ReplayMemory(object):

def __init__(self, max_size):

self.buffer = collections.deque(maxlen=max_size) #长度就是经验池容量 def append(self, exp):

self.buffer.append(exp)#增加一条经验(obs, action, reward, next_obs, done )

def sample(self, batch_size):

mini_batch = random.sample(self.buffer, batch_size)

obs_batch, action_batch, reward_batch, next_obs_batch, done_batch = [], [], [], [], [] for experience in mini_batch: #每一条batch分解一下,加到对应数组里

s, a, r, s_p, done = experience

obs_batch.append(s)

action_batch.append(a)

reward_batch.append(r)

next_obs_batch.append(s_p)

done_batch.append(done) return np.array(obs_batch).astype('float32'), \

np.array(action_batch).astype('float32'), np.array(reward_batch).astype('float32'),\

np.array(next_obs_batch).astype('float32'), np.array(done_batch).astype('float32') def __len__(self):

return len(self.buffer)

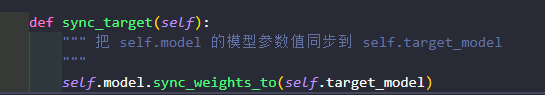

2.2 固定Q目标

2.3 DQN流程

在parl里面单独把DQN算法提取出来

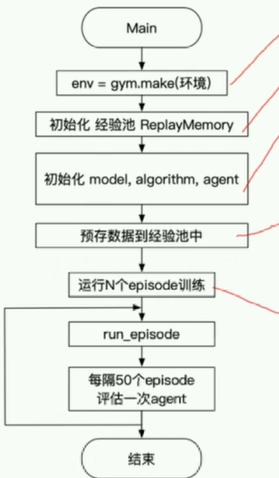

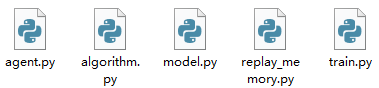

4.PARL的架构DQN详细讲解如下:

可以比较方便的应用在其他深度学习环境下。这样的算法看起来会比较整洁5个文件:

Agent把产生的数据传给algorithm,algorithm根据model的模型结构计算出Loss,使用SGD或者其他优化器不断的优化,PARL这种架构可以很方便的应用在各类深度强化学习问题中。

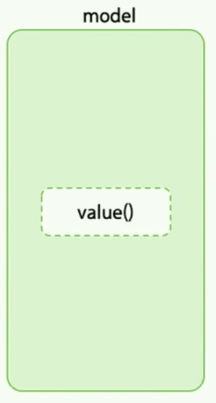

4.1 model:

Model用来定义前向(Forward)网络,用户可以自由的定制自己的网络结构。

4.2 algorithm:

Algorithm定义了具体的算法来更新前向网络(Model),也就是通过定义损失函数来更新Model,和算法相关的计算都放在algorithm中。

将model的参数同步到target_model中,调用这个API就好。

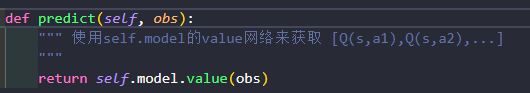

预测:

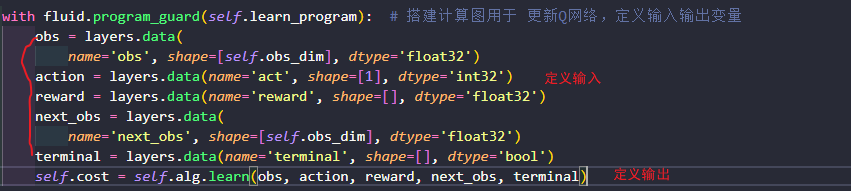

4.3 learn():

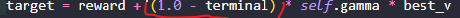

target Q计算公式 和Qlearing一样,if episode是最后一个则没有下一个状态,就是当前reward。

分成三部分,得到Q目标值、在获取预测值,最后得到LOSS。

阻止梯度传递,target_q 用到的是target_model的值,而target_model的值需要固定不动的,所以切断联系,避免优化器找到所有和cost有关的参数进行一起优化。

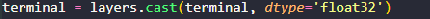

- 小技巧:terminal就是done,

这行代码把if else都写出来了,如果是true就是1 false就是0

true的话就是1,后项式整体为0.

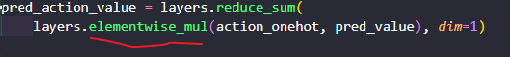

- pred_value拿到的是pred_value = [[2.3, 5.7, 1.2, 3.9, 1.4]],拿到所有a对应的Q了,然后把Q先转换到onehot向量3 => [0,0,0,1,0] 2 => [0,0,1,0,0]

安位相乘再相加,就得到3.9了。即Q(s,a)

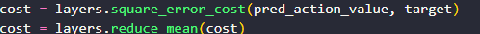

计算均方差、在用adm优化器优化。

Agent负责算法与环境的交互,在交互过程中把生成的数据提供给Algorithm来更新模型(Model),数据的预处理流程也一般定义在这里。

每200step同步一次网络。

每运行一次run就完成一次网络的更新。

获取计算Q值

with fluid.program_guard(self.pred_program): # 搭建计算图用于 预测动作,定义输入输出变量

obs = layers.data(

name='obs', shape=[self.obs_dim], dtype='float32')

self.value = self.alg.predict(obs)

5.cartpole测试

5.1 main.py 代码流程图体现:

每训练50个episode,评估5次【多次】再求平均,避免偶然性。

训练时运行learn更新Q算法。

render为true,则显示需打印内容,等于设置了一个标记。

6.PARL常用APi

7.总结:

软更新:应该是指每次更新参数的时候利用一个衰减的比例

硬更新:则是指每隔一定步数完全Copy参数

【六】强化学习之DQN---PaddlePaddlle【PARL】框架{飞桨}的更多相关文章

- 强化学习算法DQN

1 DQN的引入 由于q_learning算法是一直更新一张q_table,在场景复杂的情况下,q_table就会大到内存处理的极限,而且在当时深度学习的火热,有人就会想到能不能将从深度学习中借鉴方法 ...

- 【强化学习】DQN 算法改进

DQN 算法改进 (一)Dueling DQN Dueling DQN 是一种基于 DQN 的改进算法.主要突破点:利用模型结构将值函数表示成更加细致的形式,这使得模型能够拥有更好的表现.下面给出公式 ...

- 谷歌重磅开源强化学习框架Dopamine吊打OpenAI

谷歌重磅开源强化学习框架Dopamine吊打OpenAI 近日OpenAI在Dota 2上的表现,让强化学习又火了一把,但是 OpenAI 的强化学习训练环境 OpenAI Gym 却屡遭抱怨,比如不 ...

- 谷歌推出新型强化学习框架Dopamine

今日,谷歌发布博客介绍其最新推出的强化学习新框架 Dopamine,该框架基于 TensorFlow,可提供灵活性.稳定性.复现性,以及快速的基准测试. GitHub repo:https://git ...

- 强化学习系列之:Deep Q Network (DQN)

文章目录 [隐藏] 1. 强化学习和深度学习结合 2. Deep Q Network (DQN) 算法 3. 后续发展 3.1 Double DQN 3.2 Prioritized Replay 3. ...

- 强化学习 - Q-learning Sarsa 和 DQN 的理解

本文用于基本入门理解. 强化学习的基本理论 : R, S, A 这些就不说了. 先设想两个场景: 一. 1个 5x5 的 格子图, 里面有一个目标点, 2个死亡点二. 一个迷宫, 一个出发点, ...

- 强化学习(十七) 基于模型的强化学习与Dyna算法框架

在前面我们讨论了基于价值的强化学习(Value Based RL)和基于策略的强化学习模型(Policy Based RL),本篇我们讨论最后一种强化学习流派,基于模型的强化学习(Model Base ...

- 强化学习(十六) 深度确定性策略梯度(DDPG)

在强化学习(十五) A3C中,我们讨论了使用多线程的方法来解决Actor-Critic难收敛的问题,今天我们不使用多线程,而是使用和DDQN类似的方法:即经验回放和双网络的方法来改进Actor-Cri ...

- 强化学习(十二) Dueling DQN

在强化学习(十一) Prioritized Replay DQN中,我们讨论了对DQN的经验回放池按权重采样来优化DQN算法的方法,本文讨论另一种优化方法,Dueling DQN.本章内容主要参考了I ...

- 强化学习(十)Double DQN (DDQN)

在强化学习(九)Deep Q-Learning进阶之Nature DQN中,我们讨论了Nature DQN的算法流程,它通过使用两个相同的神经网络,以解决数据样本和网络训练之前的相关性.但是还是有其他 ...

随机推荐

- VWAP 订单的最佳执行方法:随机控制法

更多精彩内容,欢迎关注公众号:数量技术宅,也可添加技术宅个人微信号:sljsz01,与我交流. 引言:相关研究 在当今的投资领域,算法交易正迅速成为客户获取和清算股票头寸的首选方法. 通常,被委托者会 ...

- 原创内容屡屡被盗?从源头对资源盗用说NO

在这个信息化的时代,资源被盗用是一件很让人厌恶,但又很常见的事.比如,之前郭敬明的小说<梦里花落知多少>剽窃庄羽小说<圈里圈外>一事,虽然郭敬明通过个人微博向庄羽道歉,并表示& ...

- 以API 配置的方式来配置你的 Dubbo 应用

package com.aswatson.csc.member.conf; import com.aswatson.csc.member.service.MemberCardService; impo ...

- CompletableFuture 使用详解

CompletableFuture 使用详解 1. runAsync 和 supplyAsync方法 CompletableFuture 提供了四个静态方法来创建一个异步操作. public stat ...

- C#设计模式15——观察者模式的写法

是什么: 观察者模式是一种设计模式,它定义了对象之间的一种一对多的依赖关系,使得当一个对象状态发生改变时,它的所有依赖者都能够得到相应的通知并作出相应的反应.观察者模式也被称为发布-订阅模式. 为什么 ...

- C语言基础之理论概述

C语言介绍 C语言是一种高级程序设计语言,由贝尔实验室的Dennis Ritchie在1972年开发.C语言是结构化编程语言,支持变量.数据类型.运算符.表达式.流程控制语句和函数等基本程序设计元素. ...

- 理解 Kubernetes volume 和 共享存储

1. Kubernetes volume 文章 介绍了 Docker volume.与 docker volume 类似的,在 kubernetes 中存在 Pod 级别的 volume,Pod 的 ...

- RSA 加密,解密,签名,验签

一.RSA加密简介 RSA加密是一种非对称加密.可以在不直接传递密钥的情况下,完成解密.这能够确保信息的安全性,避免了直接传递密钥所造成的被破解的风险. 是由一对密钥来进行加解密的过程,分别称为公钥和 ...

- [转帖]SecurityProtocolType 枚举

https://learn.microsoft.com/zh-cn/dotnet/api/system.net.securityprotocoltype?view=net-8.0 命名空间: Syst ...

- [转帖]redis-benchmark的使用总结

redis-benchmark的使用总结 Redis简介: 测试需求: 测试环境架构 测试工具Redis-benchmark 1 redis-benchmark使用方法 参数的作用 2 测试查看 测试 ...