<爬虫实战>豆瓣电影TOP250(三种解析方法)

1.豆瓣电影排行.py

# 目标:爬取豆瓣电影排行榜TOP250的电影信息

# 信息包括:电影名字,上映时间,主演,评分,导演,一句话评价

# 解析用学过的几种方法都实验一下①正则表达式.②BeautifulSoup③xpath

import requests

import re # 正则表达式

import json

from bs4 import BeautifulSoup # BS

from lxml import etree # xpath def get_one_page(url):

response = requests.get(url)

if response.status_code == 200:

return response.text

return None def zhengze_parse(html):

pattern = re.compile(

'<em class="">(.*?)</em>.*?<img.*?alt="(.*?)".*?src="(.*?)".*?property="v:average">(.*?)</span>.*?<span>(.*?)</span>.*?'

+ 'class="inq">(.*?)</span>',

re.S)

items = re.findall(pattern, html)

# 因为125个影片没有描述,根本没有匹配到- -,更改也简单,描述单独拿出来,这里我就不改了

for item in items:

yield {

'index': item[0],

'image': item[2],

'title': item[1],

'people': item[4].strip()[:-2],

'score': item[3],

'Evaluation': item[5]

} def soup_parse(html):

soup = BeautifulSoup(html, 'lxml')

for data in soup.find_all('div', class_='item'):

index = data.em.text

image = data.img['src']

title = data.img['alt']

people = data.find_all('span')[-2].text[:-2]

score = data.find('span', class_='rating_num').text

# 第125个影片没有描述,用空代替

if data.find('span', class_='inq'):

Evaluation = data.find('span', class_='inq').text

else:

Evaluation = ''

yield {

'index': index,

'image': image,

'title': title,

'people': people,

'score': score,

'Evaluation': Evaluation,

} def xpath_parse(html):

html = etree.HTML(html)

for data in html.xpath('//ol[@class="grid_view"]/li'):

index = data.xpath('.//em/text()')[0]

image = data.xpath('.//a/img/@src')[0]

title = data.xpath('.//a/img/@alt')[0]

people = data.xpath('.//div[@class="star"]/span[4]/text()')[0][:-2]

score = data.xpath('.//div[@class="star"]/span[2]/text()')[0]

# 第125个影片没有描述,用空代替

if data.xpath('.//p[@class="quote"]/span/text()'):

Evaluation = data.xpath('.//p[@class="quote"]/span/text()')[0]

else:

Evaluation = ''

yield {

'index': index,

'image': image,

'title': title,

'people': people,

'score': score,

'Evaluation': Evaluation,

} def write_to_file(content, flag):

with open('豆瓣电影TOP250(' + str(flag) + ').txt', 'a', encoding='utf-8')as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n') def search(Num):

url = 'https://movie.douban.com/top250?start=' + str(Num)

html = get_one_page(url)

for item in zhengze_parse(html):

write_to_file(item, '正则表达式')

for item in soup_parse(html):

write_to_file(item, 'BS4')

for item in xpath_parse(html):

write_to_file(item, 'xpath')

page = str(Num / 25 + 1)

print("正在爬取第" + page[:-2] + '页') def main():

# 提供页码

for i in range(0, 10):

Num = i * 25

search(Num)

print("爬取完成") if __name__ == '__main__':

# 入口

main()

第125个电影显示信息(赶紧去加个描述吧)

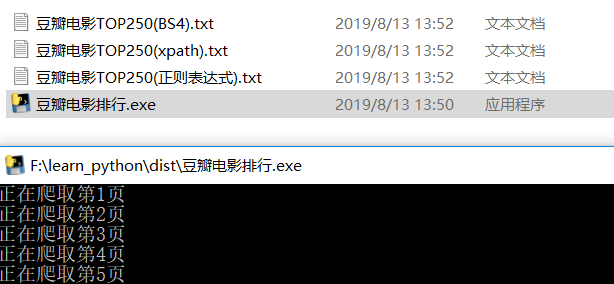

2.打包

pyinstaller -F 豆瓣电影排行.py

3.运行效果

<爬虫实战>豆瓣电影TOP250(三种解析方法)的更多相关文章

- 【Python爬虫】:使用高性能异步多进程爬虫获取豆瓣电影Top250

在本篇博文当中,将会教会大家如何使用高性能爬虫,快速爬取并解析页面当中的信息.一般情况下,如果我们请求网页的次数太多,每次都要发出一次请求,进行串行执行的话,那么请求将会占用我们大量的时间,这样得不偿 ...

- 爬虫实战 豆瓣音乐top250 xpath

刷知乎时刷到一篇爬取豆瓣音乐top250的,然后看了看,感觉自己的爬虫又更上一层楼了哈啊哈哈,尤其是发现xpath这么好用的东西. 不过也有一个感慨,就是有很多种方式都可以获得想要的数据,对于入门的新 ...

- 第一个爬虫经历----豆瓣电影top250(经典案例)

因为要学习数据分析,需要从网上爬取数据,所以开始学习爬虫,使用python进行爬虫,有好几种模拟发送请求的方法,最基础的是使用urllib.request模块(python自带,无需再下载),第二是r ...

- 爬虫_豆瓣电影top250 (正则表达式)

一样的套路,就是多线程还没弄 import requests import re import json headers = 'Mozilla/5.0 (Windows NT 10.0; WOW64) ...

- Python 爬虫:豆瓣电影Top250,包括电影导演、类型、年份、主演

结果输出到文本文件中. import codecs import requests from bs4 import BeautifulSoup headers={'User-Agent': 'Mozi ...

- Python_XML的三种解析方法

什么是XML? XML 指可扩展标记语言(eXtensible Markup Language). XML 被设计用来传输和存储数据. XML是一套定义语义标记的规则,这些标记将文档分成许多部件并对这 ...

- QT XML文档的解析 QXmlStreamReader, DOM,SAX 三种解析方法 简单示例

0. xml文档如下 <?xml version="1.0"?> <bookindex> <entry term="sidebearings ...

- iOS--XML三种解析方法( XMLDictionary)、(GDataXMLNode)、(NSXMLParser)

iOS9之后,默认网络请求是https,所有我们要设置一下网络安全,具体设置如下 1.第三方类库 XMLDictionary 下载地址: https://github.com/nicklockwood ...

- python爬虫 Scrapy2-- 爬取豆瓣电影TOP250

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

随机推荐

- sqlserver 登录记录(登录触发器)

本人自用 sqlserver 账号登录的记录(记录表+登录触发器) --存储账号的登录记录信息 use [YWmonitor] go create table access_log ( ,) NOT ...

- Cell的复用机制问题总结

创建方式汇总,注册和不注册Cell注册的两种方式 1.tableView registerNib:(nullable UINib *) forCellReuseIdentifier:(nonnull ...

- Echart使用js进行封装成函数

Echart使用js进行封装成函数 主要是对 json 串的封装,使用 js 进行对 json 的解析.之间用的最多是循环取出数组中的值,如果拿去使用可直接修改 json 就好. 上一篇把二维的封装好 ...

- Openstack组件实现原理 — Glance架构(V1/V2)

目录 目录 Glance 安装列表 Glance Image service Image service 的组件 Glance-Api Glance-Registry Glance-db Image ...

- 21、Linux命令对服务器网络进行监控

带宽在我们性能测试中是非常重要的一个因素,带宽的理论上传/下载速度是可以进行推算的.比如你的带宽是10m,那么上传/下载理论速度是10/8=1.25m/s.举个例子,服务器上一个文件大小1.25M,我 ...

- 31. Flexible static memory controller (FSMC)

31.1 FSMC main features FSMC块能够与同步和异步内存和16位PC存储卡.其主要目的是: 将AHB事务转换为适当的外部设备协议 满足外部设备的访问定时要求 所有外部存储器与控制 ...

- inode缓存与dentry缓存

1. inode缓存 1: struct inode { 2: /* RCU path lookup touches following: */ 3: umode_t i_mode; 4: uid_t ...

- Codeforces 1173A Nauuo and Votes

题目链接:http://codeforces.com/problemset/problem/1173/A 思路:模拟. AC代码: #include<bits/stdc++.h> usin ...

- yield迭代器的使用

class Program { static void Main(string[] args) { List<Student> students = new List<Student ...

- 并发新构件之PriorityBlockingQueue:优先阻塞队列

PriorityBlockingQueue:优先阻塞队列:是带有优先级的阻塞队列,一个无界阻塞队列,它使用与类 PriorityQueue 相同的顺序规则,并且提供了阻塞获取操作.虽然此队列逻辑上是无 ...