Keras + LSTM 做回归demo 2

接上回, 这次做了一个多元回归

这里贴一下代码

import numpy as np

np.random.seed(1337)

from sklearn.model_selection import train_test_split

import matplotlib.pyplot as plt

import keras

from keras.models import Sequential

from keras.layers import Activation

from keras.layers import LSTM

from keras.layers import Dropout

from keras.layers import Dense

import pandas as pd

datan = 1000

# 真实参数

ori_weights = [5, -4, 3, -2, 1]

colsn = len(ori_weights)

bias = -1

ori = np.zeros((1, colsn))

ori[0] = np.asarray(ori_weights)

# 列信息

cols_name = [chr(65+i) for i in range(colsn)]

X = np.zeros((colsn, datan)) for i in range(colsn):

X[i] = np.random.normal(1, 0.1, datan)

# 真实Y

Y = np.matmul(ori, X) + bias + np.random.normal(-0.1, 0.1, (datan, ))

# 数据预览

df = pd.DataFrame(X.T, columns=cols_name)

df['Y'] = df.apply(lambda row: np.matmul(ori, [row[k] for k in df.columns] )[0]+bias, axis=1)

df['target'] = Y[0]

df.head()

X_train, X_test, Y_train, Y_test = train_test_split(X.T, Y.T, test_size=0.33, random_state=42)

neurons = 128

activation_function = 'tanh'

loss = 'mse'

optimizer="adam"

dropout = 0.01

batch_size = 12

epochs = 200

model = Sequential() model.add(LSTM(neurons, return_sequences=True, input_shape=(1, colsn), activation=activation_function))

model.add(Dropout(dropout))

model.add(LSTM(neurons, return_sequences=True, activation=activation_function))

model.add(Dropout(dropout))

model.add(LSTM(neurons, activation=activation_function))

model.add(Dropout(dropout))

model.add(Dense(output_dim=1, input_dim=1))

model.compile(loss=loss, optimizer=optimizer)

epochs = 2001

for step in range(epochs):

cost = model.train_on_batch(X_train[:, np.newaxis], Y_train)

if step % 30 == 0:

print(f'{step} train cost: ', cost)

# test

print('Testing ------------')

cost = model.evaluate(X_test[:, np.newaxis], Y_test, batch_size=40)

print('test cost:', cost)

# plotting the prediction

Y_pred = model.predict(X_test[:, np.newaxis])

#

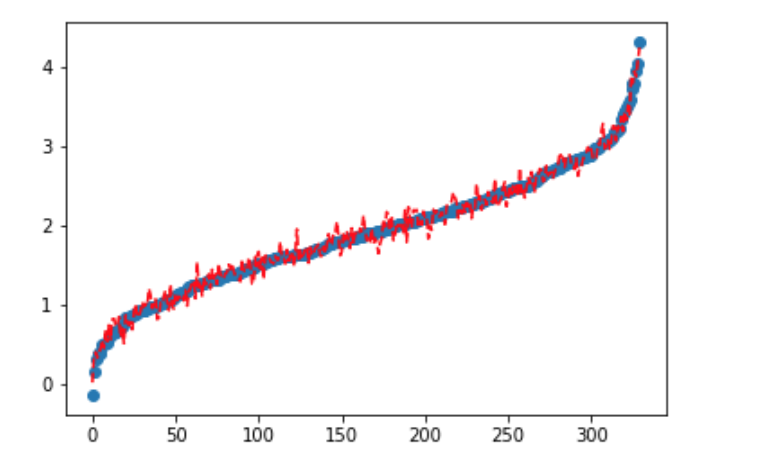

sdf = pd.DataFrame({'test':list(Y_test.T[0]), 'pred':list(Y_pred.T[0])})

sdf.sort_values(by='test', inplace=True)

#

plt.scatter(range(len(Y_test)), list(sdf.test))

plt.plot(range(len(Y_test)), list(sdf.pred), 'r--')

plt.show()

Keras + LSTM 做回归demo 2的更多相关文章

- Keras + LSTM 做回归demo

学习神经网络 想拿lstm 做回归, 网上找demo 基本三种: sin拟合cos 那个, 比特币价格预测(我用相同的代码和数据没有跑成功, 我太菜了)和keras 的一个例子 我基于keras 那个 ...

- 循环神经网络LSTM RNN回归:sin曲线预测

摘要:本篇文章将分享循环神经网络LSTM RNN如何实现回归预测. 本文分享自华为云社区<[Python人工智能] 十四.循环神经网络LSTM RNN回归案例之sin曲线预测 丨[百变AI秀]& ...

- 利用Caffe做回归(regression)

Caffe应该是目前深度学习领域应用最广泛的几大框架之一了,尤其是视觉领域.绝大多数用Caffe的人,应该用的都是基于分类的网络,但有的时候也许会有基于回归的视觉应用的需要,查了一下Caffe官网,还 ...

- [翻译]用神经网络做回归(Using Neural Networks With Regression)

本文英文原文出自这里, 这个博客里面的内容是Java开源, 分布式深度学习项目deeplearning4j的介绍学习文档. 简介: 一般来说, 神经网络常被用来做无监督学习, 分类, 以及回归. 也就 ...

- 单向LSTM笔记, LSTM做minist数据集分类

单向LSTM笔记, LSTM做minist数据集分类 先介绍下torch.nn.LSTM()这个API 1.input_size: 每一个时步(time_step)输入到lstm单元的维度.(实际输入 ...

- 使用LSTM做电影评论负面检测——使用朴素贝叶斯才51%,但是使用LSTM可以达到99%准确度

基本思路: 每个评论取前200个单词.然后生成词汇表,利用词汇index标注评论(对 每条评论的前200个单词编号而已),然后使用LSTM做正负评论检测. 代码解读见[[[评论]]]!embeddin ...

- python 做回归

1 一元线性回归 线性回归是一种简单的模型,但受到广泛应用,比如预测商品价格,成本评估等,都可以用一元线性模型.y = f(x) 叫做一元函数,回归意思就是根据已知数据复原某些值,线性回归(regre ...

- keras神经网络做简单的回归问题

咸鱼了半个多月了,要干点正经事了. 最近在帮老师用神经网络做多变量非线性的回归问题,没有什么心得,但是也要写个博文当个日记. 该回归问题是四个输入,一个输出.自己并不清楚这几个变量有什么关系,因为是跟 ...

- 用 LSTM 做时间序列预测的一个小例子(转自简书)

问题:航班乘客预测 数据:1949 到 1960 一共 12 年,每年 12 个月的数据,一共 144 个数据,单位是 1000 下载地址 目标:预测国际航班未来 1 个月的乘客数 import nu ...

随机推荐

- 【Docker】-NO.132.Docker.1 -【Docker 修改容器端口】

Style:Mac Series:Java Since:2018-09-10 End:2018-09-10 Total Hours:1 Degree Of Diffculty:5 Degree Of ...

- 【Python学习】iterator 迭代器小练习

http://anandology.com/python-practice-book/iterators.html Problem 1: Write an iterator class revers ...

- QQ/微信中被禁止访问的网页怎么打开

为什么关心这种技术?因为我经常听到身边搞微商.搞微信项目的朋友都在叫苦连天,由于微信域名屏蔽.微信域名被拦截.弄得他们尸横遍野,损失的连过年回家的路费都没了,曾经的叱咤风云一下变成了今日的倒亏损.腾讯 ...

- nginx ../logs/nginx.pid" failed (2: No such file or directory)

[1]nginx.pid相关 (1)可能出现两种场景: 1.1 nginx.pid文件不存在 发生现象:nginx: [error] open() "/usr/local/lib/ubcsr ...

- 数据分片一致性hash

一致性hash 一致性hash是将数据按照特征值映射到一个首尾相接的hash环上,同时也将节点(按照IP地址或者机器名hash)映射到这个环上.对于数据,从数据在环上的位置开始,顺时针找到的第一个节点 ...

- 【Access】数据库四门功课--[增删改查]基础篇

一.增 以userinfo为例 1.增加一条完整的数据 INSERT INTO userinfo VALUES (1, 2, 3, 4); 基本格式:INSERT INTO AAA VALUES (X ...

- clean exit - waiting for changes before restart

在使用nodemon的时候,针对于同一个文件一次使用还好,当多次使用的时候就会出现这样的情况: 解决办法: nodemon clean exit 原因: 可能是因为缓存造成的:

- appium1.4版本,每次运行appium时需要安装unlock,setting文件的解决方法

在使用appium执行自动化脚本时,首次运行脚本时会在手机中安装unlock,setting,inputmanager三个apk,以达到让appium控制app的目的,但是运行完一次之后,在OPPO, ...

- Gradle Repository

// 该init.gradle文件,请保存到${USER_HOME}/.gradle/文件夹下,如:C:\Users\Administrator\.gradle allprojects { repos ...

- iperf 测试工具

Iperf是一个网络性能测试工具.Iperf可以测试TCP和UDP带宽质量.Iperf可以测量最大TCP带宽,具有多种参数和UDP特性. Iperf可以报告带宽,延迟抖动和数据包丢失.利用Iperf这 ...