55.storm 之 hello word(本地模式)

strom hello word

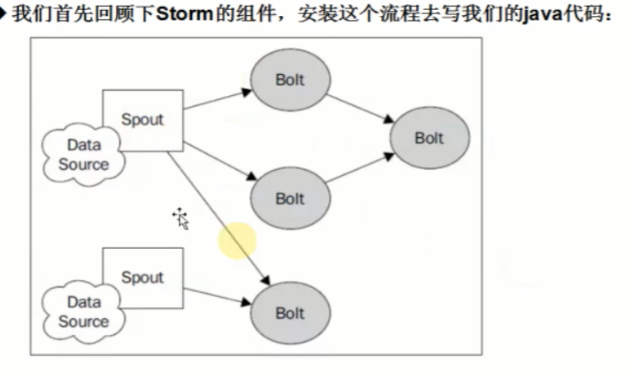

概述

然后卡一下代码怎么实现的:

- 编写数据源类:Spout。可以使用两种方式:

继承BaseRichSpout类

实现IRichSpout接口

主要需要实现或重写几个方法:open、nextTuple、declareOutputFields

- 继续编写数据处理类:Bolt。可以使用两种方式:

继承BaseBasicBolt类

实现IRichBolt接口

终点实现或重写几个方法:execute、declareOutputFields

- 最后编写主函数(Topology)去进行提交一个任务

在使用Topology的时候,Storm框架为我们提供了两种模式:本地模式和集群模式

本地模式:(无需Storm集群,直接在java中即可运行,一般用于测试和开发阶段)执行main函数即可

集群模式:(需要Storm集群,把实现java程序打包,然后Topology进行提交)需要把应用打成jar,使用Storm命令吧Topology提交到集群中去。

实际操作

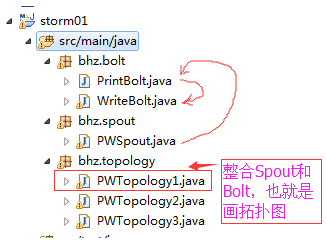

先来看一下代码结构:

就如上图所说,数据从PWSpout流到PrintBolt,最后到WriteBolt写到文件。具体看一下这几个类的代码:

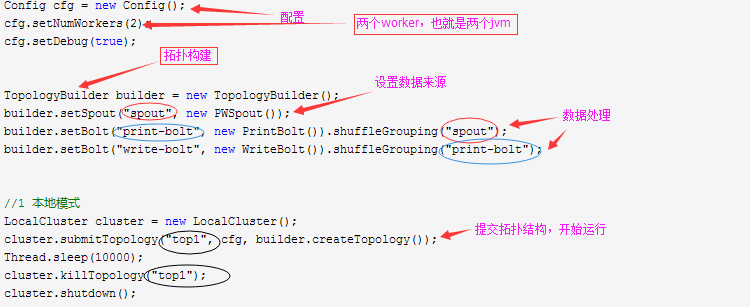

先看一本地模式的:

PWTopology1.java 拓扑结构构建

import backtype.storm.Config;

import backtype.storm.LocalCluster;

import backtype.storm.StormSubmitter;

import backtype.storm.topology.TopologyBuilder;

import bhz.bolt.PrintBolt;

import bhz.bolt.WriteBolt;

import bhz.spout.PWSpout; public class PWTopology1 { public static void main(String[] args) throws Exception {

//

Config cfg = new Config();

cfg.setNumWorkers(2);

cfg.setDebug(true); TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("spout", new PWSpout());

builder.setBolt("print-bolt", new PrintBolt()).shuffleGrouping("spout");

builder.setBolt("write-bolt", new WriteBolt()).shuffleGrouping("print-bolt"); //1 本地模式

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("top1", cfg, builder.createTopology());

Thread.sleep(10000);

cluster.killTopology("top1");

cluster.shutdown(); //2 集群模式

// StormSubmitter.submitTopology("top1", cfg, builder.createTopology()); }

}

代码分析:

数据来源:

import java.util.HashMap;

import java.util.Map;

import java.util.Random; import backtype.storm.spout.SpoutOutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseRichSpout;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Values; public class PWSpout extends BaseRichSpout { private static final long serialVersionUID = 1L;

private SpoutOutputCollector collector; private static final Map<Integer, String> map = new HashMap<Integer, String>(); static {

map.put(0, "java");

map.put(1, "php");

map.put(2, "groovy");

map.put(3, "python");

map.put(4, "ruby");

} @Override

public void open(Map conf, TopologyContext context, SpoutOutputCollector collector) {

//对spout进行初始化

this.collector = collector;

//System.out.println(this.collector);

} /**

* <B>方法名称:</B>轮询tuple<BR>

* <B>概要说明:</B><BR>

* @see backtype.storm.spout.ISpout#nextTuple()

*/

@Override

public void nextTuple() {

//随机发送一个单词

final Random r = new Random();

int num = r.nextInt(5);

try {

Thread.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

}

this.collector.emit(new Values(map.get(num)));

} /**

* <B>方法名称:</B>declarer声明发送数据的field<BR>

* <B>概要说明:</B><BR>

* @see backtype.storm.topology.IComponent#declareOutputFields(backtype.storm.topology.OutputFieldsDeclarer)

*/

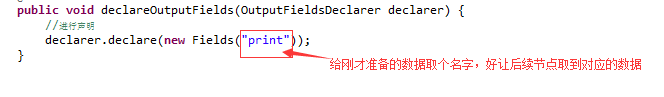

@Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

//进行声明

declarer.declare(new Fields("print"));

} }

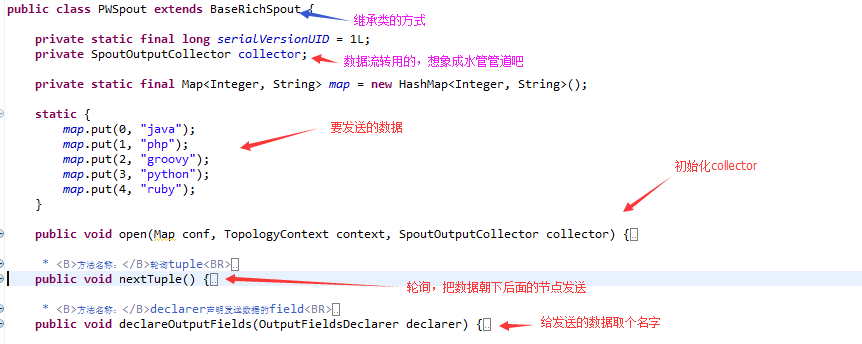

代码解析:

整体结构

细入分析

---------------------------- open 方法---------------------------------------------------------

--------------------------------- nextTuple方法 --------------------------------------------------------------

---------------------------- declareOutputFields方法 ----------------------------------------------------

数据处理

import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory; import backtype.storm.topology.BasicOutputCollector;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseBasicBolt;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Tuple;

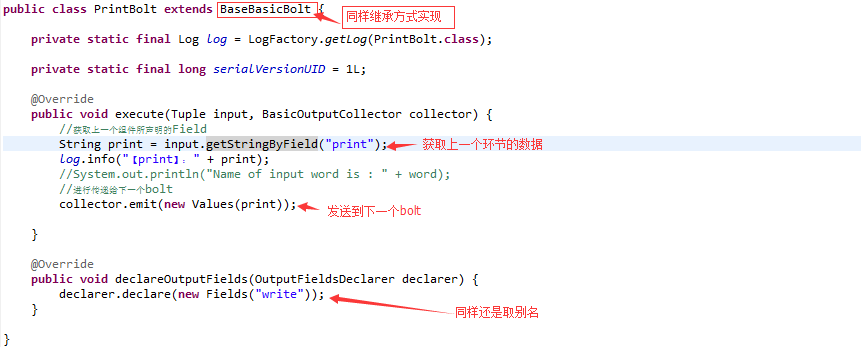

import backtype.storm.tuple.Values; public class PrintBolt extends BaseBasicBolt { private static final Log log = LogFactory.getLog(PrintBolt.class); private static final long serialVersionUID = 1L; @Override

public void execute(Tuple input, BasicOutputCollector collector) {

//获取上一个组件所声明的Field

String print = input.getStringByField("print");

log.info("【print】: " + print);

//System.out.println("Name of input word is : " + word);

//进行传递给下一个bolt

collector.emit(new Values(print)); } @Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("write"));

} }

代码分析

import java.io.FileWriter; import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory; import clojure.main;

import backtype.storm.topology.BasicOutputCollector;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.topology.base.BaseBasicBolt;

import backtype.storm.tuple.Tuple; public class WriteBolt extends BaseBasicBolt { private static final long serialVersionUID = 1L; private static final Log log = LogFactory.getLog(WriteBolt.class); private FileWriter writer ;

@Override

public void execute(Tuple input, BasicOutputCollector collector) {

//获取上一个组件所声明的Field

String text = input.getStringByField("write");

try {

if(writer == null){

if(System.getProperty("os.name").equals("Windows 10")){

writer = new FileWriter("D:\\099_test\\" + this);

} else if(System.getProperty("os.name").equals("Windows 8.1")){

writer = new FileWriter("D:\\099_test\\" + this);

} else if(System.getProperty("os.name").equals("Windows 7")){

writer = new FileWriter("D:\\099_test\\" + this);

} else if(System.getProperty("os.name").equals("Linux")){

System.out.println("----:" + System.getProperty("os.name"));

writer = new FileWriter("/usr/local/temp/" + this);

}

}

log.info("【write】: 写入文件");

writer.write(text);

writer.write("\n");

writer.flush(); } catch (Exception e) {

e.printStackTrace();

}

} @Override

public void declareOutputFields(OutputFieldsDeclarer declarer) { } }

和PrintBolt 这个类很相似,都是在处理数据。不作过多解释

55.storm 之 hello word(本地模式)的更多相关文章

- Eclipse的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: Eclipse的下载 Eclipse的安装 Eclipse的使用 本地模式或集群模式 Scala IDE for Eclipse的下载.安装和WordCount的初步使用(本地模式和集群 ...

- IntelliJ IDEA的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: IntelliJ IDEA的下载 IntelliJ IDEA的安装 IntelliJ IDEA中的scala插件安装 用SBT方式来创建工程 或 选择Scala方式来创建工程 本地模式或集群 ...

- Scala IDE for Eclipse的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: Scala IDE for Eclipse的下载 Scala IDE for Eclipse的安装 本地模式或集群模式 我们知道,对于开发而言,IDE是有很多个选择的版本.如我们大部分人经常 ...

- Linux下的Hadoop安装(本地模式)

系统为CentOS 6.9,Hadoop版本2.8.3,虚拟机VMware Workstation 主要介绍Linux虚拟机安装.环境配置和Hadoop本地模式的安装.伪分布式和Windows下的安装 ...

- Scala进阶之路-Spark本地模式搭建

Scala进阶之路-Spark本地模式搭建 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.Spark简介 1>.Spark的产生背景 传统式的Hadoop缺点主要有以下两 ...

- IntelliJ IDEA(Community版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

不多说,直接上干货! 对于初学者来说,建议你先玩玩这个免费的社区版,但是,一段时间,还是去玩专业版吧,这个很简单哈,学聪明点,去搞到途径激活!可以看我的博客. 包括: IntelliJ IDEA(Co ...

- 安装部署Apache Hadoop (本地模式和伪分布式)

本节内容: Hadoop版本 安装部署Hadoop 一.Hadoop版本 1. Hadoop版本种类 目前Hadoop发行版非常多,有华为发行版.Intel发行版.Cloudera发行版(CDH)等, ...

- 2.hadoop基本配置,本地模式,伪分布式搭建

2. Hadoop三种集群方式 1. 三种集群方式 本地模式 hdfs dfs -ls / 不需要启动任何进程 伪分布式 所有进程跑在一个机器上 完全分布式 每个机器运行不同的进程 2. 服务器基本配 ...

- Hive的三种安装方式(内嵌模式,本地模式远程模式)

一.安装模式介绍: Hive官网上介绍了Hive的3种安装方式,分别对应不同的应用场景. 1.内嵌模式(元数据保村在内嵌的derby种,允许一个会话链接,尝试多个会话链接时会报错) ...

随机推荐

- TCP/IP协议(4):网络层

网络层上有IP.ICMP.IGMP等协议. 1.IP地址 在OSI模型中,三层网络层负责IP地址,IP数据报帧头中的源地址和目的地址就是指IP地址.IPV4类型IP地址为32位4个字节,IPV6类型I ...

- latex去掉页眉

\begin{document}之前添加 \fancyhead{} 即: \fancyhead{} \begin{document}

- IntellJ IDEA2017 springboot2.0.2中读取配置

IDEA 路径 src\main\resources\application.properties 配置文件名称为 application.properties 默认的位置在classpath根目录下 ...

- vue动态路由

我们经常需要把某种模式匹配到的所有路由,全都映射到同个组件.例如,我们有一个 User 组件,对于所有 ID 各不相同的用户,都要使用这个组件来渲染.能够提供参数的路由即为动态路由第一步:定义组件 c ...

- 第27章:MongoDB-索引--唯一索引

①唯一索引 唯一索引的目的是为了让数据库的某个字段的值唯一,为了确保数据的都是合法的,但是唯一索引在插入数据时会对数据进行检查,一旦重复会抛出异常,效率会比较低,唯一索引只是保证数据库数据唯一的最后一 ...

- java高精度实数和小数

java 高精度实数和小数 String s = "1231222222222222222222222222222222222222222222222222222222"; Big ...

- 【王者荣耀之IT大神版】1.1版本升级之“投降机制”

版本:1.1 关于“投降机制”的理论基础与灵感来源于<微习惯>这本书. 简单来说,微习惯就是很小很小的习惯,比如说,每天做一个俯卧撑,每天看一页书等等.我们以前也许有过很多的计划,但却总是 ...

- Cacti Install Error

Cacti Error happened while installing: ERROR: Your MySQL TimeZone database is not populated. Please ...

- Grand Central Dispatch

什么是GCD? Grand Central Dispatch或者GCD,是一套低层API,提供了一种新的方法来进行并发程序编写.从基本功能上讲,GCD有点像NSOperationQueue,他们都允许 ...

- 如何对CentOS FTP服务配置

根据很多人对CentOS FTP服务的不解,我觉得应该对CentOS FTP服务做出一定的解释. 1.安装 一般在CentOS上都自动安装了vsftd,若没有安装则可以使用以下步骤进行安装yum -y ...